Яндекс Вебмастер (Webmaster Yandex): от А до Я

Я, Николай Шмичков, сделаю твой бизнес успешным.

У меня только 1 вопрос, ты готов значительно увеличить продажи?

Содержание:

В предыдущей статье про Вебмастер Гугл я рассказал, что Вебмастер — это Ваш способ заявить поисковой системе.

Яндекс выпустил сервис в 2007 году, официально открыв его для владельцев сайтов 21 декабря.

На сегодня он оброс дополнительными функциями, выдает огромное количество информации, необходимой для SEO оптимизатора, и фактически без него невозможно провести полноценный аудит сайта.

Анализ ошибок и отчетов Вебмастера Яндекс позволяет провести достаточно глубокий аудит любого вебсайта, выявить причины падения отдельных страниц в индексе и дать ответы на многие вопросы.

ОТОБРАЖЕНИЕ САЙТА В ЯНДЕКСЕ

Все мы знаем, что в контекстной рекламе мы можем решить, как будет выглядеть наше объявление.

Также мы можем в любой момент его отредактировать.

В естественной выдаче Вы тоже можете решить, что будет отображаться и как.

В выдаче в органике отображение Вашего сайта называется Сниппет.

По факту у Вас нет прямой возможности редактировать.

Но я расскажу, какие элементы можно изменять.

Отображение сайта в выдаче обычно можно схематически изобразить так:

Заголовок — изменяется непосредственно в HTML коде Вашей страницы.

Это тот самый Title, который Вы можете редактировать в админке своего сайта.

Есть определенные рекомендации по созданию кликабельных и привлекательных Title.

- Используйте ключевые слова страницы.

- Используйте большие буквы. Это упрощает восприятие. Но не КАПЛОК.

- Старайтесь изложить в Title, о чем эта страница в 60-65 символах.

Вы можете воспользоваться специальной утилитой КАЛЬКУЛЯТОРА ЗАГОЛОВКОВ, а также ознакомиться с техникой Эверест, как при помощи Title увеличить кликабельность своих страниц в органике.

Описание. Ранее — это был тег Description, но после недавних изменений в технике формирования сниппетов, теперь в описании отображается наиболее релевантный поисковому запросу фрагмент контента страницы.

Текст может выбираться из фрагментов микроразметки Open Graph и Schema.org.

Это не значит, что тег дескрипшн заполнять не нужно.

Если Вы его не заполните, Яндекс понизит Ваши позиции (об этом ниже).

Если Вам нужно сделать так, чтобы не все подставлялось в сниппет, запретите индексирование отдельных фрагментов контента в коде при помощи тега noindex.

Если нужно закрыть от индексации ссылку, поставьте для нее тег Nofollow.

По микроразметке и сниппете рекомендую ознакомиться с официальным гайдом от Яндекс.

В поисковой выдаче фрагменты описания будут подсвечены жирным шрифтом по ключевым словам для удобства выбора нужной странички.

Быстрые ссылки. Отображается обычно для сайтов с высоким уровнем доверия, а также с хорошим трафиком.

Если сайт отображается с верхнем блоке ТОП5 выдачи, под Заголовком может отображаться блок быстрых ссылок.

Какие ссылки отображать и выводить, Вы можете изменить в вебмастере.

Но Вы не можете добавить их самостоятельно — Вам придется выбирать из предложенных.

Фавикон. Современные CMS предлагают добавить его без особых трудностей.

Это — та маленькая иконка, которая отображается сразу рядом с выдачей и в браузере в вкладке.

Помните, фавикон должен быть простым и понятным стилизованным логотипом Вашей компании — его должны узнавать пользователи.

Специальные данные. Яндекс также выводит помимо быстрых ссылок и сниппета, еще и другие.

Первый — хлебные крошки.

Если Ваша страница находится на втором и третьем уровне вложенности, Яндекс отобразит в сниппете символически путь к этой странице.

Это достигается за счет микроразметки BreadCrump.

Второй элемент — это физический адрес компании.

Достигается за счет прописывания микроразметки Company, где Вы прописываете реальный адрес, телефон, время работы компании.

И третий элемент — экспериментальный — если Вы используете чат Jivosite на своем сайте.

Да, Яндекс провел эксперимент с Jivosite и сайты с этим модулем получили возможность начать чат с клиентом без посещения самого сайта.

Некоторые элементы можно контролировать и изменять непосредственно из Вебмастера.

ГЛАВА 1:

Использование Яндекс Вебмастера

В этой главе мы расскажем, как добавить свой сайт в Вебмастер Яндекса и дать доступ своим сотрудникам.

Вебмастер от российского поисковика Яндекс отличается достаточно простым интерфейсом и понятен большинству владельцев сайтов и оптимизаторов.

Для начала работы рекомендуется добавить свой сайт (для входа воспользуйтесь своей учеткой в Яндексе), карту сайта и предоставить доступ своим коллегам и партнерам.

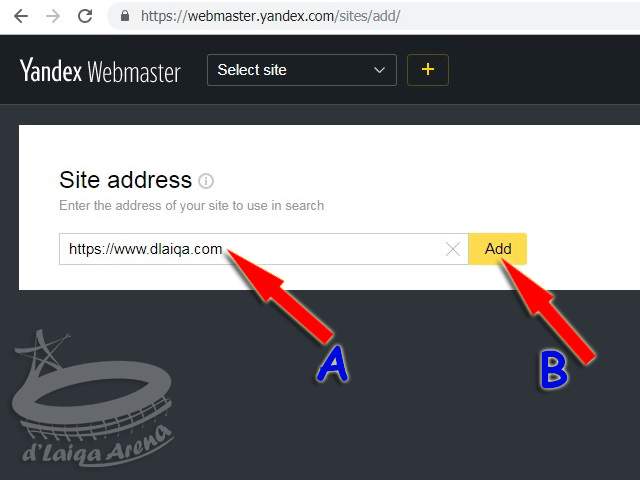

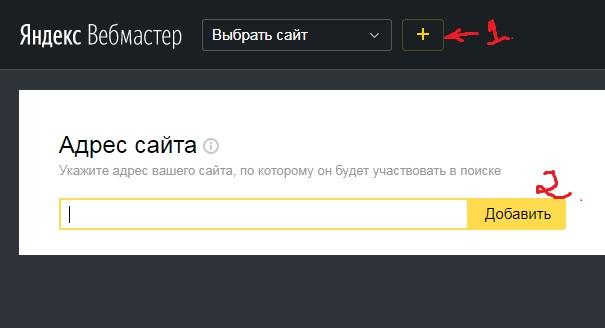

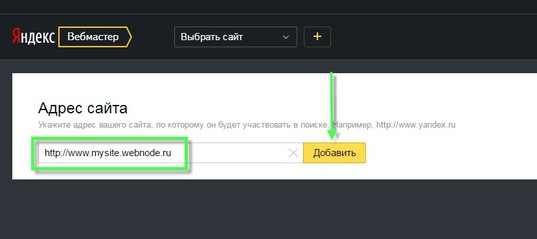

ДОБАВЛЕНИЕ САЙТА В ВЕБМАСТЕР ЯНДЕКС

Для добавления сайта перейдите по ссылке на Webmaster.

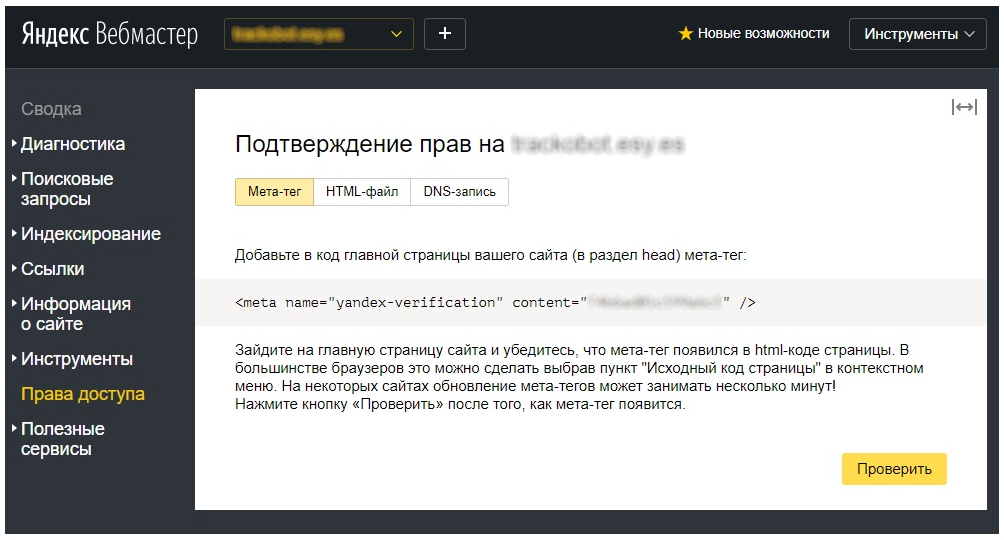

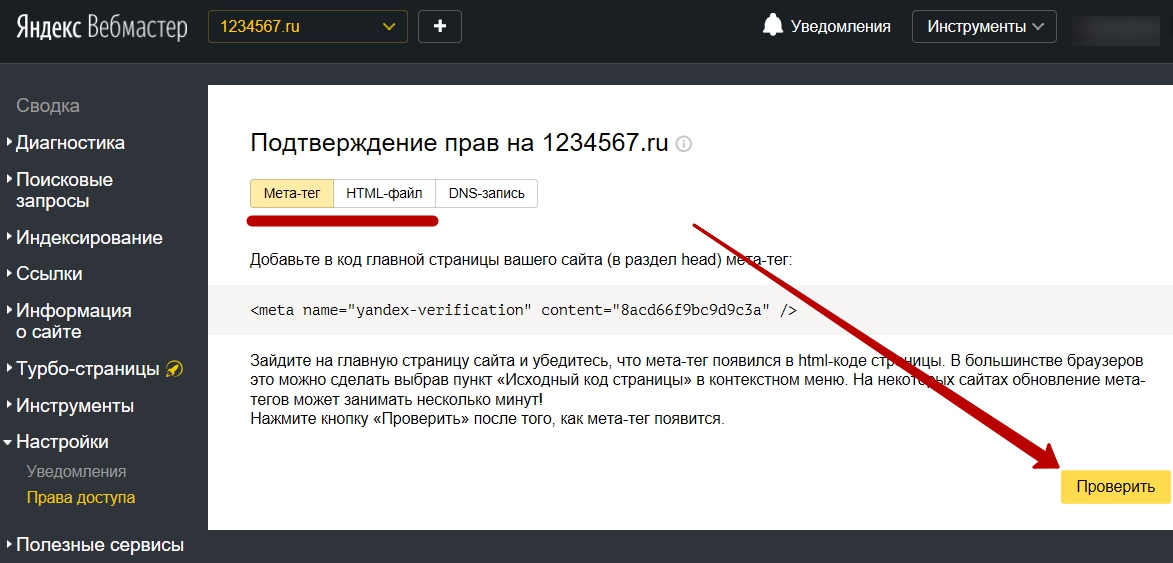

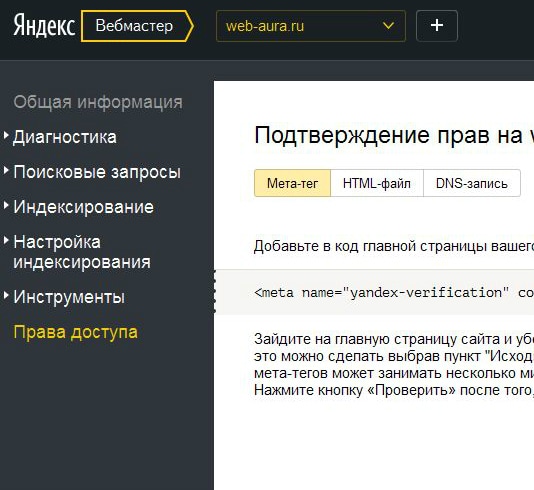

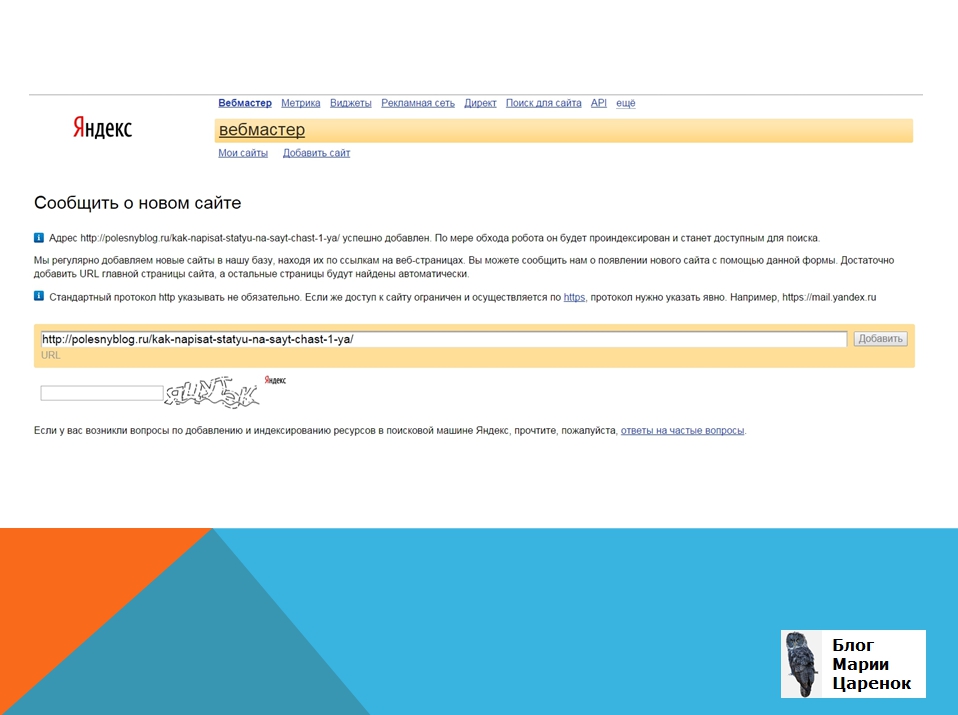

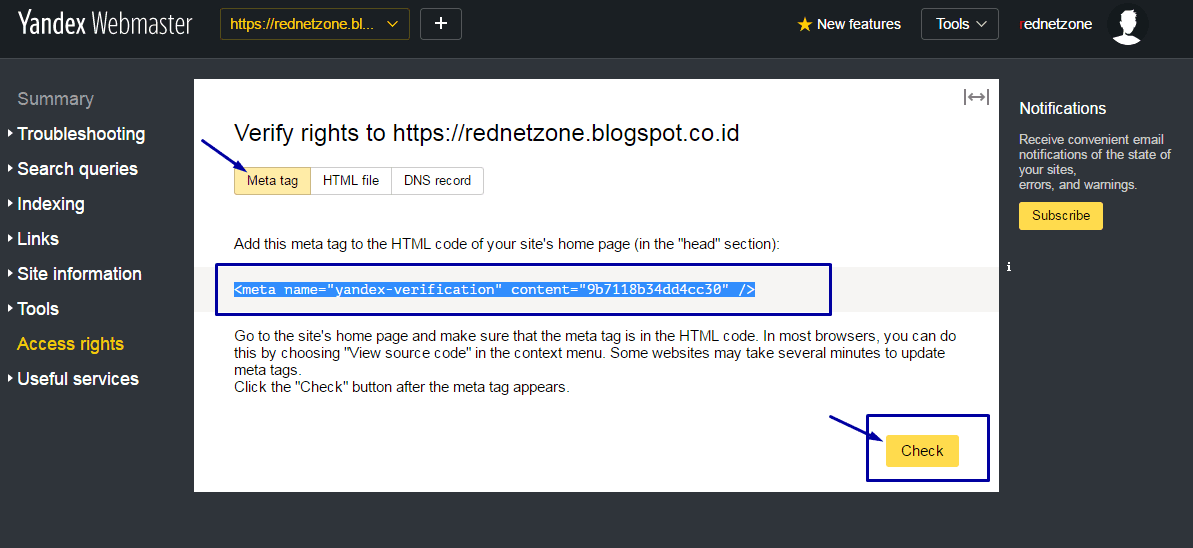

Затем система предложит Вам подтвердить право на владение своим сайтом.

Через метатег.

Для этого скопируйте указанный код в окошке и отредактируйте шапку сайта, разместив его перед закрывающим тегом </head>.

Затем нажмите кнопку Проверить.

Через HTML файл.

Зайдите на Ваш FTP (или в диспетчер файлов на хостинге) и загрузите файл (клик на верхнюю ссылку с названием файла скачивает его на Ваш жесткий диск).

Проверьте, чтобы файл открывался (кликните после его установки на хостинге на нижнюю ссылку в окне вебмастера).

Затем нажмите кнопку Проверить для подтверждения владения сайтом.

Через DNS запись.

Просто зайдите в настройки DNS и добавьте запись типа TXT с указанным текстом.

Затем подождите несколько часов и подтвердите владение сайтом, нажав кнопку Проверить.

Убедитесь, что Вы выбрали правильную версию домена!

Например, если Вы выбрали домен с WWW., а подтверждаете владение сайтом без WWW, ничего не сработает.

КАК ДАТЬ ДОСТУП НА ЯНДЕКС.ВЕБМАСТЕР

Доступ для Яндекс.Вебмастера обязательно должен быть у Вашего SEO-оптимизатора.

Для этого перейдите в раздел Права Доступа и в окошке Делегирование праввпишите Яндекс почту Вашего оптимизатора.

При этом в разделе Метод проверки будет показано, каким образом логин получил права на сайт.

ГЛАВА 2:

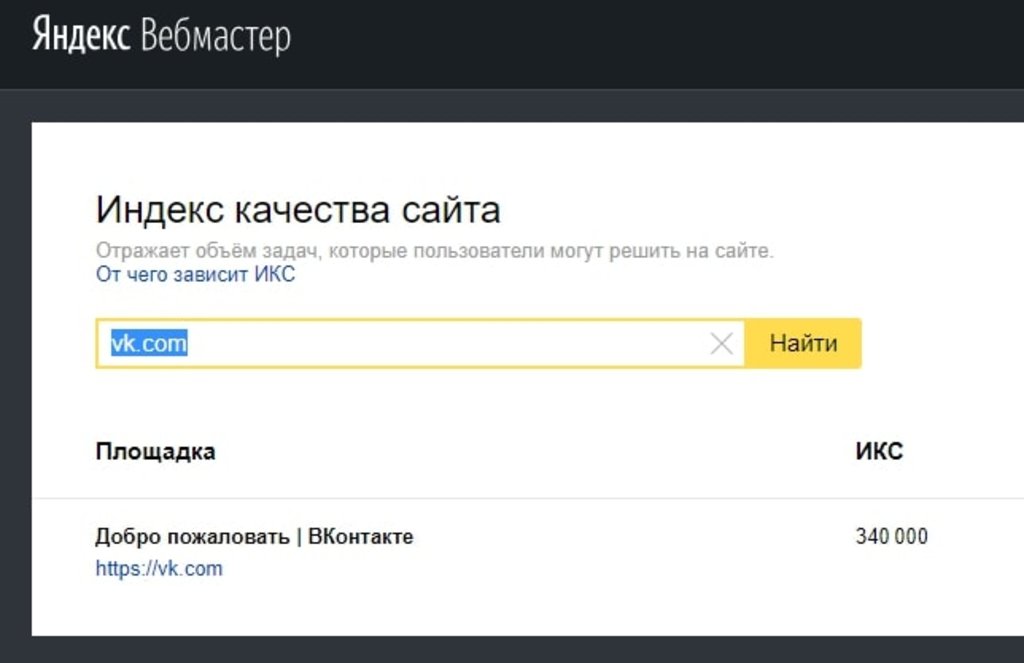

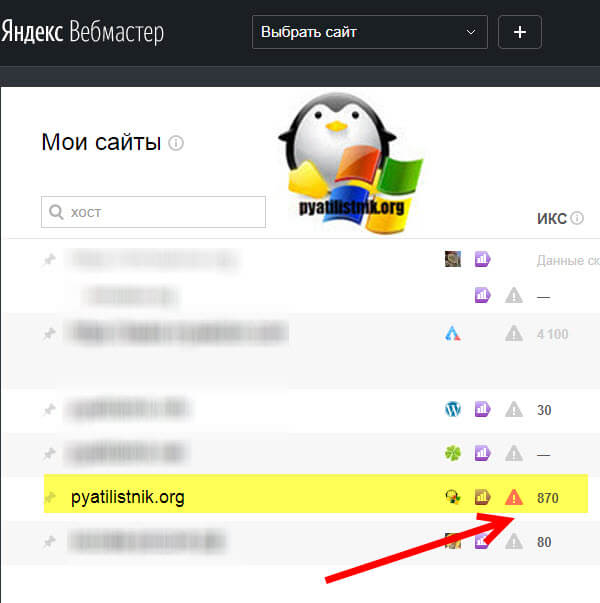

Индекс Качества Сайта

Что известно о новой пузомерке Яндекса?Как ее использовать для анализа сайта?

В чем отличие от почившего ТИЦ?

В этой главе мы все узнаем подробно.

Мы знаем, что Google отказался от своего фактора PageRank (или скрыл его метод расчета, и само значение скрыл).

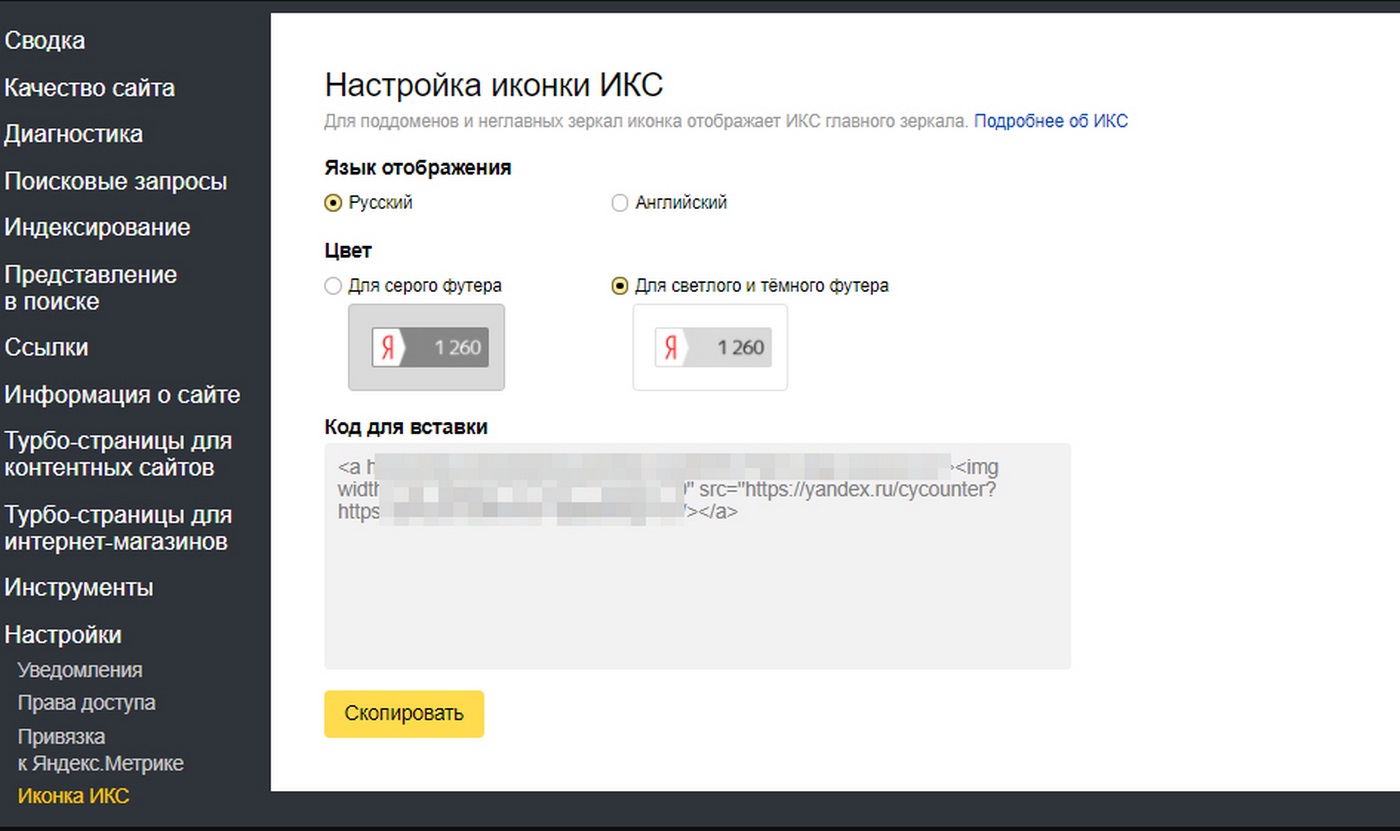

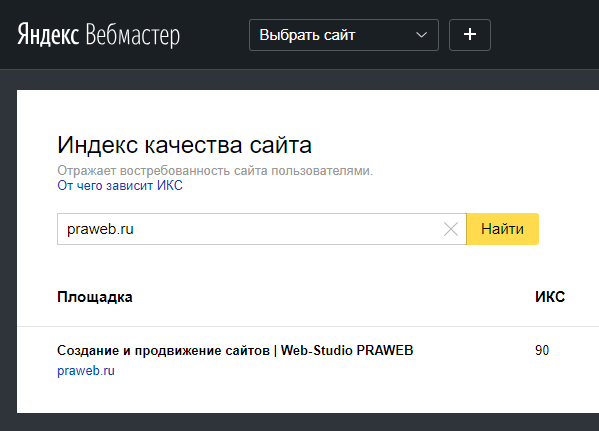

Совсем недавно Яндекс внедрил новый показатель качества сайта — ИКС (или Индекс Качества Сайта).

Он пришел на смену устаревшему ТИЦ (который учитывал индекс цитирования ссылками сайтами из Яндекс.

Так как Яндекс.Каталог уже ушел на покой, ТИЦ давно нужно было заменить.

Вебмастер Яндекс отображает ИКС вместо ТИЦ.

Вы можете провероить ИКС для любого сайта по ссылке.

Сейчас ИКС рассчитывается по следующим критериям:

- Размер аудитории сайта. Чем больше трафик Вашего сайта, тем выше потенциальный ИКС. Увеличить его можно за счет привлечения трафика на свой сайт за счет контекста, Email рассылок, рефералов и соцсетей, а также оффлайн-маркетинга.

- Уровень удовлетворенности пользователей на сайте. Улучшайте время пользователя на сайте, уменьшайте показатель отказов.

- Уровень доверия пользователей к сайту. Обычно наличие роста брендового трафика — хороший знак, что Вы становитесь более известны и поисковик начинает Вас лучше ранжировать

- Уровень доверия Яндекса к Вашему сайту. Да, у Яндекса есть свой чеклист, где он оценивает Ваш сайт по собственным параметрам. Об этом далее

- Другие критерии. Влияние асессоров (сотрудников Яндекс), скрытые алгоритмы поисковика.

Мы знаем, что ИКС для зеркал передается идентичный.

Если доменные имена совпадают, ИКС основого сайта совпадает с зеркалом.

Если Ваш сайт занимается публикацией материалов (статейник или блог), Вы можете разместить код Вашего ИКС на Вашем сайте — это будет красноречивый знак о качестве Вашего ресурса для Яндекса: ссылки с сайта с высоким ИКС ценятся гораздо выше.

ГЛАВА 3:

Возможности Вебмастера Яндекс

В этой главе мы рассмотрим, как можно использовать Яндекс Вебмастер новичку, и на какие разделы обратить внимание в первую очередь.Эти данные удивят своей полезностью даже опытных специалистов.

Теперь перейдем непосредственно к функционалу, как ним пользоваться.

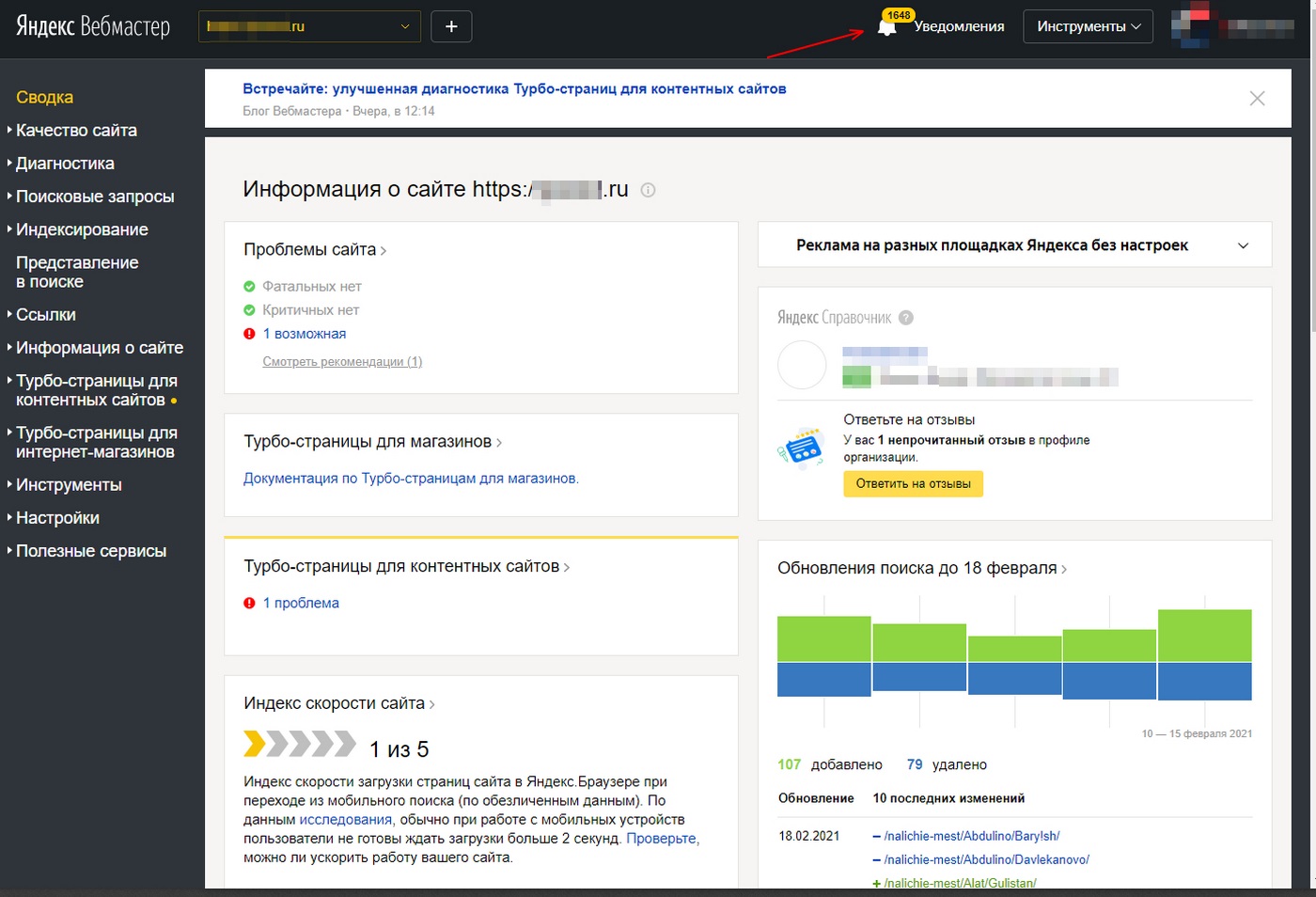

Раздел СВОДКА встречает Вас готовым набором виджетов и отображает ключевые новости (изменения) для Вашего сайта.

В Виджетах при помощи списков и инфографики отображаются последние изменения на сайте — проблемы, клики, обход поискового робота, новые ссылки на Вас и изменение индекса ИКС.

Из главного экрана перейти на более глубокие отчеты.

Диагностика сайта

Проверка сайта на ошибки, безопасность и нарушения (диагностика).

Ошибки делятся на несколько типов: фатальные, критичные, возможные проблемы и рекомендации.

Отчеты по ошибкам достаточно подробные и позволяют оперативно на них реагировать на нарушения.

Ошибки делятся на Фатальные, Критичные, Возможные и Рекомендации.

Фатальные ошибки Вашего сайта

Фатальные ошибки, которые Вы можете допустить:

- Сайт закрыт от индексации в файле robots.txt. Проверить его можно при помощи специальной утилиты в вебмастере (о ней — ниже).

- Есть ошибки DNS (вашего хостинга). Если Вы видите эту ошибку, сайт может выпасть из индекса на долгое время.

- Не загружается главная страница. Из-за различных сбоев хостинга или работы сайта, если поисковик не может получить документ главной страницы, то Вы можете потерять сайт из выдачи.

- На сайте обнаружены проблемы с безопасностью.

Есть огромное количество ошибок и нарушений, которые может применить к Вам Яндекс.

Есть огромное количество ошибок и нарушений, которые может применить к Вам Яндекс.

Нарушения безопасности — очень опасные нарушения, и могут повлечь к необратимым последствиям для Вашего сайта

После восстановления сайта от нарушения может пройти от двух до четырех недель на анализ выдачи — после обхода поискового робота пересматривается текущий показатель качества сайта и отдельных страниц.

Я кратко расскажу, что может быть применено к сайту за каждое нарушение.

Общие нарушения

- Дорвей. Если Вы создали сайт, который переводит пользователей на другой сайт, то использование дорвеев — это методика черного SEO и Яндекс за это наказывает понижений позиций или удалением из индекса.

- Клоакинг. Вид нарушения, когда Вы показываете поисковику один контент, а пользователю — другой (например, перенаправляете пользователей на закрытые от индексации страницы, а в индексе находятся безвредные версии). Этим промышляют сайты по продаже порнографического и запрещенного законодательством контента и товаров.

- Партнерские программы. Если Вы предлагаете услуги и продукцию из других сайтов, при этом сам сайт не имеет никакого полезного уникального контента. Например, в Казахстане модно создавать парсинг-клоны сайтов магазина IKEA (оригинальная компания IKEA там не работает, а товар востребован), где все страницы парсятся на основе оригинального сайта.

Ссылочные нарушения

- Покупка ссылок для продвижения. Да, если Вас Яндекс заподозрит в закупке ссылок на сторонних ресурсах, Вы приедете в Минусинск (не город). От такого фильтра избавиться очень трудно — так как Вам придется снимать ссылки вручную (обращаясь к владельцам сайтов и хостинг-провайдерам с просьбой снять ссылки). Кстати это — слабое место, ведь недобросовестные конкуренты могут накупить на Вас ссылок с мусорных ресурсов, а Вы не можете никак от этого защититься. По факту алгоритм должен блокировать некачественные ссылки, но пока это лишь в теории.

- Размещение (продажа) SEO ссылок. Да, подобный процесс касается и сайтов, которые размещают SEO ссылки.

Исходящие ссылки должны быть тематическими, неспамными и вести на целевой контент.

Исходящие ссылки должны быть тематическими, неспамными и вести на целевой контент.

Текстовые нарушения

- SEO тексты. Да, создание текстов, которые влияют на выдачу поисковой системы, является нарушением и к Вам может быть применен фильтр. Один из них — Баден-Баден, второй — более грубый — Переоптимизация.

- Сайты с бесполезным (малополезным) контентом, с нарушениями правил рекламы и распространением спама.

- Спам поисковых запросов. Создание множества страниц, заточенных под разные повторяющиеся поисковые запросы, и перенасыщенные контентом с поисковыми запросами. Обычно Вы можете подумать, что это может коснуться тегов, разделов каталога и фильтров, но это не так: фильтр направлен на запросный спам в текстовых блоках в подвале страниц, созданных для вывода посадочной страницы под поисковые ключи.

- Скрытый текст. Использование текста, который написан нулевым шрифтом или скрыт под изображением или в скрываемом блоке, напичканный ключевыми словами, который поисковик ошибочно считает полезным.

В случае нарушения выдача будет понижена.

В случае нарушения выдача будет понижена.

Мошенничество и взлом

- Накрутка ПФ (поведенческого фактора). Как известно, показатель отказов — фактор ранжирования, и иногда хочется его улучшить… любой ценой. Я бы не советовал — за это нарушение Ваш сайт может надолго вылететь из поиска.

- Предложение по накрутке ПФ (мотивация пользователей накручивать Вам поведенческие факторы) наказывается тем же.

- Подключение платных услуг подписки для мобильных пользователей. Да, Яндекс, если заподозрит Вас в этом, резко даст о себе знать.,

- На сайте обнаружены нежелательные программы или файлы (кряки, зараженные файлы, украденный контент). Наличие подобных элементов может послужить сигналом для удаления страниц из индекса.

- Опасные сайты. Если Ваш сайт подвергся заражению, он будет помечен как небезопасный.

- Фишинг. В отличие от партнерок, некоторые сайты могут быть похожи на популярные порталы — практически точными копиями. Такие сайты создаются для воровства личных данных (логины, пароли, учетные данные) пользователей

- Кликджекинг — аналогично фишингу, сайты, которые позволяют украсть личные данные пользователя, не ставя его в известность

Что делать, если Яндекс ошибся?

Методы Яндекса очень точные, и он редко ошибается.

Шанс ошибки по статистике около 1%.

Но вдруг Вам повезло войти в этот процент, Вы получили подобное письмо счастья, и Ваш сайт понизился в выдаче, или совсем вылетел из нее?

Тогда перейдите по ссылке, выберите и заполните форму.

Опишите тщательно ситуацию.

И терпеливо ждите ответа.

Критичные ошибки

Есть две критичные ошибки, которые не являются фатальными, но могут сказаться на Вашем ИКС. Мы рекомендуем их исправить как можно быстрее.

- Битые ссылки. Если на сайте много внутренних ссылок, которые не работают (отдают ошибку), это усложняет навигацию. Поисковый робот выдаст страницы с ошибками и порекомендует их исправить

- Долгий ответ сервера. Если Ваш хостинг отвечает больше 3 секунд, Ваш сайт получит понижение позиций. Если Вы увидели такую ошибку, свяжитесь с Вашим провайдером услуг хостинга (выберите VPS или подключите более мощный тариф или смените его).

Возможные ошибки

Список ошибок из этой категории может повлиять на качество, релевантность и скорость индексации Ваших страниц.

- Ошибки файла Robots.txt (нет файла, или в файле обнаружены ошибки)

- Ошибки файла Sitemap.xml (нет файла, файл давно не обновлялся, не прописан в Robots или в индекс загружены ненужные страницы или в файле есть ошибки)

- Ошибки в уникальных страницах (есть дубли контента)

- Ошибки редиректов главной страницы (неверно настроен 301 редирект)

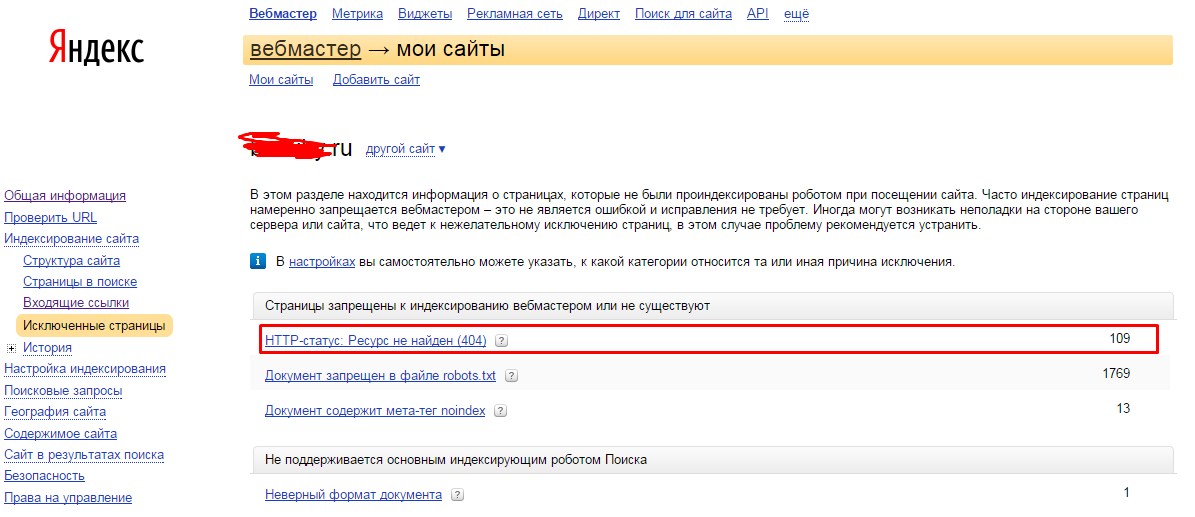

- Ошибка кода 404 Not Found (ответа на запрос на несуществующие страницы)

- Ошибки качества рекламы на сайте согласно IAB Russia.

- Ошибки в мета данных (отсутствуют теги Title и Description на страницах в индексе).

Все ошибки вполне исправимы — просто приведите в порядок файл sitemap, robots и пропишите грамотно заголовки и описания для индексируемых страниц.

Рекомендации Яндекс

Финальный список чеклиста оптимизатора уже скорее влияет на отображение и правильность индексации Вашего сайта.

Старайтесь и тут не наломать дров и не забыть про каждый пункт.

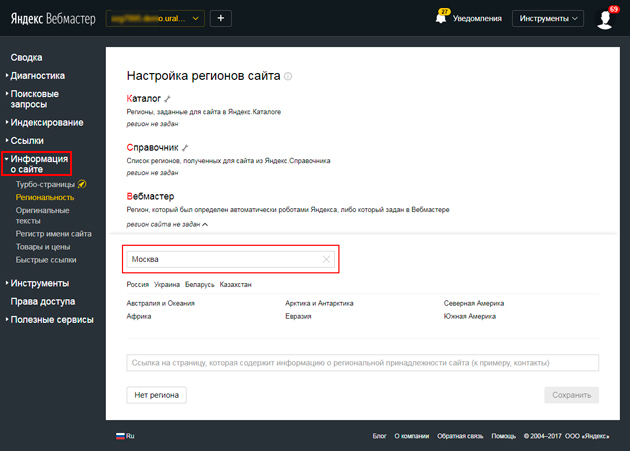

- Настройка региона для выдачи.

Укажите город и страну для гео принадлежности Вашего сайта. Сайты с городами — поддоменами — для каждого поддомена для каждого города пропишите в вебмастере уникальный город (предварительно добавьте каждый в вебмастер).

Укажите город и страну для гео принадлежности Вашего сайта. Сайты с городами — поддоменами — для каждого поддомена для каждого города пропишите в вебмастере уникальный город (предварительно добавьте каждый в вебмастер). - Сайт не найден в Яндекс Справочнике (или Яндекс Картах).

- Нет фавикона.

- Сайт не оптимизирован для мобильных. Сейчас — это важный фактор ранжирования в связи с ростом мобильного трафика. Если Вы увидели эту ошибку, передайте этот список Вашему программисту.

- Ошибка Яндекс Метрики. Сам счетчик должен обязательно быть установлен корректно для всех индексируемых страниц сайта.

- Неверная разметка для видео-контента. Используйте корректно разметку для видео на своем сайте. Полную инструкцию для программиста можно прочесть тут.

Держите этот чеклист перед глазами — и при помощи вебмастера Яндекс Вы всегда сделаете технический аудит без всяких трудностей!

ГЛАВА 4:

Раздел индексирования

Часто бывает ситуация, когда Ваш многостраничный сайт попадает в индекс с ошибками, или не полностью?В этом разделе Вы сможете контролировать индексацию сайта в Яндексе и ключевые слова, по которым Вы получаете показы и трафик.

В данном разделе находится инструментарий, отвечающий за статус нахождения страниц сайта в индексе Яндекса.

Индексация — автоматический процесс, и происходит за счет поискового робота, который руководствуется настроенной картой сайта и файлом robots, а также тегами разметки на Ваших страницах (index, follow и микроразметки).

Но также в вебмастере и ручные методы запуска механизма индексации — например в случае сбоя робота, Вы можете его перенаправить вручную.

Изучим все инструменты подробно.

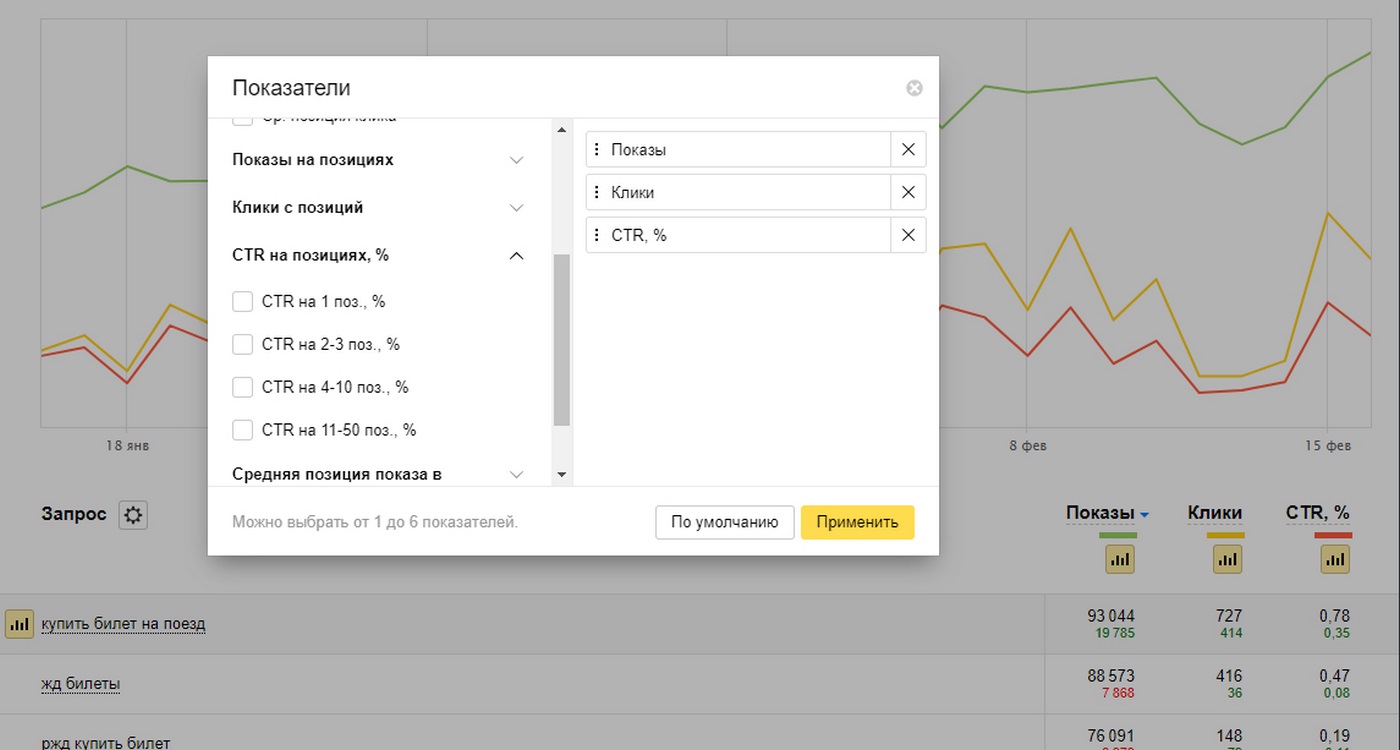

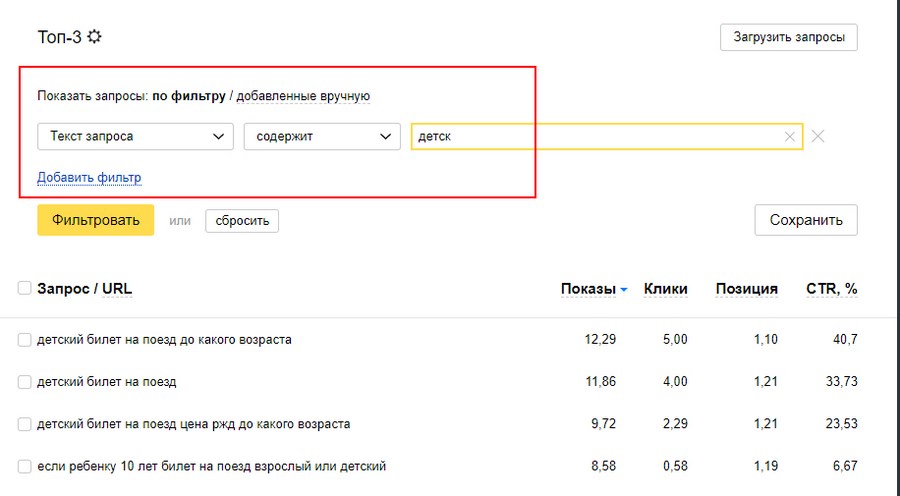

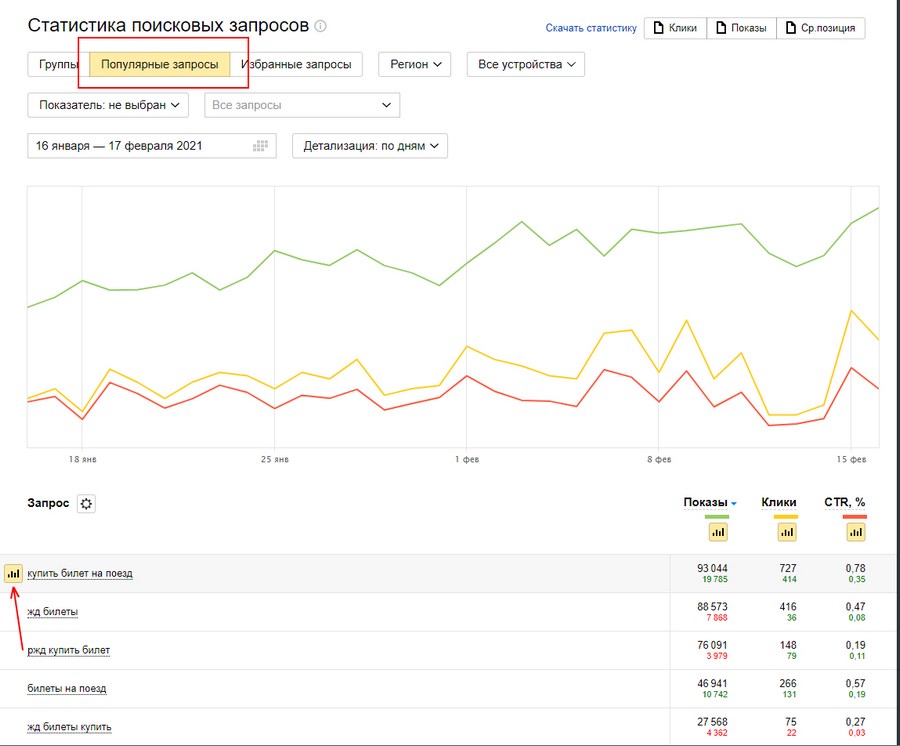

Статистика запросов

Простой и понятный способ посмотреть, какие поисковые запросы работают на Вашем сайте: какую позицию они занимают, как часто Ваш сайт отображается в поиске.

Оценивайте как для каждого запроса, так и для всего сайта в целом Позицию, Клики, средний CTR.

В разделе ВСЕ ЗАПРОСЫ и ГРУППЫ Вы можете собрать запросы в группы (Избранные или создать собственные), пользоваться простыми фильтрами для отображения данных.

На основе этих данных стройте стратегию продвижения

- Улучшайте контент на страниц, где есть смысл усилить позиции.

- Работайте над сниппетами (Title и Description) для запросов, где у Вас высокая позиция, но низкий CTR.

- Создавайте новый контент для тех запросов, где у Вас нет позиций и у Вас нет целевых страниц.

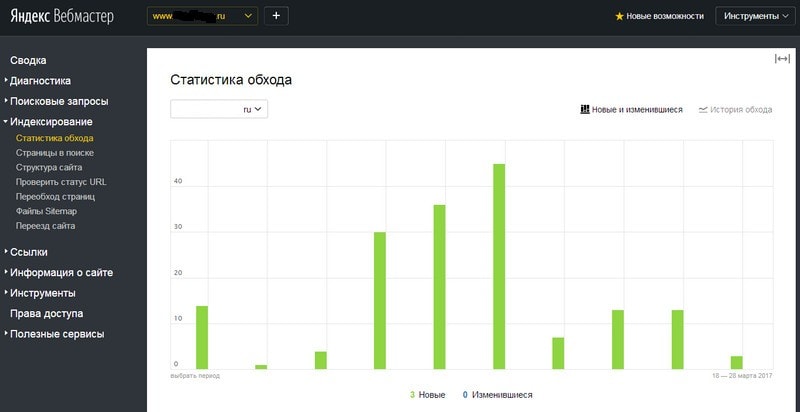

Статистика обхода

Данный раздел сайта помогает узнать, как поисковый робот Яндекс индексирует и обходит Ваши страницы.

Можно выявить, какие страницы робот обошел, а с какими возникли трудности из-за ошибок индексации.

Страницы в поиске

Отображает статистику индексации Вашего сайта — в динамике.

Сколько страниц было добавлено и удалено из индекса.

И по какой причине.

Например, недостаточно качественные страницы, выпавшие из индекса, отображаются в этом отчете.

Структура сайта

Данный раздел позволяет отследить иерархию по уровням загруженных страниц и процент индексации каждого подраздела.

Именно по этому отчету Яндекс может выделить наиболее важные разделы Вашего сайта для отображения сниппета “Быстрые ссылки”.

Утилита для переезда сайта (индексирование).

Позволяет безболезненно переехать с одного домена на другой без потери позиций.

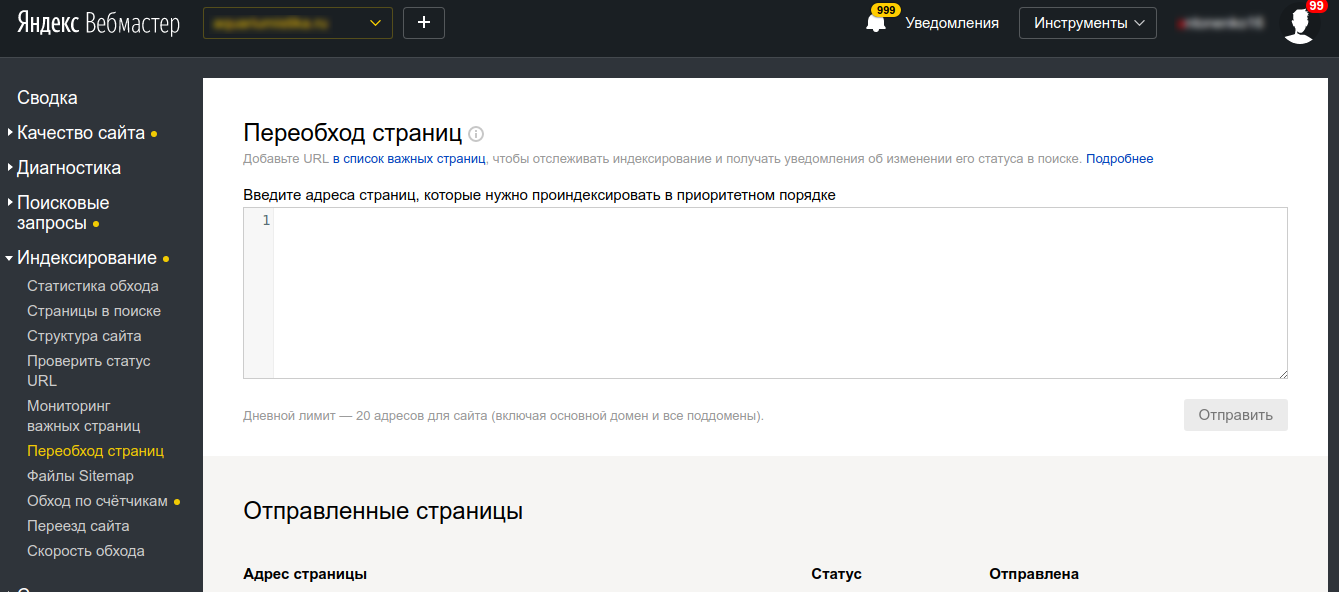

Важные страницы и переобход страниц (индексирование) позволяет отслеживать до 100 важных страниц и провести приоритетный обход роботом Яндекса до 20 новых страниц.

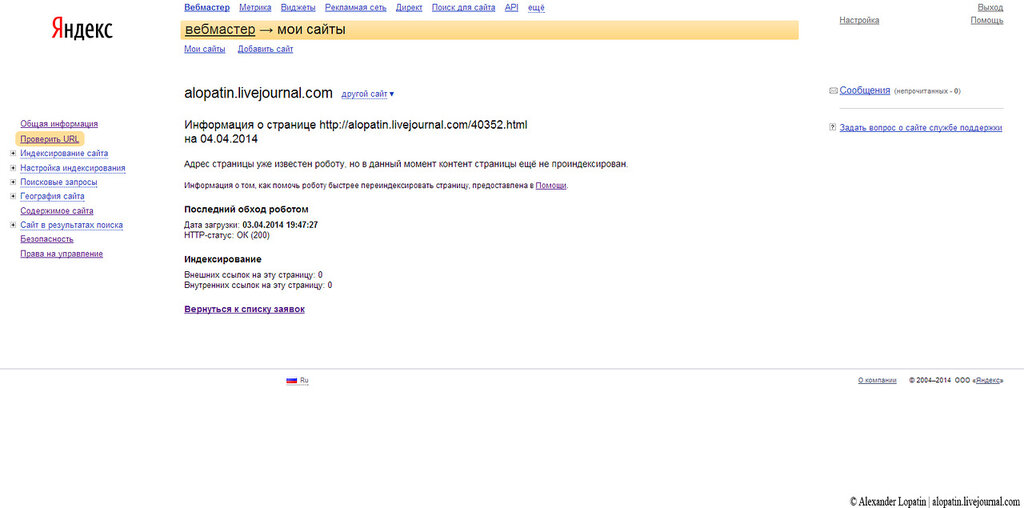

Проверить статус URL

Позволяет оперативно проверить наличие ссылки в поисковой базе Яндекс (и код отклика – 200, 301, 403 или 404).

Отслеживайте Важные страницы

Любой SEO оптимизатор должен знать, как его страницы индексируются в поиске.

Для удобства отслеживания страниц создали специальный инструмент.

Просто добавляйте списком отслеживаемые страницы и проследите за их ответом.

Если Вы не можете определиться, Яндекс Вебмастер предлагает на выбор Вам наиболее рекомендованные страницы — которые лучше всего индексируются и привлекают трафик.

Переобход страниц

Отдельный инструмент, который позволяет проверить обход страниц поисковым роботом.

Да, если вдруг у Вас медленно проводится индексация, но нужно все же ускорить добавление в индекс новых страниц, есть ручной метод для этих целей.

В день можно попросить обойти робота в ручном приоритетном порядке.

Зачем это нужно?

Например, если Ваша страница была недоступна (отдала ответ 404 сервера), она может быть исключена из индекса.

Для повторной индексации потребуется повторно роботу обойти эту страницу, а робот Яндекса очень медлителен.

Поэтому в таком случае запускайте обход отдельных страниц вручную.

Файлы Sitemap.xml

Карта сайта — это файл, содержащий список страниц для индексации.

Это не вебстраница на сайте, на которой Вы сделали ссылки!

Это отдельный файл, который находится на Вашем FTP сайта и отвечает за время обновления каждой страницы, которую Вы хотите передать списком для поисковика.

Если у Вас нет карты сайта, создайте ее.

Для добавления карты сайта в Яндекс перейдите по ссылке.

Введите ссылку на файл карты сайта и нажмите кнопку Добавить.

Также Яндекс.Вебмастер по умолчанию может подтянуть карту сайта непосредственно из файла robots.txt.

Инструмент позволяет отследить все ошибки непосредственно в картах сайта и показывает объем ссылок, которые передаются в Яндекс для индексации.

Просто кликните на Ошибки и изучите полученный отчет со списком ссылок.

Внесите правки в файлы sitemap и попробуйте снова.

Переезд Сайта

Иногда приходится переезжать со старого домена на новый.

Например, если Вы съезжаете с WWW. домена на обычный.

Или установили HTTPS сертификат.

Для вебмастера это — разные сайты.

И нужно об этом сообщить.

Или например — переехали вообще с старого домена на новый.

Для удобства, в Яндекс Вебмастере есть соответствующий раздел.

Выберите новый домен из списка с подтвержденными правами.

При помощи галочек Вы можете добавить к домену HTTPS и WWW (по мере необходимости).

Затем нужно нажать Сохранить и дождаться изменения в индексации.

Если все сделали правильно, Яндекс произведет переезд сайта без ухудшения его позиций.

Скорость обхода

Если Вы считаете, что робот Яндекса замедляет Ваш сайт или же индексация сайта проходит достаточно медленно, Вы можете внести корректировки на скорость обхода Вашего сайта.

Мы рекомендуем этот раздел менять только в крайнем случае и выставить по умолчанию пункт “Доверять Яндексу”.

Средняя скорость обхода равна 3 запросам в одну секунду на Ваш сайт.

ГЛАВА 5:

Раздел ссылочного анализа

Самый недооцененный раздел Яндекс Вебмастера.Но при помощи него можно решить множество задач — как сделать перелинковку, так и изучить внешний ссылочный профиль сайта.

Раздел ссылочного анализа

Ссылочный анализ для Вебмастера является не менее важным, чем раздел индексации.

Ссылки Вашего сайта являются важным фактором ранжирования.

На Вашем сайте по факту должны быть все исходящие рабочие ссылки (как на внешние источники, так и внутренние), так и у Вас должен быть хороший ссылочный профиль.

Анализ внутренних ссылок в Вебмастере

Раздел внутренних ссылок выдает список внутренних неработающих URL на Вашем сайте.

Проанализируйте Вашу карту сайта и внутренние ссылки на Вашем сайте и удалите битые нерабочие URLы.

Внешние ссылки

Как мы изучили, внешние ссылки — это важный инструмент вебмастера.

Если Вы хотите видеть, какие ссылки на Вас ставятся и с каким ИКС (индексом качества) — Вы можете изучить непосредственно в этом разделе.

Помните, что за покупку SEO ссылок на бирже Вы рискуете получить фильтр Минусинск и потерять значительно в выдаче.

Поэтому мы рекомендуем изучать Ваш ссылочный профиль и вовремя реагировать на некачественное проведение.

Помните, хорошие ссылки следует создавать только белыми методами.

Мы их расписывали в этой статье.

Также можете изучить в нашем материале, чем отличаются черные и белые методы продвижения.

Если вдруг Вы заподозрили, что Ваша SEO компания размещает на Вас некачественные ссылки, или же в этом деле были замечены Ваши конкуренты, мы рекомендуем изучить отчет по внешним ссылкам и вовремя известить SEO отдел.

Мы можем помочь проанализировать качество ссылочного профиля Вашего сайта.

Для этого заполните форму и мы свяжемся с Вами в течение дня.

ГЛАВА 6:

Изменение информации о сайте

В этом разделе мы рассмотрим, как можно изменить региональность Вашего сайта, а также сообщить об оригинальном контенте для защиты от кражи.

Предыдущие разделы отвечали за индексацию сайта и ссылки.

Это действительно важные факторы ранжирования.

Но следует знать, что важно не просто быть в индексе.

Важно быть в индексе по правильным ключевым словам.

В этом нам поможет раздел Информации о Сайте.

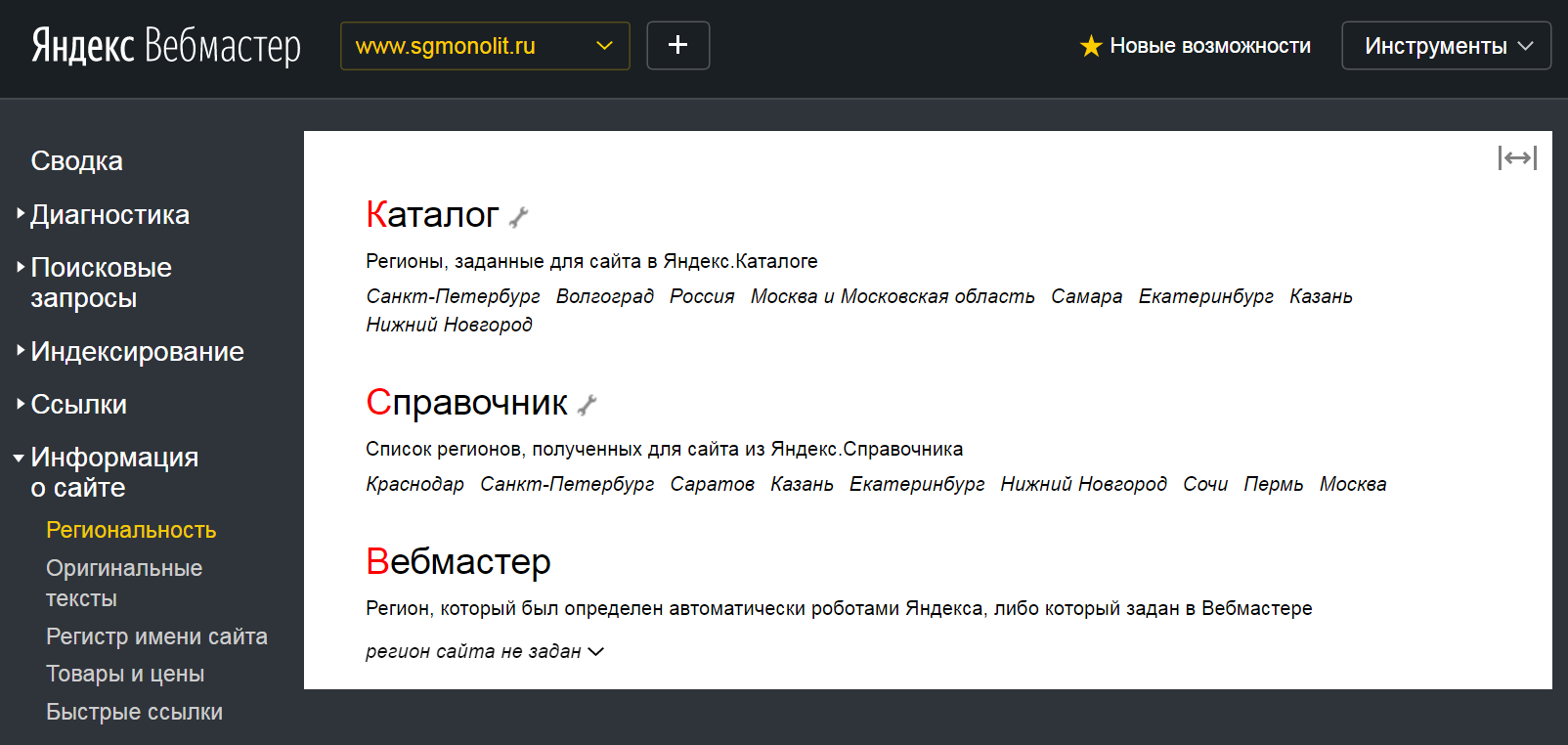

Региональность

Очень лаконичный и простой раздел.

По факту регион присваивается сайту при помощи двух инструментов — справочника и собственно — вебмастера.

В справочнике можно выбрать таргетинг вручную.

Здесь Вы можете настроить для своего сайта регион согласно Яндекс Карт.

При клике на раздел ИЗМЕНИТЬ РЕГИОНЫ Вас переадресует на Яндекс. Справочник, где будет предложено отредактировать Ваши данные на Яндекс.Картах.

Справочник, где будет предложено отредактировать Ваши данные на Яндекс.Картах.

Вы можете присвоить нужный город, адрес и телефон Вашей компании, а также категорию бизнеса.

Для верификации следует подождать некоторое время — в случае подтверждения Вы получите соответствующее уведомление.

В Яндекс.Вебмастере Вы можете прописать вручную регион, но для верификации потребуется указать страницу, где указаны Ваши адресные данные.

Защита от копирования оригинальных текстов

Часто бывает ситуация, когда Вы пишете тексты, но их успевают у Вас украсть?

Или же нужно успеть написать свой контент первым?

А Вы можете опубликовать контент, но в индекс попадаете медленнее конкурентов?

Раздел “Оригинальные тексты” позволяет добавить тексты до их предварительной заливки на сайт во избежание воровства (перепечатывания) Вашего уникального контента.

В день можно заливать не более 100 текстов объемом от 500 до 32 тыс. символов.

Очередность добавления контента отображается ниже.

Регистр имени сайта

Иногда хочется выделить составное имя в своем названии.

Например, если оно состоит из двух слов.

И нужно, чтобы в выдаче каждый слог был выделен разным регистром?

Перейдите в раздел Регистр Имени Сайта и пропишите его так, как Вам нужно.

И желательно опишите причину.

Это не влияет на SEO и результаты выдачи, но влияет на отображение Вашего сайта в результатах.

Есть определенные ограничения: нельзя делать 5 заглавных букв подряд, заглавные буквы аббревиатур должны подтверждаться контентом сайта, слитные слова.

Слова, разделенные дефисом, не подвергаются изменению.

В нижнем регистре всегда прописываются домены первого уровня (com.ua, org, ru) и префиксы (www., ftp.).

Товары и цены

Вы знаете, что у Яндекса есть свой инструмент для привлечения трафика для интернет-магазина — Яндекс.Маркет.

Но Вы можете улучшить свое отображение сниппетов в выдаче.

Первоначально подключите свой магазин к Яндекс. Маркету.

Маркету.

Ознакомьтесь с лицензионным соглашением и создайте Файл YML со списком Ваших товаров.

Он Вам дальше пригодится.

После добавления магазина в Яндекс.Маркет в вебмастере Вы сможете прописать все необходимые данные и отредактировать сниппеты.

Раздел “Товары и цены” позволяет подключить к Вашему сайту Яндекс.Маркет.

Создайте YML файл со списком выгружаемых товаров и зарегистрируйтесь в Яндекс.Маркет и отслеживайте работу Вашего магазина.

Быстрые ссылки

Мы уже рассказали, что в сниппете мы не можем повлиять на быстрые ссылки.

Но в Вебмастере есть инструмент, который позволяет выбрать из подходящих быстрых ссылок нужные.

Вы можете отключить ненужные (1) быстрые ссылки, а также отсортировать весь список по весу.

Вес ссылок распределяется благодаря внутренней перелинковке.

Распределяйте правильно вес внутренних ссылок по сайту, чтобы важные ссылки получали больше разделов.

Это обычно достигается за счет хлебных крошек, организованного каталога и удобной навигации в статьях и товарных страницах.

Если Вы выбрали нужные быстрые ссылки, Вы можете изучить, как будет выглядеть Ваш сниппет.

Турбо-страницы

Мобильные технологии шагают вперед достаточно быстро.

Одна из особенность мобильных устройств — это малые размеры, а вторая — небольшие потребности в трафике.

Так, веб-страницы для мобильных устройств должны загружаться быстро.

Причем — очень быстро.

Одна из новых технологий Яндекса — поддержка Турбо-страниц.

Все настройки турбо страниц Вы производите непосредственно в Яндекс Вебмастере — просто настройте свой RSS канал (или загружайте контент через API).

Проверка обычно занимает около двух часов.

В разделе настроек Вы можете выбрать тип отображения Ваших турбо страниц, добавить стили CSS Для персонализации, настроить меню и подключить счетчики отслеживания.

В разделе ОТЛАДКИ Вы сможете проверить отображение своего сайта в простом редакторе.

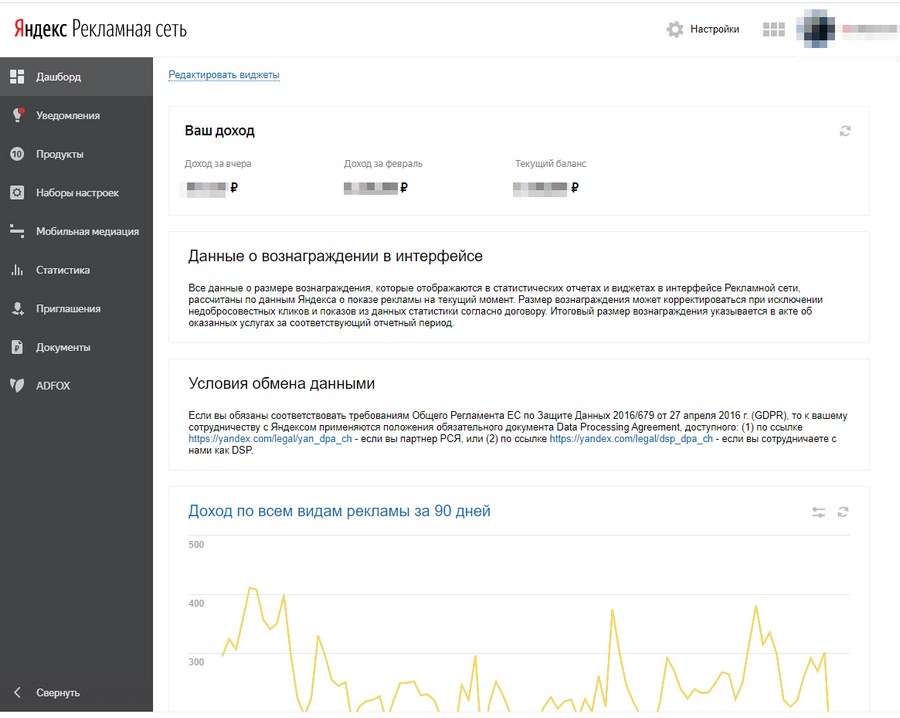

Если Вы подключены к рекламной сети Яндекса (РСЯ) или сети ADFOX, Вы можете добавить отображение рекламных блоков.

ГЛАВА 7:

Инструменты Яндекс Вебмастера

В этом разделе мы рассмотрим инструменты, которые доступны внутри интерфейса Яндекс.Вебмастер

Еще Яндекс Вебмастер, как и Гугл Вебмастер, предлагает свои утилиты.

Валидатор XML фидов

Валидатор XML фидов позволит проверить экспортные файлы XML, которые используются в сервисах Яндекс: в Яндекс.Недвижимости, Авто, Работе, Видео, Яндекс.

Отзывах, Маркете и Справочнике.

Просто выберите тип файла, укажите ссылку (или загрузите) и проверьте результат соответствия.

Незаменима для программистов — часто приходится настраивать.

Валидатор микроразметки

Валидатор микроразметки позволит проверить корректность установки микроразметки на Вашем сайте и даст рекомендации по ее настройке.

Есть удобный инструмент.

Проверка мобильных страниц.

Проверка мобильных страниц.

Позволяет проверить, оптимизирована ли конкретная посадочная страница для мобильных устройств, покажет превью мобильной версии и даст рекомендации относительно отдельных ошибок.

Утилита достаточно простая.

Вставьте ссылку и подождите несколько минут.

Готовый чеклист проверяет, прописали ли Вы Viewport для мобильных устройств, не прогружается ли горизонтальная прокрутка, отсутствуют ли Flash/Silverlight/JAVA элементы, и размер шрифта достаточно крупный, чтобы был удобен для чтения.

Также Яндекс не преминет напомнить о Турбо страницах, если Вы их не внедрили.

Удалите ссылку из индексации

Удалите ссылку из индексации.

Иногда бывает, что ссылки могли ошибочно попасть в индекс, (например — плохой программист или SEO оптимизатор открыл все страницы в Robots.txt) а на их удаление может пройти несколько месяцев.

А нужно все решить в считанные часы.

На помощь приходит простой и понятный инструмент.

Поддерживает два интерфейса.

Удаление по URL позволяет закинуть списком ссылки, которые требуется удалить вручную.

В день можно закинуть по 500 страниц.

Второй способ пригодится в более тяжелых случаях — например, для удаления из индекса целых разделов сайта.

Не забудьте внести правки затем в файл robots.txt во избежание повторного попадания в индекс.

Проверка ответа сервера

Проверка ответа сервера позволит отслеживать важные страницы, а также в ручном режиме проверить работоспособность страниц и их обход поисковым роботом.

Утилита достаточно понятная, и отображает, как поисковый робот воспринимает контент каждой страницы.

Инструмент проверки Sitemap.xml

Инструмент проверки Sitemap.xml позволит проверить качество собранного файла карты сайта.

Просто вставьте ссылку и проверьте, есть ли ошибки — попадают ли в карту закрытые от индексации страницы.

Сервис отклонения ссылок Яндекс.Вебмастер

К сожалению, сервиса, аналогичного Disavow Links, как у Гугла, у Яндекса пока не предвидится, поэтому, если конкуренты разместили на Вас много ссылок, в вебмастере Вы ничего сделать не сможете.

Есть огромное количество жалоб по этой теме в сети, и Яндекс всячески старается дорабатывать алгоритм по отслеживанию некачественных ссылок.

Как я говорил, также не стоит забывать, что в Вебмастере есть собственная техподдержка, где можно изложить претензии и написать сообщение напрямую.

ВЫВОДЫ

Яндекс Вебмастер — один из наиболее мощных инструментов для анализа ошибок Вашего сайта.

Те SEO оптимизаторы, которые не анализируют ошибки при помощи Вебмастеров, обычно затем не понимают, почему их сайты не продвигаются в ТОП и вообще почему теряют позиции в Яндекс.

Хотите проверить качество Ваших оптимизаторов?

Зайдите в вебмастер Яндекс и изучите следущие отчеты в первую очередь:

- Есть ли ошибки в разделе Диагностика. Если они были, посмотрите, когда были отправки на повторный анализ

- Нет ли никаких санкций в разделе Безопасность и нарушения?

- Какие запросы находятся в избранных? Идет ли отслеживание позиций по ним? Соответствуют ли они Вашему семантическому ядру сайта?

- Проводите ли Вы мониторинг Важных страниц сайта? Есть ли они в индексе?

- Добавлены ли карта сайта в вебмастере?

- Добавляются ли новый контент для статей в раздел Оригинальные тексты?

- Используется ли привязка к региону в справочнике и вебмастере?

- Включен ли раздел Товары и Цены для интернет-магазинов?

- Используется ли раздел Турбо-страницы для блога и новостного сайта?

- Проверьте статус URL важных страниц.

Есть ли они в индексе и обходятся ли они роботом.

Есть ли они в индексе и обходятся ли они роботом.

Этот несложный чеклист позволит Вам узнать, проводит ли Ваш SEO оптимизатор работу над сайтом и как он держит его в тонусе.

Оставляйте комментарии и делитесь своими успехами в продвижении!

Новый Яндекс.Вебмастер: полное руководство

От редакции: Чудеса случаются. Такой вот подробнейший гайд нам прислал для публикации.. выпускник академии 🙂 Яндекс.Вебмастер позволяет видеть (в прямом смысле слова) все, что происходит с сайтом в плане индексации и продвижения в поисковой системе Яндекс. Поэтому это наиполезнейшая статья для всех SEOшников. Наслаждайтесь чтением.

Где найти Яндекс.Вебмастер (для совсем новичков)

Добавление сайта в новый Вебмастер

Обзор всех разделов нового Яндекс.Вебмастера и руководство по их использованию

Раздел «Индексирование»

Раздел «Настройка индексирования»

Раздел «Инструменты»

Раздел «Права доступа»

Бонус: обзор уведомлений в новом Яндекс. Вебмастере

Вебмастере

Кто-то привык к старому интерфейсу Яндекс.Вебмастера и не оценил преимущества нового. Зря. Теперь у владельцев сайтов больше возможностей влиять на индексирование и отображение своего ресурса в поиске Яндекса. Сейчас проще обнаруживать ошибки и вовремя их исправлять. После прочтения этой статьи станет еще проще.

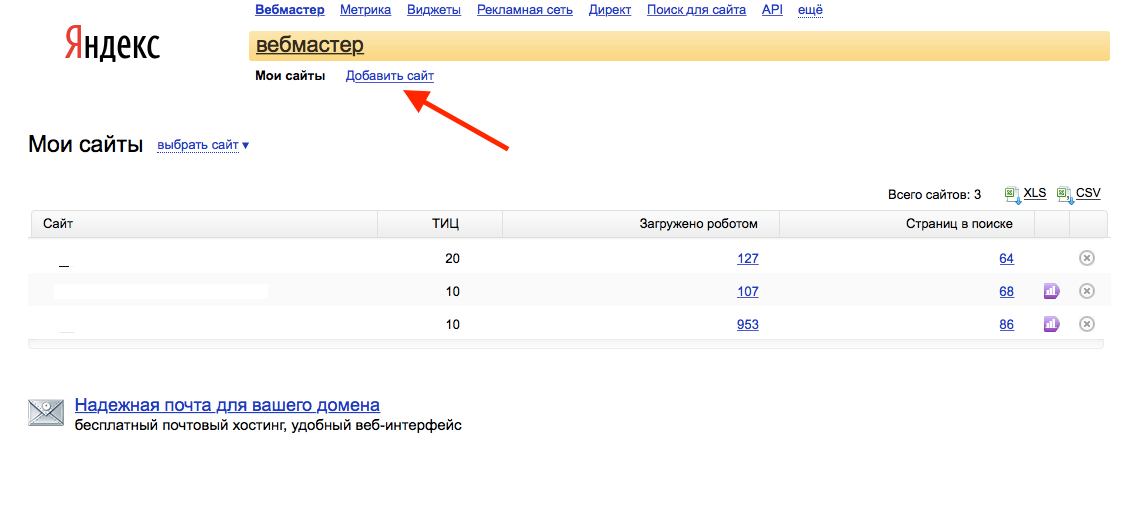

Где найти Яндекс.Вебмастер (для совсем новичков)

Подраздел для тех, кто вообще ни разу не пользовался Яндекс.Вебмастером. Если вы считаете себя более-менее опытным пользователем, пропускайте его.

Итак, если вы даже не представляете, где найти Яндекс.Вебмастер, зайдите в Яндекс.Почту (электронную почту, зарегистрированную на Яндексе), нажмите в правом верхнем углу на слово «ЕЩЁ», а потом на фразу «Все сервисы».

Разбираемся, как из почты перейти в кабинет Вебмастера.

Вы попадете на страницу со множеством сервисов. Ищите раздел «Для бизнеса» (он находится практически в самом низу). В этом разделе нужно нажать на ссылку «Вебмастер».

Вебмастер на странице с различными сервисами Яндекса

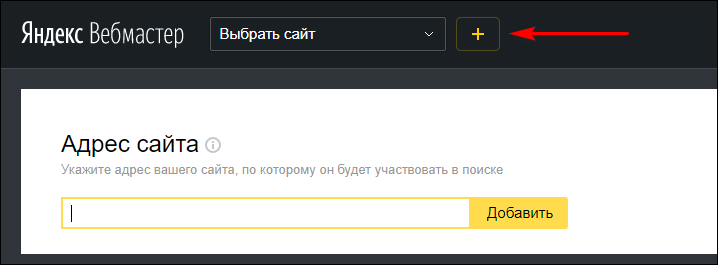

Добавление сайта в новый Вебмастер

Когда вы через почту попадете в Яндекс.Вебмастер, вам нужно будет добавить один или несколько сайтов.

Это можно сделать с помощью кнопки со значком «+», которая находится чуть правее надписи «Вебмастер» в левом верхнем углу экрана.

Добавление сайта в обновленный Вебмастер

Когда вы нажмете на «+», надо будет ввести адрес своего сайта и нажать кнопку «Добавить».

Добавление сайта в обновленный Вебмастер (добавление URL)

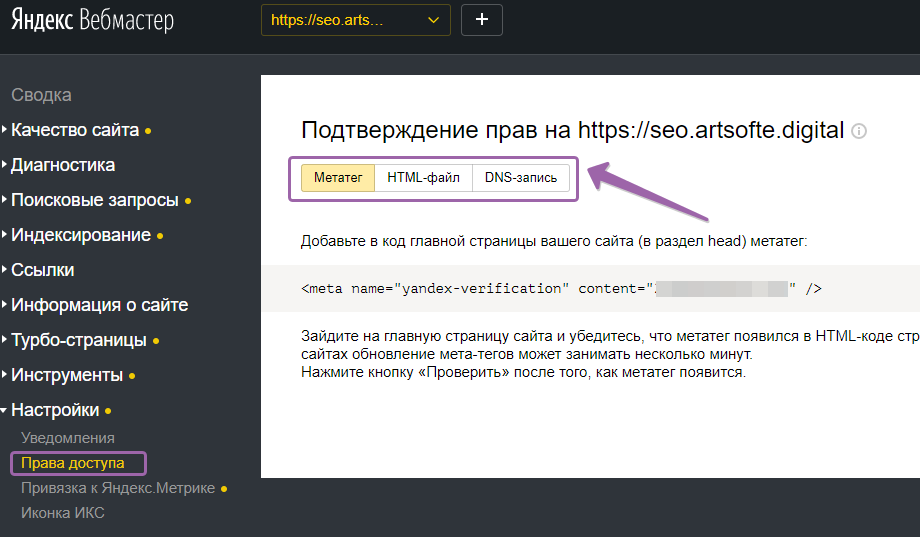

После этого нужно подтвердить права.

Добавления мета-тега – как вариант подтверждения прав на сайт

Выбирайте способ подтверждения: «Мета-тег», «HTML-файл» или «DNS-запись». Самым простым вариантом считается добавление HTML-файла. Скачивайте специальный файл, который предлагает вам Вебмастер и добавляйте его в корневой каталог (главную папку) сайта.

Добавления HTML-файла в директорию сайта на хостинге – как вариант подтверждения прав на сайт

Подтвердить права с помощью мета-тега – тоже простой и удобный вариант.

Нужно скопировать код с Вебмастера и поместить его в тег head.

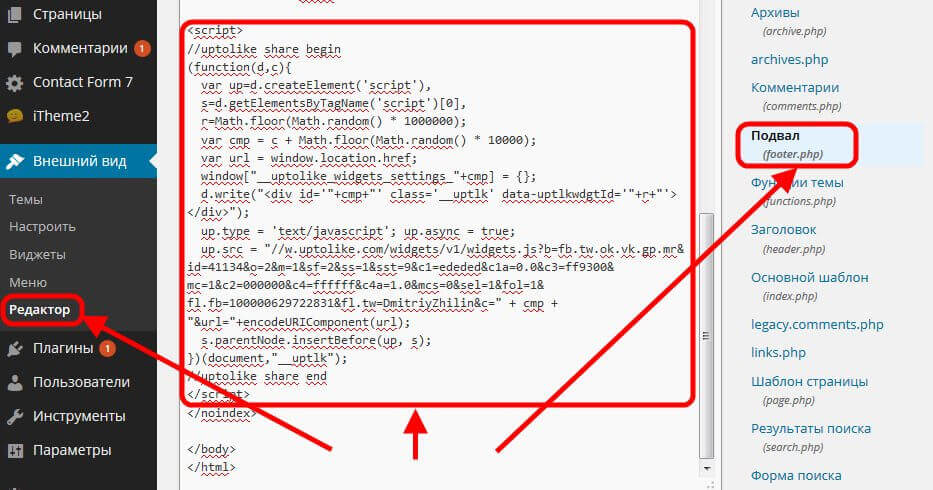

Если ваш сайт создан на CMS WordPress, зайдите в раздел административной панели «Внешний вид», потом в подраздел «Редактор». После чего выберите файл с названием «header.php». В этом файле нужно найти закрывающий тег и над ним поместить код из Вебмастера.

Маленький полезный нюанс! Если кода в header.php слишком много и вы не можете найти , воспользуйтесь поиском по странице в вашем браузере. Нажмите комбинацию клавиш Ctrl + F, скопируйте в поле поиска и нажмите на стрелочку. Браузер найдет нужное место и подсветит нужный участок кода.

Если вы сделали все правильно, вас перебросит в раздел «Права доступа», где можно посмотреть всех владельцев сайта.

В помощи сказано, что на подтверждение прав может понадобиться несколько минут. На самом деле обычно нужно не более пары секунд. Вы добавили мета-тег или HTM-файл, нажали кнопку «Проверить» – все. Теперь для вашего сайта доступны все возможности обновленной версии Яндекс.Вебмастера.

На самом деле обычно нужно не более пары секунд. Вы добавили мета-тег или HTM-файл, нажали кнопку «Проверить» – все. Теперь для вашего сайта доступны все возможности обновленной версии Яндекс.Вебмастера.

Важно! Сайтом могут владеть несколько людей одновременно. Каждый, кто подтвердил права, может использовать все функции Яндекс.Вебмастера.

Прежде, чем вы начнете изучать руководство в этой статье, стоит упомянуть, о Яндекс.Помощи. Ссылка на нее находится в самом низу интерфейса Вебмастера.

Там можно уточнить или узнать дополнительную информацию о той или иной функции Яндекс.Вемастера. Важно, что ссылка «Помощь» перебросит вас именно туда, куда нужно. Если, например, вы находитесь в разделе «Индексирование» и нажимаете на «Помощь», вы попадаете на статью именно об индексировании.

Обзор всех разделов нового Яндекс.Вебмастера и руководство по их использованию

1. Раздел «Общая информация»

Общая информация в обновленном Яндекс. Вебмастере

Вебмастере

В этом разделе можно узнать следующее:

1. Проблемы сайта. Если есть какой-нибудь вид проблем («Фатальные», «Критичные» или «Возможные»), можно сразу узнать подробности и советы от Яндекса. Например, на скриншоте вверху видно, что на сайте присутствуют возможные проблемы. Чтобы узнать, какие это именно проблемы, надо нажать на надпись «Возможные проблемы», которая сейчас превратилась в ссылку.

2. Индексирование. Сразу видно количество загруженных страниц, количество страниц в поиске и тех, которые Яндекс решил исключить. Об индексировании более подробно будет рассказано чуть ниже.

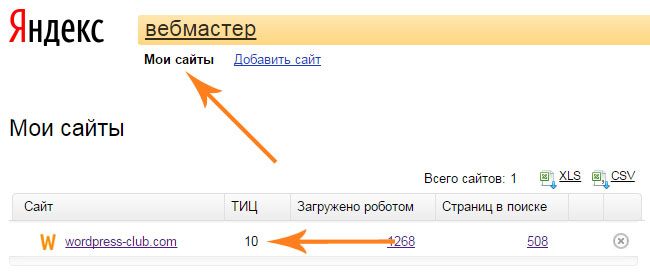

3. тИЦ. В принципе все понятно. Здесь показан Тематический индекс цитирования Яндекса. Параметр, который как бы никак не влияет на ранжирование сайтов и вообще ни на что не влияет, но который почему-то на одном из самых видных и главных мест в Яндекс.Вебмастере.

Маленький полезный нюанс! Стоит упомянуть, что по умолчанию данные о тИЦ показаны за последний месяц. Чтобы узнать о динамике индекса цитирования вашего сайта за более обширный период, нажмите на надпись «выбрать период».

Чтобы узнать о динамике индекса цитирования вашего сайта за более обширный период, нажмите на надпись «выбрать период».

ТИЦ в новом Яндекс.Вебмастере

Появится ползунок, с помощью которого можно выбрать нужный период и проследить изменение тИЦ на сайте. Обратите внимание, что на скриншоте внизу рядом с числом «20» появилось «↑100%». Это означает, что за выбранный вами период тИЦ вырос на 100%.

ТИЦ в новом Яндекс.Вебмастере

2. Раздел «Диагностика »

Этот раздел разбит на 3 подраздела.

1. «Диагностика сайта»

Подраздел «Диагностика сайта» в Яндекс.Вебмастере.

Здесь показаны проблемы сайта. Те же самые, что и в разделе «Общая информация». Только здесь больше функций.

Например, можно посмотреть динамику появления и исчезновения проблем на сайте на протяжении года. Для этого нужно нажать на кнопку «Другие дни» в правом верхнем углу.

Динамика возникновения и устранения проблем на сайте в кабинете Яндекс.Вебмастера

На скриншоте видно, что в декабре прошлого года на сайте была одна возможная и одна критичная проблема. Критичную устранили 15 декабря.

В этом подразделе можно не только узнать, какие именно ошибки обнаружены на сайте, но и конкретные страницы с ошибками. Например, если у вас отсутствуют мета-теги , нажмите на ссылку «Ознакомьтесь», чтобы посмотреть, на каких страницах следует дописать Description.

Возможные проблемы на сайте, о которых предупреждает Яндекс.Вебмастер

Маленький полезный нюанс! Description должен быть только на тех страницах, которые участвуют в поиске и нужны для привлечения трафика и клиентов. Не всегда необходимо прописывать этот мета-тег на всех страницах. На сайте могут быть отзывы или другие страницы, которые полезны для пользователя, но которые не продвигаются в поиске. Имейте это в виду. Не старайтесь устранить каждую мелкую ошибку на сайте. Лучше вложить время в действительно важные страницы.

Не старайтесь устранить каждую мелкую ошибку на сайте. Лучше вложить время в действительно важные страницы.

В подразделе «Диагностика сайта» есть еще одна полезная ссылка, о которой следует рассказать – «Посмотреть всё, что проверяет Вебмастер».

Ссылка, чтобы проверить свой ресурс на наличие ряда проблем

Если на нее нажать, можно увидеть много пунктов.

Важно, что там есть пункты «Отсутствуют теги title» и «Отсутствуют мета-теги ».

Вебмастер не только сообщает, что Description’а нет, но и дает возможность посмотреть, на каких именно страницах отсутствует этот мета-тег

Но нет пункта о keywords. Можно считать, что таким образом Яндекс официально признал, что для него не имеет значения, есть ли этот мета-тег на сайте.

До сих пор на форумах оптимизаторов появляются вопросы в стиле: «А что делать с keywords? Прописывать или нет? В одних источниках говорят, что он обязателен, в других, что поисковики давно не обращают на него внимания».

Думаю, что Яндекс наконец-то однозначно ответил на этот вопрос.

Интересный нюанс! Существует теория, что поисковики намеренно обманывают оптимизаторов. Анонсируют одно, а на деле все по-другому. Если вы верите в эту теорию, обязательно прописывайте keywords. Иначе ТОПа не видать.

2. «Безопасность»

Подраздел «Диагностика сайта» в Яндекс.Вебмастере.

Этот подраздел рассказывает нам о вредном коде на сайте. Заглядывайте в него после того, как давали доступ к своему ресурсу сторонним специалистам.

3. «Нарушения»

«Нарушения» – самый страшный подраздел в новом Яндекс.Вебмастере. Перед сном в него лучше не заходить.

Нужно отметить, что теперь с помощью нового Вебмастера Яндекс честно рассказывает о наложенных фильтрах.

Вот такую приветливую надпись я увидел, когда заглянул в Яндекс.Вебмастер одного сайта, над которым мне предложили работать.

Раньше фильтры можно было определить по косвенным признакам или с помощью специальных сервисов. Обновленный Вебмастер не только рассказывает, под какие санкции попал сайт, но и дает довольно подробное описание фильтра и рекомендации о том, как от него избавиться.

Нужно нажать кнопку «Подробнее о нарушении» и прочитать справку Яндекса.

В справке есть ссылки на дополнительные статьи, которые дают еще больше информации о фильтре и способах убрать его с сайта.

Узнать, наложены ли санкции на ваш сайт можно также и в разделе «Общая информация».

Когда веб-сайт под фильтром, у вас появляется фатальная проблема. Рядом с надписью «Фатальные» не зеленая галочка, а красный кружочек с восклицательным знаком, а вместо нуля положительное число.

Когда видите что-то подобное, нужно срочно действовать – исправлять фатальные, а потом возможные проблемы.

Важно! Когда на сайте есть фатальная проблема – это не всегда признак наложения фильтра. Нажмите на надпись «Фатальные», чтобы узнать точно.

Нажмите на надпись «Фатальные», чтобы узнать точно.

В этом же подразделе в случае санкций внизу появляется желтая кнопка «Я все исправил». Когда вы уверены, что все нарушения исправлены, смело нажимайте на эту кнопку, но учтите, что в ближайший месяц на нее нажимать нельзя. Яндекс разрешает отправлять сигнал об устранении проблем на сайте не чаще раза в месяц.

В Яндекс.Помощи сказано, что санкции снимаются примерно через две недели после отправления сигнала. Мне довелось только один раз пользоваться этой волшебной кнопкой. Как оказалось, Яндекс.Помощь не врет. Фильтр за кликджекинг действительно сняли через 2 недели.

3.Раздел «Поисковые запросы»

В этом разделе 2 подраздела.

1. «Статистика»

Статистика поисковых запросов в новом Яндекс.Вебмастере

По умолчанию вам показана статистика всех запросов. Статистика обновляется не каждый день. Но можно узнать, что происходило 10 дней назад: сколько запросов было показано в поиске, на какие из них нажимали пользователи и какой в итоге получился CTR.

Чтобы изменить период, за который вы хотите посмотреть данные о запросах, нажимайте на поле с датами.

Выбираем период, чтобы посмотреть данные о запросах

Максимальный период, который можно выбрать – 1 год.

Во вкладке «Популярные запросы» можно посмотреть статистику самых популярных запросов, ведущих на ваш сайт.

Выбираем период, чтобы посмотреть данные о запросах

Чтобы посмотреть количество показов, кликов и среднюю позицию определенного запроса за определенный промежуток времени, просто нажимайте на него. Если хотите сравнить его показатели с показателями других запросов, нажимайте чуть левее. Чтобы рядом с запросом появился желтый значок диаграммы (как на скриншоте вверху).

Во вкладке «Избранные запросы» можно посмотреть самые важные запросы, которые вы сами должны добавить (как добавлять, будет рассказано ниже).

Избранные запросы в обновленном Яндекс. Вебмастере.

Вебмастере.

Имейте в виду, что сразу после добавления запросов в «Избранные запросы» (или любую другую группу), статистика по ним отображаться не будет (как она не отображается для запросов на скриншоте). Нужно несколько дней, чтобы собралась статистика для определенной группы. Данные из других, уже созданных некоторое время назад групп, для тех же самых запросов не копируются.

Вкладка «Регион» создана для того, чтобы смотреть, как запросы отображаются/не отображаются в каком-то конкретном географическом регионе.

Избранные запросы в обновленном Яндекс.Вебмастере.

Кстати! Когда я готовил статью, я обнаружил, что мой блог показывается (точнее показывался 10 дней назад) в Китае вот по таким запросам.

Запросы, которые интересуют китайцев на сайте копирайтера.

2. «Последние запросы»

Последние запросы в обновленном Вебмастере.

Здесь показаны запросы, по которым сайт появлялся в поиске за последнюю неделю.

Как видно на скриншоте вверху, можно посмотреть отдельно запросы, которые входят в ТОП 3, ТОП 10 и ТОП 50.

Также здесь удобно создавать свои группы запросов. Для этого нужно нажать «Создать группу», потом написать подходящее название и нажать «Сохранить».

Создание своей группы с запросами в Вебмастере Яндекса.

Когда группа будет создана, в нее можно добавить запросы двумя способами.

1. Загрузить с помощью копирования текста или выбора файла с текстом.

Добавление нужных запросов в группу, которую вы создали.

2. Выбрать нужные запросы из тех, что уже были показаны в поиске.

Добавление нужных запросов в группу, которую вы создали.

В «Избранные» запросы можно добавлять таким же образом. Отмечайте галочкой слова и словосочетания, которые представляют для вашего сайта наибольший интерес и жмите «Добавить запросы в избранное».

Судя по Яндекс. Помощи, в одну группу можно добавить максимум 1000 запросов, а для одного сайта есть возможность создавать не более 100 групп.

Помощи, в одну группу можно добавить максимум 1000 запросов, а для одного сайта есть возможность создавать не более 100 групп.

Стоит немного сказать о фильтре для запросов. Это довольно полезный инструмент, который позволяет получать точные данные о каком-то одном аспекте, связанном с запросами. Например, если вы настроите фильтр, как показано на скриншоте ниже, вы сможете увидеть все запросы, которые находятся на 3-м месте в выдаче Яндекса.

Пример того, как можно использовать фильтр в Яндекс.Вебмастере.

Раздел «Индексирование»

В этом разделе 5 подразделов.

1. «Статистика»

Статистика индексирования в Яндекс.Вебмастере 2016 года.

На что надо обратить внимание в этом подразделе:

1. Страницы в поиске. Это самые важные данные. В Яндекс.Вебмастере должны отображаться все страницы, которые вы оптимизировали и готовили для привлечения трафика. Если на зеленом графике, который отвечает за количество страниц в поиске, наблюдается резкое падение, как правило, нужно срочно предпринимать меры (хотя иногда это временно, и после переобхода роботом страницы снова возвращаются в индекс).

2. Ползунок под графическими данными. Здесь, как и под графиком с тИЦ, можно выбрать определенный период времени, и посмотреть как за это время менялась статистика индексирования.

Почему загруженных страниц много, а страниц в поиске гораздо меньше?

В «Загруженные страницы» попадают удаленные или недоступные страницы:

Удаленные страницы в Яндекс.Вебмастере.

Страницы, с которых настроен 301-й редирект:

Страницы, которые отдают код 301.

А также те разделы сайта, которые закрыты с помощью тега noindex (например, страницы пагинации):

Страницы в теге noindex, которые также можно увидеть в Яндекс.Вебмастере.

2. «Структура сайта»

Структура сайта в Вебмастере.

В этом подразделе нужно смотреть, видит ли Яндекс сайт так, как видите его вы. Иногда он не учитывает некоторых разделов, иногда здесь появляется то, что вы не хотели бы видеть в поиске. Корректируйте структуру своего ресурса с помощью файла robots.txt.

Корректируйте структуру своего ресурса с помощью файла robots.txt.

3. «Проверка URL»

Здесь можно проверить, доступны ли для Яндекса все полезные страницы на вашем сайте и правильно ли он поступает с рубриками, которые вы хотите скрыть от поиска.

Проверяем URL с помощью Вебмастера Яндекса.

Важно, что история проверок URL сохраняется. То есть, можно узнать, правильно ли вы исправили ошибки на сайте: открыли нужные страницы и закрыли ненужные.

Разобраться с этим подразделом невероятно легко. Нужно вбить интересующий вас адрес в поле под надписью «Проверка URL» и нажать «Проверить».

Яндекс утверждает, что на проверку обычно надо не более 1-2 минут. У меня этот процесс занимает около часа (проверял на разных сайтах и разных хостингах).

Когда проверка завершена, рядом с URL появляется ссылка «готово». Нажмите на нее, чтобы увидеть результаты проверки.

Полезная страница, которую вы хотите отправить в поиск и показать посетителям ресурса, должна выглядеть вот так:

Как определить, что страница проиндексирована роботом Яндекса и участвует в поиске.

Имейте в виду, что даже если вы закрыли какой-то раздел или страницу в robots.txt, она все равно будет обходиться роботом, и результаты проверки будут выглядеть вот так:

Как определить, что страница обходится роботом Яндекса, но не участвует в поиске.

4. «Внутренние ссылки»

Неработающие ссылки в Яндекс.Вебмастере.

В этом подразделе вы можете посмотреть все закрытые от индексирования или нерабочие внутренние ссылки.

Стоит отметить, что здесь можно увидеть ссылки, например, на теги (метки), которые часто нужно закрывать от индексирования (чтобы не было дублей). Не все «нерабочие» ссылки в этом подразделе нужно исправлять.

5. «Внешние ссылки»

Ссылки на ваш сайт и их показатели в новом Яндекс.Вебмастере.

Удобный довольно обширный подраздел, где можно посмотреть подробную информацию о ссылках на сайт (о тех самых ссылках, которые как бы уже давно не учитываются Яндексом при ранжировании).

Тут можно увидеть количество всех ссылок (на сайте, в Вебмастере которого сделан скриншот, их 406), а также количество всех доноров ссылок (125 на рассматриваемом сайте).

На цветной диаграмме показано распределение тИЦ среди сайтов-доноров.

Также тут можно посмотреть на удаленные, неработающие ссылки и на то, в каких доменных зонах расположены сайты-доноры ссылок (Распределение TLD).

Чуть ниже информация о каждой ссылке. Можно узнать адрес страницы, на которой поставлена ссылка, тИЦ донора, на какую именно страницу вашего сайта ведет ссылка и дату появления линка.

Обратите внимание на серую надпись, которая находится под адресом страницы донора. Иногда это анкор ссылки. Иногда просто текст, расположенный рядом с ссылкой.

Подробное описание ссылок в кабинете Вебмастера.

Раздел «Настройка индексирования»

В разделе целых 7 подразделов.

1. «Файлы Sitemap»

Добавление Sitemap.

Здесь надо добавить карту сайта в Вебмастер. Для этого просто нужно ввести URL Sitemap и нажать «Добавить».

Если вы все сделали правильно и карта вашего сайта корректно сгенерирована, вы увидите что-то вроде этого:

Когда на сайте корректная карта сайта.

Когда с Sitemap какие-то проблемы, новый Яндекс.Вебмастер сообщает вам об этом вот так:

2. «Переезд сайта»

В Яндекс.Вебмастере теперь можно «переезжать» на новый домен.

Что это значит? Это значит, что если, например, у вас есть сайт mysite.ru, а вы хотите, чтобы он превратился в mysite.com, нужно зайти в раздел «Настройка индексирования», подраздел «Переезд сайта» и выполнить «переезд».

Одно из самых полезных нововведений в новом Вебмасте

Имейте в виду, что переезжать можно только на домен, который тоже зарегистрирован в вашем Яндекс.Вебмастере.

Сайт становится доступным по новому адресу примерно через 2 недели после действий в Вебмастере.

3. «Региональность»

Подраздел «Региональность» в новом Яндекс.Вебмастере.

Здесь можно посмотреть на тот регион, который присвоил вашему сайту Яндекс и попытаться повлиять на решение поисковика. Корректно заполненный раздел сайта «Контакты» с микроразметкой, правильно выбранный домен и карта увеличат ваши шансы получить желаемый регион. Хотя не всегда все так просто.

Иногда от Яндекса не дождаться ничего щедрее этого:

Когда Яндекс не идет навстречу оптимизатору.

4. «Регистр имени сайта»

Подраздел «Регистр имени сайта» в Яндекс.Вебмастере.

Если у вас есть сайт mysite.com, в этом подразделе можно сделать так, чтобы он отображался в поиске Яндекса, как MySite.com. Учтите, что если у вас сайт my-site.com (то есть в названии есть дефис), изменить его регистр в поиске не получится. Вариант MYsite.com также не пройдет. Яндекс разрешает делать заглавными начальные буквы разных слов, входящих в название домена. Но не буквы, которые вам просто захотелось выделить.

Но не буквы, которые вам просто захотелось выделить.

5. «Быстрые ссылки»

Управление быстрыми ссылками.

В подразделе можно управлять быстрыми ссылками, которые определил для вашего сайта Яндекс. Если ваш сайт грамотно разработан, и поисковик решил, что есть быстрые ссылки, которые можно показывать в выдаче, вы можете выбрать, какие именно ссылки подойдут для выдачи в поиске, а какие лучше скрыть.

Скрыть определенную Яндексом ссылку из выдачи можно, нажав на значок глаза рядом с названием (именем) ссылки.

Пометка «chg» рядом с ссылкой означает, что доступны новые варианты названия.

Пометка «new» означает, что ссылка появилась недавно.

6. «Оригинальные тексты»

Сервис «Оригинальные тексты» в новом Яндекс.Вебмастере.

Здесь как бы можно защищать свои тексты от копирования. Хотя сам же Яндекс в Вебмастере предупреждает, что нет гарантии, что ваши старания будут учтены в работе поисковых алгоритмов.

Удобно, что все отправленные через сервис «Оригинальные тексты» статьи остаются в кабинете Вебмастера. Можно посмотреть дату отправки, а также удалить их с помощью крестика справа. Иногда это полезно. Например, когда сайт закрывается, а вы хотите использовать контент на нем второй раз на другом сайте.

Удаление текстов, отправленных Яндексу через сервис «Оригинальные тексты».

Маленький полезный нюанс! Копируйте сюда тексты прямо из Word. HTML-разметку вроде тега добавлять не нужно.

7. «Товары и цены»

Удаление текстов, отправленных Яндексу через сервис «Оригинальные тексты».

Если у вас магазин, здесь можно добавлять информацию о товарах, улучшать его видимость в поиске и привлекать больше покупателей.

В этом разделе 8 подразделов, которые мы сейчас детально рассмотрим.

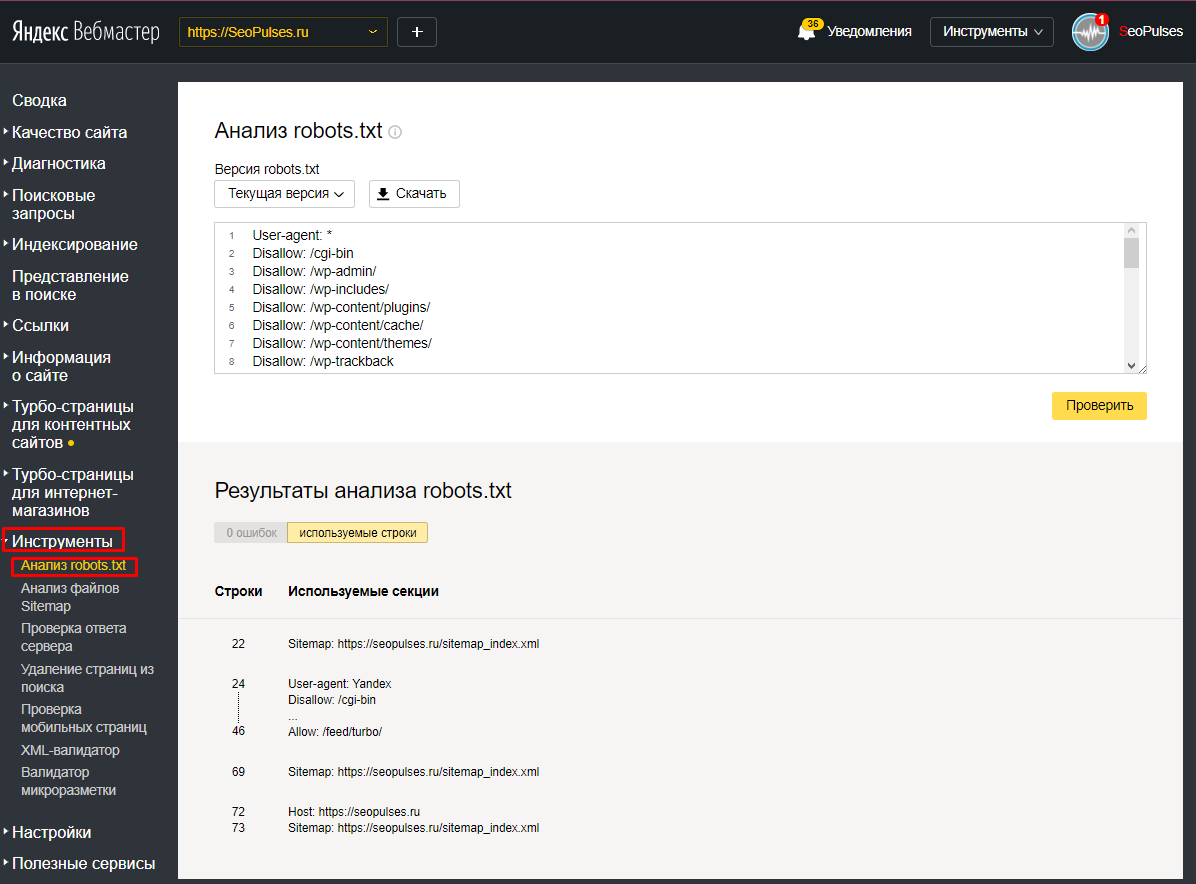

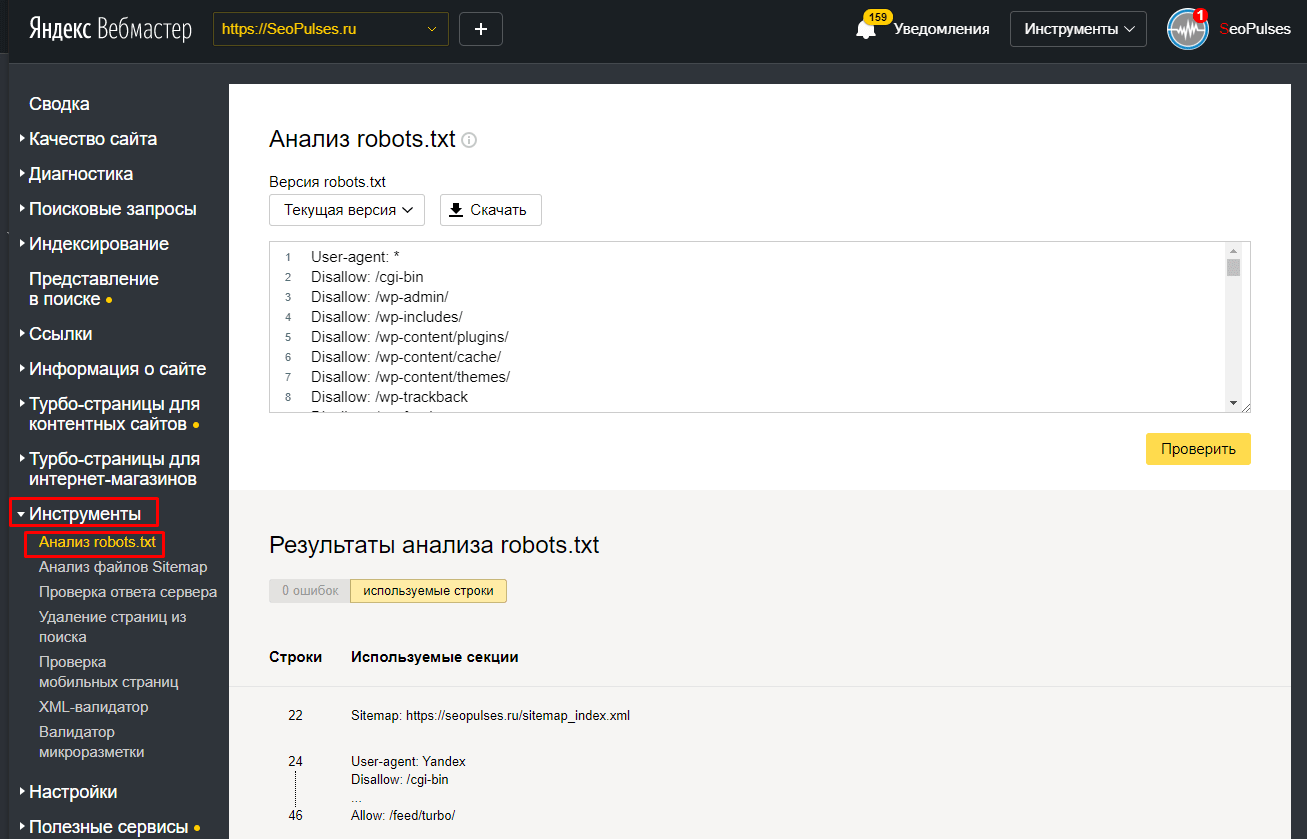

Анализ файла robots.txt с помощью возможностей нового Вебмастера.

В подразделе можно проверить, корректно ли вы заполнили файл robots.txt.

Если после того, как вы нажали желтую кнопку «Проверить», вы видите вот такую картину (количество ошибок 0, и используются все строки, которые вы добавили):

Robots.txt без ошибок

Значит robots.txt заполнен без ошибок.

В самом низу этого раздела есть секция «Разрешены ли URL?». Вместо того чтобы писать вопрос по robots.txt на форуме оптимизаторов и читать язвительные ответы опытных специалистов, используйте ее, чтобы убедиться, закрыли ли вы все то, что нужно закрыть, в этом файле.

Когда интересующий вас URL закрыт от индексации в robots.txt, после проверки он становится красным.

Проверяем, разрешен ли URL в robots.txt.

Если же никакая директива в robots.txt не запрещает индексирования страницы, после проверки рядом с URL появляется галочка зеленого цвета.

Проверяем, разрешен ли URL в robots. txt.

txt.

2. «Анализ файлов Sitemap»

Подраздел «Анализ файлов Sitemap» в новом Вебмастере.

Еще один способ проверить, все ли в порядке с картой вашего сайта. Есть три варианта проверки: «Текст», «URL» или «Файл». Когда Sitemap в порядке, можно увидеть веселую галочку и надпись «Ошибок не найдено».

3. «Проверка ответа сервера»

Проверка ответа сервера в Вебмастере.

Тут можно узнать много данных (включая IP сайта, веб-сервер, который установлен на хостинге, и время ответа сервера) о какой-то одной конкретной странице. Главные сведения – это код статуса HTTP. Если код 200 ОК (как на скриншоте), все в порядке. Значит страница доступна, и поисковики (не только Яндекс) могут добавить ее в индекс.

4. «Удалить URL»

Попытка удалить URL, который все еще есть на сайте и не закрыт от индексации.

Этот подраздел Яндекс. Вебмастера создан для удаления из индекса ненужных страниц. Обратите внимание, что можно удалять только те страницы, которых уже нет на сайте (которые отдают код 404) или индексирование которых запрещено с помощью тега noindeх или файла robots.txt.

Вебмастера создан для удаления из индекса ненужных страниц. Обратите внимание, что можно удалять только те страницы, которых уже нет на сайте (которые отдают код 404) или индексирование которых запрещено с помощью тега noindeх или файла robots.txt.

Когда вы правильно подготовите удаление веб-страницы, Вебмастер отправит ваш запрос Яндексу.

Удаление страницы из индекса после предварительного удаления ее с сайта.

5. «Проверка мобильных страниц»

Нужно стараться, чтобы после проверки Яндекс.Вебмастер выдал вот такой результат:

Проверка мобильных страниц в Яндекс.Вебмастере.

Имейте в виду, что если у вас все хорошо с главной страницей, это не означает, что мобильная верстка настроена на всем сайте:

Ошибка в мобильной верстке с точки зрения Яндекса.

Проверяйте все важные страницы на оптимизацию для мобильных устройств.

6. «Переобход страниц»

«Переобход страниц»

Теперь в Яндекс.Вебмастере можно отправлять страницы на индексацию.

В Google Search Console эта возможность реализована уже давно. Как мы помним, это можно сделать в разделе «Сканирование», подразделе «Посмотреть как Googlebot».

Несколько кликов, и страница (а также все страницы, которые связаны с ней линками, если это необходимо) отправляется в индекс.

В новом Яндекс.Вебмастере отправить страницу на индексацию (переиндексацию) можно в разделе «Инструменты», подразделе «Переобход страниц».

Как видите, в день можно отправить не более 10 страниц. Но, как правило, этого достаточно.

Я засекал, сколько времени нужно роботу Яндекса для обхода страницы, отправленной через Вебмастер. Примерно 20 минут.

Быстро и легко убедиться, действительно ли Яндекс проиндексировал отправленную вами страницу, можно вбив в строчку поиска Яндекса предложение (или его часть) с этой страницы. Только не забудьте взять этот небольшой кусочек текста в кавычки.

Только не забудьте взять этот небольшой кусочек текста в кавычки.

Видно, что свежая статья в индексе, хотя она опубликована всего несколько часов назад.

Отправляйте на индексацию недавно опубликованные страницы и отправляйте на переиндексацию старые страницы, на которых появились важные изменения.

7. «XML-валидатор»

Описание XML-валидатора Яндекс.Вебмастера.

Нужен для проверки XML-файлов для партнерских программ Яндекса.

8. «Микроразметка»

Проверка микроразметки с помощью сервиса Яндекса.

Проверяет, какая микроразметка применяется на странице. Валидатор не такой удобный, как у Google, который показывает каждый тип микроразметки с помощью отдельного аккуратного блока:

Проверка микроразметки с помощью сервиса Google.

Но и он позволяет увидеть, какие данные размечены правильно:

Корректно добавленная микроразметка.

А в каких содержится ошибка:

Микроразметка с ошибкой.

Раздел «Права доступа»

Об этом разделе уже было упоминание в начале статьи.

Здесь стоит добавить о делегировании прав.

Если вы хотите, чтобы еще один человек получил доступ в Яндекс.Вебмастер вашего сайта и при этом не обладал такими же правами, как и вы (то есть не подтверждал права на владение сайтом с помощью мета-тега или HTML-файла), впишите логин его электронной почты в поле «Делегирование прав» и нажмите на кнопку «Делегирование прав».

Делегирование прав на ваш сайт некоему Бэтмену.

Имейте в виду, что сюда нужно добавлять только логин, а не всю электронную почту. То есть в поле надо писать Batman, а не [email protected].

Когда вы делегируете права, вы же можете их и сбросить с помощью кнопки «Сбросить права».

Как сбросить права на сайт в Яндекс.Вебмастере.

Если другой пользователь получил доступ с помощью подтверждения прав, удалить его таким способом с Яндекс.Вебмастера не получится.

Бонус: обзор уведомлений в новом Яндекс.Вебмастере

Сейчас Вебмастер Яндекса может сообщать вам о важных изменениях, связанных с сайтом, на электронную почту.

Зайдите в пункт меню «Уведомления», который находится в правом верхнем углу интерфейса Вебмастера.

Как сбросить права на сайт в Яндекс.Вебмастере.

Потом нажмите на «Настройки».

Как нужно настраивать уведомления об изменениях на сайте.

Перед вами появится страница, на которой можно выбрать, какие уведомления будут приходить на почту.

Самые важные уведомления – это сообщения о появлении новых проблем и об обновлении поисковой базы.

Нельзя игнорировать возможности такого мощного и бесплатного инструмента, как Яндекс.Вебмастер. Не нужно вспоминать старый привычный интерфейс, надо как можно раньше изучить все фишки нового Вебмастера и таким образом существенно упростить работу по продвижению своего сайта (сайтов).

Если вы хотите научиться оптимизировать сайты и стать суперменом-сеошником, то можем предложить курс «SEO-оптимизация: продвижение сайтов в поисковых системах». После курсов проведете аудит сайта и создадите стратегию продвижения. Научитесь анализировать конкурентов, сформируете семантическое ядро. Прогнозируя результаты продвижения, сможете оптимизировать бюджет. Привлекательно? Записывайтесь!

ЗАПИСАТЬСЯ

Если Вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter

Как без навыков SEO оптимизировать новый сайт до запуска, чтобы получить как можно больше органического трафика

С воодушевлением сделали дизайн, написали тексты, заверстали сайт и… вдруг вспомнили, что забыли о SEO. Что же делать!?

Спокойно, всё поправимо! Рассказываем, как быстро оптимизировать сайт без навыков в SEO.

Зайдите в домен, на котором вы планируете выкладывать сайт, и откройте файл robots.txt.

Проверьте, что в robots.txt нет запрещающей директивы “Disallow: /”. Иначе сайт не будет индексироваться.

Обычным поиском в документе robots.txt напишите Disallow: / и убедитесь, что там такой фразы нет:

В метатегах главной страницы нет метатега robots со значениями noindex или nofollow. Нажмите правой кнопкой мыши по главной странице сайта и зайдите в «Просмотреть код» (или CTRL+U, если работаете в Windows).

В поиске введите строку <meta name=»robots» content=»noindex» /> — ее не должно быть, иначе страница будет запрещена к индексации.

Настроены редиректы. Редирект — перенаправление пользователя с одной страницы на другую:

-

с http-версии на https-версию. То же самое для других вариантов написания адреса сайта — с или без WWW;

-

с HTTP — 301-й редирект на HTTPS.

Чтобы проверить, зайдите в панель вебмастера, введите адрес страницы, которую хотите проверить, и найдите строку: «Код статуса HTTP». Должно быть так:

Заголовки, описания, контакты считываются поисковиками. В Яндекс.Вебмастере и Google Search Console посмотрите страницы как их видит робот.

В Яндекс.Вебмастере нажмите «Содержимое страницы», в Google Search Console — «Изучить просканированную страницу».

В Google Search Console нажмите «Изучить просканированную страницу»

Вы увидите код, как видит его поисковик. Проверьте, есть ли в нем все заголовки и текст, которые должны быть на ваших страницах. Бывает, что текста в коде нет, и тогда поисковики его не индексируют.

На домене должен лежать сайт. Но пока его нет, разместите заглушку. Хорошая заглушка рассказывает посетителю, куда он попал и когда откроется сайт.

По удачной заглушке понятно, что это за компания и чем занимается. На ней кратко описаны товары и услуги, есть форма сбора емейлов, чтобы потом напомнить потенциальным покупателям, что сайт открылся. Вот неплохой пример:

Благодаря тексту на заглушке сайт будет оставаться в выдаче поисковиков и начнет копить возрастные метрики. То есть когда опубликуете сайт, у него уже будет определенный вес у поисковиков.

Старайтесь избегать абстрактных фраз, вроде «Сайт находится в разработке» или «Зайдите позже»:

Яндекс.Вебмастер показывает, что поисковик знает о сайте.

Сайт добавлен в Яндекс.Вебмастер. Тут всё просто: заходите в Вебмастер, и там есть ваш сайт.

Https-версия сайта — главное зеркало, и никакие другие домены не приклеены к сайту. Зеркало сайта — это его точная копия, но с другим адресом. Например, http://kosmetika-premium. ru и https://kosmetika-premium.ru с одинаковым контентом будут зеркалами. Сайт с https в адресе должен стать главным зеркалом.

ru и https://kosmetika-premium.ru с одинаковым контентом будут зеркалами. Сайт с https в адресе должен стать главным зеркалом.

К примеру, у нас есть сайт http://kosmetika-premium.ru:

-

Перейдите в Вебмастер в раздел «Зеркала» и введите адрес сайта. Вебмастер покажет, какой адрес — главное зеркало.

-

Если это не сайт с https, нажмите «Добавить главное зеркало».

Сайты не считаются зеркалами, если они не возвращают одинаковый контент, — тогда заявка не будет обработана.

В разделе «Диагностика сайта» нет фатальных и критичных ошибок. Вам главное увидеть надпись «На данный момент проблемы на сайте отсутствуют»:

В разделе «Страницы в поиске» выводятся проиндексированными страницы и заглушки. Другие страницы не индексируются, в «исключенных страницах» пусто.

Вот здесь несколько изображений попали в исключенные страницы, они не индексируются. Нужно передать информацию разработчику и проверить, что происходит с сайтом:

Во «Внешних ссылках» нет резких скачков. На графике видно, что в январе 2019 года возник провал: большая часть сайтов перестала ссылаться на наш сайт:

Если видите такую картину, нужно выяснить причину. Например, сайты с ссылками на ваш сайт могли закрыться:

Теперь идем в консоль Гугла.

Сайт добавлен в Search Console. Заходите в консоль и проверяете, что там есть ваш сайт:

В разделе «Сообщения» нет информации об ошибках. Если есть письма об ошибках, передайте их разработчику:

В разделе «Поисковый индекс» — только страницы, которые относятся к заглушке.

В разделе «Меры, принятые вручную» нет предупреждений. Например, о том, что вы рассылаете агрессивный спам. Вот здесь все хорошо:

Например, о том, что вы рассылаете агрессивный спам. Вот здесь все хорошо:

Зайдите в Lumen — базу правообладателей, там копятся иски и жалобы. Если какой-то бренд находит в сети незаконное размещение своих материалов, он пишет жалобу

Проверьте, нет ли на домене страниц ваше сайта, которые удалены по DMCA. Введите адрес своего сайта в поисковую строку:

В результатах поиска — нет нашего сайта. Это значит, не будет вопросов по правам на контент:

В Вебархиве проверьте историю по домену, на котором планируете размещать сайт. Выберите в календаре прошлые даты и посмотрите, какой контент был на страницах. Главное, чтобы в прошлом по этому адресу не было казино, взрослого или другого запрещенного контента.

Если кликнуть на выделенные даты в календаре, увидите, как тогда выглядела страница сайта и что на ней было размещено

В robots. txt должны быть прописаны такие настройки:

txt должны быть прописаны такие настройки:

Просто скопируйте их и вставьте в свой файл:

User-agent: *

Disalow: /

Впишите в поисковой строке такую фразу: «site: адрес сайта»

В Яндексе:

В Google:

|

Эмулятор поисковиков — это программа, которая имитирует поискового робота. Мы используем Screamingfrog. Что проверить: |

|

-

находит все нужные страницы. Вы видите в списке все страницы, которые должны видеть поисковые системы.

-

нет бесконечных циклов сбора;

-

все страницы отдают код 200 и нет 4хх (битых ссылок) или 3хх (редиректов).

Сайт не падает от парсинга в несколько потоков. Пропарсите сайт с помощью screamingfrog с двумя параметрами: количество потоков и количество URL в секунду. До десяти потоков и до двух URL сайт должен работать:

Пропарсите сайт с помощью screamingfrog с двумя параметрами: количество потоков и количество URL в секунду. До десяти потоков и до двух URL сайт должен работать:

Нет дублей страниц. Смотрим, чтобы не было страниц с одинаковыми адресами и содержанием:

Title и metadescription соответствует содержимому страниц. В Title должно быть то, что на самой странице:

Теперь сайт можно выкладывать, но после запуска нужна дополнительная проверка.

Скорость рендеринга основных типовых страниц в Google PageSpeed. Нужно проверить десктопную и мобильную версии. График должен быть в зеленой зоне или хотя бы в зоне 70-89%:

Такую картину нужно показать разработчику, чтобы он исправил ошибки и вывел мобильную версию в зеленую зону.

Сейчас на сайте могут быть неоптимизированные изображения или другие ошибки:

Время ответа сервера в Яндекс. Вебмастере. Оптимально — не более 500 мс.

Вебмастере. Оптимально — не более 500 мс.

Адаптивность типовых страниц в Google Mobile Friendly и Яндекс.Вебмастере. В идеале в Яндексе вы должны увидеть такую картину:

Если вы получите сообщение, что страница не адаптирована для мобильных устройств или частично загружена, бейте тревогу и обращайтесь к разработчику.

Такая картина — повод обратиться к разработчику:

Коды ответа при обращении к несуществующим страницам в Яндекс.Вебмастере. Добавьте к адресам страниц / или что-то допишите. К примеру:

Оригинальный URL:

Модифицированный URL:

По страницам с неправильными адресами должны получать статус 301 Moved Permanently или 404 Not Found.

С тестового сайта не перенеслись настройки закрытия от поисковиков. Нет метатега robots=noindex и директивы disallow в robots. txt:

txt:

Индексация в Вебмастере. Зайдите в Вебмастер и проверьте, чтобы в выдаче были только страницы сайта и не было мусорных страниц. Мусор — это страницы сортировок, фильтраций, utm-меток.

Правильные логи вебсервера. Их запрашивают у разработчика. Логи показывают, какие страницы посещают поисковые роботы — страницы сайта или мусорные. В записях посещения сайты должны быть строки с именами Яндекса и Гугла, это и есть роботы.

Переходы в Метрике и Analytics должны расти:

На этом пока всё!

Как бороться с недостаточно качественными страницами | MIVOKS group

Любой SEO-специалист, продвигающий сайт в Яндексе в 2020 году, может в один прекрасный день обнаружить, что из поиска исключена пара десятков (или сотен) страниц с пометкой «недостаточно качественные». Расскажем о том, как с этим бороться!

- Что значит недостаточно качественная страница

- Как посмотреть

- Влияние на позиции в выдаче

- Как исправить

- Бонус: «Яндекс-шторм»

Что значит недостаточно качественная страница

Страницы низкого качества не дают подходящего ответа на запрос пользователя (интент запроса, если по-умному) и не содержат ничего полезного для него.

Сюда попадают разные типы документов:Представьте, что вы хотите купить телевизор и открываете любимый поисковик. Зашли на понравившийся ресурс, а там нет ни фотографий, ни цены, ни характеристик… Сомнительно, что вы совершите покупку на этом ресурсе. Вот поисковые системы и пытаются оградить людей от подобных недоразумений и убрать из выдачи сайты, которые не способны решить их проблему.

- Служебные, структурные или тестовые, проиндексированные по ошибке

- Карточки товаров или категории в интернет-магазинах

- Статьи из блога или новости

- Информационные блоки, такие как отзывы, контакты, гарантии и т.п.

Причины попадания в блок тоже разнятся, но эффект один и он не самый приятный!

Как посмотреть

Давайте разберемся где же искать НКС. Заходим в Яндекс.Вебмастер и выбираем нужный сайт.

Находим пункт меню Индексирование → Страницы в поиске

Здесь вы сможете отследить все изменения индексации: добавление, изменение, удаление. Нам потребуется вкладка Исключенные

Нажимаем на фильтр Статус → Недостаточно качественная → Применить

И вот мы находим полный список НКС.

Ссылки кликабельны и с ними можно начинать работать. Если хотите выгрузить весь список, то Вебмастер позволяет это сделать. Промотайте вниз страницы и найдете кнопки для скачивания в формате XLS и CSV

Влияние на позиции в выдаче

Яндекс уверяет, что переживать по этому поводу не стоит. Нужно «улучшать сайт, ориентируясь на посетителей – тогда страницы станут более удобными и востребованными, и алгоритм сможет включить их в поиск. »

»

Однако, на практике алгоритм работает иначе: поисковик «выставляет» среднюю оценку всему домену. Поэтому, если будет много некачественных страниц с низким рейтингом, то и «доверие» к сайту будет ниже. Как следствие – снижение позиций даже по трафиковым запросам.

Иными словами, НКС негативно влияют на сайт целиком, включая наиболее мощные его документы.

Как исправить

Прежде, чем исправить поломку, ее нужно найти. Рассмотрите внимательно файлы, которые помечены «BAD_QUALITY» и определите что в них общего. Помимо этого задайте себе вопрос: «а нужно ли конкретно это в поисковике?»

Общие рекомендации

На странице обязательно должны быть:

- Прописанные уникальные метатеги title, description

- Структура заголовков. Ровно один h2, а остальные – при необходимости разбить информацию на логические разделы.

- Информация, которая является основной для нее.

Служебные страницы

Часто сюда попадают пагинация, результаты поиска или добавления в корзину. По-хорошему, они и не нужны в индексе и закрываются в robots.txt или им прописываются canonical.

Сюда же относятся «сырые» документы, которые создали, например, желая написать статью, а потом отложили в долгий ящик. Забыв, при этом, запретить роботам ее индексировать.

Переживать о подобных пропажах точно не стоит, это больше сигнал еще раз провести технический аудит – скорее всего, получится «поймать» еще много таких маленьких ошибок и исправить их.

Карточки товаров в интернет-магазине

К магазину применяются четкие требования, которые однозначно должны быть выполнены, если его владелец хочет не только занимать хорошие позиции в поисковой выдаче, но и успешно торговать в сети. К ним относят:

К ним относят:

- Цену с указанием валюты

- Фото в хорошем качестве

- Описание, чем больше полезной информации «без воды», тем лучше

- Технические характеристики (в зависимости от тематики они разные)

- Данные о наличии или сроках поставки

- Условия оплаты, доставки, возврата и т.п.

- Отзывы покупателей

- Возможность покупки

Проверьте, что эти требования выполнены по максимуму, на сколько это возможно в вашей тематике.

Категории в интернет-магазине