Онлайн Dr.Web. Проверка на вирусы файлов и ссылок.

Онлайн (online) антивирус

Dr.Web.Проверка на вирусы в режиме онлайн (online) файлов и страниц веб-сайтов, осуществляется бесплатным онлайн-сервисом антивируса Dr.Web.

Вы можете вводить любые интересующие URL-адреса страниц сайтов для проверки на наличие вредоносных программ.

Сканирование страницы веб-сайта антивирусом, производится в режиме онлайн с использованием новейших вирусных баз.

Итоговую информацию о наличии или отсутствии вредоносного кода на искомой веб-странице, вы получите сразу после окончания проверки антивирусной программой, без регистраций и СМС.

Вирусные базы антивируса Dr.Web, используемые для онлайн сканирования сайта и проверки файла на вирусы, обновляются каждый час.

Вы можете пользоваться сервисом Dr. Web на нашем сайте для онлайн проверки на вирусы

Web на нашем сайте для онлайн проверки на вирусы

Возможно Вам будет интересно узнать о бесплатных антивирусных плагинах для браузеров:

Firefox, Pale Moon, Internet Explorer, Opera, Safari, Chrome, а также для почтового клиента: Thunderbird, см. статью — Плагин LinkChecker, антивируса Dr.Web

Онлайн проверка файлов антивирусом

Dr.Web .В нижерасположенной форме, нажмите кнопку «Обзор» и выберете интересующий файл на своем компьютере, далее кнопка «Проверить» и ждите результатов проверки.

Если необходимо проверить несколько файлов, то упакуйте эти файлы в формат — zip любым архиватором, например 7-Zip.

Скачать можно из раздела — Архиваторы

Онлайн проверка ссылок антивирусом

Dr.Web.Проверяется страница любого веб-сайта на наличие вредоносных (вирусных) скриптов.

Введите в поле формы адрес веб-страницы (URL), подозрительного веб-сайта и нажмите «Проверить».

Откроется окно сервиса Dr.Web и после проверки, появится отчет антивируса.

Ознакомившись с отчетом Dr.Web, прокрутив окно антивирусного сервиса до конца страницы, нажмите кнопку «Закрыть окно».

Если напротив записей об обнаруженных на сайте скриптов стоит отметка «Ок», то все исполняемые скрипты на исследуемой веб-странице не содержат вредоносного кода с точки зрения антивирусного сканера Dr.Web.

Текущие новости о вирусах, от разработчиков антивируса

Dr.WebГрафика текущей активности вирусов и вредоносных программ.

Обновление графика производится в режиме реального времени от Dr.Web.

Троянец заблокировал Windows и требует отправить SMS?

Используйте «Сервис разблокировки компьютеров» Dr. Web, где Вы можете бесплатно разблокировать Windows от Trojan. Winlock

Web, где Вы можете бесплатно разблокировать Windows от Trojan. Winlock

Для тех, у кого вирус заблокировал Windows и требует заплатить денег, воспользуйтесь бесплатным сервисом Dr.Web.

***«Доктор Веб» — российский производитель антивирусных средств защиты информации под маркой Dr.Web. Продукты Dr.Web разрабатываются с 1992 года

Проверка ссылки на вирусы. Проверяем ссылки онлайн сканерами

Добрый день, уважаемые посетители. Мир интернета небезопасен. Страшное начало? Все вы, наверное, слышали о нашумевших вирусах поразивших тысячи компьютеров в Европе, России и Украине таких как, WannaCry и Petya.A. От них не убереглись даже министерства и большие корпорации. Надо максимально уделить внимание безопасности в сети. Все мы скачиваем какие-то файлы переходя по ссылкам, а они могут быть заражены. Проверка ссылки на вирусы, считаю, должна быть обязательна перед скачиванием какого-либо файла.

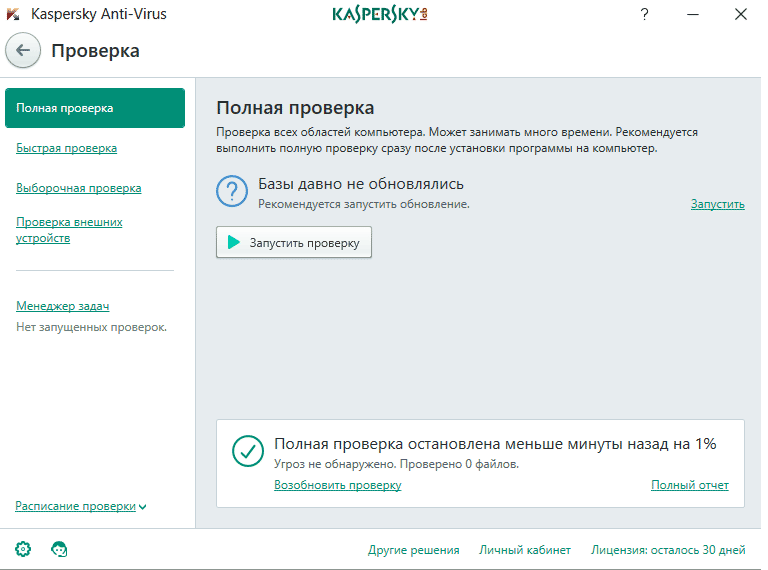

Разумеется, на компе установлена программа антивирус, которая должна блокировать загрузку файлов, содержащих вирусы. Да и поисковики Яндекс и Google предупреждают о зараженных сайтах, а то вовсе не показывают их выдаче. Но ни первый, ни второй вариант не гарантирует 100% защиты от вирусов и троянов, которые могут или блокировать ПК, или получить доступ к аккаунтам сервисов которыми пользуетесь в интернете, что чревато финансовыми потерями.

Да и поисковики Яндекс и Google предупреждают о зараженных сайтах, а то вовсе не показывают их выдаче. Но ни первый, ни второй вариант не гарантирует 100% защиты от вирусов и троянов, которые могут или блокировать ПК, или получить доступ к аккаунтам сервисов которыми пользуетесь в интернете, что чревато финансовыми потерями.

Как же быть? Предлагаю пользоваться онлайн сервисами проверки ссылок на содержание вирусов. Данные сканеры не требуют установки на компьютер, бесплатные, проверка на вирусы проходит довольно быстро по известным им базам вирусов, используя несколько антивирусных программ одновременно. Сигнатуры баз обновляются постоянно. Это сочетание позволяет найти и обезвредить «шпиона».

Вот эти сервисы проверки ссылок на вирусы.

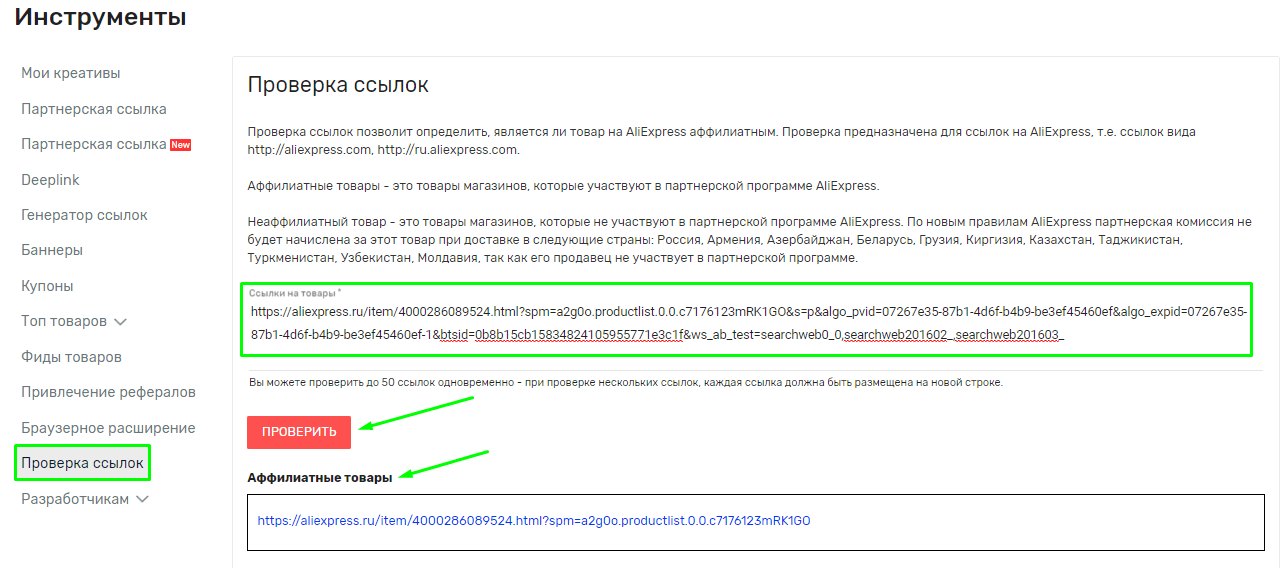

- [link]Virus Total[/link]. Если адрес сайта вызывает подозрения укажите URL. Virustotal осуществляет анализ не только подозрительных ссылок на вирусы, но и файлов различных форматов.

Размер файлов не должен превышать 128 Мб. Есть возможность проверить архив без предварительного разархивирования. После недолгой проверки получите отчет. В случае опасности «чертёнок» покажет количество зараженных файлов. Ещё одним плюсом Вирустотал есть возможность установить приложение [link]VirusTotal Uploader[/link].

Размер файлов не должен превышать 128 Мб. Есть возможность проверить архив без предварительного разархивирования. После недолгой проверки получите отчет. В случае опасности «чертёнок» покажет количество зараженных файлов. Ещё одним плюсом Вирустотал есть возможность установить приложение [link]VirusTotal Uploader[/link]. - [link]Antivirus-alarm[/link]. Очень сильный сервис. Проверка проходит довольно продолжительное время. Может проверить не только указанную ссылку на вирусы, но и весь сайт которому принадлежит урл.

- [link]Metadefender[/link]. Объём проверяемых файлов не более 140 Мб. Изюминка сервиса — сканирование IP-адреса на вирусы. В другом месте подобного не видел.

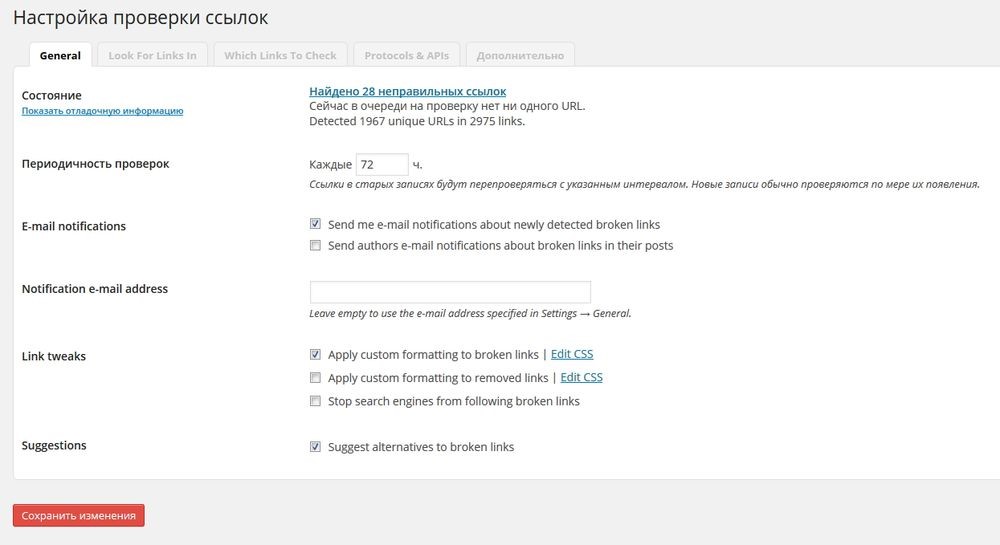

- [link]Dr. Web[/link]. По-видимому лучший вариант. Проверка ссылки на вирусы проходит очень быстро. Максимальный объём проверяемого файла — 10 Мб. Для проверки нескольких, загружаете архив. Доктор Веб имеет своё приложение для компьютеров Dr.Web Link Cheker и для мобильных устройств Dr.Web для Android.

Link Cheker делает:

Link Cheker делает:- проверяет измененные ссылки, конечную ссылку куда перенаправляет пользователя;

- проверяет на скрипты;

- в социальных сетях предупреждает о переходе на внешний ресурс за пределы сети;

- анализирует файлы до скачивания.

Резюмируем. Проверка ссылки на вирусы одним из представленных сканеров уменьшит вероятность попадания вредоносных программ на ваш компьютер. Пора понять, что мошенников, желающих нажиьтся на любителей «халявы» становится всё больше и больше. Скачивать программы и различные документы надо из проверенных источников и с официальных сайтов. Если нет, то проверка ссылок на вирусы онлайн способом просто необходима.

Желаю Всем безопасного сёрфинга!

С уважением, Павел Коновалов

Статья по теме: «Плагин TAC. Удаляем скрытые ссылки из темы WordPress»

Найти битые ссылки – проверить наличие битых ссылок на сайте

Введи url сайта

Обработка. ..

..

Кликнув на ссылку с количеством страниц вы откроете отчет с ссылками которые ведут на несуществующие страницы.

Как найти битые ссылки

Регулярная качественная проверка битых ссылок необходима для эффективного продвижения сайта. С помощью онлайн-сервиса Saitreport вы можете осуществить проверку до пятидесяти страниц бесплатно и получить подробный отчет о наличии битых ссылок.

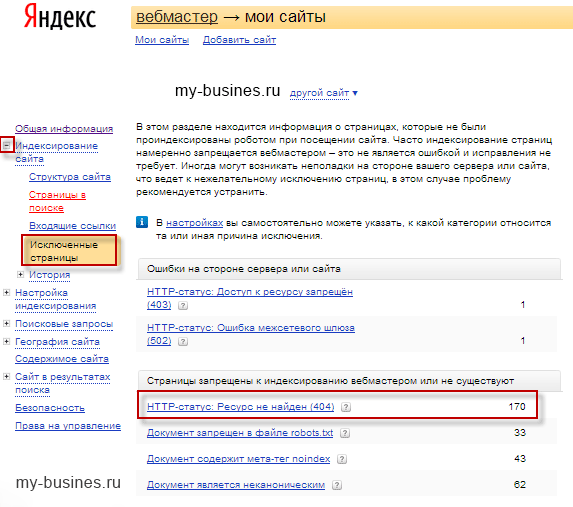

Битые ссылки представляют собой URL, которые ведут пользователя на заблокированные или неактивные страницы. При переходе по такой ссылке отображается ошибка 404. В большинстве случаев, обнаружив битую ссылку на сайте, пользователь прекращает заходить на данный ресурс. Поэтому анализ сайта на наличие битых ссылок — чрезвычайно важная процедура, позволяющая вовремя исправить ошибки и не допустить снижения рейтинга страницы.

Основные причины появления неработающих URL:

- неправильно прописан адрес;

- структура сайта была изменена;

- файл, на который ведет ссылка, был удален или перемещен;

- срок хранения файла, на который ведет ссылка, истек;

- адреса страниц, на которые ведет ссылка, были изменены;

- ресурс был заблокирован.

Как проверить сайт на наличие битых ссылок

Отчет позволит вам определить страницу донор, откуда проставлена ссылка, и анкор по которому она ссылается. Полученная информация упростит вам исправление или удаление битых ссылок.

С помощью сервиса Saitreport вы можете проверить на битые ссылки любой сайт. Такой способ проверки гораздо быстрее и эффективнее, чем самостоятельный поиск неработающих URL. Воспользоваться сервисом абсолютно просто:

- введите URL в строку анализа;

- запустите проверку;

- дождитесь результата.

Благодаря тщательному анализу, включающему в себя более двухсот параметров ресурса, вы получите удобный отчет со списком битых ссылок. Данный отчет можно выгрузить в формат .csv.

Результаты анализа кодов ответа будут представлены вам в виде ссылающихся страниц с указанием доноров и анкоров таких ссылок. Благодаря проверке битых ссылок на сайте Saitreport вы получите подробную информацию о ссылках, соответствующих коду ошибки 404, и рекомендации по их исправлению. Данные ссылки, в зависимости от причины их появления, можно удалить или исправить.

Заказ поиска битых ссылок на сайте Saitreport позволяет воспользоваться удобным онлайн-сервисом и получить подробные данные о состоянии сайта и угрозе снижения лояльности пользователей. Анализ страниц производится максимально быстро, поэтому вы можете выполнить большой объем работ и проверить до пятидесяти страниц, сэкономив свое время.

Операции с документомОнлайн антивирусы, которые можно использовать для проверки компьютеров и файлов на наличие вредоносных кодов и шпионских программ.

|

Автоматизированная проверка ссылок для тестирования системы

Мне часто приходится работать с хрупкими устаревшими веб-сайтами, которые неожиданно ломаются при обновлении логики или конфигурации.

У меня нет ни времени, ни знаний о системе, необходимых для создания сценария Selenium. Кроме того, я не хочу проверять конкретный вариант использования — я хочу проверить каждую ссылку и страницу на сайте.

Я хотел бы создать автоматизированный системный тест, который будет проходить через сайт и проверять наличие неработающих ссылок и сбоев. В идеале, был бы инструмент, который я мог бы использовать для достижения этой цели. Он должен иметь как можно больше следующих функций в порядке убывания приоритета:

В идеале, был бы инструмент, который я мог бы использовать для достижения этой цели. Он должен иметь как можно больше следующих функций в порядке убывания приоритета:

- Срабатывает через скрипт

- Не требует человеческого взаимодействия

- Следует по всем ссылкам, включая якорные теги и ссылки на файлы CSS и js

- Производит журнал всех найденных 404s, 500s и т. д.

- Может быть развернут локально для проверки сайтов в интрасетях

- Поддерживает аутентификацию cookie/form-based

- Бесплатно с открытым исходным кодом

Существует много частичных решений, таких как FitNesse , Firefox LinkChecker и проверка ссылок W3C , но ни одно из них не делает всего, что мне нужно.

Я хотел бы использовать этот тест с проектами, использующими целый ряд технологий и платформ, поэтому чем более портативным будет решение, тем лучше.

Я понимаю, что это не замена правильному системному тестированию, но было бы очень полезно, если бы у меня был удобный и автоматизированный способ проверки того, что ни одна часть сайта не была явно нарушена.

Поделиться Источник ctford 20 октября 2009 в 18:37

9 ответов

- Проверка Ссылок (Spider Crawler)

Я ищу проверку ссылок для паука моего сайта и регистрации недействительных ссылок, проблема в том, что у меня есть страница входа в систему в начале, которая требуется. То, что я хочу, — это проверка ссылок для запуска через регистрационные данные командного пункта, а затем паук rest веб-сайта….

- Как получить базу данных wiki в поисковые системы?

Я создаю сайт, который будет иметь базу данных статей wiki. Прямо сейчас нет никаких ссылок на статьи wiki, кроме использования поисковой системы на сайте. Как я могу получить статьи, которые будут пауком Google и других поисковых систем Интернета? В базе данных слишком много статей, чтобы…

33

Мы используем и очень любим Linkchecker:

http://wummel. github.io/linkchecker/

github.io/linkchecker/

Он имеет открытый исходный код, Python, командную строку, возможность внутреннего развертывания и выводится в различных форматах. Разработчик был очень полезен, когда мы связались с ним по вопросам.

У нас есть скрипт Ruby, который запрашивает нашу базу данных внутренних веб-сайтов, запускает LinkChecker с соответствующими параметрами для каждого сайта и анализирует XML, который дает нам LinkChecker, чтобы создать пользовательский отчет об ошибках для каждого сайта в нашем CMS.

Поделиться Sean McMains 06 ноября 2009 в 22:25

28

Я использую для этого Линк-сыщика Ксену . Быстро проверьте отсутствие мертвых ссылок и т.д. на любом сайте. Просто наведите его на любой URI, и он будет паучить все ссылки на этом сайте.

Удаление с сайта:

Поиск ссылок Xenu (TM) проверяет веб -сайты на наличие неработающих ссылок.

Проверка ссылок выполняется на «normal» ссылках, изображениях, фреймах, плагинах, фонах, локальных картах изображений, таблицах стилей, скриптах и java апплетах. Он отображает постоянно обновляемый список URLs, которые вы можете отсортировать по различным критериям. Отчет может быть подготовлен в любое время.

Он отвечает всем вашим требованиям, кроме того, что он может быть написан по сценарию, поскольку это приложение windows, которое требует запуска вручную.

Поделиться Matt Lacey 31 октября 2009 в 20:27

2

Какой части вашего списка не соответствует проверка ссылок W3C? Это было бы то, что я бы использовал.

В качестве альтернативы, twill (python-based) — интересный маленький язык для такого рода вещей. У него есть модуль проверки ссылок , но я не думаю, что он работает рекурсивно, так что это не очень хорошо для пауков. Но вы можете изменить его, если вам это удобно. И я могу ошибаться, может быть рекурсивный вариант. В любом случае, стоит проверить.

Но вы можете изменить его, если вам это удобно. И я могу ошибаться, может быть рекурсивный вариант. В любом случае, стоит проверить.

Поделиться Zac Thompson 31 октября 2009 в 20:18

- Автоматизированная Система Тестирования

Я пытаюсь создать автоматизированную платформу тестирования для некоторых наших внутренних веб-сервисов (java) на работе. Каждая служба имеет набор APIs (3-5), хотя это может быть относительно легко достичь, проблема возникает с некоторыми APIs, которые не ведут себя как чистые функции, например:…

- Использование OpenX для обслуживания текстовых ссылок, которые могут видеть поисковые системы?

В настоящее время я использую OpenX для обслуживания вращающихся текстовых ссылок. Тем не менее, код вызова javascript, поэтому я не думаю, что поисковые системы могут использовать эти ссылки. Есть ли другое решение или способ изменить OpenX для обслуживания ссылок, которые поисковые системы могут.

..

..

2

Возможно, вы захотите попробовать использовать для этого wget. Он может создавать паук на сайте, включая «page requisites» (т. е. файлы), и может быть настроен для регистрации ошибок. Я не знаю, будет ли у него достаточно информации для вас, но он бесплатный и доступен на Windows (cygwin), а также unix.

Поделиться Mr. Shiny and New 安宇 02 ноября 2009 в 19:01

1

InSite -это коммерческая программа, которая, кажется, делает то, что вы хотите (не использовали ее).

Если бы я был на вашем месте, я бы, наверное, сам написал такого рода паука…

Поделиться orip 31 октября 2009 в 13:58

1

Я не уверен, что он поддерживает аутентификацию формы, но он будет обрабатывать файлы cookie, если вы сможете запустить его на сайте, и в противном случае я думаю, что Checkbot сделает все в вашем списке. Я уже использовал в качестве шага в процессе сборки, чтобы проверить, что на сайте ничего не сломано. На веб-сайте есть пример вывода .

Я уже использовал в качестве шага в процессе сборки, чтобы проверить, что на сайте ничего не сломано. На веб-сайте есть пример вывода .

Поделиться Ian G 02 ноября 2009 в 19:29

1

Мне всегда нравился linklint для проверки ссылок на сайте. Однако я не думаю, что это соответствует всем вашим критериям, особенно тем аспектам, которые могут зависеть от JavaScript. Я также думаю, что он пропустит изображения, вызванные изнутри CSS.

Но для спайдеринга всех якорей это отлично работает.

Поделиться artlung 07 ноября 2009 в 08:55

0

Попробуйте SortSite . Это не бесплатно, но, кажется, делает все, что вам нужно, и даже больше.

В качестве альтернативы, PowerMapper от той же компании имеет подход similar-but-different. Последний даст вам меньше информации о детальной оптимизации ваших страниц, но все равно определит любые неработающие ссылки и т. Д.

Последний даст вам меньше информации о детальной оптимизации ваших страниц, но все равно определит любые неработающие ссылки и т. Д.

Отказ от ответственности: У меня есть финансовый интерес в компании, которая производит эти продукты.

Поделиться Gary McGill 07 ноября 2009 в 10:41

0

Попробуйте http://www.thelinkchecker.com это онлайн-приложение, которое проверяет количество исходящих ссылок , ранг страницы, привязку, количество исходящих ссылок. Я думаю, что это то решение, которое вам нужно.

Поделиться Barry 18 января 2014 в 22:20

Похожие вопросы:

стратегия тестирования для нефункциональных тестовых случаев в непрерывной интеграции

При разработке больших систем нефункциональные требования часто являются наиболее важными, и их реализация занимает большую часть времени разработки. Нефункциональные тесты стоят дорого и часто…

Нефункциональные тесты стоят дорого и часто…

Типы сценариев, реализуемых компаниями для тестирования производительности системы

Как новичок в JMeter, я создал несколько сценариев, таких как некоторое количество пользователей входят в систему, отправляют некоторые запросы HTTP, запросы зацикливаются и т. д. Я хотел бы знать,…

Автоматизированная система тестирования производительности

Существует ли фреймворк для написания автоматизированных тестов производительности на JVM ? Я хотел бы установить некоторые целевые показатели производительности и flash красный свет (или, скорее,…

Проверка Ссылок (Spider Crawler)

Я ищу проверку ссылок для паука моего сайта и регистрации недействительных ссылок, проблема в том, что у меня есть страница входа в систему в начале, которая требуется. То, что я хочу, — это…

Как получить базу данных wiki в поисковые системы?

Я создаю сайт, который будет иметь базу данных статей wiki. Прямо сейчас нет никаких ссылок на статьи wiki, кроме использования поисковой системы на сайте. Как я могу получить статьи, которые будут…

Прямо сейчас нет никаких ссылок на статьи wiki, кроме использования поисковой системы на сайте. Как я могу получить статьи, которые будут…

Автоматизированная Система Тестирования

Я пытаюсь создать автоматизированную платформу тестирования для некоторых наших внутренних веб-сервисов (java) на работе. Каждая служба имеет набор APIs (3-5), хотя это может быть относительно легко…

Использование OpenX для обслуживания текстовых ссылок, которые могут видеть поисковые системы?

В настоящее время я использую OpenX для обслуживания вращающихся текстовых ссылок. Тем не менее, код вызова javascript, поэтому я не думаю, что поисковые системы могут использовать эти ссылки. Есть…

Автоматизированная система тестирования GUI для Android

Существует ли автоматизированная система тестирования GUI для Android?

Есть ли проверка ссылок для gulp?

Есть ли проверка ссылок 404 для gulp? Я ищу что-то вроде grunt’s grunt-link-checker для тех, кто незнаком, он предоставляет список внутренних и внешних ссылок, которые 404.

CloudFormation AWS::CertificateManager::Certificate автоматизированная проверка сертификатов

Согласно документам AWS здесь и здесь , я должен быть в состоянии автоматизировать создание и проверку сертификатов с помощью cloudformation. По-видимому , когда вы указываете HostedZoneId в…

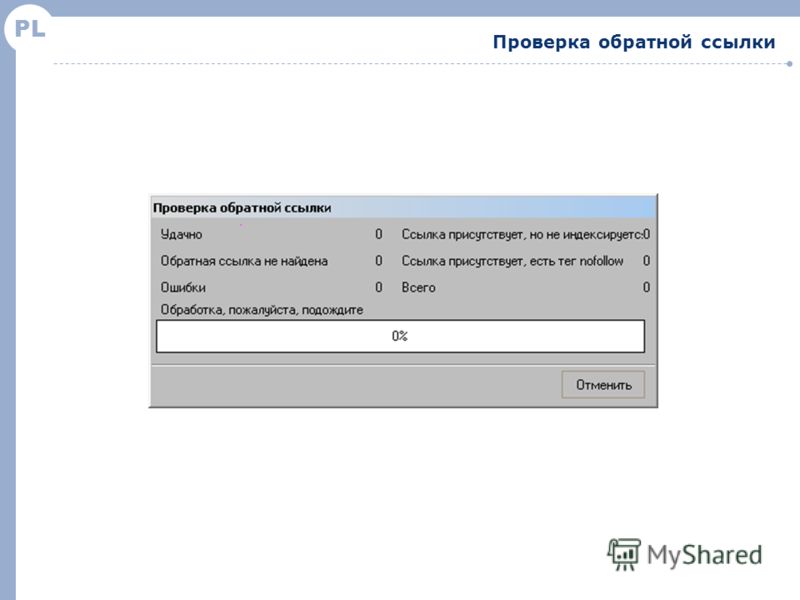

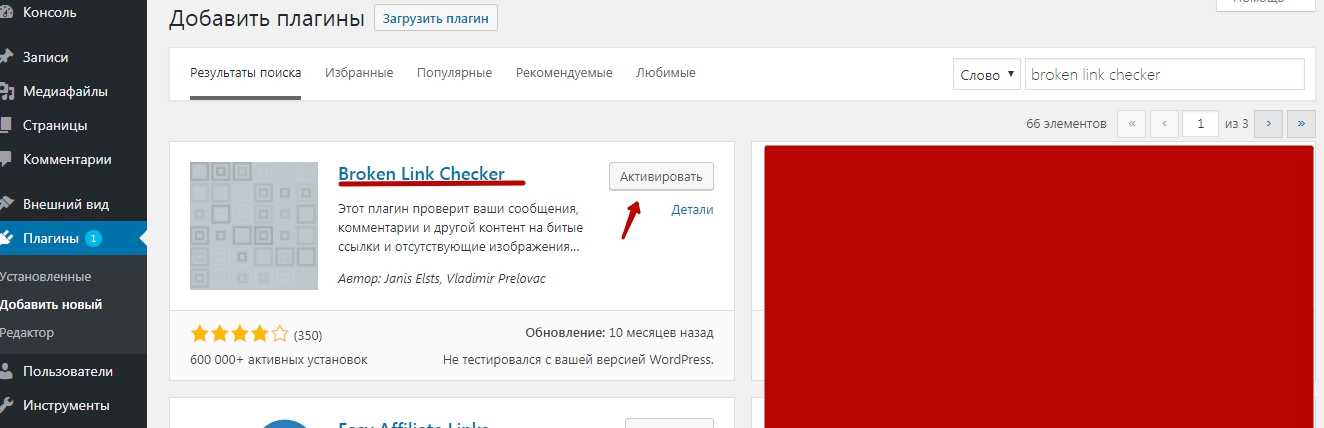

Программы для проверки ссылок сайта на работоспособность

Когда поисковый робот заходит на ваш сайт он начинает проверять все ссылки на доступность и когда натыкается на ссылку с ответом “Ошибка 404”, считает такую ссылку ошибочной (битой). На любом сайте возникают такие ссылки-ошибки и со временем их становится все больше и больше. Возникают такие ошибки в силу разных причин: ошибки в редакции контента, смена шаблона, взлом сайта, выпадение ссылок авторов комментариев и тд.

Поисковые системы очень негативно относятся к сайтам на которых находится большое количество ошибочных ссылок и ранжируют их ниже других. Поэтому необходимо систематически проверять свой ресурс на наличие битых ссылок и ненужных чужих урлов. Проверить целостность ссылок можно с помощью программ специально созданных для этого. Одним из таких бесплатных инструментов, является утилита Site Link Checker.

Проверить целостность ссылок можно с помощью программ специально созданных для этого. Одним из таких бесплатных инструментов, является утилита Site Link Checker.

Программы для проверки ссылок

Бесплатная программа Site Link Checker предназначена для проверки ссылок веб-сайтов на работоспособность. Программа поможет вам быстро найти неработающие ссылки и адреса ссылок содержащие синтаксические ошибки и редиректы. Site Link Cheker покажет абсолютно все ссылки, как внутренние (изображения, дубли, ошибки, ссылки плагинов и тд), так и внешние, связанные с проверяемой страницей.

Адреса ссылок можно посмотреть в браузере, скопировать и сохранить в текстовый файл. Очень быстрая и полезная программа для качественной проверки ссылок сайта. Этот простой в использовании инструмент, всегда поможет вам привести в порядок все ссылки на вашем сайте. Проверка ссылок необходимая мера для оценки качества сайта. Из недостатков — только постраничная проверка сайта.

Программа LinkChecker 8.2

Более продвинутая программа LinkChecker 8.2 предназначена для проверки ссылок в веб-документах и веб-сайтов. Программа быстро проверит и найдет все существующие ссылки всего сайта и предоставит полный отчет о каждой найденной ссылке — адрес, анкор, размер, время создания, вид ошибки, редирект и тд.

Основные возможности программы LinkChecker 8.2

- Многопоточность

- Поддержка HTTP/1.1, HTTPS, FTP

- Поддержка фильтров

- Поддержка протокола robots.txt

- Проверка HTML и CSS синтаксиса

- Поддержка HTML5

- Работа с прокси

- Сохранение результатов в HTML файл

Программа работает очень быстро, в настройках можно задать нужные параметры проверки. Найдет и покажет всю информацию по каждой найденной ссылке. Покажет ссылки в установленных плагинах и теме шаблона, запрет на индексацию ссылок в robots.txt, наличие аудио, видео.

Также работает с локальными файлами, словом покажет всю информацию о контенте, сколько всего ссылок, какого они вида и количество ошибок. Результат проверки можно сохранить в html и потом посмотреть в виде удобных для просмотра цветных таблиц по каждой отдельной ссылке.

Результат проверки можно сохранить в html и потом посмотреть в виде удобных для просмотра цветных таблиц по каждой отдельной ссылке.

При всем этом программа абсолютно бесплатна, будет полезна как новичкам, так и более продвинутым пользователям. Выкладываю портабельные версии одним архивом, обычный инсталлятор можно скачать на сайтах этих программ. Скачать программы для проверки ссылок.

Лучшие бесплатные программы для проверки ссылок на веб-сайте

- – Автор: Игорь (Администратор)

Проверка ссылок на веб-сайтах — отличная профилактика

В сущности, практически все веб-сайты содержат мертвые или битые ссылки, точно так же, как и практически любое программное обеспечение содержит ошибки. Ошибки происходят всегда и это естественное явление. Изменился контент, поменялись имена файлов и пути до них, изменилась структура на внешних сайтах и прочее. И до тех пор пока вы не будете проверять на регулярной основе веб-сайт на наличие битых ссылок, вы будете продолжать совершать классическую ошибку и давать возможность битым ссылкам расстраивать пользователей сайта.

Изменился контент, поменялись имена файлов и пути до них, изменилась структура на внешних сайтах и прочее. И до тех пор пока вы не будете проверять на регулярной основе веб-сайт на наличие битых ссылок, вы будете продолжать совершать классическую ошибку и давать возможность битым ссылкам расстраивать пользователей сайта.

Программы для проверки ссылок на веб-сайтах действуют аналогично паукам поисковой системы. Они «ползают» по вашему сайту и ищут внутренние и внешние битые ссылки. Весь процесс сканирования является рекурсивным. Это означает, что паук строит дерево ссылок, ведущих от страницы к страницы, и продолжает исследовать ссылки до тех пор, пока не пройдется по всему дереву или же не будет достигнут заданный предел (вложенность, уровни и прочее). Хорошие программы анализаторы ссылок так же предоставляют полноценный отчет о всех мертвых ссылках, с указанием подробной информации о местонахождении каждой ссылки и вида ошибки (например, 404 ошибка, превышен интервал ожидания и прочие).

Примечание: Вы можете ограничивать поисковые роботы с помощью настроек в файлах robots.txt и .htaccess. Однако, эти ограничения учитывают не все программы для проверки ссылок. Например, Xenu’s Link Sleuth не воспринимает эти настройки и поэтому все ограничения необходимо задавать перед каждой проверкой.

Обзор бесплатных программ для проверки ссылок на веб-сайтах

Программа для проверки ссылок на веб-сайтах LinkChecker

LinkChecker имеет все необходимые функции, которые вы только можете захотеть от программы для проверок ссылок на сайте. Самое главное, что приложение выделяет url адрес исходной страницы, где была обнаружена ошибка, так что вы всегда сможете быстро и просто исправить битые ссылки. Сводный отчет о результатах достаточно легко использовать. Каждая проверенная ссылка будет сопровождаться дополнительной информацией, включая заголовок страницы, тип и код ошибки, ответ сервера и прочее. Кроме того, LinkChecher поддерживает настройку глубины рекурсии (максимальное количество переходов от первой ссылки к последней).

LinkChecker так же можно запускать из командной строки. Существует большой набор консольных параметров, который позволит вам легко использовать программу из пакетных файлов (например, добавить к пакетному файлу, который выполняет ряд проверок по расписанию). Возможности и гибкость настройки LinkChecker действительно приятно удивляют.

Основные характеристики:

- Рекурсивная и многопоточная проверка сайта

- На выходе программы можно получить отчет в виде обычного текстового файла, html, csv и xml, а так же карту сайта в различных форматах

- Поддерживаются ссылки HTTP/1.1, HTTPS, FTP, mailto:, nntp:, Telnet и ссылки на локальные файлы

- Поддержка ограничения проверки ссылок на основе фильтров url с регулярными выражениями

- Поддерживает прокси

- Авторизация для HTTP, FTP и Telnet

- Может учитывать исключения из файла robots.txt

- Поддерживает куки

Программа проверки ссылок Xenu’s Link Sleuth отличный пример того, когда время не властно

Xenu’s Link Sleuth. Это достаточно старый представитель данного класса программ. Однако, несмотря на то, что последний релиз программы состоялся в 2010, Xenu’s Link до сих пор остается одной из лучших программ в своем классе. Приложение потребует от вас некоторого времени на его изучение. Но, как только вы разберетесь, то весь процесс настройки и запуска проверки будет отнимать у вас минимум времени. Кроме того, Xenu предоставляет достаточно полные и детальные отчеты.

Это достаточно старый представитель данного класса программ. Однако, несмотря на то, что последний релиз программы состоялся в 2010, Xenu’s Link до сих пор остается одной из лучших программ в своем классе. Приложение потребует от вас некоторого времени на его изучение. Но, как только вы разберетесь, то весь процесс настройки и запуска проверки будет отнимать у вас минимум времени. Кроме того, Xenu предоставляет достаточно полные и детальные отчеты.

Примечание: картинка справа — это логотип с сайта разработчика.

Основные характеристики:

- Простой пользовательский интерфейс без излишеств (классика)

- Умеет перепроверять битые ссылки (полезно при временных сетевых ошибках)

- Простой и детальный отчет о сканировании

- Фильтры

- Занимает меньше 1 МБ

- Поддержка SSL веб-сайтов («https:// «)

- Частичное тестирование ftp, gopher и почтовых адресов

- Обнаруживает и помечает в отчет url, которые были перенаправлены

- Создает карту сайта

Link Evaluator расширение браузера Firefox для проверки ссылок

Link Evaluator — это расширение для браузера Firefox, которое умеет проверять только открытые страницы. Но, несмотря на ограничение, программа будет весьма полезной для быстрой проверки.

Но, несмотря на ограничение, программа будет весьма полезной для быстрой проверки.

Link Evaluator отслеживает как статусный код http, так и содержимое страницы, которое возвращается для каждого url. И пытается распознать отличия между результатами (как например, отсутствие корректного кода по стандарту и реально возвращаемый текст). Учитываются следующие результаты:

- Битые ссылки (404)

- Превышение времени ожидания ответа сервера

- Ошибки аутентификации

- «Некорректный» контент для заданной страницы

Каждая проверенная ссылка подсвечивается цветом относительно результата проверки: зеленый — успешно, оттенки желтого — частично успешно, красный — не успешно.

В целом, Link Evaluator подойдет тем пользователям Firefox, которые занимаются анализом веб-страниц или же часто проводят время на своих сайтах.

Онлайн решения для проверки ссылок на веб-сайте

Как альтернатива, выступают различные онлайн решения для проверки ссылок. У них есть как и свои преимущества (например, нагрузки не на вашем компьютере и прочие), так и свои недостатки (различные ограничения, неполные отчеты и прочие).

У них есть как и свои преимущества (например, нагрузки не на вашем компьютере и прочие), так и свои недостатки (различные ограничения, неполные отчеты и прочие).

Online Broken Link Checker позволяет найти только точно битые ссылки, без предоставления полного отчета о всех проверенных ссылках и кодах ответов. Для каждой мертвой ссылки отмечается веб-страница, на которой ссылка была обнаружена. Вы так же можете щелкнуть по ссылке «src» рядом с каждой обнаруженной битой ссылкой, чтобы увидеть исходный код html с выделенной областью, где ссылка была обнаружена.

Бесплатная версия ограничена проверкой 3000 ссылок. Так же надо учитывать, что инструмент проверяет как внутренние ссылки, так и внешние. Поэтому в зависимости от размеров сайта, такой проверки может быть не достаточно. Коммерческая версия не имеет такого предела и позволяет проверять сайты любого размера, но все же это коммерческая версия.

Еще одним инструментом является W3C Link Checker. Несмотря на то, что решение позволяет проверять только одну страницу в один момент времени, сформированный отчет будет достаточно информативным. Кроме того, необходимо понимать, что речь идет о w3.org, в чьем ведении находятся многие стандарты строительства web.

Кроме того, необходимо понимать, что речь идет о w3.org, в чьем ведении находятся многие стандарты строительства web.

Link Valet от Web Design Group позволяет пройтись во вашему сайту аналогично тому, как это выполнял бы поисковый робот. Т.е. с учетом ограничений в robots.txt. После сканирования, полный отчет будет содержать информацию о ссылках и возвращаемых кодах. У сервиса есть лимит глубины рекурсии, но вы можете продолжить поиск по вашему сайту, выбрав одну из ссылок в конце отчета (страницы, которые не были проверены).

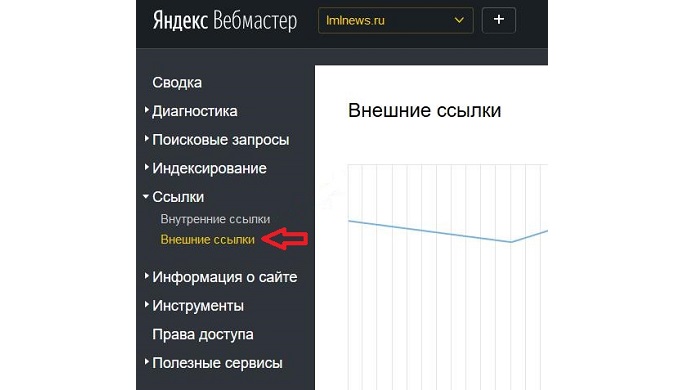

Так же существует различные дополнения для известных CMS, которые самостоятельно проверяют структуру сайта и формируют отчет о битых ссылках. Кроме того, некоторые поисковые системы предлагают собственные инструменты для отслеживания мертвых ссылок, но, обычно, для их использования необходимо зарегистрироваться и подтвердить тот факт, что сайт принадлежит вам.

Руководство по быстрому выбору (ссылки на бесплатные программы для проверки ссылок на веб-сайтах)

LinkChecker

Xenu’s Link Sleuth

Link Evaluator

☕ Хотите выразить благодарность автору? Поделитесь с друзьями!

- Лучшие бесплатные программы для скачивания любого сайта

Добавить комментарий / отзыв

Проверять сайты на наличие битых ссылок

Введение

LinkChecker — бесплатная лицензия GPL. лицензированный валидатор сайтов.

LinkChecker проверяет ссылки в веб-документах или целых веб-сайтах.

Он работает в системах Python 2, требующих Python 2.7.2 или новее.

Python 3 пока не поддерживается.

лицензированный валидатор сайтов.

LinkChecker проверяет ссылки в веб-документах или целых веб-сайтах.

Он работает в системах Python 2, требующих Python 2.7.2 или новее.

Python 3 пока не поддерживается.

Характеристики

- рекурсивная и многопоточная проверка и сканирование сайта

- вывод в цветном или обычном тексте, HTML, SQL, CSV, XML или карту сайта график в разных форматах

- HTTP / 1.1, HTTPS, FTP, mailto :, news :, nntp :, Telnet и локальный файл ссылки поддержки

- ограничение проверки ссылок с помощью фильтров регулярных выражений для URL

- поддержка прокси

- авторизация по имени пользователя / паролю для HTTP, FTP и Telnet

- соблюдает протокол исключения robots.txt

- Поддержка файлов cookie

- Поддержка HTML5

- Поддержка плагинов

разрешение пользовательских проверок страниц. В настоящее время доступны

Проверка синтаксиса HTML и CSS, проверка на вирусы и многое другое.

- Различные интерфейсы: командная строка, графический интерфейс и веб-интерфейс

- … и многие другие варианты проверки, задокументированные в страница руководства.

Скриншоты

| Интерфейс командной строки | Клиент с графическим интерфейсом | Веб-интерфейс CGI |

Базовое использование

Чтобы проверить URL типа http://www.example.org/myhomepage/ , достаточно

введите http: // www.example.org/myhomepage/ в клиенте графического интерфейса или

веб-интерфейс или выполнить linkchecker http://www.example.org/myhomepage/ в командной строке.

Эта проверка будет рекурсивно проверять все страницы, начинающиеся с http://www.example.org/myhomepage/ . Кроме того, все внешние ссылки

указание за пределами www.example.org будет проверяться, но не рекурсивно

в.

Другие средства проверки ссылок

Если это программное обеспечение не соответствует вашим требованиям, вы можете проверить другие бесплатные средства проверки ссылок.

Статус набора тестов

Linkchecker имеет обширные модульные тесты для проверки качества кода. Travis CI используется для непрерывной сборки и тестовая интеграция.

Как проверить свой сайт на наличие битых ссылок

В этой статье описаны два метода проверки веб-сайта на наличие битых ссылок:

- Google Search Console позволяет просматривать неработающие ссылки и ошибки, обнаруженные сканерами Google. Эта информация автоматически обновляется каждый раз, когда Google сканирует ваш сайт.

- W3C Link Checker сканирует ваш сайт на наличие битых ссылок по запросу. Этот метод также предоставляет конкретную строку в исходном HTML-файле, содержащую неработающую ссылку.

Метод № 1: Консоль поиска Google

Чтобы постоянно отслеживать неработающие ссылки на вашем сайте с помощью консоли поиска Google, выполните следующие действия:

- Войдите в свою учетную запись Google Search Console.

Если у вас еще нет учетной записи Google Search Console, зарегистрируйтесь здесь.

Если у вас еще нет учетной записи Google Search Console, зарегистрируйтесь здесь. - Щелкните сайт, за которым хотите следить. Откроется страница Search Console.

- Нажмите «Сканировать», а затем выберите «Просмотреть как Google». Здесь вы можете запросить у Google сканирование определенных страниц вашего сайта.

Этот процесс происходит не сразу. Сканирование вашего сайта Google может занять до одной недели.

- После того, как Google просканирует сайт, для доступа к результатам нажмите Сканирование, а затем нажмите Ошибки сканирования. Откроется страница ошибок сканирования.

- В разделе «Ошибки URL» отображаются все неработающие ссылки, обнаруженные Google в процессе сканирования.

Метод № 2: W3C Link Checker

Чтобы просканировать ваш сайт на наличие битых ссылок с помощью W3C Link Checker, выполните следующие действия:

- Используйте свой веб-браузер, чтобы посетить W3C Link Checker.

- В текстовом поле Введите адрес (URL) документа, который вы хотите проверить, введите URL сайта, который вы хотите просканировать.

- Чтобы видеть только релевантные выходные данные, установите флажок «Только сводка».

- Чтобы проверять ссылки на последующих страницах, установите флажок Проверять связанные документы рекурсивно.В текстовом поле глубины рекурсии введите, сколько уровней вы хотите проверить.

- Щелкните Проверить. Результаты отображаются при сканировании каждой страницы.

Проверка ссылок на веб-сайт — проверьте свой веб-сайт на наличие неработающих ссылок

Online Website Link Checker — удобный инструмент для каждого веб-мастера. Это позволяет вы, чтобы проверить, содержит ли ваш веб-сайт битые ссылки. Люди серфинга в Интернете раздражает, когда они нажимают ссылку, которая не работает и не имеет значения, является ли это ссылкой на несуществующую страницу в вашем Интернете, вы удалили или переименовали по какой-либо причине, или это ссылка на третью веб-страница партии, которую вы не можете контролировать.Неработающая ссылка в вашем Интернете — это ваша проблема и онлайн-проверка ссылок на веб-сайты может помочь вам выявить проблему, как только возможно.

Онлайн-проверка ссылок на веб-сайты посещает указанную вами веб-страницу и создает список всех ссылок на этой странице. Затем он проверяет, все ли ссылки в список действителен. Почти все веб-сайты содержат более одной страницы и, следовательно, проверка действительности всех ссылок в Интернете займет много времени. сайт, если это было сделано отдельно для каждой страницы.Вот почему вы можете указать глубина процесса проверки ссылки в онлайн-проверке ссылок на веб-сайты и таким образом вы можете легко проверять ссылки на всех страницах вашего веб-сайта. Онлайн-проверка ссылок на веб-сайты не только посещает указанную вами исходную страницу. но также и все страницы вашего веб-сайта, на которые ссылается исходная страница. И опять же, если веб-страница, на которую ссылается исходная страница, ссылается на другую веб-страницу на вашем сайте будут проверяться и его ссылки и т. д.

Наш движок способен полностью анализировать HTML (версии 4 и 5) и CSS. коды, а также выявлять и проверять ссылки во всех стандартных элементах.

Укажите URL-адрес веб-страницы, с которой нужно начать, и щелкните «Проверять!» кнопка. По умолчанию значение Глубина установлено на 1, что означает, что онлайн-проверка ссылок на веб-сайты будет проверять только те ссылки, которые найдены на указанной вами исходной странице. Если вы установите глубину 2, ссылки второго уровня также будут проверяться. Ссылки второго уровня: ссылки на страницах в том же домене, что и исходная страница, которые ссылка на исходную страницу.Точно так же, если вы установите глубину на 3, Ссылки третьего уровня также будут проверены, и это ссылки, на которые есть ссылки страницы второго уровня.

Обратите внимание, что если вы ссылаетесь на веб-страницы другого домена, ссылки будут проверено, но независимо от значения глубины ссылки от этих сторонних страницы проверяться не будут.

Используйте параметр Диапазон , чтобы указать, какие веб-страницы следует проверять (битые) ссылки. Проверяет страницы только в указанном субдомене опция позволяет онлайн-проверке ссылок на веб-сайты проверять только страницы в пределах одного субдомен 1 , указанный в параметре URL .Выбрав опция Проверять страницы во всем домене вы указываете программе проверки сканировать во всех поддоменах основного домена URL.

Вы также можете указать максимальное количество страниц, которые программа проверки может сканировать, используя Максимальное количество страниц для сканирования Поле . Ограничение по умолчанию — 500 страниц. Вы можете увеличить лимит до 10000 страниц. Однако, если вы установите лимит выше чем значение по умолчанию, вам придется платить дополнительные кредиты за каждые 500 страниц сверх лимита по умолчанию.Обратите внимание, что окончательная стоимость рассчитывается исходя из фактического количества страниц, которые сканирует программа проверки. Сначала мы списываем с вашего счета столько кредитов, сколько необходимо для покрытия максимального лимит, который вы устанавливаете. Затем, после выполнения задачи, мы возвращаем неиспользованные кредиты, если таковые имеются. Например, если у вас достаточно средств на счету, вы можете смело установить лимит на 10000, а если проверяемый вами сайт содержит всего 3350 ссылок, вам вернут неиспользованные кредитов, так что ваша окончательная стоимость будет такой, как если бы вы установили лимит в 3500.

Есть много веб-сайтов, на которых протокол robots.txt. Короче говоря, владелец веб-сайта помещает файл robots.txt в корень (под) домена. (например, http://www.google.com/robots.txt) и все добросовестные веб-сканеры загружают файл перед сканированием (под) домена чтобы узнать, какие URL-адреса запрещены для сканирования. Онлайн-проверка ссылок на веб-сайты позволяет уважать или не уважать протокол robots.txt, просто установив или сняв отметку Роботы Respect.txt вариант.

Если вы хотите настроить правила robots.txt специально для проверки ссылок на веб-сайты в Интернете, используйте odt как значение пользовательского агента. Например, чтобы запретить нашему движку посещать / Test / папка, используйте:

Пользовательский агент: odt

Disallow: / Test /

Для веб-мастеров, которые хотят тщательно проанализировать свои веб-сайты, мы предлагаем варианты Проверить URL-адреса в CSS и Проверить ссылки в HTML-формах .Воспользуйтесь первым вариантом если вы хотите проверить все URL-адреса в атрибуты стиля, в элементах

Размер файлов не должен превышать 128 Мб. Есть возможность проверить архив без предварительного разархивирования. После недолгой проверки получите отчет. В случае опасности «чертёнок» покажет количество зараженных файлов. Ещё одним плюсом Вирустотал есть возможность установить приложение [link]VirusTotal Uploader[/link].

Размер файлов не должен превышать 128 Мб. Есть возможность проверить архив без предварительного разархивирования. После недолгой проверки получите отчет. В случае опасности «чертёнок» покажет количество зараженных файлов. Ещё одним плюсом Вирустотал есть возможность установить приложение [link]VirusTotal Uploader[/link]. Link Cheker делает:

Link Cheker делает:

ru

ru

Наш сервис предоставляет отчет о проверке файла с информацией о его безопасности/заражении.

Наш сервис предоставляет отчет о проверке файла с информацией о его безопасности/заражении.

Each time you may check only one file with size not exceeding 512kB.

Each time you may check only one file with size not exceeding 512kB. You can use it to scan your system’s memory, all files and drives’ boot sectors, and to automatically clean infected files.

You can use it to scan your system’s memory, all files and drives’ boot sectors, and to automatically clean infected files. HouseCall performs additional security checks to identify and fix vulnerabilities to prevent reinfection.

HouseCall performs additional security checks to identify and fix vulnerabilities to prevent reinfection. 3) is a free service. Use it to find out if your computer is infected, and disinfect your computer if needed. The product will automatically download the necessary components and virus definition databases as it is started.

3) is a free service. Use it to find out if your computer is infected, and disinfect your computer if needed. The product will automatically download the necessary components and virus definition databases as it is started. В случае обнаружения опасности отправляется уведомление по e-mail, ICQ и SMS, и Вы сможете принять необходимые меры.

В случае обнаружения опасности отправляется уведомление по e-mail, ICQ и SMS, и Вы сможете принять необходимые меры. Эти данные будут являться для нас исходными, однако уже на этом этапе можно выявить взломанный сайт. После каждой последующей проверки сайта, новые данные будут сравниваться с исходными. В случае обнаружения неизвестных системе ссылок, скриптов и т.д. они отобразятся в личном кабинете, а владелец сайта будет об этом предупрежден.

Эти данные будут являться для нас исходными, однако уже на этом этапе можно выявить взломанный сайт. После каждой последующей проверки сайта, новые данные будут сравниваться с исходными. В случае обнаружения неизвестных системе ссылок, скриптов и т.д. они отобразятся в личном кабинете, а владелец сайта будет об этом предупрежден. ru

ru

Оно не конфликтует с антивирусным ПО, установленным на компьютере.

Оно не конфликтует с антивирусным ПО, установленным на компьютере. Проверка ссылок выполняется на «normal»

ссылках, изображениях, фреймах, плагинах,

фонах, локальных картах изображений,

таблицах стилей, скриптах и java апплетах. Он

отображает постоянно обновляемый список

URLs, которые вы можете отсортировать по различным

критериям. Отчет может быть подготовлен в

любое время.

Проверка ссылок выполняется на «normal»

ссылках, изображениях, фреймах, плагинах,

фонах, локальных картах изображений,

таблицах стилей, скриптах и java апплетах. Он

отображает постоянно обновляемый список

URLs, которые вы можете отсортировать по различным

критериям. Отчет может быть подготовлен в

любое время.

Если у вас еще нет учетной записи Google Search Console, зарегистрируйтесь здесь.

Если у вас еще нет учетной записи Google Search Console, зарегистрируйтесь здесь.