Продвижение сайтов медицинской тематики, кейс по выводу в ТОП Яндекса

Доброго времени суток, друзья, коллеги и просто случайные читатели (угораздило же вас нарваться именно на мой пост). Мне выпала честь начать цикл публичных кейсов, посвященных SEO в частности и интернет-маркетингу в целом. Писать будем всей своей дружной командой, потому что нас тут ох как много и у каждого за плечами свое кладбище не один успешно реализованный проект. В цикле будут как обзоры работы с конкретной тематикой, так и в принципе советы по решению частых проблем, с которыми могут столкнуться вебмастера и владельцы сайтов.

Я же сегодня с удовольствием расскажу о том, как почти за полгода неплохо отработал сайт медицинской тематики (мед. техника для домашнего использования) и вывел его в ТОП Яндекса по запросам (в том числе и высокочастотным). К сожалению, для Google проведенных работ на определенном этапе оказалось недостаточно, но обо всем этом подробнее ниже.

Общая информация по проекту Начало работы с проектом — октябрь 2018 года.

Стояли следующие задачи:

- Вывод посадочных страниц в ТОП-10 ПС по релевантным запросам.

- Увеличение посещаемости сайта.

Ну тут все как обычно, классические цели для абсолютного большинства проектов. Далее подробнее разберем проведенные работы.

Аудит — всему голова. Только всесторонний анализ проекта гарантирует выбор правильной стратегии продвижения и адекватный план работ на период. Собственно, далее рассмотрим, какие проблемы были выявлены в ходе препарирования сайта.

Базовые показатели (индексация + история домена) Как я уже писал выше, сайт пришел ко мне уже с небольшой историей — в индексе был как минимум полгода, поэтому первым делом смотрим как на него отреагировали поисковики.

- Всего на сайте обнаружено 332 html-страниц.

- Количество проиндексированных страниц в ПС Яндекс – 440.

- Количество проиндексированных страниц в ПС Google – 379.

Все страницы сайта учтены и находятся в поиске — это хорошо. Однако кроме них в индекс попали технические страницы, которым там не место — это не хорошо. К тому же есть расхождение (хоть и небольшое) между числом страниц в выдаче Яндекса и Google — тоже нужно обратить на это внимание.

По итогу вручную проходимся по органической выдаче, причесываем robots.txt, закрывая от индекса ненужные страницы. При этом параллельно генерируем sitemap.xml, заливаем ее в корень сайта, обновляем информацию в вебмастерах.

Что касается доменного имени — домен стерильный (без санкций), бэклинков практически нет. С одной стороны хорошо, когда история чиста — можно спокойно сформировать хороший ссылочный профиль, не оглядываясь на предыдущих вебмастеров и их эксперименты. Но, с другой стороны, для того, чтобы сделать домену качественную ссылочную историю, нужно немало времени (у многих просто не хватает терпения) + есть вероятность, что “чистый” сайт, даже с возрастом в один год, все же может еще висеть в песочнице.

Компания, продающая свои товары/услуги через интернет, должна быть зарегистрирована как минимум в двух основных справочниках — Яндекс.Справочник и Google Мой Бизнес. Это нужно для того, чтобы потенциальному клиенту было проще отыскать компанию (+маркер на карте и присвоение сайту региона). Собственно, у моего проекта всего этого не было. Провели успешную регистрацию в справочниках.

Самый сок — все косяки и недоработки сайта. Здесь, как правило, больше всего рекомендаций и работы. Для анализа использовал классическую программу Screaming Frog, которая сегодня есть у любого уважающего себя SEO-специалиста.

Итак, что же мы нашли в ходе тех.аудита:

- Расклейка зеркал — код 200 как у www.site.by, так и у site.by. Настроили редирект с www.site.by на site.by. При выборе основного зеркала руководствовались тем, какое из них оказалось в выдаче.

- У 68% картинок на сайте отсутствует тег alt. В ходе последующих двух месяцев заполнили альты у всех картинок.

- На сайте присутствуют «хлебные крошки», однако в карточках товара неполные крошки – в пути отсутствует карточка товара, а раздел перед ней некликабелен. Составлено ТЗ на доработку. Проблема устранена на втором месяце работы с сайтом.

- На сайте обнаружены внешние ссылки (в основном на социальные сети — стандартный блок карточки товара в шаблоне). Изначально хотели вывести их java-скриптом, но потом в принципе отказались от таких линков и закомментили от греха подальше.

- На сайте не обнаружена HTML-карта сайта. Не критичная ошибка, пометили себе как доработку на будущее.

- С помощью PageSpeed Insights получили рекомендации по увеличению скорости загрузки сайта. Это классические советы вроде удаления из верхней части страницы блокирующего кода JavaScript и CSS, сокращения объема изображений (сжатие), использования кэширования браузера за счет указания в заголовках HTTP даты или срока действия статических ресурсов и т.

д. Последовали советам, в итоге увеличили скорость загрузки страниц сайта (86 баллов из 100 возможных).

д. Последовали советам, в итоге увеличили скорость загрузки страниц сайта (86 баллов из 100 возможных). - Т.к. на сайте есть фильтрация и пагинация, обязательным пунктом технического аудита стала проверка на наличие и корректность настройки атрибутов re=”canonical” + “next”/”prev”. По итогу обнаружены дубли страниц – динамические страницы (фильтры, пагинация). Хоть дубли и были закрыты от индекса, но дополнительно разместили на них тег rel=”canonical” (для фильтров) и rel=”next”/”prev” для страниц пагинации. Таким образом мы показали поисковым роботам какие страницы являются основными (родительскими), а какие — дочерними, навсегда закрыв этот вопрос.

- Далее проверили все внутренние страницы сайта на корректность отработки (ответы сервера). Проще будет описать это таблицей.

Небольшой, но все же просчет — неправильное оформление 404 страницы. При запросе несуществующей страницы рекомендуется сообщать посетителю, что произошла ошибка и помочь в дальнейшей навигации по сайту. Что мы, собственно и сделали… не без доли юмора… ну да, такие вот мы Петросяны.

- Проверка микроразметки — микроразметка карточек товаров в порядке (я был приятно удивлен), однако МР хлебных крошек и страницы “Контакты” на сайте почему-то не оказалось. Реализовали классическую разметку для хлебных крошек и страницы «Контакты».

- В ходе парсинга сайта обнаружили сквозной тег “noindex”, который висел на одном из элементов формы обратной связи. Я придерживаюсь мнения, что чем меньше noindex-а на сайте, тем лучше, поэтому приняли решение убрать тег… все равно никакой практической пользы от него нет.

Для главной

| URL | Код ответа | Нужно |

| index | 404 | 404 |

index. htm htm | 404 | 404 |

| index.html | 200 | 301 |

| qwerty123 | 404 | 404 |

| qwerty123.htm | 404 | 404 |

| qwerty123.html | 404 | 404 |

| qwerty123.php | 404 | 404 |

| // | 200 | 301 |

Для внутренних

| URL | Код ответа | Нужно |

| С закрывающим слэшем и без (проверка на дубли) | 200 | 301 |

| .htm | 200 | 301 |

| .html | 200 | 301 |

| .php | 200 | 301 |

| qwerty123 | 200 | 404 |

| qwerty123.htm | 200 | 404 |

qwerty123. html html | 200 | 404 |

| qwerty123.php | 200 | 404 |

| Произвольные параметры для динамических страниц | 200 | 404 |

Сервер настроен некорректно. В таблице отмечены варианты, при которых сервер отдает неправильный ответ. По итогу настроили сервер таким образом, чтобы несуществующие страницы отдавали код ошибки 404. Там, где это было нужно, настроили 301 редирект.

На этом закончился технический аудит сайта — по итогу ошибок не так много (одна из причин, почему я люблю молодые сайты) и абсолютное их большинство было устранено в течение первых двух месяцев работы.

Текстовый аудит занимает обычно довольно много времени, но в этот раз мне можно сказать повезло — т.к. сайт был на стадии финального заполнения товарами, там была всего пара страниц с текстом… к сожалению, полностью скопированным с других ресурсов. Плагиат не приемлем, потому неуникальные тексты были удалены и впоследствии заменены на качественный копирайт, страницы без текстов, естественно, также наполнили контентом в течение всего периода работы над проектом.

Обычно на это уходит от силы два месяца, но в данном случае было большое количество посадочных, для которых нужны уникальные тексты.

Обычно на это уходит от силы два месяца, но в данном случае было большое количество посадочных, для которых нужны уникальные тексты.Проверка title — все тайтлы на сайте выводились по маске. Для посадочных страниц переписали title руками под запросы. Для всех остальных — изменили маску на более информативную (h2+регион+название магазина).

Проверка h2 — было обнаружено большое число дублей по h2. Переписал все теги вручную.

Проверка Description — описаний не было ни на одной странице сайта. На посадочных прописал руками с учетом ключевых запросов. Для остальных страниц настроил маску (В нашем интернет-магазине вы можете купить+h2+в Минске+Товары с ценами, фото, подробным описанием).

Статейный раздел сайта не развит от слова “вообще”. Даны рекомендации по написанию статей в блог для перелинковки страниц и регулярного обновления контента сайта.

При подготовке рекомендаций по улучшению юзабельности ресурса важно четко понимать желания аудитории и, что немаловажно, возможности заказчика. Никто не запрещает, конечно, посоветовать перекроить шаблонный сайт под звездолет, потратив на это уйму времени, сил и ресурсов, но иногда это не так эффективно… были в моей практике такие случаи, когда заказчик, не рассчитав свои силы, просто не мог финансово тянуть проект и по итогу уходил в минус на одних только доработках, не дожив до реального результата.

Никто не запрещает, конечно, посоветовать перекроить шаблонный сайт под звездолет, потратив на это уйму времени, сил и ресурсов, но иногда это не так эффективно… были в моей практике такие случаи, когда заказчик, не рассчитав свои силы, просто не мог финансово тянуть проект и по итогу уходил в минус на одних только доработках, не дожив до реального результата.

В общем, нужно быть в первую очередь практичным, советуя доработки, что я и сделал в этот раз, рекомендуя только необходимые изменения.

Добавить на сайт онлайн-консультанта (JivoSite, например, или EnvyBox) – это позволит быстрее обрабатывать запросы посетителей + даст возможность расширить сниппет в выдаче.

В разделах/подразделах вывести дополнительные ссылки на теговые страницы с брендами товаров. Например, тонометры – микролайф, омрон и т.д. Каждый бренд должен открываться на отдельной статичной странице (для того чтобы оптимизировать их под запросы).

В левый сайдбар навигации вывести все подкатегории – например, для тонометров выводить «автоматические», «полуавтоматические», «механические» и т.

д. Сделать так, чтобы пункт «Тонометры» разворачивался вниз и показывал свои подкатегории – это упростит переход к подразделам.

д. Сделать так, чтобы пункт «Тонометры» разворачивался вниз и показывал свои подкатегории – это упростит переход к подразделам.В карточку товара вывести блок «Похожие товары» — работа на внутреннюю перелинковку сайта + помощь пользователю + улучшение поведенческих показателей (время на сайте, процент отказов и т.д.).

- В карточку товара вывести блок «С этим товаром часто покупают» — сюда выводить расходники (если они есть). Данный блок работает аналогично предыдущему, с одним лишь отличием — помогает делать допродажи.

Все карточки товаров вывести в отдельную категорию /product/ вне общей структуры сайта. Это поможет избавиться от дублирования страниц в том случае, если один товар будет показываться в нескольких категориях одновременно и, соответственно, иметь два разных адреса.

Как я уже говорил выше, я не ставил целью сделать звездолет из шаблонного интернет-магазина, нужно было просто привести его в человеческий вид, потратив минимум времени и денег.

Проанализировав ТОП-20 конкурентов в тематике, была создана базовая семантика (до 500 запросов), которая в течение месяца была расширена до более чем 4000 запросов. Учитывались не только ключи для разделов и подразделов, но и коммерческие запросы для теговых страниц + запросы по товарам.

После сбора и чистки семантики, была проведена кластеризация запросов и разбивка их по посадочным страницам. Имея на руках структурированное СЯ и анализ конкурентов, была выведена расширенная структура сайта. К сожалению, полностью ее привести не смогу — она получилась очень разветвленной (нет возможности сделать хоть сколько-то адекватный скрин), ниже пример небольшого ее куска.

Итак, все необходимые данные у нас на руках, приступаем к практической части работы.

Для каждой группы запросов был составлен уникальный title и description на основе анализа конкурентных сайтов и перечня ключей, входящих в кластер.

Внесение всех мета на посадочные страницы заняло около 40 часов. Это суммарное время, потому что большей части страниц на сайте не существовало и приходилось возвращаться к правке мета каждый раз, когда был готов контент для новой страницы.

Внесение всех мета на посадочные страницы заняло около 40 часов. Это суммарное время, потому что большей части страниц на сайте не существовало и приходилось возвращаться к правке мета каждый раз, когда был готов контент для новой страницы.Составлено ТЗ на тексты для посадочных страниц. Написание текстов + публикация. Аналогично, как и в случае с мета-данными, эта работа растянулась аж на пять месяцев, т.к. посадочных страниц получилось немало и каждый месяц копирайтер выдавал контент на определенные группы товаров. Таким образом, мы сразу оптимизировали приоритетные страницы и спасли наших контент-менеджеров от приступов прокрастинации… там по итогу и так выходило что-то около 50к символов ежемесячно, представляете что случилось бы с нашими девушками, если бы им дали задание описать все посадочные страницы сразу?

По внешней оптимизации — раскачка ссылочного профиля путем получения бэклинков из различных источников (чтобы сделать максимально естественную ссылочную историю).

Была проведена регистрация в каталогах организаций, покупка отзывов на форумах, приобретение вечных ссылок на трастовых тематичных ресурсах. К сожалению, тематика проекта не предполагала активного продвижения в соц.сетях, потому оттуда ссылок достать не получилось, но и так неплохо.

Была проведена регистрация в каталогах организаций, покупка отзывов на форумах, приобретение вечных ссылок на трастовых тематичных ресурсах. К сожалению, тематика проекта не предполагала активного продвижения в соц.сетях, потому оттуда ссылок достать не получилось, но и так неплохо.

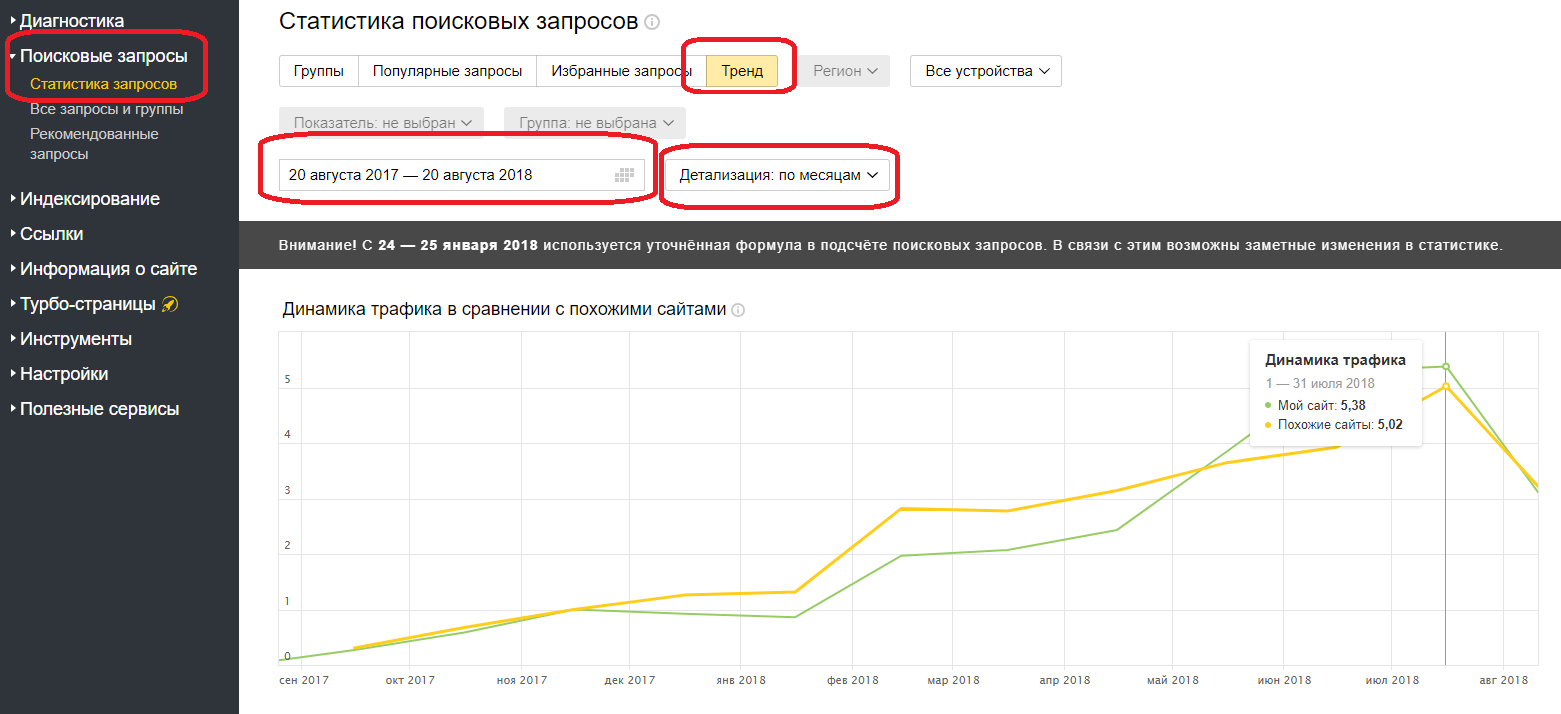

Ну а теперь самое интересное — к чему мы пришли спустя 5 месяцев работы над проектом? Честно сказать, результаты неоднозначные. Яндекс очень хорошо принял сайт — положительная динамика видна невооруженным глазом буквально с первых месяцев работы. А вот Google повел себя более чем странно — упорно отказывался замечать сайт, хотя явных причин тому я не вижу, может быть только слабое ссылочное, которое лично я бы еще качал и качал. В общем, судите сами — далее статистика со скриншотами.

За период с октября 2018 года по февраль 2019 средняя позиция сайта в ПС Яндекс выросла с 70 до 34. В Google практически без изменений.

Процент запросов в ТОП-10 ПС Яндекс вырос с 6% до 38%. Google — без изменений.

Google — без изменений.

За период с октября 2018 года по февраль 2019 посещаемость сайта из Яндекса выросла с 774 визитов/месяц до 1637 визитов/месяц. Google за 5 месяцев практически без изменений — 50-70 визитов/месяц.

По завершении работ сайт был причесан, наполнен контентом и оптимизирован для продвижения в поиске. Началась аккуратная прокачка ссылочного профиля, которую следовало бы продолжать и дальше.

Хотя сайт не получилось вытянуть в поиске Google, нам удалось хорошо стартовать в Яндексе. В ТОП-10 Яндекса зашли как НЧ и СЧ-запросы, так и “толстые” ВЧ-запросы по ряду кластеров.

Возвращаясь к ситуации с Google — как я уже говорил, меня терзает подозрение, что конкретно данный проект, не имея раскаченного ссылочного профиля и будучи по сути молодым проектом, просто все еще сидит в песочнице (иначе как объяснить такую никакую динамику за полгода?). Признаюсь, тотальное фиаско с гуглом меня сильно зацепило, поэтому я продолжаю следить за проектом, периодически снимая позиции и проверяя метрику сайта — кто знает, может быть однажды я увижу рост показателей и смогу наконец-то спать спокойно?

Что же, а у меня на сегодня все! Всем счастья-здоровья, дружите с гуглом и не берите без предварительного анализа ссылки у незнакомцев, какими бы сладкими они (незнакомцы ссылки) не казались. Ну и подписывайтесь на нашу рассылку, чтобы не пропустить интересные статьи и кейсы от моих более удачливых коллег.

Ну и подписывайтесь на нашу рассылку, чтобы не пропустить интересные статьи и кейсы от моих более удачливых коллег.

Владимир Еленский

Практикующий SEO-специалист MAXI.BY media. Опыт работы более 5-ти лет. Хороший человек и просто красавчик.

Индексация сайта в поисковых системах Яндекс и Google. Как ускорить, проверить

Индексация сайта в поисковых системах — важная составляющая продвижения сайта в топ Яндекс и Google.

В статье расскажем, что такое индексация сайта, чем отличается индексация Яндекс и Google, как проиндексировать сайт в поисковых системах и как можно ускорить этот процесс. В завершении покажем, как проверить индексацию страниц.

Получайте до 18% от расходов на контекстную и таргетированную рекламу!Рекомендуем: Click.ru – маркетплейс рекламных платформ:

- Более 2000 рекламных агентств и фрилансеров уже работают с сервисом.

- Подключиться можно самому за 1 день.

- Зарабатывайте с первого потраченного рубля, без начальных ограничений, без входного барьера.

- Выплаты на WebMoney, на карту физическому лицу, реинвестирование в рекламу.

- У вас остаются прямые доступы в рекламные кабинеты, рай для бухгалтерии по документообороту и оплатам.

Читайте также: 10 лучших курсов по SEO-продвижению

Что такое индексация сайта в поисковых системах?

Индексация сайта или страниц сайта — это когда поисковые роботы обходят сайт и собирают данные о его содержании. Во время индексации сканируется вёрстка, текст, внешние и внутренние ссылки, графические и медиа элементы. После успешной проверки сайт попадает в индекс поисковой системы.

Простыми словами, поисковики вносят ваш сайт в свою базу данных и решают, показывать ли его в результатах выдачи. Далее поисковая система ранжирует ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры.

По большому счёту, процесс индексирования сайта в Яндекс и Google идентичен, но с одним отличием. В 2019 году Google изменил свой основной принцип индексирования сайта и перешёл на Mobile-first. С этого момента, поисковик в первую очередь сканирует мобильную версию страниц, а не десктопную. Поэтому, если вы хотите, чтобы ваш сайт лучше ранжировался в Google, проработайте отображение сайта на мобильных устройствах.

При этом, не стоит путать индексацию и ранжирование сайта:

- Ранжирование — это порядок отображения сайта в результатах поисковой выдачи, по определённым запросам.

- Индексация — это всего лишь фиксация данных о сайте в базе данных ПС.

Не путайте!

Как проиндексировать сайт в Яндекс и Google

По факту, можно ничего не делать и просто подождать, и поисковые системы, рано или поздно, самостоятельно проиндексируют сайт. Но лучше не надеяться на поисковики и взять инициативу в свои руки.

Но перед тем, как отправить сайт на индексацию, помните о поисковой оптимизации: правильном заполнении title и description, заголовков h2 и h3-H6, уникальном тексте, перелинковке, микроразметке.

Когда сайт готов, можно переходить к индексации.

Индексация сайта в Яндексе:

- Правильно прописать файл robots.txt.

- Сделать карту сайта.

- Добавить сайт в Яндекс.Вебмастер.

- Отправлять новые страницы на индексацию.

Индексация сайта в Google:

- Правильно прописать файл robots.txt.

- Сделать карту сайта.

- Добавить сайт в Google Search Console.

- Отправлять новые страницы на индексацию.

После этого поисковикам потребуется время на то, чтобы собрать и отобразить данные о сайте. Отобразятся они там же, в Яндекс.Вебмастер и Search Console. Обычно на это уходит 2-3 дня, может и больше, но не более недели.

Обычно на это уходит 2-3 дня, может и больше, но не более недели.

Если вы всё сделали правильно и сайт до сих пор не проиндексирован, то почитайте нашу статью: скоро здесь появится ссылка.

Как ускорить индексацию сайта

Выпустили новую статью и хотите, чтобы она как можно быстрее стала приводить вам поисковый трафик? В таком случае, можно ускорить индексацию новой страницы.

Вот несколько действенных способов:

- Откройте Яндекс.Вебмастер. Перейдите «Индексирование — Переобход страниц». Вставьте в текстовое поле URL-адрес и нажмите внизу «Отправить». Молодые сайты таким способом могут проиндексировать до 30 новых страниц за сутки, далее лимиты устанавливаются индивидуально.

- Для Google. Заходим в Search Console. В поле сверху вставляем URL-адрес и жмём Enter. Откроется страница с предварительными данными, здесь нажимаем «Запросить индексирование».

- Разместите ссылку на новую страницу в социальных сетях: ВКонтакте, Facebook, Twitter и прочих.

Чем больше, тем лучше.

Чем больше, тем лучше. - Сделайте email-рассылку с анонсом новой страницы или статьи. Также рассылку можно сделать в соцсетях или мессенджерах.

- Добавьте внутренние ссылки, ведущих на нужную страницу. Лучше всего размещать такие ссылки на самых посещаемых страницах своего сайта.

- Чаще обновляйте сайт и публикуйте новый контент. Тогда поисковые роботы сами будут чаще сканировать ваш ресурс.

Все эти действия в комплексе или по отдельности позволят поисковикам раньше обнаружить и проиндексировать новую страницу или ресурс в целом.

Как проверить индексацию сайта

Чтобы проверить индексацию сайта в поисковых системах, можно сделать следующее.

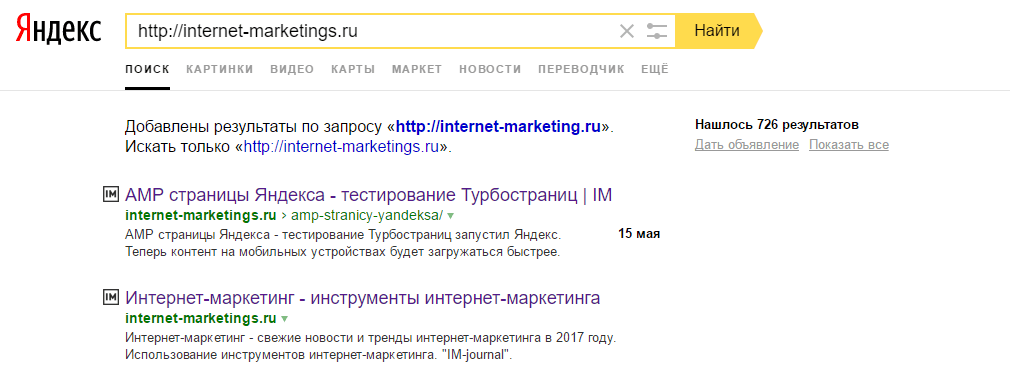

Способ 1. Введите в поиске специальный запрос: оператор [site] и адрес сайта (без пробела).

Пример: site:postium.ru.

Актуально, как для Яндекса, так и для Google.

Способ 2: Как узнать сколько страниц проиндексировал Яндекс.

Заходим в Яндекс. Вебмастер и переходим «Индексирование — Структура сайта». Напротив своего сайта, в столбце «В поиске» вы увидите количество проиндексированных страниц.

Вебмастер и переходим «Индексирование — Структура сайта». Напротив своего сайта, в столбце «В поиске» вы увидите количество проиндексированных страниц.

Способ 3: Как узнать сколько страниц проиндексировал Google.

Заходим в Search Console и открываем раздел «Покрытие». Здесь также показывается количество проиндексированных страниц, и страницы с ошибками.

Способ 4. Расширения для браузера, такой как, например RDS-бар.

Способ 5. Различные SEO-сервисы для анализа сайтов: Serpstat, Netpeak Checker, Pr-cy и прочие.

ЗаключениеПосле успешной индексации сайта в поисковых системах, работа не заканчивается. Необходимо периодически делать анализ индексации сайт, а так же снимать позиции по популярным запросам. Это позволит держать руку на пульсе и не оказаться в ситуации, когда значительная часть трафика из поисковиков просто исчезла.

Полезные ссылки:

Индексация сайта — что это такое, определение в маркетинге на ROMI center

Что это такое

Индексация страниц сайтов в поисковиках происходит по алгоритмам поисковых систем: учитываются ссылки ресурса, релевантность и распределение контента по разделам. Роботам важно понять, насколько представленная информация ценна для пользователя, который ввёл запрос в поисковую строку. Именно это и позволяет выявить поисковая индексация сайта.

Роботам важно понять, насколько представленная информация ценна для пользователя, который ввёл запрос в поисковую строку. Именно это и позволяет выявить поисковая индексация сайта.

Как настроить свой ресурс для наилучшей поисковой выдачи и как проверить все показатели? Обо всём этом расскажем далее.

Как проходит индексация сайта

Как только появилась глобальная сеть, у владельцев поисковых систем возникла необходимость фильтрации результатов запросов. В эти времена и появилась индексация сайта по ключевым словам. Такой односторонний метод оценки привёл к тому, что на первых строках результатов появлялись совершенно бесполезные страницы, сплошь и рядом заполненные необходимыми словоформами.

С тех пор многое изменилось и поисковые роботы научились оценивать сайты сразу по нескольким параметрам для получения наиболее достоверной информации. Сейчас индексация сайта бесплатная и высота отображения ресурса зависит исключительно от его качества.

Для улучшения индексации ресурса большинству русскоязычных сайтов достаточно учесть особенности алгоритмов двух основных поисковиков: Google и Яндекс. Подача данных нового сайта может происходить автоматическим и ручным методами. Рассмотрим далее самые распространённые вопросы о прохождении индексации:

Подача данных нового сайта может происходить автоматическим и ручным методами. Рассмотрим далее самые распространённые вопросы о прохождении индексации:

Как происходит автоматическая проверка?

Автоматическая индексация сайта в поисковых системах происходит при помощи механизмов, которые самостоятельно находят ресурс и анализируют его контент, релевантность информации, ссылки, трафик, время визитов пользователей и многое другое. Началу прохождения такой проверки способствует наличие ссылок на сайт на других ресурсах.

Индексация в Google сайта: как сделать вручную?

Необходимо зарегистрировать ресурс в сервисе Google Search Console.

Где проверить количество страниц в индексе?

Чтобы узнать, сколько страниц сайта проиндексировано Яндексом, перейдите по ссылке. Для аналогичного мониторинга в Google необходимо ввести в поисковую строку значение site: домен сайта. Например site:moisait.ru

Почему Яндекс не индексирует сайт?

Яндекс сканирует ресурсы с более низкой скоростью, в сравнении с Google. Для получения заветной отметки в базе данных необходимо зарегистрироваться в Яндекс.Вебмастер.

Индексация Яндекс и Google: что важно учесть?

Помимо регистрации в Яндекс.Вебмастер и Search Console необходимо проверить карту сайта — sitemap, а также указать необходимые параметры индексации в файле Robots.txt.

Сколько времени индексируется новый сайт

Сколько занимает проверка — зависит от поисковой системы. Google является скоростным лидером в данном процессе, управляясь с индексацией примерно за одну неделю. Время индексации в Яндексе может быть больше — до нескольких недель.

Скорость, с которой поисковик заметит ресурс зависит от множества параметров, поэтому указанные сроки весьма условны. Например, дополнительные страницы уже проиндексированного сайта рассматриваются быстрее.

Что значит переиндексация сайта

Переиндексация — повторный анализ страниц, производимый алгоритмами поисковых систем. Как часто происходит данный процесс? Во многом это зависит от регулярности обновлений. Чем чаще на сайте появляется новая информация, тем с большим вниманием поисковик рассматривает ресурс, чтобы не пропустить новости. О прочих лайфхаках для ускорения индексации поговорим далее.

Проверить сайт на запрет индексации

При индексации сайта могут возникнуть проблемы, которые требуется оперативно устранить. Чтобы страницы успешно прошли проверку и отображались в поиске.

Яндекс.Вебмастер и Search Console содержат разделы, в которых можно посмотреть проблемы, найденные на ресурсе. Например, система может сделать запрет на индексацию страниц за нарушение правил безопасности или за отсутствие подверждённого домена.

Последствия запрета индексации части сайта отразятся на показах этих страниц. Пользователь просто не увидит их, когда введёт в поисковик целевой запрос.

Как открыть сайт для индексации, скрыв отдельные страницы

Однако иногда часть страниц требуется закрыть от индексации преднамеренно, прописав их в файле robots.txt. Вот в каких случаях это может пригодиться:

- Дублированные страницы.

- Страницы в разработке.

- Технические разделы, которые необходимо скрыть.

Во-первых, запретить индексацию специально можно путём указания имени нужного файла или папки в файле robots.txt:

User-agent: *

Disallow: /folder/file.php

Disallow: /folder/

Системы не смогут проверить noindex и nofollow, поэтому второй вариант скрытия ненужного контента — это указание данных тегов.

Запретить индексацию сайта полностью

Иногда требуется полностью удалить сайт из базы данных поисковых систем. Для это необходимо прописать в robots.txt значение:

User-agent: *

Disallow: /

Если же сайт не индексируется, но требуется обратное — необходимо в первую очередь проверить этот же файл. Возможно, во время работ на ресурсе он был временно скрыт от посторонних взглядов.

Проверка индексации сайта в поисковых системах

Проверить индексацию страницы можно:

- При помощи поисковой строки, добавив к домену сайта символы «site:».

- Встроенными инструментами Яндекс.Вебмастер и Google Search Console.

- Специальными сервисами, например RDS Bar или XSEO.in.

Как ускорить индексацию?

Индексирование сайта — это целый ряд процессов, повлиять на которые возможно, улучшив качество ресурса. Как проверить, достаточно ли хорош продукт с точки зрения поисковых роботов? Выполните перечисленные пункты и потенциальные клиенты уже совсем скоро увидят вас на страницах Яндекса и Google.

- Поисковые боты ценят частое обновление контента, поэтому нужно публиковать новости регулярно.

- Файлы sitemap.xml и robots.txt должны быть корректно заполнены.

- Индексация ссылок — краеугольный камень SEO, поэтому стоит включить внутреннюю перелинковку и добавить внешние ссылки.

- Необходимо проверить наличие ошибок.

- Провести индексацию сайта наилучшим образом поможет качественный контент и удобство ресурса для пользователей.

- Проверить контент сайта и включить в него ключевые слова, по которым необходимо отображаться.

- Исключить дубли страниц или скрыть их от индексации.

Как часто Яндекс переиндексирует сайты?

В Корпорации РБС систематически проводятся исследования алгоритмов поисковых систем, в том числе, конечно же, алгоритмов Яндекса. Аналитические данные, полученные в результате исследований, позволяют совершенствовать и улучшать технологии продвижения сайтов. Так, например, нами был проведен эксперимент, позволивший получить ответ на вопрос, который волнует многих оптимизаторов: как часто Яндекс переиндексирует сайты?

Некоторые оптимизаторские компании придерживаются в своей работе устоявшихся представлений о том, что переиндексация проходит примерно раз в две недели — месяц. Так считалось раньше, многие продолжают считать так и сегодня. Однако, по данным наших последних исследований, средняя частота индексации страницы сайта поисковыми роботами Яндекса составляет 2 месяца.

Вас, конечно, интересует вопрос, как мы получили эти цифры. Воспользовавшись операторами Яндекса, которые позволяют искать страницы по дате документа, мы произвели подсчет того, сколько страниц было проиндексировано за несколько месяцев. То есть, мы получили точное количество страниц, проиндексированных за день, за месяц и т.д. На основании этих данных, усреднив дату индексации по массе страниц, была подсчитана средневзвешенная частота индексации рунета.

Итоговые данные исследования представлены в таблице:

| Сколько месяцев назад | Дата индексации: начиная с | Дата индексации: заканчивая | Проиндекси-рованных страниц в месяц | Проиндекси-рованных сайтов в месяц | Произведение числа страниц на число месяцев ожидания |

| 0,5 | 24.11.2008 | 24.12.2008 | 1166275328 | 5246643 | 583137664 |

| 1,5 | 25.10.2008 | 24.11.2008 | 517037824 | 7348362 | 775556736 |

| 2,5 | 25.09.2008 | 25.10.2008 | 575049600 | 10233151 | 1,438E+09 |

| 3,5 | 26.08.2008 | 25.09.2008 | 319139680 | 7032475 | 1,117E+09 |

| 4,5 | 27.07.2008 | 26.08.2008 | 156473056 | 1619253 | 704128752 |

| 5,5 | 27.06.2008 | 27.07.2008 | 67509080 | 1153613 | 371299940 |

| 6,5 | 28.05.2008 | 27.06.2008 | 55373240 | 1512878 | 359926060 |

| 7,5 | 28.04.2008 | 28.05.2008 | 32786320 | 817107 | 245897400 |

| 8,5 | 29.03.2008 | 28.04.2008 | 19774816 | 813317 | 168085936 |

| 9,5 | 28.02.2008 | 29.03.2008 | 19155704 | 765290 | 181979188 |

| 10,5 | 29.01.2008 | 28.02.2008 | 18788006 | 651709 | 197274063 |

| 11,5 | 30.12.2007 | 29.01.2008 | 14784696 | 521438 | 170024004 |

| 12,5 | 30.11.2007 | 30.12.2007 | 12517872 | 561495 | 156473400 |

| Суммарное число страниц2974665222 | Среднее число месяцев до индексации 2,1749955 |

Изучив данные, представленные в таблице и на графике, можно сделать вывод, что срок давности индексации «средней» страницы в рунете составляет 2,17 месяца. Если посчитать более точно — учесть первые три месяца (75% всех проиндексированных страниц) с точностью до дня — получится, что средняя периодичность индексации составляет 59 дней (на 24 декабря 2008). То есть, примерно два месяца, а не две недели — месяц, как полагали раньше.

Что дают оптимизаторам эти цифры? За установленную ссылку оптимизатор, а вместе с ним и клиент платит 2 месяца ежедневно. А ссылка начинает приносить пользу только через 2 месяца — нерациональный расход бюджета на продвижение, не так ли? Когда проиндексированность ссылок систематически проверяется с помощью специальных программных комплексов, такого не происходит. Вывод прост — доверяйте свой бюджет на продвижение умелым и опытным оптимизаторам, которые имеют возможность отслеживать и снимать нерабочие ссылки и заменять их новыми.

Статья подготовлена по материалам исследований Евгения ТРОФИМЕНКО, начальника отдела исследований и аналитики Корпорации РБС.

отличия и особенности — SEO-словарь веб-студии Муравейник

В данной статье рассмотрим различия в индексации Яндекса и Google и почему в разных поисковиках может быть проиндексировано разное количество страниц. Подписчик спрашивает: «По какой причине в индексе Яндекса и Google количество страниц моего сайта разное? К примеру, в Яндексе 155, а в Google 230. Насколько это плохо? Как определить, почему так случилось? Как исправить?».

Почему необходимо попадание страниц в индекс

Индекс — это некоторая поисковая база, из которой потом поисковая система выбирает старнички, чтобы они участвовали в ранжировании (то есть участвовали в конкуренции за первые места) по тем или иным запросам.

Если страница вылетела из индекса либо в него не попала, то, соответственно, нигде не будет участвовать — и это плохо. Потому что если она хоть как-то худо-бедно в индекс залетела, то какой-нибудь запрос все равно на себя притянет, по нему выйдет. Пусть он даже будет супермикрочастотный, все равно хоть какой-то трафик может на себя собирать.

Потому за этим действительно нужно следить. У каждой поисковой системы существуют разные критерии по добавлению страниц в индекс и сохранении их там.

Есть четкие, например, и Яндекс, и Google выбрасывают дубли, а также страницы, закрытые от индексации тем или иным способом (и это очевидно, вебмастеры сами сказали поисковиком, что их не надо индексировать) и т.д.

Но есть и более мягкие критерии:

В обе эти категории входят страницы, которые по этим «мягким», не всегда понятным критериям не попадают в индекс. И в основном различие в индексации Яндекса или Google относится к этим категориям страниц, которые вылетели и не попали в индекс по неоднозначным критериям.

Особенности индексирования в Яндексе и Google

В Яндексе «недостаточно качественное» поменялось на одтельные два блока — малополезное/малоценное и невостребованное — и две категории как бы объединены, но по факту это 2 разных проблемы.

Первая, когда они малополезны, малоценны — это про их качество: мало контента, либо он настолько некачественный или недостаточный по мнению Яндекса, что из-за этого страница не попадает в индекс. Обычно это карточки товаров без фотографий, документ практически без контента — только заголовок, а больше ничего нет, или заголовок и один комментарий. Вот такие часто вылетают. То есть просто страница настолько проигрывает конкурирующим, что не может быть показана по какому-либо запросу, потому что бесполезна.

А вот вторая часть — невостребованы — это абсолютно про другое. Такая страница не нужна, нет тех запросов, по которым она будет ранжироваться, люди такое не спрашивают, поэтому даже нет смысла ее добавлять. И здесь вопрос в спросе.

Например, у вас есть теговая страница на сайте. И вы берете и добавляете заголовок в Вордстат, можно даже без разметки (кавычек, восклицательных знаков), а просто в широком соответствии. Даже можно регион не выставлять, а выбрать всю страну. И смотрите, а есть ли в таком режиме хоть какой-то мизерный спрос на это. И если хотя бы 10-20 человек так спрашивают, то страницу можно оставлять и под «невостребована» она не попадет. Если там 0, то лучше такую теговую страницу вообще не создавать, не внедряйте искусственную семантику на сайт, это вам только навредит. В ряде случаев это может пройти, но потом все равно такие страницы вылетят и сайту будет плохо.

Иногда, конечно, бывает, что может повезти и получится. Есть опыт, когда сгенерировали всё на всё, немного доделали и оно все-таки зашло — но это довольно редкая ситуация.

В Google нет такой детализации. Данный поисковик не особо любит объяснять, почему он именно так решил и именно эти страницы в категорию «просканировано, но не проиндексировано» отправил. И, в общем, в справке у них это тоже описано довольно абстрактно. В Яндексе тоже раньше про недостаточно качественно толком написано не было, сейчас хоть расписали в новой формулировке, спасибо им за это. А вот у Google четких критериев нет.

Что делать

Таким образом, все отличие в количестве проиндексированных страниц заключается в том, что критерии отличаются у разных поисковиков. Так что вам нужно заходить и в отчет Яндекса по просканивроанным и проиндексирвоанным старницам, смотреть, почему вылетели именно они: недостаточно качественные, дубли или еще какие-то причины, они случайно стали закрыты или не случайно. И обратить внимание, есть ли проблемы, какие, и постараться исправить их: сделать документы более качественными, а если не востребованы (спроса нет), то просто удалить, и в Яндекс и Google они не должны попадать.

И в Google тоже заходить в отчет «просканировано, но не проиндексировано» и смотреть, какие страницы туда попали, затем пробовать их либо прокачать, либо закрыть от индексации.

Поэтому в целом такое отличие, как правило, не несет ничего плохого, но если очень сильно отличается количество страниц, то нужно проверять и там, и там и как-то исправлять.

Что такое индексация сайта, как ее проверить и как ускорить

Чтобы открыть онлайн-магазин, запустить информационный или развлекательный портал в сети необходим сайт – это, буквально, место или сегмент в виртуальном пространстве с уникальным адресом (домен), где размещается контент и файлы по проекту. Но чтобы ресурс можно было найти среди других, его необходимо «прописать» в специальной базе поисковых систем – индексе.

Что такое индексация сайта? Как её правильно выполнить и проверить? Можно ли ускорить этот процесс и полностью отказаться от него, на что влияет индекс? На все вопросы подробно отвечаем в этой статье.

Разбираемся в понятиях

Индексация страницы – это процесс сбора, проверки и внесения информации о контенте сайта в базу поисковых систем. Такая непростая и трудоемкая работа поручается специальным роботам, которые целиком обходят весь сайт и, следуя установленным алгоритмам ПС, собирают информацию со страниц. При индексации учитываются внешние и внутренние ссылки, графические элементы, текстовое наполнение и другое. Если ресурс проходит проверку, то он вносится в индекс ПС, то есть пользователи смогут его найти по поисковым запросам.

Вся информация в базе – это выжимка данных, собранных поисковыми роботами с сайтов в Интернете. Пользователю, обратившемуся к такой библиотеке через ПС, предлагается сначала каталог сайтов с релевантной запросу информацией. Поисковые системы ранжируют ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры. Ознакомившись с краткой информацией о ресурсе (заголовок + сниппет), пользователь кликает на позицию в выдаче и переходит на целевую страницу для дальнейшего изучения.

Попытки структурировать сайты в сети были приняты в конце 90-х годов прошлого века. В то время алгоритмы ПС только разрабатывались, поэтому индекс напоминал предметный указатель по ключевым словам, которые находили роботы на проверяемых страницах. Соответственно в ТОП выдачи часто проникали переоптимизированные и абсолютно бесполезные для пользователей сайты. За 20-30 лет развития алгоритмы отбора усложнились. Сегодня роботы смотрят не только на попадание контента в тематику, но и на его качество, полезность для людей, доступность сайта с разных устройств, скорость загрузки и многое другое.

Как индексируют Яндекс и Google

Для большинства пользователей Рунета, индексация в поисковых системах – это добавление сайта в базу Яндекса и/или Гугла. Обычно достаточно прописать ресурсы только в этих поисковиках, чтобы развивать свой проект. Провести индексацию, независимо от выбранной ПС, можно двумя способами:

- Поисковые роботы самостоятельно находят и проверяют созданный сайт или его новые страницы. Многие эксперты считают такой вариант самым выгодным, ведь если ПС сами хотят внести ресурс в индекс, то он пользуется популярностью. Значит, приносит пользу. Как роботы определяют полезность страниц: наличие активных внешних ссылок, объемы трафика и вовлеченность посетителей. Если все условия выполняются, то индексация сайта проходит быстрее: от 24 часов до недели. В противном случае ПС могут и вовсе «забыть» о новом ресурсе. Работы у роботов хватает.

- Пользователь принудительно отправляет сайт на индексацию с помощью заполнения формы на сервисе поисковой системы. Созданные страницы помещаются в очередь на «прописку» и ждут посещения роботов ПС. Обычно добавляют URL главной страницы, а боты сами обходят весь ресурс, ориентируясь по карте сайта, меню и внутренним ссылкам. Используются сервисы Google Webmaster Tools и Яндекс.Вебмастер соответственно. Этот вариант занимает больше времени, но не требует финансовых затрат.

Для сканирования сайтов существуют разные боты ПС. Например, проверку новых страниц перед внесением в индекс делает основной робот, который проверяет весь контент на ресурсе. Новую информацию на проиндексированных страницах проверяет быстрый робот в соответствии с графиком обновления. Также используются боты для сканирования новостной ленты, графического контента и другие.

Как проверить?

Алгоритмы индексации и соответственно скорость работы ботов Яндекса и Гугла отличаются. Считается, что Google проверяет страницы быстрее. Это связано с тем, что система сначала сканирует сайт полностью – полезные и неполезные страницы, но в выдачу пропускает только качественные ресурсы. Таким образом, попадание в индекс Гугла ещё не гарантирует место в выдаче.

Индексация сайта в Яндексе, что это такое и почему долго? Роботы ПС проверяют только полезные материалы, отсеивая мусорные страницы. Поэтому индексация затягивается. В любом случае сканирование контента на соответствие требованиям выполняют обе системы: Яндекс сразу, а Гугл после «прописки».

Проверить индексацию можно тремя способами:

- Использовать инструменты вебмастеров, которые предоставляются поисковыми системами бесплатно – это webmaster.yandex.ru или google.com/webmasters. В Гугле откройте Search Console и далее раздел «Индекс Google». Информация о статусе сайта находится в блоке «Статус индексирования». В Яндексе пройдите по следующей цепочке: «Индексирование сайта» — «Страницы в поиске». Естественно нужно сначала внести в форму URL сайта и подтвердить права владельца.

-

Использовать специальные операторы, которые вводятся в поисковую строку. Для Яндекса и Гугла нужно прописать значение «site:» и после двоеточия добавить домен ресурса. Например: site:calltouch.ru. Таким способом можно узнать количество проиндексированных страниц. Если значения в Гугле и Яндексе сильно различаются, то вероятно сайт под фильтром.

-

Воспользоваться браузерными плагинами или спецсервисами. Это небольшие дополнения к веб-обозревателю, которые автоматически проверяют наличие страниц в индексе. Популярное решение — RDS Bar.

Как ускорить?

От того, как быстро роботы ПС проверят новый контент напрямую зависит скорость появления страниц в поисковой выдаче. Соответственно на сайт быстрее придет аудитория и совершит целевые действия. Скорость индексации зависит от нескольких факторов:

- Авторитетность сайта в сети, полезность для пользователей;

- Отсутствие ошибок при индексации;

- Качество и частота обновления контента;

- Наличие внутренних и внешних ссылок;

- Вложенность страниц;

- Правильно заполненные файлы sitemap.xml и robots.txt;

- Корректно выставленные ограничения в роботсе.

Для ускорения индексации рекомендуется выполнить следующие действия:

- Подобрать надежный и быстрый хостинг.

- Поставить сайт на индексацию в ПС Яндекса и Гугла.

- Корректно настроить robots.txt. В файле нужно запретить посещение технических, служебных страниц, просмотр другой информации, не представляющей пользы для посетителей.

- Создать файл карты sitemap.xml и сохранить его в корне сайта. По нему роботы проверяют структуру страниц, а также следят за обновлением контента.

- Проверить код главной и других страниц на наличие ошибок и дублей.

- Проверить текстовое наполнение на количество ключевых слов.

- Регулярно размещать на сайте новый полезный контент. Рекомендуется настроить внутреннюю перелинковку между статьями и страницами. Это простой и эффективный вариант повысить вовлеченность пользователей в проект и соответственно «подрасти» в выдаче.

- Настроить навигацию, сделать доступ к нужной странице с главного меню не длиннее 3-х кликов. К юзабилити сайтов сегодня предъявляются повышенные требования, так как это напрямую влияет на поведенческие факторы посетителей. Если до нужной информации расстояние в 10-12 кликов, то 90% пользователей покинут такой сайт.

- Разместить ссылки на ресурс в соцсетях, на тематических форумах, досках объявлений и других площадках генерации трафика.

Часто требуется уменьшить вес изображений, так как «тяжелая» графика замедляет загрузку страниц, плохо сказывается на индексировании и дальнейшем продвижении в поисковой выдаче.

Как закрыть страницы от роботов?

Выше мы узнали, что такое индексация страниц сайта, зачем она нужна, как ускорить этот процесс. Поговорим теперь, как спрятать от проверки информацию на страницах и зачем это делать. Обычно запрет на сканирование ботами ПС устанавливают, чтобы скрыть от публичного просмотра технические и служебные страницы, конфиденциальную информацию, ресурсы в разработке, дубли и другое.

То есть, чтобы качественно продвигаться в поиске, нужно знать, какие данные показывать, а какие скрывать.

Поставить запрет на сканирование ботами можно несколькими способами:

- Использовать файл robots.txt. В документе можно запретить индексацию отдельной страницы, так и всего сайта целиком. Этот файл как раз и устанавливает правила для роботов ПС. Для запрета используются два основных оператора: указание адресата (User-agent) и запрещающая директива (Disallow), которая ставит «шлагбаум» для бота. Например, если сайт ещё не готов к запуску, то в роботсе можно прописать следующий код: User-agent: * и на следующей строке Disallow: /. Так вы закроете весь ресурс для роботов ПС.

- Прописать специальные теги в файле robots.txt. Обычно этот вариант используется для скрытия одной страницы от сканирования. Используются теги noindex и nofollow, которые запрещают ботам ПС проверять страницу или часть контента. Например, можно запретить работу конкретного бота следующим кодом: <meta name=»googlebot» content=»noindex, nofollow»/>.

На что влияет индексация?

Благодаря «прописке» в поисковых системах Яндекса и Гугла, сайты попадают в поле видимости пользователей и потенциальных клиентов. Сама по себе целевая страница в сети, онлайн-магазин или Landing Page не представляет ценности. Полезность её определяют посетители. Соответственно находясь в индексе и регулярно обновляя контент, ресурс растет в выдаче. Это увеличивает приток трафика и помогает развивать проект.

Роботы ПС оценивают не только качество контента, но и поведенческие факторы, посещаемость, вовлеченность. С помощью этих метрик определяется полезность сайта. Чем лучше поведенческие факторы аудитории, тем выше страницы в ранге.

Первые 20 строк поисковой выдаче собирают 95% всего трафика по запросу. Поэтому быть в индексе на хорошем счету у ПС – это гарантия успешного продвижения и высоких конверсий.

Резюме

Мы рассмотрели, что такое индексация сайта в поисковых системах Яндекс и Гугла. Изучили основные моменты добавления, проверки и ускорения «прописки» в ПС. Узнали, как и зачем выставлять запреты на сканирование страниц ботами. У индексации простая задача, но с далеко идущими последствиями – внести информацию о сайте в базу поисковых систем.

Почему сайт не в поиске: причины и способы проверки

Проверка индексации сайта через Яндекс Вебмастер и Google Search Console

Для того, чтобы проверить качество индексации страниц сайта, достаточно воспользоваться сервисами от двух поисковиков: Яндекс Вебмастер и Google Search Console. Каждая из этих панелей показывает количество находящихся в индексе страниц для своего поисковика (Яндекс и Google, соответственно).

Google Search Console

Зайдя в этот инструмент, на главной странице находим блок «Покрытие». В нем показывается график с количеством страниц сайта в индексе Гугла (зеленый график), и количество страниц, которые содержат ошибки (красный график). В таком виде удобно смотреть как добавлялись/удалялись страницы из индекса в определенный отрезок времени.

Из блока «Покрытие» есть возможность перехода в полный отчет. На отдельной странице будет показан график, количество ошибок, загруженных страниц без ошибок и исключенные страницы. Кликая по каждому из показателей, получаем графические данные по нему, а также списки самих URL-адресов.

Заходим в блок «Покрытие»

Просматриваем нужный отчет

Яндекс Вебмастер

Аналогичные возможность есть у Яндекс Вебмастера. Чтобы посмотреть проиндексированные страницы Яндексом, заходим в пункт «Индексирование – Страницы в поиске». Пролистав ниже, находим все страницы сайта, которые на текущий момент находятся в индексе.

Выбираем раздел «Индексирование – Страницы в поиске»

Список проиндексированных страниц

Инструмент позволяет просматривать исторические данные о том, как менялось количество проиндексированных страниц. Для этого вверху графика нажимаем «История», а внизу слева выставляем необходимый временной диапазон.

Анализируем историю индексации

Как видно из примера, сайт выпадал из индекса полностью, но через какое-то время вернулся вновь.

Почему сайт может выпасть из индекса? Причины и их решения

Причин, по которым сайта нет в поиске, может быть множество, рассмотрим основные.

Новый сайт или страница

Процесс индексации представляет собой сканирование поисковым краулером документов сайта. После чего данные обрабатываются, а уже после появляются (или не появляются) в поисковой выдаче. Обновление поисковой базы называется Update, и у каждого поисковика он происходит с разной скоростью. Поэтому если страницы недавно созданного сайта не отображаются в поиске, то чаще всего они еще просто не были проиндексированы.

Отсутствие запрета на индексацию сайта

Закрыть от индексации можно весь сайт, либо отдельные его документы. Поэтому вторым шагом по поиску причины отсутствия сайта в индексе, будет проверка файла robots.txt, находящегося в корне файловой системы.

Данный файл открывается с помощью любого текстового редактора, в нем должны отсутствовать следующие строки:

Блок на весь сайт User -agent: * Disallow: / Или для отдельных страниц: User-agent: * Disallow: /page.html

Страницы могут быть закрыты от индексации посредством метатегов. Если известно, каких именно нет страниц в индексе, проверьте их вручную (либо с помощью автоматизированных инструментов, например, Screaming Frog SEO Spider) на наличие следующего метатега (он доступен только для Яндекса, Google его игнорирует):

<meta name="robots" content="noindex" />

Кроме этого, любой документ можно проверить на доступность поисковыми роботами в инструменте Яндекс Вебмастера: Индексирование – Анализ robots.txt. Вставляем в блоке «Разрешены ли URL?» адрес страницы и смотрим результат.

Проверяем отдельные URL на индексацию

Дублированный контент

Поисковые системы заинтересованы в том, чтобы их выдача была как можно более качественной, максимально отвечающей запросам пользователей. Нет смысла добавлять в поиск страницы, если их дубли уже есть в интернете.

Поэтому перед публикацией контента, особенно текстового, обязательно проверяйте его на уникальность, это можно сделать в следующих сервисах:

- Text.Googlebot» search_bot

Запрет в самой CMS

Это больше всего касается сайтов созданных на платформе WordPress, дело в том, что в админке этого движка есть настройка запрета индексации сайта, и даже если в Robots.txt индексация открыта, то сайт индексироваться не будет. Важно проверить что галочка в данном разделе снята и индексация разрешена.

WordPress — проверка запрета индексацииОтсутствие четкой структуры сайта

Весь контент на сайте должен находиться в структурированном виде, на различных уровнях вложенности (Главная – Категория – Подкатегория – и т.д.). Причем не рекомендуется создавать уровни вложенности более 5. Если эти два правила не соблюдаются, то процесс индексации может затянуться по времени, особенно, если страниц на сайте много.

Страница или сайт недоступны

Сайт и его страницы должны быть доступны как посетителям, так и поисковым краулерам, и отдавать код 200. По разным причинам, этот код может отличаться:

- 4xx – документ недоступен по текущему адресу. Не рекомендуется удалять страницы, находящиеся в индексе поисковика, т.к. это может негативно сказать на ранжировании сайта. Лучше сделать 301-редирект (перенаправление) с удаленной страницы на другую релевантную.

- 5xx – сервер не в состоянии выполнить запрос.

Чтобы проверить код ответа сервера, заходим в одноименный инструмент в Яндекс Вебмастере.

Инструмент для просмотра кода ответов сервера

Пример отчетаНа сайт наложены фильтры

Если сайт или его страницы резко выпали из индекса, скорее всего, был наложен фильтр со стороны поисковой системы. Проверить на наличие некоторых фильтров можно в панелях вебмастеров.

В Google Search Console заходим в пункт «Меры, принятые вручную». Если на сайт применена какая-либо санкция со стороны сотрудников Google, то эта информация будет доступна здесь.

Google Search ConsoleАвтоматически наложенные санкции не отображаются в панели, но их можно обнаружить по косвенным признакам.

Проблемы с Яндексом также частично отображаются в Вебмастере на странице «Сводка».

Проблемы сайта в Яндекс.ВебмастереВот список некоторых действий, которые могут привести к санкциям со стороны поисковиков:

- Неадекватное наращивание внешней ссылочной массы. Поисковики не любят манипулирование факторами ранжирования, поэтому при обнаружении накладывают фильтры, понижая сайт в результатах выдачи, либо вовсе удаляют его (или отдельно взятые страницы) из индекса. Фильтры: Минусинск и Пингвин.

- Низкокачественный или неуникальный контент. Фильтры: АГС, Panda, Баден-Баден.

- Переоптимизация контента. Недопустимо превышать порог 3-5% плотности ключевых слов, а также использовать вхождения в неестественном виде (например, «купить квартира Москва»).

- Накрутка поведенческих факторов, например, фейковые посещения сайта.

Сайт заблокирован государственными органами

В РФ действует закон, запрещающий распространение определенного типа контента в интернете. За это (кроме уголовного преследования), возможна блокировка сайта по решению ряда государственных органов: Роскомнадзора, Ген. Прокуратуры, МВД, Роспотребнадзора и т.д.

Эта причина блокировки одна из самых явных, т.к. при посещении сайта пользователь получает всю информацию со ссылками на федеральный закон.

Блокировка сайтаНебольшой список материалов, которые подлежат такой блокировке:

- Информация о способах изготовления и т.д. наркотических веществ.

- Антиправительственная информация, по типу организации митингов, призывы к массовым беспорядкам и т.д.

- Описание способов совершения самоубийств.

- И прочее.

Дублированный контент внутри сайта

Если на сайте появляются страницы-дубли, то часть из них выпадет из индекса. Причем может случиться так, что выпадет именно целевая страница.

Дубли чаще всего появляются в силу специфики работы CMS, когда одна и та же страница доступна по разным адресам, но для поисковика это разные документы. Чтобы этого избежать, рекомендуется изучить подобные нюансы используемой CMS и настроить ее таким образом, чтобы дубли не появлялись (например, установив плагин), либо с них было перенаправление (301-редирект) на основную страницу.

В рамках данной статьи мы рассмотрели основные причины, по которым сайт может выпасть из поиска. Определив и решив их, после одного или нескольких Update поисковой базы, страницы сайта вернутся в органическую выдачу.

Статистика сканирования — Вебмастер. Справка

Робот-индексатор Яндекса регулярно сканирует страницы сайта и загружает их в поисковую базу. Робот может не загрузить страницу, если она недоступна.

Яндекс.Вебмастер позволяет узнать, какие страницы вашего сайта сканирует робот. Вы можете просмотреть URL-адреса страниц, которые робот не смог загрузить из-за недоступности сервера хостинга или из-за ошибок в содержании страницы.

Информация о страницах доступна в Яндекс.Вебмастер на странице. Информация обновляется ежедневно в течение шести часов после посещения страницы роботом.

По умолчанию сервис предоставляет данные по сайту в целом. Чтобы просмотреть информацию об определенном разделе, выберите его из списка в поле URL сайта. Доступные разделы отражают структуру сайта, известную Яндексу (кроме разделов, добавленных вручную).

Если в списке нет страниц, которые должны быть включены в результаты поиска, воспользуйтесь инструментом «Переиндексировать страницы», чтобы сообщить о них Яндексу.

Вы можете скачать информацию о страницах в формате XLS или CSV с помощью фильтров.

Примечание. Данные доступны с 20 февраля 2017 года.

- Динамика состояния страниц

- Изменения страниц в поисковой базе

- Список страниц, просканированных роботом

- Фильтрация данных

Информация о странице представлена в следующем виде:

Новые и измененные — количество страниц, просканированных роботом в первый раз, и страниц, статус которых изменился после того, как они были просканированы роботом.

Статистика сканирования — количество страниц, просканированных роботом, с кодом ответа сервера.

Изменения отображаются, если код ответа HTTP изменился, когда робот снова обратился к странице. Например, 200 OK превращается в 404 Not Found. Если изменилось только содержание страницы, в Яндекс.Вебмастере это не отобразится.

Чтобы просмотреть изменения, установите параметр «Последние изменения». Может отображаться до 50 000 изменений.

Яндекс.Вебмастер показывает следующую информацию о страницах:

Дата последнего посещения страницы роботом (дата сканирования).

Путь к странице из корневого каталога сайта.

Код ответа сервера, полученный при сканировании.

На основе этой информации вы можете узнать, как часто робот просматривает страницы сайта. Вы также можете увидеть, какие страницы были только что добавлены в базу данных, а какие были повторно просканированы.

- Страницы, добавленные в базу поиска

Если страница просматривается в первый раз, в столбце «Была» отображается статус «Н / д», а в столбце «Текущий» отображается ответ сервера (например, 200 OK).

После успешной загрузки страницы в базу данных поиска она может отображаться в результатах поиска после обновления базы данных поиска. Информация о нем отображается в разделе «Страницы в поиске».

- Страницы, переиндексированные роботом

Если робот просканировал страницу раньше, статус страницы может измениться при повторном сканировании: в столбце Was отображается ответ сервера, полученный во время предыдущего посещения, в столбце Current отображается ответ сервера получено во время последнего сканирования.

Предположим, что страница, включенная в поиск, стала недоступна для робота. В этом случае он исключается из поиска. Через некоторое время вы можете найти его в списке исключенных страниц в разделе «Страницы в поиске».

Страница, исключенная из поиска, может оставаться в базе данных поиска, чтобы робот мог проверить ее доступность. Обычно робот запрашивает страницу до тех пор, пока на нее есть ссылки, и это не запрещено в файле robots.txt.

Чтобы просмотреть список страниц, установите для параметра значение Все страницы.Список может содержать до 50 000 страниц.

Вы можете просмотреть список страниц сайта, просканированных роботом, и следующую информацию о них:

Дата последнего посещения страницы роботом (дата сканирования).

Путь к странице из корневого каталога сайта.

Код ответа сервера, полученный при последней загрузке страницы роботом.

Вы можете фильтровать информацию о страницах и изменениях в поисковой базе по всем параметрам (дате сканирования, URL страницы, коду ответа сервера) с помощью значка. Вот несколько примеров:

- По ответу сервера

Вы можете создать список страниц, которые робот просканировал, но не смог загрузить из-за ответа сервера 404 Not Found.

Вы можете фильтровать только новые страницы, которые были недоступны для робота.Для этого установите переключатель в положение «Последние изменения».

Также вы можете получить полный список страниц, которые были недоступны для робота. Для этого установите переключатель в положение Все страницы.

По фрагменту URLВы можете создать список страниц с URL, содержащим определенный фрагмент. Для этого выберите из списка Содержит и введите фрагмент в поле.

По URL-адресу с использованием специальных символовВы можете использовать специальные символы для соответствия началу строки или подстроки и устанавливать более сложные условия с помощью регулярных выражений.Для этого выберите совпадения URL-адресов из списка и введите условие в поле. Вы можете добавить несколько условий, поместив каждое из них в новую строку.

Для условий доступны следующие правила:

Символы, используемые для фильтрации Символ Описание Пример * Любое количество символов Соответствует любому количеству символов Показать данные для всех страниц, начинающихся с https: // example.com / тариф /, включая указанную страницу:

/ тариф / *- Использование символа *

Символ * может быть полезен при поиске URL-адресов, содержащих два или более определенных элемента.

Например, вы можете найти новости или объявления за определенный год:

/ news / * / 2017/.@ Отфильтрованные результаты содержат указанную строку (но не обязательно строго соответствуют ей) Отображение информации для всех страниц с URL-адресами, содержащими указанную строку: @tariff~ Условие — регулярное выражение Отображение данных для страниц с URL-адресами, соответствующими регулярному выражению.Например, вы можете отфильтровать все страницы с адресом, содержащим фрагмент ~ таблица | диван | кровать, повторяющийся один или несколько раз.! Отрицательное условие Исключить страницы с URL-адресами, начинающимися с https://example.com/tariff/: ! / Тарифа / *Использование символов не чувствительно к регистру.

Символы @,!, ~ Можно использовать только в начале строки. Доступны следующие комбинации:

Оператор Пример ! @ Исключить страницы с URL-адресами, содержащими тариф: ! @Tariff4 причины, по которым Яндекс.Веб-мастер необходим для вашего веб-сайта

Яндекс.Вебмастер — это набор инструментов, аналогичных инструментам Google для веб-мастеров, с множеством функций, которые позволяют веб-мастерам и владельцам сайтов проверять статус индексации и оптимизировать видимость своих веб-сайтов в Яндексе. Некоторые функции, такие как отправка и проверка карты сайта или создание и проверка файла robots.txt, также доступны в GWT, а некоторые другие доступны только для Яндекса, что делает Яндекс.Вебмастер неотъемлемой частью инструментария любого SEO-менеджера.Давайте посмотрим!

1. Связь с Яндексом

Яндекс — ведущая поисковая система в России, и, следовательно, если вы хотите добиться успеха в привлечении органического трафика на свой российский сайт, вам лучше прислушаться к тому, что он вам скажет. Через Яндекс.Вебмастер владельцы сайта получают:

Общие сообщения

Яндекс часто дает советы по оптимизации сайта, изменения алгоритма и другую полезную информацию. Вы также получаете уведомления о новых пользователях, присоединяющихся к вашей учетной записи, о новых сайтах, связанных с вашей учетной записью, и т. Д.

Предупреждения о безопасности

Если сайт был взломан или на нем было обнаружено другое вредоносное ПО, Яндекс уведомляет владельца через Яндекс.Вебмастер. Эта функция может оказаться очень полезной и помочь выявить проблемы на ранней стадии, поскольку обнаружение вредоносных программ Яндексом лучше, чем у Google или Norton.

Количество страниц в поисковом индексе

В отличие от Google, который почти постоянно обновляет результаты поиска и повторно сканирует сайты, Яндекс обновляет поисковый индекс еженедельно или раз в две недели.За обновлениями можно следить с помощью различных инструментов, и когда происходит большое обновление, обычно полезно проверить, что произошло с позициями сайта, а также количеством проиндексированных страниц.

Если к сайту применен фильтр или штраф, эффект обычно виден после обновления индекса поиска.

Изменение ТИЦ

TIC (тематический индекс цитирования) — это оценка, которую Яндекс присваивает всем веб-сайтам аналогично Page Rank в Google. Яндекс регулярно обновляет ТИЦ, и за обновлениями легко следить через Яндекс.Веб-мастер.

2. Управление появлением в поиске

Яндекс предоставляет множество возможностей для создания привлекательных сниппетов поисковой выдачи. Некоторые элементы должны быть добавлены разработчиками (например, микроформаты), а другие можно настроить через Яндекс.Вебмастер:

URL-адрес

Для длинных доменов Яндекс дает возможность использовать некоторые буквы с большой буквы, чтобы доменное имя было более читабельным. Например, russiansearchmarketing.com может отображаться в поисковой выдаче как RussianSearchMarketing.com.

Дополнительные ссылки

В отличие от Google, Яндекс дает довольно много контроля над органическими дополнительными ссылками. Через Яндекс.Вебмастер можно изменить текст дополнительных ссылок или удалить дополнительные ссылки, которые не актуальны.

Интерактивные фрагменты — «Острова»

Около 1,5 года назад Яндекс представил новый макет поисковой выдачи с интерактивными сниппетами под названием Яндекс.Острова. Идея «островов» состоит в том, чтобы приблизить к пользователю наиболее важную информацию и упростить поиск решений проблем пользователей, отвечая на их вопросы быстрее, прямо в результатах поиска.Дизайн «острова» может варьироваться от очень простого — например, кнопка или поле поиска — до довольно сложного, например, формы подачи заявки или даже системы бронирования.

«Острова» необходимо отправить через Яндекс.Вебмастер.

3. Настройка региональной принадлежности

Яндекс, как и Google, показывает результаты локального поиска в разных регионах России. Чтобы Яндекс определил правильный регион для вашего сайта, вы можете воспользоваться настройками «География сайта» в Яндекс.Вебмастере.

Региональные настройки важны, если вы работаете с так называемыми «геозависимыми» поисковыми запросами, такими как «французский ресторан», «доставка пиццы», другими словами, с продуктами и услугами, которые можно приобрести на месте.

4. Утверждение авторства текста

Как я писал в одном из своих предыдущих постов, Яндекс предоставляет в Яндекс.Вебмастере функцию «оригинальные тексты», которая позволяет владельцам контента сообщать Яндексу о своем авторстве. Заявление об авторстве чрезвычайно важно для всех, но особенно для недавно запущенных сайтов, поскольку это сводит к минимуму возможность того, что пираты контента будут ранжироваться выше оригиналов.

Яндекс.Вебмастер — один из важнейших инструментов поисковой оптимизации Яндекса. Если у вас еще нет учетной записи, обязательно включите ее в свой набор инструментов SEO в 2015 году.

Google. Это наиболее широко используемая поисковая система, и для многих это первое, что люди каждый день вводят в свои веб-браузеры. Однако это не единственная поисковая система, которую используют люди. По данным Alexa, Baidu — четвертый по популярности веб-сайт (первое место в рейтинге Google).Фактически, Китай занимает третье место по численности пользователей Интернета (731 миллион в 2016 году), поэтому неудивительно, что Baidu занимает такое высокое место.

Для веб-сайтов (крупных корпоративных веб-сайтов) не редкость иметь международную аудиторию, поэтому для любого, кто думает о SEO, важно знать обо всех основных поисковых системах.

Обладая различными функциями и возможностями, каждый сканер поисковой системы настроен для работы с совершенно разным темпом и способностями, часто с совершенно другой конечной целью (удобство для мобильных устройств, авторитетность веб-сайта и т. Д.).

Итак, когда вы оптимизируете аудиторию, например, в России, вы должны думать, как российские поисковые системы (в данном случае Яндекс!).

Общий взгляд на поисковые системы по всему миру

Google: поисковая система с большей долей рынка

Ларри Пейдж и Сергей Брин основали Google в 1998 году, и это, безусловно, самая широко используемая поисковая система с долей рынка около 90%. Google использует наибольшее количество точек данных для индексации и ранжирования страниц в Интернете, что делает его алгоритмы одними из самых сложных среди любой поисковой системы.Некоторые из основных факторов, которые принимаются во внимание, включают техническое состояние вашего веб-сайта, внешний авторитет (обратные ссылки), удобство для мобильных устройств и, что наиболее важно, качество контента. Сканер Google также очень продвинутый — он способен обрабатывать JavaScript и сканировать миллиарды страниц каждый день.

На приведенном ниже графике показаны URL-адреса, просканированные Google на определенном веб-сайте. Чтобы проиллюстрировать различия между каждой поисковой системой и ее возможностями, все графики представляют один и тот же веб-сайт за один и тот же период времени с ежедневным просмотром.

В этом примере Google сканирует около 1–2 млн новых URL-адресов в день. Объем сканирования превышает количество просканированных URL-адресов, а это означает, что ваши страницы можно сканировать несколько раз в день (Woohoo!). Вы можете проверить, как часто Google сканирует ваши страницы, в Google Search Console или непосредственно на платформе Botify.

Как вы гарантируете, что Google сканирует и индексирует ваши новые страницы?

Есть несколько способов увеличить скорость сканирования, чтобы Google сканировал и индексировал ваши новые страницы.Например, вы можете сократить время загрузки своего сайта (и, как результат, улучшить свой UX — победа, победа!) И отправить обновленную карту сайта, указав в первую очередь самые важные новые URL-адреса.

После того, как вы предприняли шаги, чтобы заставить Google сканировать ваши новые URL-адреса, вы можете использовать такой инструмент, как Botify Log Analyzer, чтобы узнать, происходит ли это на самом деле (например, действительно ли Google сканирует мои URL-адреса? Как часто?).

Кроме того, новый и улучшенный сканер JavaScript от Botify позволит вам точно увидеть, как поисковые системы обрабатывают JavaScript на вашем веб-сайте.Они могут сканировать ваши новые URL-адреса, но видят ли они весь ваш контент?

Эти и многие другие аспекты помогут вам определить, будут ли сканироваться ваши новые страницы и когда, и помогут направить ботов в правильном направлении.

Bing: поисковая система Microsoft

Microsoft запустила Bing в 2009 году, и по данным на 2017 год, она занимала около 9% мирового рынка и 33% в США.

Подобно Google, Bing имеет ключевые отличия в способах сканирования, индексации и ранжирования веб-страниц.

Ключевые различия между Google и Bing

- Рейтинг: Алгоритмы ранжирования Bing используют некоторые из тех же факторов, что и Google, например обратные ссылки и удобство для мобильных устройств, но оценивают их иначе, чем Google — обратные ссылки кажутся гораздо более важными для ранжирования в Bing, чем в Google, в то время как удобство для мобильных устройств в Google важнее, чем Bing.

- JavaScript: Bing утверждает, что обрабатывает JavaScript, но по нашему опыту мы видели несколько примеров этого.К счастью, Microsoft недавно объявила, что Bingbot становится вечнозеленым. Bing внедряет Microsoft Edge для запуска JavaScript и отображения страниц, а Microsoft Edge скоро перейдет на Chromium (проект с открытым исходным кодом, на котором основан Google Chrome). Это изменение позволит Bingbot получить доступ к функциям Chromium и будет продолжать использовать новые функции, доступные с каждым обновлением. Это не только выигрыш для оптимизаторов, работающих с JavaScript, но и упрощает совместную оптимизацию веб-сайтов для Bing и Google без необходимости устранять неполадки друг с другом.Ознакомьтесь с нашей статьей об обновлении строки пользовательского агента Googlebot, чтобы узнать больше о том, что вечнозеленый бот может изменить для SEO.

- Приоритет сканирования: Bingbot определяет приоритеты URL-адресов, просматривая внутренние ссылки и карты сайта, в то время как робот Googlebot использует множество других факторов. Кроме того, Bingbot иногда попадает в «ловушки сканирования», такие как фасетная навигация и URL-адреса внутреннего поиска.

- Объем сканирования: Как показано ниже, объем сканирования Bing почти соответствует количеству просканированных URL (это означает, что вместо того, чтобы сканировать URL несколько раз, он сканирует их только один раз или гораздо реже).Между тем, количество просканированных новых URL-адресов остается очень низким, что затрудняет быстрое проиндексирование новых важных страниц.

Но у нас большие новости!

На нашей недавней конференции Crawl2Convert в Нью-Йорке мы были очень рады, что Фабрис Канель, главный менеджер программы Bing, представил новый API Bing, который поможет вам мгновенно проиндексировать новейшие страницы. Более того, API будет напрямую интегрирован в платформу Botify! Эта интеграция будет запущена в соответствии с FastIndex, компонентом активации Botify, который позволит клиентам Botify создавать полностью оптимизированные карты сайта.Вы сможете увеличить ежедневные лимиты отправки и быстро проиндексировать свои страницы — с помощью FastIndex и Bing API.

Baidu: основная поисковая система Китая

Baidu — доминирующая поисковая система, используемая в Китае. Он похож по размеру и масштабу на Google в США и напоминает Google по своим инвестициям. Например, как и Google, Baidu инвестировала в машинное обучение, чтобы улучшить свои алгоритмы ранжирования.

В отличие от этого, Baidu обладает огромной способностью сканировать.Вместо того, чтобы полагаться на такие сигналы, как канонические, для определения приоритетов сканирования и индексирования, Baidu обычно может сканировать все и самостоятельно решать, что следует индексировать.

Кроме того, в Китае большое внимание уделяется мобильным устройствам, поэтому результаты мобильного поиска Baidu могут сильно отличаться от результатов поиска Baidu для настольных компьютеров. Мобильная связь является таким приоритетом в Китае, что Baidu даже создает мобильные версии веб-сайтов только для настольных компьютеров на лету.

Baidu также имеет инициативу, аналогичную Google AMP.Инициатива Baidu, подобная AMP, началась просто как MIP (Mobile Instant Pages), после чего была представлена новая, более утилитарная платформа под названием Bear Paw (названная в честь логотипа Baidu). В 2018 году Baidu объявила, что будет направлять 50% своего мобильного трафика на страницы BP.

Объем сканированияBaidu почти эквивалентен количеству просканированных URL-адресов, поэтому шансы на то, что ваши страницы будут сканироваться чаще, чем раз в неделю, невелики. Однако он сканирует новые URL-адреса с высокой скоростью, что отлично подходит для быстрой индексации ваших новых URL-адресов, вместо того, чтобы ждать несколько дней или недель для индексации.Кроме того, сканер Baidu может обрабатывать JavaScript, хотя и выборочно.

П.С. Хотя Google China действительно существует, он был заблокирован для материкового Китая в 2010 году и доступен только в Гонконге. Итак, если у вашего веб-сайта много посетителей из Китая, они, скорее всего, ищут и находят вас через Baidu!

Яндекс: главная поисковая система России

Яндекс — популярная поисковая система в России, а также крупнейшая технологическая компания страны.Из поисковых систем в Азии Яндекс наиболее сопоставим с Bing. Многие традиционные приемы SEO, такие как создание обратных ссылок и создание статей, по-прежнему работают, но Яндекс не может приблизиться к масштабам других поисковых роботов. Поисковый робот фокусируется на новых и чрезвычайно важных URL-адресах, а не на частом сканировании всего веб-сайта. Следует отметить, что краулер не сканирует и не отображает JavaScript, что затрудняет ранжирование веб-сайтов на основе JS в Яндекс.

Как и Baidu, Яндекс обычно не сканирует URL-адреса более одного раза в заданный период времени.Тем не менее, он сканирует изрядное количество новых URL-адресов (примерно 50 КБ в день!), Что оптимистично для веб-сайтов с новыми веб-страницами, требующими индексации.