Для чего нужна видеокарта, устройство видеокарты компьютера на примере GeForce 9600 GT

Видеокарта является очень важным компонентом в системе, наверное вторым по важности после процессора. Но почему это именно так? Вообще, для чего нужна видеокарта? Приглашаю вас вместе со мной разобраться в этих вопросах, все ответы обязательно будут далее по тексту.

Открою секрет тем, кто еще не знает — абсолютно в каждом компьютере есть видеокарта. Объясняется это тем, что без нее просто немыслима работа за компьютером. Дело в том, что, как вы уже наверное догадались, видеокарта отвечает за формирование изображения на мониторе компьютера. Без нее мы с вами просто-напросто сидели бы и «втыкали» в пустой ничего не показывающий монитор, причем остальная часть устройств компьютера при этом бы стабильно продолжала работать.

Иными словами получается, что если убрать из системы видеокарту, ничего страшного не произойдет, все будет работать и это никак не отразится на работе компьютера в общем. Это с технической точки зрения. Но с точки зрения нас с вами, отсутствие видеокарты на 100% лишает нас возможности вообще хоть как-то работать на таком компьютере. И поэтому видеокарта по важности идет следом за процессором (без процессора комп даже не включится).

Чтобы понять что это за «зверь» такой — видеокарта и где он «живет», предлагаю заглянуть внутрь системного блока компьютера.

Видеокарта (зеленая стрелка) состоит из множества компонентов и представляет собой печатную плату, на которой эти компоненты размещены. Итак, что же это за компоненты такие? У меня на руках старенькая 9600 GT от известной фирмы-производителя. Думаю, можно использовать ее в качестве примера для наглядного описания компонентов, поскольку в конструктивном плане все современные графические карты (видеокарты) идентичны — различаются только некоторые моменты, такие как: расположение отдельных чипов, их количество и т.д. Иными словами, далее по тексту пойдет объяснение базовой структуры (

Графический процессор (зеленая стрелка) — главный компонент (сердце) видеокарты. Именно от него зависят большинство характеристик видеокарты, производительность — в первую очередь. Графический процессор является еще и самым горячим компонентом любой видеокарты. Занимается расчетами выводимого на монитор изображения, разгружая при этом центральный процессор (у которого и своих обязанностей хватает). Участвует в расчетах для построения трехмерной графики. Современные графические процессоры (GPU) по сложности мало чем отличаются от центрального процессора компьютера (CPU). Не секрет, что число транзисторов в процессоре играет далеко не последнюю роль, так вот графический процессор видеокарты в большинстве случаев превосходит центральный процессор, как по количеству транзисторов, так и по вычислительной мощности. Достигается это, как правило благодаря большому числу универсальных вычислительных блоков.

Видеоконтроллер — формирует картинку в памяти видеокарты, а так же отсылает информацию на ЦАП (цифро-аналоговый преобразователь) относительно развертки монитора, занимается обработкой запросов центрального процессора компьютера. Содержит в себе несколько контроллеров: контроллер внешней шины данных (PCI или AGP), контроллер внутренней шины данных и контроллер памяти видеокарты. Так как к большинству современных видеокарт можно одновременно подключить сразу несколько мониторов, видеокарты содержат в себе сразу несколько видеоконтроллеров, каждый из которых управляет одним или несколькими дисплеями.

Видеопамять (желтые рамки) — выполняет роль некоего буфера, в который поступает изображение с графического процессора через видеоконтроллер. По своей сути очень схожа с оперативной памятью компьютера. В видеопамяти также хранятся промежуточные кадры, невидимые на мониторе элементы изображения и другие данные. Видеопамять бывает нескольких типов, различающихся по частоте и скорости доступа. Если говорить про современные видеокарты, все они могут оснащаться памятью типа GDDR3, GDDR4, GDDR5. Объем памяти тоже может быть разный, как правило от 1-4 Гб.

Сами чипы видеопамяти находятся вблизи графического процессора и располагаются вокруг него — и это не случайно. Смысл в том, что чем ближе находятся чипы видеопамяти к GPU, тем быстрее он с ними может взаимодействовать, за счет этого повышается его тактовая частота. Следует иметь ввиду, что помимо видеопамяти, современные графические процессоры обычно используют часть системной (ОЗУ) памяти компьютера, доступ к которой организуется драйвером видеокарты через шину AGP (которая уже устарела) или PCI-E.

Коннекторы (видеовыходы) — служат для подключения монитора(ов) к компьютеру. На приведенной ниже фотографии их три, значит к видеокарте одновременно можно подключить три монитора. Как вы понимаете, выходов может быть значительно больше — все зависит от стоимости видеокарты.

Сейчас не будем останавливаться на характеристиках каждого из них, это тема отдельной статьи, а просто перечислим их — D-Sub (окрашен в синий цвет), HDMI (слева), DVI, DisplayPort (которого нету на данной видеокарте). Это все были основные выходы, отвечающие за вывод картинки на монитор. Но существуют и другие — коннекторы системы питания и охлаждения видеокарты. Например так выглядит коннектор системы охлаждения видеокарты, при условии, что она представлена в виде вентилятора (активная система охлаждения).

Через этот коннектор и далее по проводу подается напряжение на моторчик кулера, заставляя его вращаться. И через него же можно управлять скоростью вращения кулера. И как уже было сказано выше, есть еще один разъем — разъем дополнительного питания видеокарты. Все современные видеокарты им оснащаются в обязательном порядке, ибо потребляемая мощность этих видеокарт весьма и весьма высокая. Если на видеокарте нет такого разъема, как в случает с 9600 GT — мощность потребляется через интерфейс PCI-E x16, который способен «выдавать» до 75 Вт, если мне не изменяет память.

Если взглянуть на обратную сторону видеокарты, можно увидеть отверстия под винты крепления системы охлаждения графического процессора. Больше ничего интересного здесь вы не найдете.

Принцип работы видеокарты

Ну а теперь предлагаю обобщить все вышесказанное в некую последовательность, которая будет объяснять принцип работы видеокарты.

До того, как стать изображением на мониторе, цифровые данные в виде двоичного кода (0 и 1) обрабатываются центральным процессором компьютера, после чего они через шину данных направляются в видеокарту, где еще раз обрабатываются, преобразуются в аналоговый сигнал, который направляется на монитор. Это если кратко. Ну а если поподробней — сначала данные из шины данных попадают в графический процессор, где они обрабатываются. После чего эти обработанные цифровые данные через видеоконтроллер поступают в видеопамять видеокарты, где создается некий образ изображения, которое должно выводиться на мониторе. Следующим этапом — будет передача этих данных в RAMDAC (цифро-аналоговый преобразователь), где они преобразуются в аналоговый вид и уже в таком виде поступают на монитор.

Кстати, по поводу RAMDAC — сейчас все реже и реже на видеокартах встречается аналоговый выход (D-Sub), поэтому прошу тех, кто дочитал до этого момента (Вы молодец) указать в комментариях свое мнение на тот счет, нужен ли RAMDAC видеокартам, которые имеют только цифровые выходы (HDMI, DVI, DP). Ведь если главной функцией RAMDAC является кодирование данных из цифрового сигнала в аналоговый сигнал, то в случае с цифровыми выходами кодировать нечего и соответственно необходимость в RAMDAC отпадает. Прошу поделиться тех кто знает информацией на этот счет. Заранее спасибо.

Как работает видеокарта? Часть 1. Компоненты и взаимодействие. / zremcom.com

|

Графические карты берут данные от центрального процессора и преобразуют их в изображения. |

Изображения, которые вы видите на своем мониторе, сделаны из крошечных точек, названых пикселями. В большинстве имеющихся на сегодняшний день мониторах настройки разрешения экрана позволяют показывать более чем миллион пикселей, и компьютер должен решать, что же делать со всеми ими, чтобы создать изображение. Для выполнения этой задачи и были разработаны видеокарты, так сказать переводчики – которые берут двоичные данные от центрального процессора и превращают их в картинку, которую мы и видим на экранах своих мониторов. Почти все современные материнские платы оснащены встроенным видеоконтроллером, который хоть и способен преобразовывать графические данные, все же не сможет обеспечивать хорошую производительность в видеоиграх и 3D приложениях. Поэтому чтобы обеспечить качественную и количественную частоту кадров в секунду – высокое разрешение и скорость используют графические карты, подключаемые к материнской плате отдельно.

Работа графической карты сложна, но её принцип, и компонентный состав легко понять. В этой статье рассмотрим основные части видеокарты и их функции в процессе работы.

Давайте представим, что компьютер это компания, в штате которой состоит собственный художественный отдел. Когда люди в компании хотят получить иллюстрации или художественные работы, они посылают запрос художественному отделу. Художественный отдел решает, как создать изображение затем рисует его на бумаге, т.е. идея становится фактической, видимой картиной.

Развитие Видеокарт. Видеокарты проделали длинный путь. |

Графическая карта работает подобно тем же принципам, что и наша компания. Центральный процессор, работающий в связке с программным обеспечением, посылает информацию об изображении на видеокарту. Видеокарта решает, как расположить пиксели на экране, чтобы создать правильное изображение. После чего она посылает подготовленную информацию на монитор через соединительный кабель.

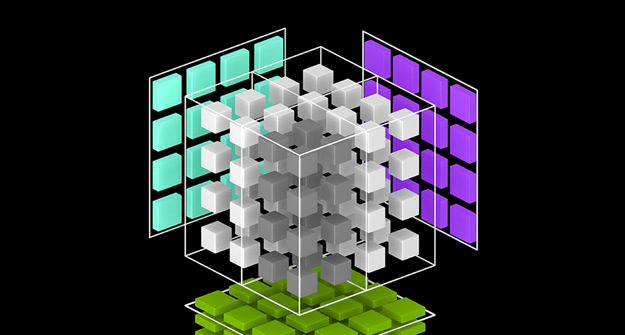

Создание изображения из двоичных данных является достаточно требовательным процессом. Например, чтобы сделать 3-х мерное изображение, графическая карта в первую очередь создает структуру изображения из прямых линий, затем проводит растрирование (заполнение пикселями), изображения, добавляет освещение, структуру и цвет. Для быстро изменяющихся видеоигр компьютер должен пройти этот процесс приблизительно шестьдесят раз в секунду. Без графической карты, чтобы выполнить необходимые вычисления, нагрузка на процессор была бы слишком большой, что бы приводило к зависанию картинки на мониторе, или другим системным сбоям.

Для выполнения своей функции графическая карта, использует четыре основных составляющих её компонента:

- Порт соединения с материнской платой (AGP, PCI-E) для передачи данных и управления.

- Процессор (GPU), чтобы решить, что сделать с каждым пикселем на экране.

- Память (VRAM), чтобы держать информацию о каждом пикселе и временно хранить сформированные изображения.

- Вывод на монитор (VGA, DVI), чтобы видеть окончательный результат обработки.

В следующей статье рассмотрим работу графического процессора и памяти видеокарты более подробно.

Не играми едиными. Ускорение программ с помощью видеокарты | Видеокарты | Блог

Что такое видеокарта, знает каждый, ведь это главный элемент ПК, отвечающий за игры. И чем он мощнее, тем лучше. Однако в словосочетание «графический адаптер» вложено намного больше смысла. И кроме умения отапливать помещение и жрать электроэнергию «майнить» видеокарты способны ускорять работу некоторых полезных программ. В их число входят приложения для видеомонтажа, графического дизайна, 3D-моделирования, VR-разработок.

Техническая сторона вопроса

Обычно основная часть нагрузки ложится на центральный процессор. Но есть задачи, с которыми GPU справится во много раз быстрее, и было бы глупо этим не воспользоваться. Логично, что чаще всего это касается программ для работы с графикой, видео и 3D-моделированием.

Во время GPU-ускорения задействуется исключительно память видеокарты. Для простой работы с FHD достаточно 2 ГБ. Однако, когда один кадр компонуется из нескольких (картинка в картинке) или используются эффекты, одновременно обрабатывающие несколько кадров (шумодавы и т. д.), расход возрастает. Для UHD/4K-видео необходимо уже минимум 4 ГБ видеопамяти.

Конечный прирост производительности зависит от правильности настройки и общих параметров системы. В случае, например, рендеринга иногда разница с CPU составляет разы, а это сэкономленное время, которое, как известно, — деньги. Гарантировать точный результат ускорения не возьмется ни один производитель, ссылаясь на индивидуальность каждой системы.

Любая видеокарта в той или иной степени способна проводить сложные вычисления и обрабатывать графику. Больше других акцентирует внимание на неигровых возможностях и технологиях своих GeForce компания nVidia.

Тензорные ядра — присутствуют в адаптерах серии RTX, повышают производительность и энергоэффективность. Поддержка ИИ ускоряет расчеты и работу с графикой.

CUDA — проприетарная технология nVidia, доступная для устройств GTX и RTX. Позволяет использовать графический процессор для вычислений общего назначения, улучшает работу с фото, видео и 3D.

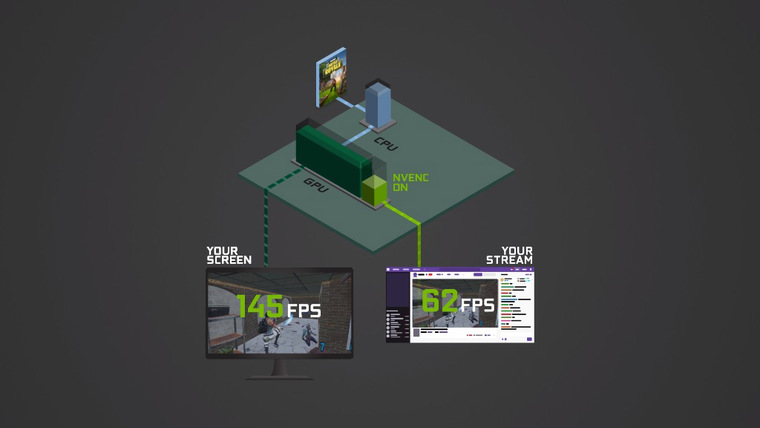

NVENC — отдельный аппаратный блок, способный кодировать и декодировать видеопоток. Благодаря этому разгружаются центральный и графический процессоры для запуска игр и других ресурсоемких задач. В первую очередь это интересно стримерам, но многие программы видеомонтажа уже приспособили NVENC под себя.

NVIDIA STUDIO DRIVER — выходит для видеокарт серии 10хх и моложе. Оптимизирует работу адаптера под такие приложения, как Autodesk Maya, 3ds Max, Arnold 5, DaVinci Resolve и т. д.

Карты AMD тоже хорошо справляются с вычислениями и обработкой графики, но любит говорить об этом исключительно компания Apple. AMD использует открытые технологии OpenGL и Vulcan — альтернативу CUDA.

Программы, работающие с GPU-ускорением

О возможности ускорения программы с помощью видеокарты можно узнать на официальном сайте. Все ведущие производители софта дают четкие инструкции, какая видеокарта подойдет и как включить GPU-ускорение. А первое, что приходит на ум, когда речь идет о работе с графикой и видео, — решения студии Adobe.

Adobe Premiere Pro использует вычислительные ресурсы видеокарт, начиная с версии CS5. Текущие версии для Windows поддерживают все современные GPU (включая встроенную графику Intel). CS6 и выше имеют функцию стабилизации видео Warp Stabilizer, которая устраняет дрожание камеры. Плагин использует GPU-ускорение только при финальном рендеринге изображения. Также в CS6 появился рендер Ray-traced 3D, который обсчитывает на видеокарте 3D-слои, камеру и источники света в композиции. Adobe Premiere CC научился работать одновременно с несколькими видеокартами, причем допускается использование разных серий и даже производителей (MultipleGPU). Выигрыш зависит от общей конфигурации ПК. Интересные возможности дает использование GPU сторонними плагинами. Можно ускорять Premiere при помощи CUDA одной видеокарты, при этом его плагин будет ускоряться OpenGL другой видеокарты. Такие плагины, как Magic Bullet Looks, Elements3D и т. п. могут использовать ресурсы GPU независимо от настроек Adobe. Подробные требования приложения к видеокарте можно найти на официальном сайте.

- Adobe After Effects предъявляет к видеокартам аналогичные с предыдущим клиентом требования.

Adobe Photoshop также активно использует видеокарты в процессе обработки изображений. Фоторедактор закрывает некоторые свои возможности, если видеокарта их не поддерживает. Яркими примерами таких функций являются «Деформация перспективы», «Умная резкость», «Размытие». Пользователю доступны три режима: базовый, обычный и расширенный. Наиболее интенсивно использует видеокарту последний. Если наблюдается снижение быстродействия, стоит переключиться на уровень ниже, воспользовавшись вкладкой Дополнительные параметры.

Кроме продукции компании Adobe нельзя не вспомнить такие программы, как 3ds Max, DaVinci Resolve и Vegas Pro.

Данные о поддержке наиболее адаптированных приложений производители видеокарт публикуют на своих официальных сайтах:

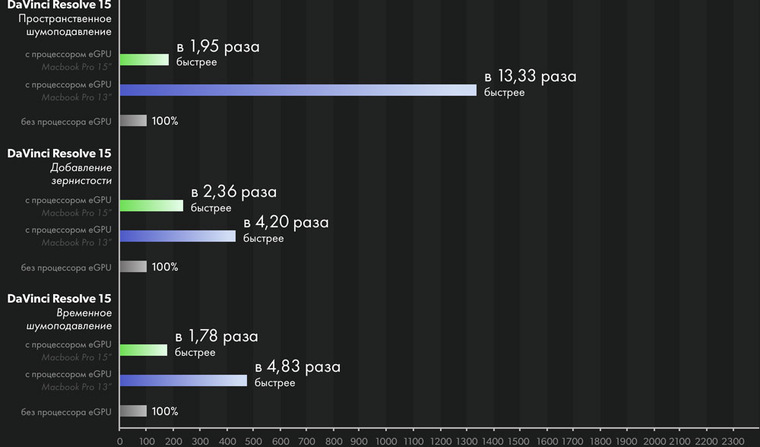

eGPU — внешний графический процессор

Этот раздел касается в первую очередь техники компании Apple. Купертиновцы любят делать упор на творческие возможности своих устройств, однако пользователи макбуков и аймаков ограничены исходной комплектацией. На помощь приходит eGPU — внешняя видеокарта, с помощью которой, по заявлению производителя, можно увеличить скорость обработки графики на Mac в несколько раз.

По сути, это обычная видеокарта в специальном боксе с блоком питания и дополнительным охлаждением. Она подключается к макам посредством Thunderbolt 3. Уже много лет Apple использует видеокарты AMD, и весь софт Apple затачивается под новый API Metal. Графические решения nVidia ощутимого прироста производительности на Apple не дают, так как из-за патологической жадности компании не смогли договориться, и весь софт на маке заточен исключительно под AMD. В отместку nVidia недавно полностью отменила поддержку CUDA на MacOS.

А что могут «профи»?

Есть заблуждение, что для работы с графикой нужно купить максимальную видеокарту, а процессор любой сойдет. Это не так. Если процессор не будет успевать давать задания видеокарте, пользователь столкнется с простоем в ресурсоемких задачах. Есть и обратная зависимость: слабая видеокарта может сдерживать процессор в финальном рендеринге. Важен баланс. Если потребности пользователя все же переросли возможности обычных моделей, можно направить свой взгляд на дорогие и узкоспециализированные решения. Технически профессиональные и потребительские видеокарты отличаются несильно, все дело в ПО.

Несколько лет назад компания nVidia выпустила первый TITAN — запредельную по производительности и цене игровую видеокарту. Но вместо того, чтобы стать нишевым продуктом, она была буквально сметена с прилавков. Оказалось, что карта прекрасно справляется с расчетами, и многие компании с удовольствием покупали ее вместо дорогих про-аналогов. Разумеется, nVidia быстро смекнула, в чем дело, и в начале 2018 года прикрыла лавочку запретила использовать графические процессоры GeForce и Titan в составе дата-центров. По словам nVidia, нельзя гарантировать их безотказную работу в жарких условиях (и это не фигуральный оборот) в режиме 24/7. В качестве альтернативы предлагается использовать, например, Tesla V100, который гораздо мощнее GeForce и стоит в десять раз больше создан специально для работы в условиях ЦоД.

nVidia имеет три линейки профессиональных видеокарт: Quadro, NVS и Tesla.

- Quadro — служит для рендеринга видео, производства VR/AR, 3D-моделирования. Быстрые и дорогие. Чтобы оправдать стоимость, производитель оснащает их самыми современными и совершенными разработками, которые появятся только в следующих сериях GeForce. Для очень богатых дизайнеров и инженеров.

NVS — многопортовые карточки, созданные для подключения большого количества мониторов в одну панель. Например, с их помощью в Макдональдсе можно выбрать бигмак с помидорами или беконом, а в аэропорте найти свой рейс. По сути, это самая обычная «затычка», на которой распаяли много портов. Очень слабые по железу и очень дорогие по соотношению цена/производительность, но ценят их не за FPS в Батле.

Tesla — узкоспециализированная и сверхдорогая линейка для математических и физических расчетов. Для работы требуется CPU. Портов нет, поиграть нельзя, расходимся пацаны.

Компания AMD в качестве профессионального решения предлагает серию Radeon Pro. Также у них есть вычислительные аналоги Tesla с космическим ценником под названием Instinct.

Как работает видеокарта?

Наверное, каждый пользователь компьютера или ноутбука когда-то слышал слово «видеокарта», а также его аналоги – «графический ускоритель», «графическая карта», «GPU» и т. д. Однако мало кто на самом деле понимает, что такое видеокарта и как она работает.

Давайте попробуем разобраться в данном вопросе.

Что такое видеокарта?

Видеокарта – это устройство, которое преобразует графический образ из памяти ПК или самой карты в форму, адаптированную для его демонстрации на экране монитора. То есть, проще говоря, все, что вы видите на мониторе, – это работа видеокарты.

Существует масса классификаций видеокарт, однако вне зависимости от прочих характеристик все их можно поделить на две группы – интегрированные (встроенные) и дискретные. Первые являются частью материнской платы или центрального процессора, вторые реализованы в виде отдельной платы, которая устанавливается в специальный слот материнской платы.

Интегрированные видеокарты хороши тем, что они доступны и не требуют от ПК много энергии. Однако у них, конечно, есть и серьезный минус – они не очень мощные, и встретить их можно в компьютерах и ноутбуках бюджетного класса.

Дискретная видеокарта дороже и потребляет много энергии, однако она отличается высокой производительностью, что очень важно для тех, кто часто играет в «тяжелые» 3D-игры.

Как работает видеокарта

Видеокарта – весьма сложное устройство, однако понять общий смысл ее работы нетрудно. Мы уже упоминали тот факт, что задача видеокарты – адаптация изображения. Каким же образом она происходит?

Центральный процессор ПК с помощью специального ПО отправляет видеокарте информацию о том, как должно выглядеть изображение, после чего она решает, в каком порядке необходимо расположить пиксели, дабы изображение получилось корректным. Чтобы создать 3D-изображение, сначала выстраивается структура из прямых линий, которая затем заполняется пикселями, а на последнем этапе формируется текстура, цветность и яркость изображения. Когда изображение сформировано, видеокарта отправляет его на монитор.

На словах этот алгоритм довольно длинен, однако в реальности он осуществляется с очень высокой скоростью. Чем мощнее видеокарта, тем выше скорость, ну а мощность видеокарты, в свою очередь, определяется параметрами, которые мы опишем ниже.

Основные параметры видеокарт

Интерфейс

Интерфейс видеокарты служит для обмена данными между 3D-ускорителем и центральным процессором. Сегодня основной стандарт обмена – шина PCI Express. Раньше использовался стандарт AGP, впрочем, в некоторых моделях он еще встречается. AGP и PCI-E – несовместимы, даже физические слоты для их установки в материнскую плату имеют разные размеры. А вот разные версии PCI-E совместимы, при этом чем старше версия, тем большую пропускную способность она имеет.

Тактовая частота

Тактовая частота видеокарты – определяющая характеристика производительности видеокарты. Чем частота выше, тем она мощнее, ну а чем мощнее видеокарта, тем более плавный и приятный интерфейс получает пользователь. Недостаточная мощь видеокарты особенно очевидна во время прохождения 3D-игр.

Объем видеопамяти

Объем видеопамяти – тоже важная характеристика производительности. Чем больше памяти, тем лучше. Однако, имеется некий предел, после которого размер памяти уже не влияет на производительность.

Тип видеопамяти

В настоящий момент применяется несколько типов видеопамяти. Чем современнее стандарт, тем выше скорость работы памяти. Самый быстрый на сегодня стандарт – GDDR5, однако память данного стандарта очень дорога, а потому наиболее востребован более доступный GDDR3. Стоит сказать, что, несмотря на доступность, видеокарта с памятью GDDR3 также очень быстрая.

Ширина шины памяти

Данный параметр оказывает влияние на пропускную способность и общую производительность видеокарты. Измеряется она значением бит/цикл, в видеокартах среднего ценового сегмента данное значение равно 128 бит/цикл, в топовых 256 бит/цикл и выше.

Версия Direct X

Direct X – это интерфейс программирования приложений, задача которого – обеспечение взаимодействия компьютера и программ. Также чем выше версия DirectX, тем более интересные режимы игр доступны пользователю.

Разъемы

Еще одна очень важная характеристика – разъемы видеокарты, к помощью которых к ней подключаются мониторы, телевизоры, проекторы и т. д. Все разъемы делятся на аналоговые и цифровые, при этом цифровые более предпочтительнее, поскольку на картинку, которая получается при аналоговом подключении, влияет масса факторов, которые зачастую очень портят ее качество.

Какая видеокарта на моем ПК?

Чтобы узнать, какая видеокарта установлена на вашем компьютере, необязательно его разбирать, достаточно зайти в «Диспетчер устройств» (Панель управление) и просмотреть сведения о видеоадаптерах. Поняв, какая у вас видеокарта, вы сможете узнать значения ее основных характеристик и оценить уровень ее производительности.

Читайте также: Как работают компьютеры.

Как разогнать видеокарту и зачем это делать | Видеокарты | Блог

Ответ на вопрос «Зачем?» можно свести к одной простой фразе: чтобы повысить производительность.

Производительность компьютерных комплектующих, определяется количественными характеристиками. В случае с рабочими частотами видеокарт зависимость абсолютно прямая и линейная: чем выше частота — тем выше производительность.

Устройство всегда имеет «номинальный» режим работы. Но в каждом выпущенном на рынок чипе есть определенный запас по частотам. Насколько велик этот запас в цифрах — зависит исключительно от конкретного экземпляра, однако заводские частоты практически никогда не являются пределом возможностей.

Ярчайшим примером здесь будет частотная модель последних поколений видеокарт Nvidia — а точнее, чипов из семейств Pascal и Turing. У этих чипов есть базовая частота, которую вы никогда не увидите, а есть частота динамического разгона, которая и указывается в характеристиках, то есть гарантируется производителем для любых условий. А сверх этого есть еще технология GPU Boost, разгоняющая чип еще сильнее, если остается запас по температурам.

Как результат — вполне реальная GTX 1060, выпущенная одним из вендоров, имеет базовую частоту в 1506 МГц, динамический разгон до 1721 МГц, а в реальности умудряется работать в диапазоне от 1870 до 1910 МГц.

А если производитель считает нормальным изменять частоту чипа в столь широких пределах — почему бы рядовому пользователю не заняться тем же самым, тем более если для этого есть необходимый инструментарий?

Какой результат можно получить от разгона видеокарты?

Все линейки видеокарт проектируются таким образом, что даже при помощи разгона практически невозможно добиться от младшей карты производительности старшей. Например, разница в количестве исполнительных блоков между GTX 1660 Ti и RTX 2060 такова, что даже предельный разгон младшей модели не выдаст производительность, которую старшая показывает на номинальных для нее частотах.

Есть, разумеется, и единичные исключения — например, Radeon RX 570 в разгоне может и догонять, и обходить номинальный Radeon RX 580, но такие случаи встречаются редко.

Любой разгон должен быть оправдан практически.

Для примера: если вы используете видеокарты начального класса, вроде Radeon R5 230 или GeForce GT 710, и в более-менее новых играх получаете всего 12 кадров в секунду — разгон, вероятно, позволит получить 14–15 кадров. Кардинально ничего не меняется, геймплей не становится комфортным.

Обратный пример: если в вашем компьютере установлены видеокарты флагманского уровня, вроде Radeon VII или GeForce RTX 2080 Ti, и при любых настройках графики вы получаете более 60 кадров в секунду даже в разрешениях 2K и 4K — лучше забыть о разгоне и наслаждаться непосредственно игровым процессом. Разницы между условными 110 и 120 кадрами в секунду вы также не ощутите.

Разгон действительно оправдан, если вам не хватает производительности, чтобы геймплей был комфортным на выбранных настройках графики, или чтобы попробовать более высокие настройки и/или разрешения экрана. Разница между 45 и 50 кадрами может казаться несущественной на бумаге, но в игре очень хорошо заметна.

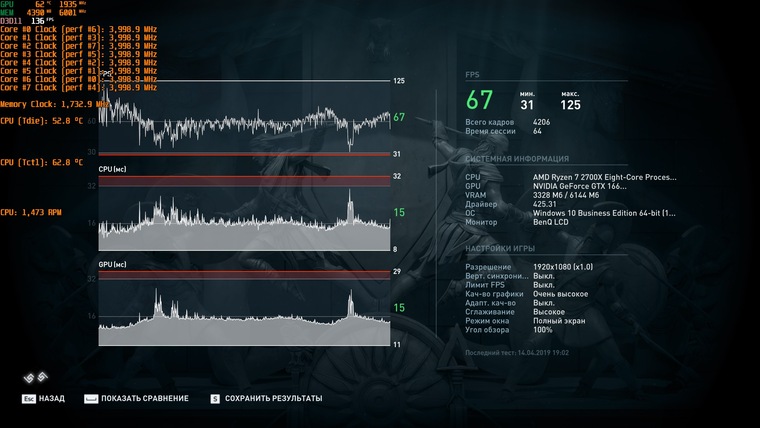

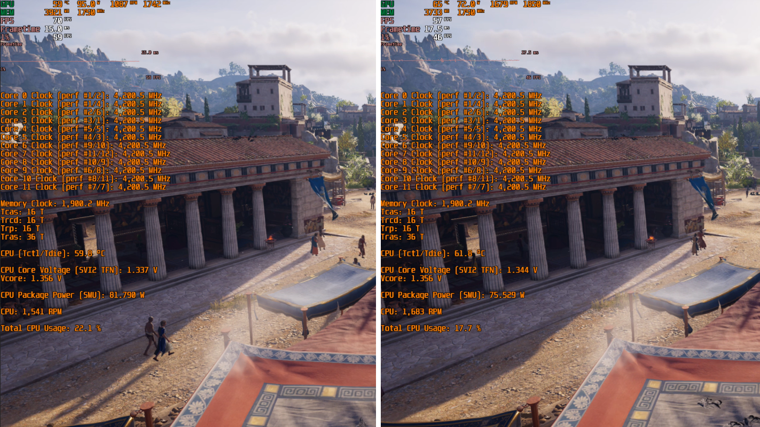

Наглядный пример — реальная GeForce GTX 1660 Ti. И два разрешения экрана при одинаковых настройках:

Full HD, номинальный режим

Full HD, режим разгона

В Full HD от разгона получили 71 FPS вместо 67. Играть одинаково комфортно в обоих случаях, и разница в количестве кадров не ощутима.

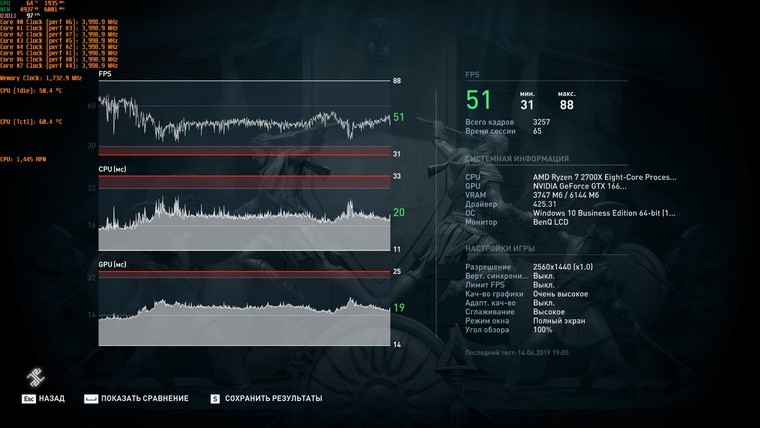

2К, номинальный режим

2К, режим разгона

А в случае разрешения 2K мы говорим о разнице между 51 и 55 FPS. И хотя кажется, что здесь разница столь же незначительна — это отнюдь не так. Пределом комфортной игры считаются стабильные 60 кадров в секунду, и любое изменение, приближающее производительность к этому значению, ощутимо в реальной игре.

Если до 60 FPS не хватает совсем немного — разгон действительно поможет.

Теория работы и разгона видеокарты

Разгон видеокарты — это программное изменение её параметров при помощи специализированных утилит.

При разгоне важно понять пять параметров, которые и придется менять:

1) Частота графического процессора (Core Clock).

Тут, на первый взгляд, все просто: чем выше частота — тем выше производительность. Но с повышением частоты возрастает энергопотребление и нагрев чипа, и одновременно с этим – требования к напряжению на нём.

При разгоне современных видеокарт Nvidia и AMD по графическому чипу вы задаете им отнюдь не конкретное значение частоты, на котором они будут работать.

Для видеокарт Nvidia задается некий модификатор, добавляющий указанное значение к их базовой частоте. Частота под нагрузкой по-прежнему определяется технологией GPU Boost, и может изменяться на меньший шаг, нежели заданное значение.

Для видеокарт AMD семейств Vega и Navi задается уже конкретное значение частоты, но это значение является лишь верхней границей, за которую карта не перешагнет. Фактическая же частота чипа под нагрузкой будет зависеть от его температуры, напряжения и близости к лимиту энергопотребления.

2) Лимит энергопотребления (Power Limit)

Следующий, более важный пункт при разгоне графического процессора — доступный видеокарте лимит энергопотребления.

Как и любой электрический прибор, видеокарта призвана выполнять определенную задачу, затрачивая на это определенное количество энергии. Для современных карт это количество лимитировано, причем ограничение закладывается программным методом на уровне биос.

Для примера, если в BIOS видеокарты заложен лимит энергопотребления в 200 Вт, то в своем штатном состоянии больше 200 Вт она никак не съест, сколько бы противоположных комментариев про нее не было написано на форумах и в карточках товара магазинов. Если фактическое энергопотребление под нагрузкой превысит 200 Вт — карта начнет сбрасывать частоты, чтобы остаться в пределах программного лимита.

На практике это означает, что при разгоне лимит энергопотребления необходимо увеличивать. Как правило, программным методом его можно повысить на 50% от штатного значения, но бывают и исключения. Ещё не факт, что вам потребуется поднимать его до предела — всё будет зависеть от реального потребления карты в режиме разгона.

3) Напряжение на GPU и памяти (Core Voltage)

Уровень энергопотребления любого чипа зависит не только от его тактовой частоты, но и от напряжения, при котором этот чип работает. Чем оно выше — тем выше энергопотребление и сильнее нагрев, но выше и частотный потенциал разгона.

Возьмем, например, видеокарту Radeon RX 5700 в референсном дизайне. В номинале GPU этой видеокарты работает на частоте в 1750 МГц при напряжении в 1.02 В. На этой же частоте GPU стабильно работает и при 0.98 В, но вот разгон до 2100 МГц возможен уже только при поднятии напряжения до 1.19 В.

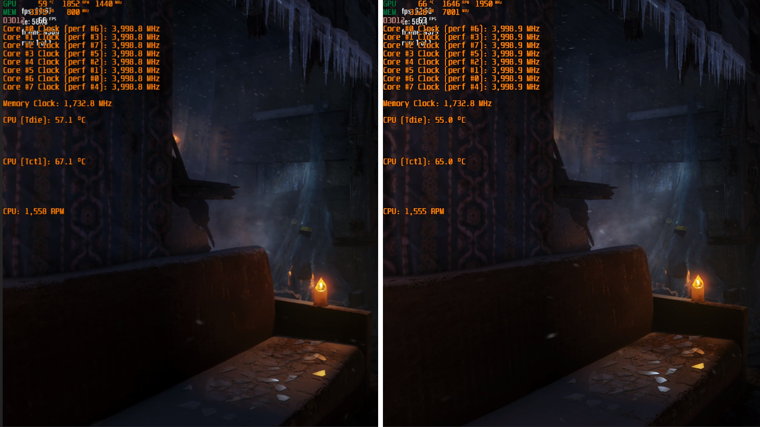

Штатный режим с понижением напряжения

Разгон с повышением напряжения

Далеко не все видеокарты допускают изменение напряжения программными средствами, что ограничивает предел разгона.

4) Частота памяти (Memory Clock)

С разгоном памяти все просто. Параметры частоты фиксированы, и если вы задаете условные 2000 МГц базовой частоты — то 2000 МГц вы и получаете под нагрузкой.

Нюанс в том, что чипы на видеокарте имеют понятие реальной и эффективной частоты. Эффективная указывается в рекламных материалах, а при разгоне меняется как раз реальная. Для памяти стандарта GDDR5 эффективная частота в 4 раза выше реальной, то есть вышеупомянутые реальные 2000 МГц дают эффективные 8000 МГц. Для памяти GDDR6 умножать надо уже не на 4, а на 8 — эффективные 14 000 МГц на деле оказываются 1750 МГц.

5) Скорость вентилятора (Fan Speed)

Видеокарту нужно разгонять собственным вентилятором, без шуток. Даже если вы правильно настроите напряжение и лимит энергопотребления, карта может не выйти на ожидаемые частоты, если упрется в потолок по температуре.

Повлиять на температуру видеокарты в разгоне можно лишь одним программным способом: задать повышенную скорость вращения вентилятора. Но, разумеется, уровень шума тоже увеличится.

Готовимся к разгону

Прежде всего — удостоверьтесь, что карте обеспечено достаточное охлаждение. Если разгон упрется в программные лимиты по температурам — карта будет снижать частоты, и никакого эффекта от разгона не будет. Проверьте температуру в штатном режиме: если она близка к 90 градусам или даже выше — забудьте о повышении частот и обеспечьте карте более комфортные условия.

Вмешиваться в конструкцию самой карты не придется, но раскрутить системный блок, вероятно, потребуется. Наладьте вентиляцию в корпусе, уложите провода так, чтобы они не мешали движению воздуха, переставьте системный блок подальше от батареи и ни в коем случае не устанавливайте его в глухие ниши «компьютерных» столов, которые не вентилируются.

Если видеокарта уже работает у вас длительное время — стоит хотя бы почистить её радиатор от скопившейся пыли, а лучше — еще заменить термопасту на графическом процессоре и термопрокладки на прочих элементах. Если собственного опыта недостаточно, любые профилактические работы можно сделать в авторизированном сервис-центре — так и гарантия сохранится.

Убедитесь в том, что мощности вашего блока питания достаточно. Стоит изучить данные о фактическом энергопотреблении вашей модели видеокарты в номинале и в разгоне, а также спецификации и обзоры на ваш блок питания. Если запаса по мощности мало, от разгона лучше отказаться.

Современное «железо» обладает завидным запасом прочности и крайне высокой степенью защиты от действий пользователя — вывести из строя ту же видеокарту при разгоне программными методами очень сложно. А вот блок питания, работающий на пределе и уходящий в защиту от перегрузки, это уже серьезная проблема.

Запасаемся инструментами для разгона

В общем случае, потребуются три отдельные утилиты: для изменения параметров видеокарты, мониторинга показателей, проверки результата. На деле же во многие «тюнеры» мониторинг и простые стресс-тесты зачастую уже встроены.

Софт для разгона

Выбор утилиты, с помощью которой вы будете управлять параметрами видеокарты, зависит исключительно от того, в какой программе вам лично удобнее работать: функционал у них примерно одинаков, различия заключаются в интерфейсе и, очень редко, — в перечне поддерживаемых видеокарт.

Для видеокарт AMD дополнительный софт не обязателен — все операции по разгону, изменению напряжений, лимитов энергопотребления, температур и даже скорости вентиляторов, можно выполнить напрямую из драйвера. Точнее, из надстройки Radeon Settings. При желании можно менять параметры, даже находясь в игре — для этого программу можно вызвать в оверлей нажатием комбинации клавиш.

Впрочем, если вы привыкли к другому интерфейсу — никто не запретит использовать сторонние программы. Как фирменные, вроде MSI Afterburner или Sapphire Trixx, так и написанные сторонними энтузиастами, вроде OverdriveNTool.

Для видеокарт Nvidia лучше использовать как раз сторонний софт — MSI Afterburner, Gigabyte AORUS Engine, Asus GPU Tweak или даже EVGA Precision X. Подобные утилиты есть практически у всех вендоров, причем не обязательно, чтобы производитель утилиты соответствовал производителю видеокарты.

Софт для мониторинга

В процессе разгона необходимо вести мониторинг параметров видеокарты, чтобы иметь представление обо всех изменениях, к которым приводят ваши действия. Разумеется, подобный функционал есть и в самих утилитах для разгона, но не всегда они могут прочесть показания всех нужных датчиков. Поэтому оптимальнее использовать специализированное ПО для мониторинга.

Например, GPU-Z или Hwinfo64. Последняя любопытна прежде всего тем, что постоянно обновляется, получая сведения о новых видеокартах и новых датчиках на них. Кроме того, агрегировав её с тем же MSI Afterburner, можно вывести все интересующие вас параметры в оверлей и контролировать частоты и температуры непосредственно из игры.

Софт для тестов

Разгон предполагает не только изменение и мониторинг параметров видеокарты, но и тестирование изменений на стабильность.

Разумеется, проверить стабильность карты можно и в играх — но для этого потребуется больше времени, да и условия могут быть не самыми подходящими. Например, в одной тестовой игре карта может быть абсолютно стабильной, а в другой — вылетать уже на этапе загрузки уровня.

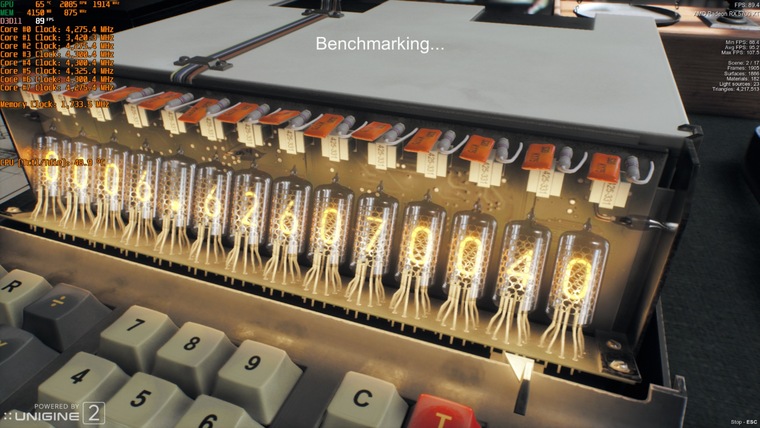

Поэтому лучше использовать специализированные бенчмарки, прямая задача которых — создание экстремальной нагрузки на видеокарту.

В случае сравнительно старых видеокарт пальму первенства здесь удерживает «пушистый бублик» — FurMark до сих пор умудряется нагревать их так, как не может ни одна современная игра или тест видеокарты.

А вот если речь идет о современных графических чипах, оснащенных технологиями энергосбережения, FurMark не помощник — карты воспринимают его как экстремальную нагрузку, и не выходят на максимальные для них частоты.

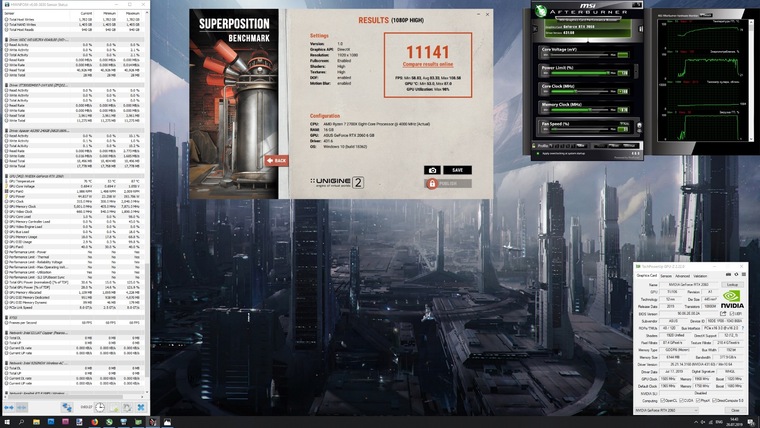

Для проверки современных видеокарт лучше подойдет бенчмарк от компании Unigine — тест Superposition. Он очень быстро грузится и создает достаточно серьезную нагрузку на видеокарту, чтобы выявить возможную нестабильность буквально в первые минуты, а не спустя несколько часов игры.

В приведенных выше картинках обоих бенчмарков тестировался современный Radeon RX 5700 XT. Что примечательно, частота GPU в «пушистом бублике» FurMark лишь чуть выше 1500 МГц, тогда как в Superposition — более 1900 МГц. Разумеется, данные теста Unigine Superposition более достоверные.

Переходим к практике

Рассмотрим изложенные выше тезисы на примере двух современных видеокарт от AMD и Nvidia, относящихся к одному ценовому сегменту и оснащенных сходными по конструкции системами охлаждения — GeForce RTX 2060 и Radeon RX 5700.

GeForce RTX 2060 не имеет заводского разгона, частотная модель полностью соответствует референсному экземпляру: 1365 МГц базовой частоты, динамический разгон до 1680 МГц, но на практике за счет технологии GPU Boost частота в течение теста составляет 1830 МГц.

Память работает на стандартной частоте в 1750 МГц (реальных).

Лимит энергопотребления GeForce RTX 2060 можно увеличить на 20% — и это вполне закономерно, поскольку у нее всего один разъем доппитания, и теоретический лимит энергопотребления составляет 225 Вт (75 по шине PCI-e + 150 Вт через разъем 8-pin). Изменение напряжения на GPU невозможно.

В тесте Superposition получаем результат в 10256 «условных попугаев».

Разгоняем GeForce RTX 2060: поднимаем лимит энергопотребления до максимума — это позволяет добавить 140 МГц к базовой частоте чипа и получить 1505 МГц базовых или 1820 МГц в динамическом разгоне. За счет технологии GPU Boost частота чипа возрастает до 1960–1990 МГц, но упирается уже в лимит температуры — 87 градусов на GPU. Дальнейший разгон возможен либо за счет принудительного повышения оборотов вентилятора, либо замены штатной СО на более эффективную.

К памяти можно добавить 218 реальных МГц — итоговая реальная частота составляет 1968 МГц. Дальнейшее повышение частоты невозможно, это предел потенциала самих чипов.

На разгоне без принудительного включения вентиляторов Superposition выдал 11140 «попугаев» и одно попугайское крылышко.

Radeon RX 5700 является референсным образцом, и его частотная модель полностью соответствует спецификациям AMD. Лимит частоты GPU — 1750 МГц, память работает на тех же 1750 реальных МГц.

Тест производительности выдает 10393 «попугая» в штатном режиме.

Разгоняем Radeon RX 5700: поднимаем напряжение со штатных 1,022 до 1,19 В. Лимит энергопотребления повышаем на 50%, верхний предел частоты GPU — до 2100 МГц, частоту памяти — до 1850 МГц (реальных). Все значения меняем через родной софт от AMD, кроме лимита энергопотребления — его «тюним» через MSI Afterburner. Частота памяти снова уперлась в предел самих чипов, а разгон GPU срезал температурный предел. Частота графического процессора RX 5700 в разгоне под нагрузкой колеблется в пределах 1980-2020 МГц.

Superposition за разгонные заслуги выдал 11927 «попугаев».

7 распространенных ошибок при выборе видеокарты | Видеокарты | Блог

Естественное желание каждого покупателя — получить максимум отдачи от приобретенного товара. То есть — выбрать из конкурирующих решений наиболее качественное, функциональное, либо просто в большей степени соответствующее вкусам нового владельца.

Это стремление логично и не нуждается в каких-либо пояснениях. Но парадокс заключается в том, что чем более технологичным (а следовательно — более дорогостоящим и менее регулярно приобретаемым) является товар — тем в меньшей степени покупатели склонны оценивать его первостепенные характеристики, обращая внимание на менее значимые моменты или вовсе сводя покупку в область эмоций.

Комплектующие для компьютера — в частности, видеокарты, — отнюдь не исключение из этого правила. Ошибок при их выборе совершается немало, и в данной статье мы постараемся осветить основные из них.

Нужно ли смотреть на объем памяти?

К сожалению, фразы вроде «фу, у этой карты 4 гигабайта, на ней только в пасьянс играть!», «у этой видеокарты всего 6 гигабайт памяти, я лучше возьму вот эту — у ней сразу 8!» или бессмертное «у меня карта на 8 гигабайт, эта игрушка на ультра летает!» буквально заполоняют компьютерные форумы, карточки товаров в интернет-магазинах, социальные сети и прочие смежные ресурсы.

Принято считать, что чем больше у карты набортной памяти — тем выше ее производительность, а прочие характеристики либо второстепенны, либо вовсе не имеют значения.

На самом деле, конечно же, это не так.

Набортная память видеокарты сама по себе не влияет на производительность — это всего лишь хранилище для используемых видеокартой данных. И фраза о преимуществах видеокарты с 8 гигабайтами набортной памяти над картой с 6 гигабайтами звучит буквально как «автомобиль с багажником на 500 литров быстрее, экономичнее, комфортнее и лучше в управлении, чем автомобиль с багажником на 350 литров».

Иначе говоря — представляет собой полный абсурд.

Во-первых, производительность видеокарты определяется в первую очередь характеристиками ее ГПУ: количеством исполнительных блоков, архитектурными особенностями, рабочими частотами. Говоря проще — при одинаковом объеме набортной памяти (6 гигабайт), бюджетная GeForce GTX 1660 никогда не будет равна GeForce RTX 2060, стоящей на пару ступеней выше в линейке продуктов.

Но в качестве наглядного примера мы рассмотрим другие карты аналогичных классов:

Встроенный бенчмарк игры Assassin’s Creed: Odyssey запущен в разрешении FullHD с настройками графики, соответствующими штатному профилю «Высокое качество». Конфигурация ПК полностью идентична, за исключением самих видеокарт.

Слева — Radeon RX 5600 XT в исполнении Sapphire с типичными для этой модели 6 гигабайтами набортной памяти.

Справа — Radeon RX 5500 XT в исполнении MSI в версии с 8 гигабайтами набортной памяти.

Частоты видеокарт, в отличие от ЦПУ и оперативной памяти, не приведены к общему знаменателю, но в данном случае этого и не требуется — разница и без того очевидна.

В первом случае по итогу тестовой сцены мы получаем 74 кадра по среднему фпс, 62 кадра по минимальному и просадки до 59 кадров в 1% редких событиий. Во втором — 60, 50 и 48 кадров соответственно.

Так какая карта оказывается быстрее — с 6 или с 8 гигабайтами памяти на борту?

Во-вторых, как уже говорилось выше, память видеокарты — это хранилище данных. А размеры любого хранилища рассчитываются исходя из объема содержимого, которое в него планируется поместить. В случае видеокарты — исходя из объема памяти, который реально задействуют игры. А требования игр — отнюдь не константа, они находятся в прямой зависимости от разрешения экрана и настроек графики. Говоря проще — одна и та же игра на высоких и на средних настройках будет обладать совершенно разными аппетитами.

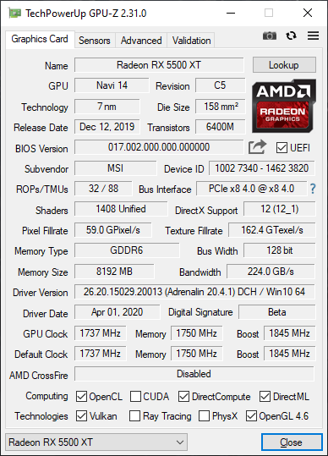

Рассмотрим следующий пример:

Red Dead Redemption 2, одна из самых требовательных игр последних лет. Здесь используется одна и та же видеокарта — Radeon RX 5500 XT 8gb в исполнении MSI.

В чем же разница?

Слева используются высокие настройки графики, справа — средние. Разрешение в обоих случаях — FullHD.

Мониторинг позволяет увидеть, что на высоких настройках используется до 6900 мегабайт набортной памяти, так что 8 гигабайт, чтобы поиграть в RDR 2 на высоких, — вполне реальная необходимость. На средних же потребление памяти снижается до 5500 мегабайт — так что карт с 6 гигабайтами памяти на борту для этих настроек тоже хватит. Однако есть одно большое «НО».

C RX 5500 XT, пусть у него и есть необходимые 8 гигабайт памяти, на высоких настройках мы получаем 45 кадров по среднему фпс, 38 — по минимальному и просадки до 36 кадров в 1%.

Бесспорно, многие назовут этот режим играбельным, но, если подходить к вопросу объективно — для по-настоящему комфортного геймплея настройки следует понижать.

На средних же настройках с тем же RX 5500 XT мы получаем 61, 52 и 49 кадров соответственно. Эти показатели как раз и можно назвать комфортными.

Вывод из примеров выше будет следующим:

Объем памяти — важный параметр, но учитывать его необходимо не в отдельности, а только и исключительно в комплексе всех прочих характеристик видеокарты.

Да, в реалиях сегодняшнего дня, даже если вы выбираете видеокарту для игр в самом ходовом разрешении FullHD, следует ориентироваться на карты с объемом памяти в 6 и 8 гигабайт, НО — только в том случае, если выбранная вами карта способна обеспечить комфортный фпс в интересующей вас игре на тех настройках, где эти 6 или 8 гигабайт реально потребуются.

Если же вас интересуют сетевые игры со сравнительно простой графикой, если вы планируете играть в игры не последних лет выпуска, либо если выбирается очень бюджетное решение, способное тянуть тяжелые новинки только на средневысоких настройках — нет смысла гнаться за большим объемом памяти. Во всех этих случаях либо реальное потребление памяти в игре будет сравнительно низким, либо производительность упрется в возможности ГПУ, а не памяти карты.

Так ли важны характеристики разрядности шины памяти или частоты в отдельности?

Этот и последующий пример можно охарактеризовать так же, как и вопрос с объемом памяти видеокарты. А именно — как стремление не рассматривать характеристики продукта не в комплексе, а максимально упростить их, сведя лишь к одному параметру.

Тезисы, разумеется, здесь звучат максимально похоже: «как можно выпускать в 2020 году обрезок со 128-битной шиной?», «да тут всего 192 бита, а еще в прошлом поколении было 256 — я лучше возьму старую карту, она явно быстрее!» и так далее.

Во-первых, помимо ширины шины памяти, есть такие понятия как рабочие частоты и тип памяти. Итоговую пропускную способность подсистемы памяти эти характеристики формируют не по отдельности, а в комплексе. И современные чипы GDDR6 даже на 128-битной шине могут обеспечить те же, или близкие значения к показателям GDDR5 на 256-битной шине.

224 гигабита в секунду против 256 — совсем не та разница, которую следовало бы ожидать, говоря о вдвое «снизившейся» ширине шины памяти.

Однако, во-вторых, сводя все к одному параметру, пусть даже он является комплексным, мы совершаем ровно ту же ошибку, что и рядовые покупатели. Пропускная способность интерфейса описывает лишь максимальный объем данных, который теоретически можно передать за единицу времени.

Ключевое слово здесь — теоретически. На практике же значение имеет архитектура ГПУ и предполагаемые ей алгоритмы сжатия данных.

Рассмотрим очередной практический пример:

Metro: Exodus, встроенный бенчмарк. Разрешение — FullHD, настройки графики — высокие, тесселяция включена, технологии Hairworks и Advanced PhysX — выключены.

Слева — Radeon RX Vega 56, использующий скоростную память типа HBM2 на 2048-битной шине. Справа –GeForce RTX 2060, с типичной для нее GDDR6 на 192-битной шине.

Казалось бы, при таких вводных данных разница в пользу первого решения должна быть очевидной, но на самом деле с Vega56 по итогу теста мы получаем 67 кадров по среднему фпс и 35 — по минимальному, а с RTX 2060 — 66 и 35 кадров соответственно.

Видеокарта — это крайне сложное и технологичное устройство, буквально «компьютер в компьютере», оснащенный собственным процессором, собственным объемом памяти и интерфейсами для передачи данных. И, как у любого компьютера, у видеокарты есть своя архитектура и свой софт, использующий ее преимущества. Поэтому любой параметр, касающийся характеристик видеокарты, нельзя рассматривать в отдельности, а уж тем более — делать какие-то выводы, основываясь исключительно на одном этом параметре.

Впрочем, не совсем так.

Есть один параметр, который действительно может определять и описывать абсолютно все, и согласно которому можно расставлять видеокарты по умозрительной лестнице предпочтений. И это, как легко догадаться — производительность карты в реальных играх.

Корректно ли сопоставлять количество функциональных блоков чипа при сравнении видеокарт разных поколений и от разных производителей?

Характеристики графического процессора, как и центрального процессора компьютера, определяются в первую очередь его частотой и количеством исполнительных блоков — т.е. универсальных шейдерных процессоров, текстурных блоков и блоков растровых операций.

И, как в случае центральных процессоров 6 ядер на частоте в 4000 МГц будут быстрее 4-х ядер на 3400 МГц, так и в случае ГПУ — чем выше частота и больше блоков, тем выше производительность. Однако, тут тоже есть свое большое «НО».

Как и ЦПУ, графические ядра видеокарт можно сравнивать «по цифрам» только в рамках одного поколения и одной архитектуры. Например, Radeon RX 580 с его 2304 процессорами, 144 TMU и 32 блоками ROP будет всегда быстрее RadeonRX 570, характеристики которого можно записать по формуле 2048/128/32.

Но вот когда заходит речь о картах разных поколений или разных производителей — стоит всегда иметь ввиду, что первостепенное значение имеет архитектура, а не частота или количество блоков. Так, карта нового поколения может иметь 2300 универсальных процессоров, а карта предыдущего поколения — все 3600, но в реальных играх полуторакратной разницы вы не увидите:

World of Tanks — правда, уже довольно старой на сегодня версии 1.5.1.3, актуальной на момент проведения тестов. FullHD, настройки графики — ультра.

Слева — Radeon RX 5700, располагающий 2304 универсальными процессорами, 144 текстурными блоками и 64 блоками ROP.

Справа — Radeon RX Vega 56, его прямой предшественник. 3584, 224 и 64 блока соответственно.

Разумеется, частота ГПУ у новинки немного выше, но 240–250 МГц не могли бы обеспечить столь заметный отрыв в производительности при такой разнице в количестве исполнительных блоков. А вот новая архитектура — еще как может!

Оценивать по количественным параметрам и сравнивать между собой можно только видеокарты одного поколения. Если же говорить о картах на принципиально разной архитектуре — можно прийти к условной ситуации, в которой есть некий чип с 1000 универсальных процессоров и его более старый аналог, у которого их 1500.

Казалось бы, второй вариант будет гарантированно быстрее, но вот незадача: 1500 процессоров на старой архитектуре могут выполнять лишь 2 инструкции за каждый такт, а каждый из 1000 новых процессоров — все 4 инструкции.

Пример, разумеется, полностью умозрительный, и аллюзий на реальные графические чипы не предполагающий. Но суть он передает верно.

Как не ошибиться при расчете питания?

Как и любые другие комплектующие, для своей работы видеокарты требуют определенное количество электроэнергии. Соответственно, встает вопрос о том, с помощью чего запитать видеокарту, планируемую к покупке. И в этом случае могут иметь место две крайности:

- Либо пользователь учитывает только заявленную мощность имеющегося блока питания, не обращая внимания на его реальные характеристики и фактическое состояние (в лучшем случае — задается вопрос «а подойдет ли блок на 500 ватт к этой видеокарте?»).

- Либо потенциальный владелец новинки бросается в другую крайность — приобретает новый блок питания заведомо избыточной мощности, при том что уже имеющийся у него блок тоже легко справился бы с задачей.

В обоих этих случаях пользователь оказывается в проигрыше. Поэтому, чтобы не потратить лишних денег и не получить заведомо нестабильную систему, нужно обязательно помнить следующее:

— Блок питания выбирается не «под видеокарту», а под всю систему в целом.

Видеокарта — это только один из составляющих элементов. Помимо нее, в системном блоке также проживают центральный процессор, жесткие диски, оперативная память, материнская плата и, возможно, какие-то платы расширения вроде звуковой карты. Все они в работе также потребляют какое-то количество ватт, и их также нужно учитывать при выборе блока питания.

— Указанная на вашем блоке мощность не обязательно есть в нем фактически.

Качество блоков питания — довольно скользкая тема, и касаться ее в рамках данной статьи мы не будем. Но все же — напомним, что условный блок на 500 ватт, выпущенный в 2010 году и активно эксплуатировавшийся до сегодняшних дней, и современный блок на те же 500 ватт, в реальных замерах выдадут совершено разную мощность. Поэтому, при расчетах совместимости оперировать нужно не цифрами с этикетки, а реальными моделями блоков питания и их фактическим состоянием.

— Фактическое энергопотребление видеокарты и рекомендуемая мощность блока питания — разные вещи.

В характеристиках видеокарт. Указанных на сайтах производителей и в карточках магазинов, можно обнаружить такой параметр, как «рекомендуемая мощность БП». Некоторые часто путают ее с энергопотреблением видеокарты, что и порождает «авторитетные советы» приобретать блоки мощностью 800 ватт к бюджетным видеокартам вроде GTX 1650 — GTX 1660 — RX 5500 XT.

На самом деле, производители видеокарт как раз прекрасно знают предыдущие два тезиса. И рекомендуемая ими мощность — это как раз мощность для ВСЕЙ системы с установленной в нее видеокартой. Более того — мощность эта намеренно завышена, поскольку тем самым производитель защищает себя от претензий со стороны владельцев низкокачественных БП.

Так как определить реальное энергопотребление интересующей вас видеокарты?

Проще всего — прочесть обзор на нее от авторитетного источника. Да, нередко в обзорах указывается энергопотребление всей системы, а не отдельно видеокарты — но так получается даже более наглядно. Ведь, если тестовая система на условном Core i9-9900K в разгоне показывает пиковое энергопотребление на уровне 580 ватт, то ваш компьютер с опять же, условным Core i5-9400F есть будет очевидно меньше.

Впрочем, если в вас вдруг проснется азарт исследователя, можно пойти и более сложным путем.

Одной из основных характеристик современных видеокарт является лимит энергопотребления. Это программное ограничение (аппаратным может являться, разве что, конфигурация разъемов дополнительного питания), по достижении которого видеокарта начинает сбрасывать частоты и понижать напряжения, чтобы остаться в обозначенных пределах.

К примеру, если видеокарта имеет лимит на 130 ватт, то без разгона и ручного поднятия лимита больше есть она не будет — как бы различные «интернет-знатоки» ни советовали вам покупать для нее блоки мощностью 800 ватт минимум.

А поскольку ограничение это программное — узнать его можно напрямую из биос видеокарты. Для этого нужно либо скачать файл и открыть его диагностической утилитой, либо обратиться, например, к базе данных портала Techpowerup.

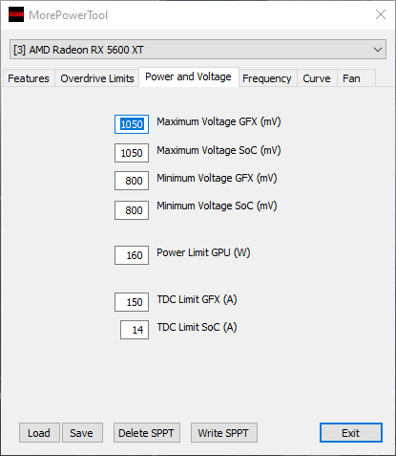

Слева — отчет утилиты MorePowerTool о лимитах видеокарты Sapphire Radeon RX 5600 XT Pulse. Лимит энергопотребления для ГПУ составляет 160 ватт. Остальные элементы в данном случае не учитываются, однако их потребление существенно ниже чем у ГПУ, для простоты можно округлить до 30–40 ватт.

Справа — информация о видеокарте Gigabyte GeForce RTX 2060 Windforce OC из базы данных Techpowerup. Здесь уже приводится общий лимит энергопотребления, и он составляет 200 ватт.

Разумеется, лимит энергопотребления — это именно пиковое значение, в реальных задачах видеокарта не всегда будет потреблять максимальное количество электроэнергии, но при расчетах мощности БП следует учитывать именно возможный максимум.

И, конечно же, надо помнить, что при разгоне видеокарты лимит энергопотребления вам придется повышать — а, следовательно, нужно закладывать некоторый запас сверх штатного значения. Опять же, здесь поможет изучение характеристик биос карты — так, на примере выше видно, что для конкретно этой версии RTX 2060 штатными средствами лимит можно поднять лишь на 18%.

При расчетах мощности блока питания для вашей системы следует учитывать всего два фактора: реальное энергопотребление ваших комплектующих и не менее реальные характеристики вашего БП. И с первым, и со вторым поможет вдумчивое изучение обзоров.

В крайнем случае — можно просто сравнить энергопотребление видеокарты, которую вы планируете приобрести, с той, которая стоит в вашем системном блоке сейчас. Хотя современные микросхемы и более сложны, их аппетиты вполне могут оказаться ниже, чем у предшественников.

Важно ли подбирать видеокарту под конкретный процессор?

Сегодня вопросы вроде «а подойдет ли эта видеокарта к моему процессору?» по своему количеству и частоте задавания уже уверенно обходят вопросы совместимости с блоками питания. Можно предположить, что здесь действительно есть какие-то тонкости, однако на самом деле это не так.

Если вопрос касается именно совместимости системы с видеокартой — то модель и семейство установленного процессора ее не определяют. Более того: как правило, если видеокарта использует интерфейс PCI-e и поддерживается в установленной на компьютере ОС — это все, что от нее требуется.

Иначе говоря, если вы собираете ПК на новой платформе, но бюджет не позволяет сразу приобрести видеокарту актуального поколения — можно использовать карту, оставшуюся от предыдущей системы, или бюджетное решение старого поколения, купленное на вторичном рынке.

И обратное тоже верно: в компьютеры, собранные на не самых новых платформах, можно устанавливать видеокарты актуальных поколений, если вам не хватает производительности графической части, или бюджет позволяет заменить только видеокарту.

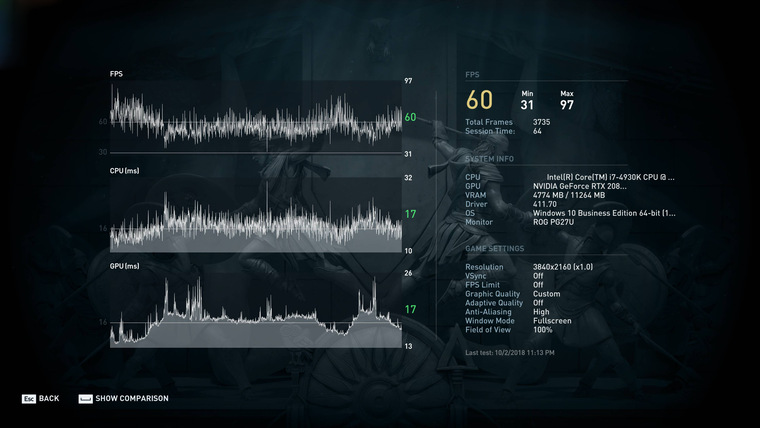

Встроенный бенчмарк игры Assassin’s Creed: Odyssey утверждает, что тестовая система объединяет процессор Intel Corei7-4930K, выпущенный в 2013 году для уже давно устаревшей платформы LGA 2011, и видеокарту GeForce RTX 2080 Ti, выпущенную в конце 2018 года, и актуальную до сих пор.

Причем, разумеется, пример выше — далеко не единственный. При желании в Интернете можно найти множество сборок даже на более старых процессорах — к примеру, Core i5/i7 Sandy Bridge и FX Piledriver, объединенных с современными видеокартами. И не только в виде статичных картинок, но и видеороликов, посвященных сборке и тестированию получившихся систем.

Безусловно, бывают случаи индивидуальной несовместимости, когда видеокарта напрочь отказывается инициализироваться и работать, хотя сама она гарантированно исправна. Но, во-первых, в современных реалиях это большая редкость, а во-вторых, вопросы в данном случае следует адресовать к материнской плате, а не к процессору.

Однако речь может идти не просто о совместимости и возможности эксплуатировать систему с новой видеокартой, но и об итоговой производительности получившегося компьютера в играх. И здесь все уже отнюдь не так просто.

Мифы о «раскрывашках»

«Раскрывашки», наиболее активно нервировавшие интернет-сообщество в период с 2014 по 2018 год, сегодня уже являются в большей степени забавным мемом и поводом для шуток, нежели серьезной проблемой. Однако и сейчас изредка проскакивают вопросы вроде «а раскроИт ли?», в которых потенциальные владельцы новых видеокарт желают знать, насколько быстрой окажется их система после апгрейда.

Согласно популярному заблуждению, к новым и быстрым видеокартам обязательно приобретать процессоры новых поколений. Причем чем выше будет индекс модели — тем лучше для производительности. Хотя реальные системные требования игр, как и соотношение производительности уже имеющегося у пользователя процессора с рекомендуемой ему моделью значения здесь никакого не имеют.

Если же пользователь не желает приобретать новый процессор (разумеется, вместе с полагающейся к нему материнской платой и в некоторых случаях — оперативной памятью), ему заявляется, что и в апгрейде видеокарты нет никакого смысла, ведь работать она будет на уровне младших моделей той же линейки, а то — и вовсе так же, как и старая видеокарта.

Разумеется, все это — крайности, доведенные до абсурда. И ключевая задача любой «раскрывашки» — не помочь, а именно убедить пользователя потратить деньги на новое железо помимо видеокарты. Чего ему, возможно, вовсе и не надо делать.

В реальности, конечно, процессор оказывает существенное влияние на производительность системы. Но, во-первых, не он один, а во-вторых — влияние это не во всех играх одинаково, и уж точно не определяется индексом модели процессора.

Рассмотрим несколько примеров.

Total War: Three Kingdoms. Игра, довольно требовательная к ресурсам центрального процессора и к тому же — использующая преимущества многопотока.

Слева — Intel Core i9-9900KF. Справа — Intel Core i7-9700KF. Оба процессора разогнаны до 5000 МГц, частота кольцевой шины поднята до 4700 МГц, видеокарта RTX 2080 Ti работает в штатном для нее режиме, все прочие условия идентичны.

При этом, в случае с Core i7-9700KF фпс в бенчмарке оказывается… выше!

Да, это исключительно частный случай, связанный с тем, что технология Hyper Threading, отличающая Core i9 от Core i7, в играх далеко не всегда работает корректно, и производительность старшей (!!!) модели ЦПУ при прочих одинаковых условиях оказывается ниже, чем у младшей.

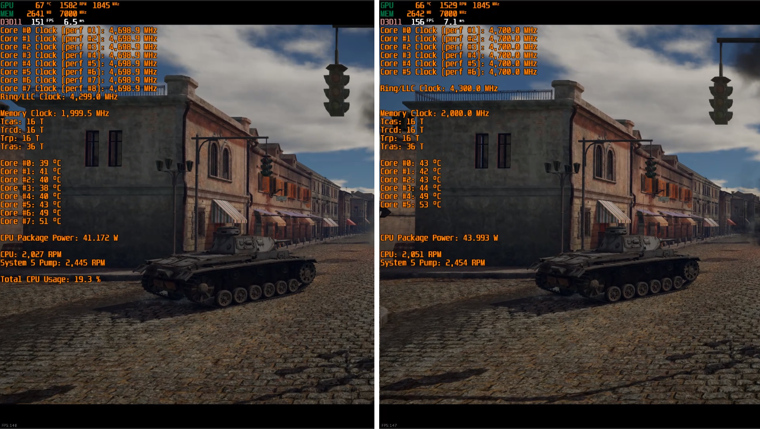

Встроенный бенчмарк игры WarThunder, являющейся уже диаметрально противоположным примером. Движок игры по сей день активно использует не более 2-х ядер.

Слева — снова Core i9-9900KF, но на сей раз — в номинальном для него режиме. 4700 МГц по всем ядрам за счет технологии MCE, 4300 МГц на кольцевой шине. Справа — уже Core i5-9600KF, разогнанный ровно до тех же параметров. Все прочие характеристики системы идентичны, в качестве видеокарты опять используется RTX 2080 Ti.

Разница в фпс, опять же, в комментариях не нуждается. В данном случае Core i9 в принципе не может иметь никаких преимуществ над Core i5 — игра попросту не использует «лишние» ядра. А технология Hyper Threading здесь опять ведет себя не лучшим образом, что и позволяет Core i5-9600KF выдавать немного больше кадров в секунду.

И это далеко не единственные примеры, категорически не вписывающиеся в картину мира, предлагаемую раскрывашками.

В реальности у каждой игры свои требования к характеристикам центрального процессора. Так, где-то используется максимально доступное количество ядер — и, например, старые процессоры под ту же платформу LGA 2011 могут не только эффективно справляться с игрой, выпущенной на 7 лет позже них самих, но и обеспечивать более комфортный геймплей, чем современные модели под LGA 1151_v2.

Где-то — наоборот, количество ядер не имеет значения, важна только тактовая частота и производительность в однопоточной нагрузке. Какие-то игры в силу особенностей движка в принципе мало зависимы от процессора и более требовательны к видеокарте. Да и сама «зависимость» от характеристик процессора в одной и той же игре может меняться со сменой разрешения экрана и настроек графики: чем они выше — тем выше влияние видеокарты, и менее заметна разница между более и менее быстрыми ЦПУ.

Раскрывашки же эти факты игнорируют и сводят все к одному простому тезису: «более дорогой и новый процессор — лучше». Но для кого именно лучше — обычно умалчивают.

Заключение

Конечно, в данной статье мы рассмотрели лишь часть распространенных ошибок, совершаемых при выборе видеокарт. Если начинать рассматривать отдельные семейства — да что там, даже отдельные ценовые сегменты! — то легенд и мифов можно будет обнаружить великое множество.

Но и эти, и любые другие мифы рождаются там, где нет четкого знания и подтвержденной информации. Выдумка, изложенная максимально просто и понятно, всегда будет более притягательна, чем факты, которые нужно изучать, анализировать и сопоставлять. Однако опираться на выдумки никогда не стоит.

Если вы хотите получить товар, максимально отбивающий свою цену — стоит сперва потрудиться и изучить сведения о нем сразу в нескольких авторитетных источниках, а не следовать первой попавшейся на глаза рекомендации.

тестирование, разгон, настройка и диагностика

Последнее обновление — 9 июня 2020 в 20:38

Мой набор программ для разгона, тестирования, настройки, управления, просмотра, мониторинга и измерения температуры видеокарт. Так же дам несколько утилит для обновления и удаления драйверов, регулировки скорости кулера и прошивки биоса видеокарт. Большинство программ и утилит обладают многими из этих возможностей. Поддерживаются как интегрированные, так и внешние видеокарты.

С их помощью можно настроить такие параметры, как сглаживание (Antialiasing), анизотропная фильтрация (Anisotropic Filtering), вертикальная синхронизация (VSync) и множество других недокументированных функций.

Разобраться в этих утилитах и программах легко, но для качественной настройки нужно разбираться в параметрах и технических возможностях настраиваемой видеокарты, чтобы настроить ее под свои потребности и сохранить компьютер в работоспособном состоянии.

Утилиты и программы расположены в порядке убывания по своей значимости и приносимой пользе.

MSI Afterburner

Программа от всем известного бренда различного компьютерного железа. Правопреемник известного RivaTuner. В основном используется для разгона видеокарт, но так же подходит для настройки и диагностики. Работает с видеоускорителями, как от NVIDIA, так и от AMD. Так же не полностью поддерживает графику от Intel.

На данный момент, это самая популярная утилита для ускорения и тонкой настройки большинства моделей видеокарт.

Официальный сайт: MSI

Язык интерфейса: Русский, Английский и другие

Распространение: бесплатно

Системные требования: Windows XP | Vista | 7 | 8 | 10

GeForce Experience

Программа для автоматического обновления драйверов видеокарт NVIDIA и установки оптимальных настроек графики для игр. Автоматически уведомляет о новых выпусках драйверов, скачивает их и оптимизирует графические настройки в играх, в зависимости от конфигурации аппаратного обеспечения.

Данную утилитку можно установить вместе с новыми драйверами или скачать отдельно. Я ее не использую, так как когда она появилась, из-за нее было множество проблем с корректностью работы да и не нужна мне дополнительная нагрузка на комп. Сейчас с ее работой все в порядке, а ставить советую только заядлым игрокам. Для остальных она бесполезна.

Официальный сайт: NVIDIA

Язык интерфейса: Русский, Английский и другие

Распространение: бесплатно

Системные требования: Windows 7 | 8 | 8.1 | 10

GPU-Z

Бесплатная программа от TechPowerUp для отображения технической информации о видеоадаптере работающая под ОС Microsoft Windows. Отображает технические характеристики графического процессора, видеопамяти. Определяет производителя, название и модель видеокарты, дату и версию драйвера и биоса, а также показывает поддерживаемые видеопроцессором (GPU) графические технологии и стандарты.

Может определить температуру и частоту ядра и видеопамяти, скорость вращения кулера. Провести онлайн сравнение устройства с другими аналогичными продуктами.

Отличная и удобная программка. Лучше использовать портативную версию, так как нужна она очень редко и устанавливать лишнее ПО нежелательно. Пригодится всем.

Официальный сайт: TechPowerUp

Язык интерфейса: Английский

Распространение: бесплатно

Системные требования: Windows XP | Vista | 7 | 8.1 | 10

Display Driver Uninstaller

Данная утилита (сокращенно DDU) поможет полностью удалить из операционной системы драйверы видеокарт от AMD, NVIDIA и Intel, а так же некоторые драйверы звуковых карт. При этом она не оставит кучу ненужных файлов (включая ключи реестра, папки и файлы).

DDU предназначена для использования в случаях, когда стандартными способами драйвера не удаляются, или когда нужно тщательно удалить драйверы видеокарты. После использования этого инструмента будет так, будто драйверов не было, как при чистой установке системы.

Более подробно по работе с DDU, читайте в статье про корректное удаление драйверов видеокарт.

Официальный сайт: Wagnardsoft

Язык интерфейса: Русский, Английский, другие

Распространение: бесплатно

Системные требования: ОС Windows Vista с SP2 до Windows 10

FurMark

Полезная утилитка, позволяющая проводить стресс-тестирование видеокарт. В настройках можно задавать разрешение экрана, активировать оконный или полноэкранный режим и настраивать сглаживание, а также указывать время проведения тестирования.

Для оверклокеров будет полезен режим испытания на принудительный отказ (burn-in test), с помощью которого можно проверить стабильность графической платы и возможностей системы охлаждения при разгоне.

Результат теста можно опубликовать на официальном сайте разработчика для занесения в базу полученных результатов. В состав входят последние версии утилит GPU-Z и GPU Shark.

FurMark самый популярный инструмент для проверки количества попугаев, которые выдает та или иная видеокарта. Вы можете запустить данный тест на своем ПК или ноутбуке и посмотреть сколько наберет именно ваша видяха. А потом сравнить ваш результат с другими.

Официальный сайт: Ozone3d

Язык интерфейса: Английский

Распространение: бесплатно

Системные требования: Все версии Windows, начиная с XP (32 или 64-bit)

GPU Caps Viewer

GPU Caps Viewer — информационная утилита, позволяющая получить информацию о графической карте, провести несколько OpenGL и OpenCL тестов и вести мониторинг различных параметров GPU карт в реальном времени.

Программа отображает OpenGL, OpenCL и CUDA информацию для всех графических карт имеющихся в системе, а также предлагает GPU мониторинг карт NVIDIA GeForce и AMD Radeon с помощью имеющейся в её составе утилиты GPU Shark (тактовая частота, температура, использование GPU, скорость вращения вентилятора, рейтинг процессов потребителей и т.п.).

Также информацию о GPU можно просмотреть онлайн, браузером по ссылкам из программы, или перейти к загрузке драйвера для карты. Работа с ПО не требует большого знания компьютера.

Официальный сайт: Geeks3D’s

Язык интерфейса: Английский

Распространение: бесплатно

Системные требования: Windows 7 / 8 / 8.1 / 10 (32/64-bit)

NVIDIA NVFlash

Используется для прошивки BIOS видеокарт на Turing, Pascal и на всех старых картах NVIDIA.

Поддерживает перепрошивку BIOS на видеокартах NVIDIA ⇒

- GeForce RTX 2080 Ti, RTX 2080, RTX 2070, RTX 2060, GTX 1660, GTX 1650

- GeForce GTX 1080 Ti, GTX 1080, GTX 1070, GTX 1060, GTX 1050

- и многое другое, в том числе перепрошивка BIOS на старых графических процессорах NVIDIA.

Лучшая утилита для перепрошивки биоса видеокарт нвидиа. Более подробно о процессе перепрошивки, смотрите на официальном сайте разработчика.

Официальный сайт: TechPowerUp

Язык интерфейса: Английский

Распространение: бесплатно

Системные требования: Win 10, 8, 7 (32-битные и 64-битные), версия для Linux

Подборку ПО я буду по возможности обновлять и пополнять. Есть множество мелких утилит по работе с видеокартами, но часть из них уже давно не поддерживается, другие плохо работают. Я рассказал об основных рабочих версиях программ, которые перекрывают большинство потребностей. Если вы знаете еще что-то, то отпишитесь пожалуйста в комментариях.

Мне нравится1Не нравится

Александр

Увлечен компьютерами и программами с 2002 года. Занимаюсь настройкой и ремонтом настольных ПК и ноутбуков.

Задать вопрос

Display Driver Uninstaller

0%

Показать результатыПроголосовало: 1

Что такое видеокарта?

Обновлено: 16.11.2019 компанией Computer Hope

Также известный как адаптер дисплея , видеокарта , видеоадаптер , видеоплата или видеоконтроллер , видеокарта представляет собой карту расширения, которая подключается к материнской плате компьютера. Он используется для создания изображения на дисплее; без видеокарты вы не сможете увидеть эту страницу. Проще говоря, это часть оборудования внутри вашего компьютера, которая обрабатывает изображения и видео, а некоторые задачи обычно выполняет процессор.Видеокарты используются геймерами вместо интегрированной графики из-за их дополнительной вычислительной мощности и видеопамяти.

Визуальный обзор видеокарты компьютера

Ниже приведены два наглядных примера того, как видеокарта может выглядеть внутри компьютера. Во-первых, это изображение видеокарты AGP старой модели с несколькими типами соединений и компонентов на ней. Во-вторых, это пример более современной видеокарты PCI Express, используемой в современных игровых компьютерах.

ЗаметкаНекоторые материнские платы могут также использовать встроенную видеокарту, что означает, что видеокарта не является отдельной платой расширения, как показано ниже.

Порты для видеокарт

Рисунки выше также помогают проиллюстрировать типы видеопортов, используемых с видеокартами. Для получения дополнительных сведений о любом из этих портов щелкните ссылки ниже.

В прошлом VGA или SVGA были наиболее популярным соединением для компьютерных мониторов. Сегодня в большинстве плоских дисплеев используются разъемы DVI или HDMI.

Слоты расширения видеокарты (подключения)

Слот расширения видеокарты — это место, где карта подключается к материнской плате.На картинке выше видеокарта вставлена в слот расширения AGP на материнской плате компьютера. В процессе разработки компьютеров было несколько типов слотов расширения для видеокарт. Сегодня наиболее распространенным слотом расширения для видеокарт является PCIe, пришедший на смену AGP, пришедший на смену PCI, пришедший на смену ISA.

ЗаметкаНекоторые OEM-компьютеры и материнские платы могут иметь встроенную или встроенную в материнскую плату видеокарту.

Могу ли я установить более одной видеокарты?

Да.Карты AMD Radeon (использующие CrossFire) и NVIDIA GeForce (использующие SLI) могут одновременно работать с двумя или более видеокартами.

Адаптер, подключение, CUDA, выделенная графика, графический процессор, аппаратные средства, устройство вывода, устройство обработки, видеоускоритель, условия видеокарты

,Назначение видеокарты | Small Business

Стивен Мелендез Обновлено 24 апреля 2019 г.

Графическая карта, также называемая видеокартой или видеокартой, представляет собой печатную плату в компьютере со специализированным оборудованием, оптимизированным для отображения высококачественной графики с высокой скоростью скорость. Они есть в большинстве современных компьютеров, и хотя они иногда ассоциируются с геймерами, которые хотят получить от своих игр максимум удовольствия, они также полезны для профессиональных приложений, таких как использование Adobe Photoshop для редактирования фотографий или редактирования бизнес-видео.

Общие сведения о вашей видеокарте

Даже если вы не думаете, что использование вашего компьютера особенно графически интенсивно, может быть полезно иметь в вашем компьютере специализированную видеокарту.

Видеокарта по определению в компьютере обрабатывает математические операции, необходимые для быстрого отображения изображений и видео. Обычно он содержит выделенную память с произвольным доступом, или ОЗУ, микросхемы, используемые для хранения данных, относящиеся к визуальным носителям, и специализированный чип процессора, называемый графическим процессором, или ГП, который оптимизирован для работы с видео.

Разработчики программ, интенсивно использующих видео, создают подразделы своего программного обеспечения, которые напрямую управляют графическим процессором, а не основным центральным процессором компьютера. Поскольку графический процессор обрабатывает специализированные инструкции, предназначенные для видео, но даже несмотря на то, что центральный процессор является инструментом общего назначения, вы часто можете добиться большей производительности видео от компьютера, выбрав хорошую видеокарту, чем обновив его микросхемы ЦП или ОЗУ общего назначения.

Когда дело доходит до торговых марок, обычно выбирают видеокарты AMD и NVIDIA.

Встроенные графические процессоры и видеокарты

Вместо выделенной видеокарты некоторые компьютеры имеют так называемый встроенный или интегрированный графический процессор. Термин «встроенный графический процессор» относится к микросхеме, расположенной на основной плате компьютера или материнской плате.

Встроенный графический процессор часто дешевле, и он потенциально оставляет слот расширения, где печатная плата открыта внутри компьютера для использования в будущем. Он также может сэкономить электроэнергию по сравнению с выделенной видеокартой и меньше выделять тепло внутри компьютера, а это означает, что для обеспечения комфортной работы компьютера требуется меньше вентиляторов или других систем охлаждения.

Обратной стороной является то, что такие микросхемы обычно совместно используют ОЗУ с общими операциями компьютера, а это означает, что у компьютера меньше возможностей для выполнения сложных графических операций. Это означает, что для более интенсивных операций с видео (и видеоигр) часто бывает выгодно иметь отдельную видеокарту, хотя встроенный чип графического процессора часто подходит для просмотра случайного потокового видео или выполнения простого редактирования видео и фотографий.

Требования к вашей видеокарте

Требуется ли вам что-то помимо встроенного графического процессора и какие требования у вас могут быть, зависит от того, что вы делаете со своим компьютером.Если вы в основном пользуетесь программами, такими как Microsoft Word и Excel, отправляете электронную почту и выходите в Интернет, то карта, поставляемая с вашим компьютером, скорее всего, подходит.

Если вы выполняете более сложные задачи, такие как редактирование видео или фотографий для своего бизнеса, или вам нравится играть на компьютере в игры, вам может потребоваться более мощная видеокарта. Если вы не уверены, какая карта вам нужна, просмотрите список необходимого и рекомендуемого оборудования для некоторого программного обеспечения, которое вы планируете использовать. Часто программы перечисляют минимальные и рекомендуемые видеокарты по имени, а затем предлагают минимальный объем видеопамяти, чтобы вы могли убедиться, что они установлены.