Анализ видимости сайта в поисковых системах

Приложение поможет найти и проанализировать все запросы, по которым сайт занимает позиции в выдаче поисковых систем Яндекс и Google по заданному региону.Проверка видимости сайта приложением MegaIndex позволяет анализировать самые популярные страницы, запросы по которым ресурс занял лидирующие позиции в поисковых системах, упоминания в социальных сетях, а также видимость конкурентов и соотношение пересечения их показов с анализируемым сайтом.

Автоматически собрав список запросов видимости и их частотность, сервис считает количество эффективных показов по алгоритму коэффициента позиции, что позволяет узнать примерную посещаемость ресурса.

Приложение анализа видимости сайта включает в себя большое количество необходимых для продвижения данных, что позволяет анализировать лидеров ниши и составлять план работ по проекту.

Сервис независимый, так как использует собственный робот и алгоритм, который способен каждый день индексировать большое количество страниц, собирая необходимые данные и сохраняя историю.

Подробная инструкция

Megaindex API

Анализируйте проект

Получайте рекомендации по продвижению

Внeдряйте рекомендации

Получайте больше трафикa

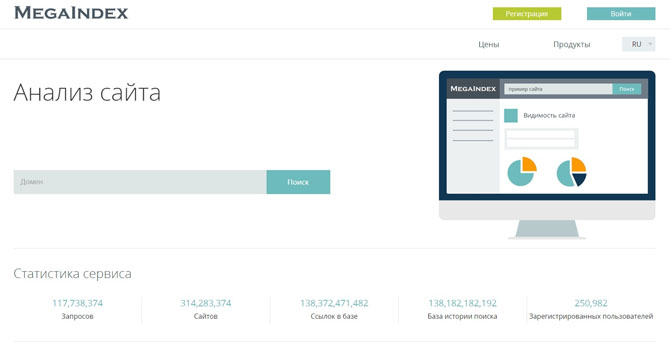

SEO-анализ сайта: индекс внешних ссылок, видимость сайта и аудит релевантности

Статистика сервиса

117,738,374 Запросов

Мегаиндекс

Универсальный SEO-инструмент.

MegaIndex является комплексной системой автоматизации продвижения и аналитики.

Сервис располагает собственным индексатором, который собирает информацию о сайтах по всему Интернету и сохраняет ее в базе данных.

В дальнейшем данные анализируются, обрабатываются и на выходе вы получаете готовый отчет содержащий все ключевые данные по сайту.

Также система хранит историю позиций сайтов в поисковых системах по более чем 120,000,000 запросов.

В совокупности это дает нашим пользователям возможность отслеживать динамику изменения позиций и оценивать эффективность продвижения.

Как проанализировать видимость сайта в поисковых системах Яндекс и Google

Сервис предназначен для анализа позиций ключевых запросов в выдаче, а также посещаемости сайта из поисковых систем Яндекс и Google.

Как проверить видимость сайта?

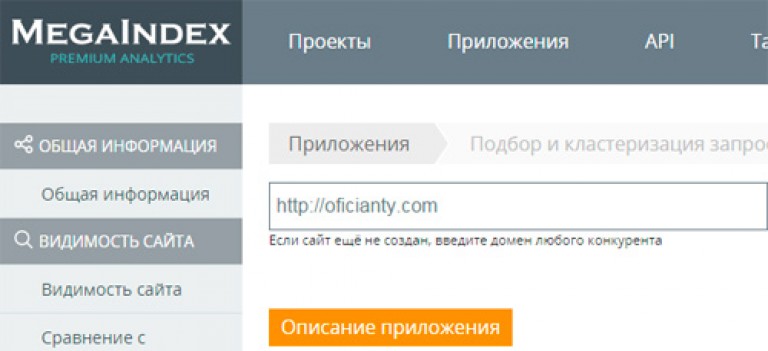

Добавить сайт для определения его видимости не сложно, для этого нужно на странице мониторинга вписать адрес сайта, затем выбрать регион и поисковую систему. Для примера возьмем известный сайт, который хорошо знаком всем любителям кино и посмотрим какова его органическая видимость в Яндекс и Google по Москве.

Посмотреть отчет по примеру

Интерфейс сервиса включает в себя следующие блоки и элементы:

1. Строка “Топ-регионы”.

Предназначена для быстрой смены региона и поисковой системы, а также для сравнения наглядного показателя количества эффективных показов сайта по другим регионам и каждой поисковой системе в целом.

2. Блок основных показателей видимости сайта.

Предназначен для быстрого и наглядного анализа показателей видимости сайта в поисковых системах и трафика, который они в текущий момент приводят.

Включает в себя:

- блок отображения количества эффективных показов в месяц.

- блок количества запросов, по которым данный сайт находится в ТОП-5, ТОП-10 и ТОП-20 выбранных поисковых систем;

3. Запросы и изменения за месяц. Блок генерирует и выводит ТОП-10 ключевых запросов по частотности за месяц.

Включает в себя следующие столбцы и элементы:

- Запрос. Список ключевых запросов по которым сайт занимает топовые позиции выдачи выбранной поисковой системы.

- Яндекс и Google Москва Органика или URL. Адрес посадочной страницы на сайте, которую определили выбранные поисковые системы по соответствующему ключевому запросу, а также количество внешних упоминаний о странице.

- Запросов в месяц. Количество раз, которое пользователи вводят ключевое слово в поисковых системах.

- Эффективность показов.

Рассчитывается согласно коэффициенту позиции, если позиция ТОП-1 значит показ = переход.

Рассчитывается согласно коэффициенту позиции, если позиция ТОП-1 значит показ = переход. - Кнопка ”Смотреть все”. Выводит общий показатель количества запросов в ТОП-10 выбранных поисковых систем по сайту. По нажатию на неё можно посмотреть подробную статистику по всем запросам, а также историю видимости запросов.

4. История видимости конкурентов. Блок с графиком за год, который наглядно демонстрирует видимость сайта по сравнению с его ближайшими конкурентами.

5. Страницы. Блок выводит ТОП-10 самых посещаемых страниц сайта согласно их доли трафика.

Включает в себя следующие столбцы и элементы:

- URL. Адрес страницы на сайте.

- Title. Содержимое тега title, названия страницы.

- Запросы. Количество запросов, по которым страница заняла позицию в ТОП-10 выбранной поисковой системы.

- Эффективность показов. Рассчитывается согласно коэффициенту позиции.

- Доля трафика.

Процентное соотношение количества трафика на страницу от полной посещаемости сайта за месяц.

Процентное соотношение количества трафика на страницу от полной посещаемости сайта за месяц. - Кнопка ”Смотреть все”. Выводит список всех, но не более 1000, страниц согласно их доли трафика.

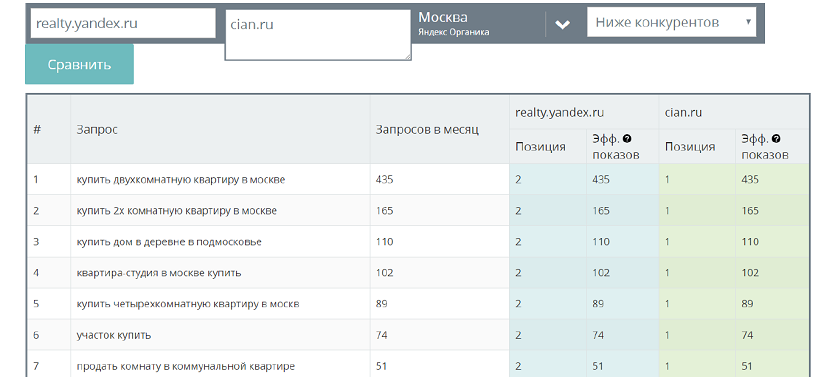

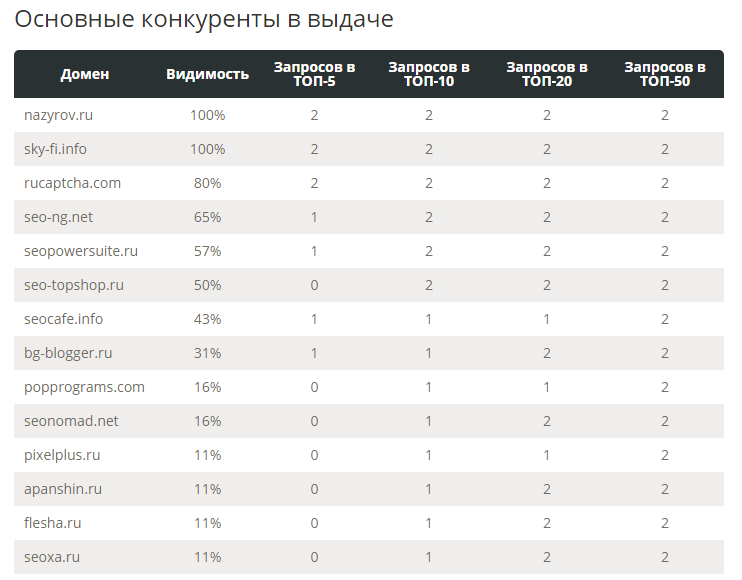

6. Конкуренты. Блок, выводящий показатели ближайших конкурентов сайта.

Включает в себя следующие столбцы и элементы:

- Домен. Адрес сайта конкурента.

- Пересечение показов. Количество показов сайта, при котором в ТОП-10, выдачи поисковых систем по тем же запросам, находится и конкурент.

- Показов сайта. Количество показов сайта в поисковых системах по тем же запросам.

- Показов конкурента. Соотношение, %.

7. График конкурентов. Демонстрирует процентное пересечение показов с конкурентами.

Почему необходимо следить за видимостью сайта?

При продвижении любого сайта всегда нужно анализировать свою нишу. Сервис анализа видимости сайта помогает комплексно просмотреть показатели текущей популярности сайта и сравнить их с показателями ближайших конкурентов.

Чтобы воспользоваться сервисом не нужно устанавливать никакого дополнительного программного обеспечения, серверы MegaIndex сделают всё за Вас. Дорожа своей репутацией мы улучшаем сервис из года в год учитывая современные тренды и нормы что позволяет нам находиться в числе профессионалов.

что это такое, как рассчитать

Видимость сайта — относительный показатель, который отображает количество показов сайта по ключевым словам. Для его расчета используется следующие параметры:

- позиция каждого запроса из семантического ядра;

- частотность запросов;

- коэффициент позиции.

Видимость сайта = СУММА (коэффициент позиции запроса * частотность запроса)

Чем выше суммарное значение, тем чаще пользователь видит ваш сайт в поисковой выдаче.

Как узнать поисковую видимость сайта

Сейчас существует большое количество сервисов, позволяющих рассчитать видимость вашего сайта в выдаче Яндекса и Google, например https://ru. megaindex.com/.

megaindex.com/.

Мы же используем собственный инструмент, который вычисляет данный показатель.

Для расчетов мы используем следующие коэффициенты:

| Позиция | Коэффициент |

|---|---|

| 1 | 1 |

| 2 | 1 |

| 3 | 1 |

| 4 | 0,85 |

| 5 | 0,6 |

| 6 | 0,5 |

| 7 | 0,5 |

| 8 | 0,3 |

| 9 | 0,3 |

| 10 | 0,2 |

| 11-30 | 0,05 |

| >30 | 0 |

Анализ видимости

С помощью данного показателя можно легко оценить общую картину продвижения сайта. Рост видимости говорит о том, что все больше частотных запросов выходит в ТОП поисковой выдачи.

Кроме того, видимость по семантическому ядру позволит быстро найти поисковых конкруентов сайта.

Алгоритм поиска конкурентов по видимости:

- Парсинг выдачи по каждому запросу до ТОП-30.

- Подсчет видимости для каждого из найденных сайтов, по формуле указанной выше.

- Сортировка всех найденных сайтов по видимости, от большего к меньшему.

Сайт с максимальным показателем видимости чаще остальных показывается в ТОП по исходному списку запросов.

Видимость сайта в выдаче поисковых систем: что это

Видимость сайта – это положение сетевого ресурса в поисковой выдаче по целевым поисковым запросам. Чем выше показатель, тем популярнее сайт. Общепринятой количественной оценки видимости сайта в поисковых системах не существует. Чаще всего высчитываемое значение зависит от популярности поисковой системы, частотности запроса, позиции ресурса в выдаче. Общий показатель видимости получают из отношения текущего значения к максимальному. Понять, что такое видимость сайта, помогут показатели, которые используют для определения этого значения.

vidimost-sajta1.jpg

vidimost-sajta1.jpgПоказатели, определяющие видимость сайта

Популярность поискового запроса. Показатель высчитывается путем подсчета количества обращений пользователей к поисковой системе с выбранным запросом за месяц.

Позиция сайта по запросу. Значением показателя является номер строки на странице результата поиска по выбранному ключевому слову.

Коэффициент позиции. Значение зависит от уровня внимания пользователей к ссылкам в поисковой выдаче в зависимости от позиции в топе. То есть чем ниже по списку расположен сетевой ресурс, тем меньше к нему внимания и ниже коэффициент позиции.

Коэффициент популярности поисковой системы. Значение высчитывают путем деления количества посетителей, пришедших из одной поисковой системы, на сумму пользователей из другой. Определяют трафик из разных поисковых систем при помощи инструментов сбора и анализа данных посещаемости сетевого ресурса, например «Яндекс. Метрики», Google Analytics.

Метрики», Google Analytics.

Для вычисления общей видимости сначала нужно определить текущее и максимальное значение. Текущей видимостью называют количество появлений сайта в результатах поиска по определенным запросам, независимо от позиции в поисковой выдаче. За максимальное значение берут количество появлений сайта на первых позициях по выбранным ключам.

Определение видимости сайта при помощи онлайн-сервисов

Видимость сайта в поисковых системах по ключевикам проще всего определить при помощи специальных инструментов, доступных как платно, так и бесплатно. Например, сервис «Мегаиндекс» автоматически рассчитывает множество показателей, включая видимость сайта в поисковиках. Компьютерная программа Site-Auditor имеет функцию определения видимости сайта в «Яндексе» и Google.

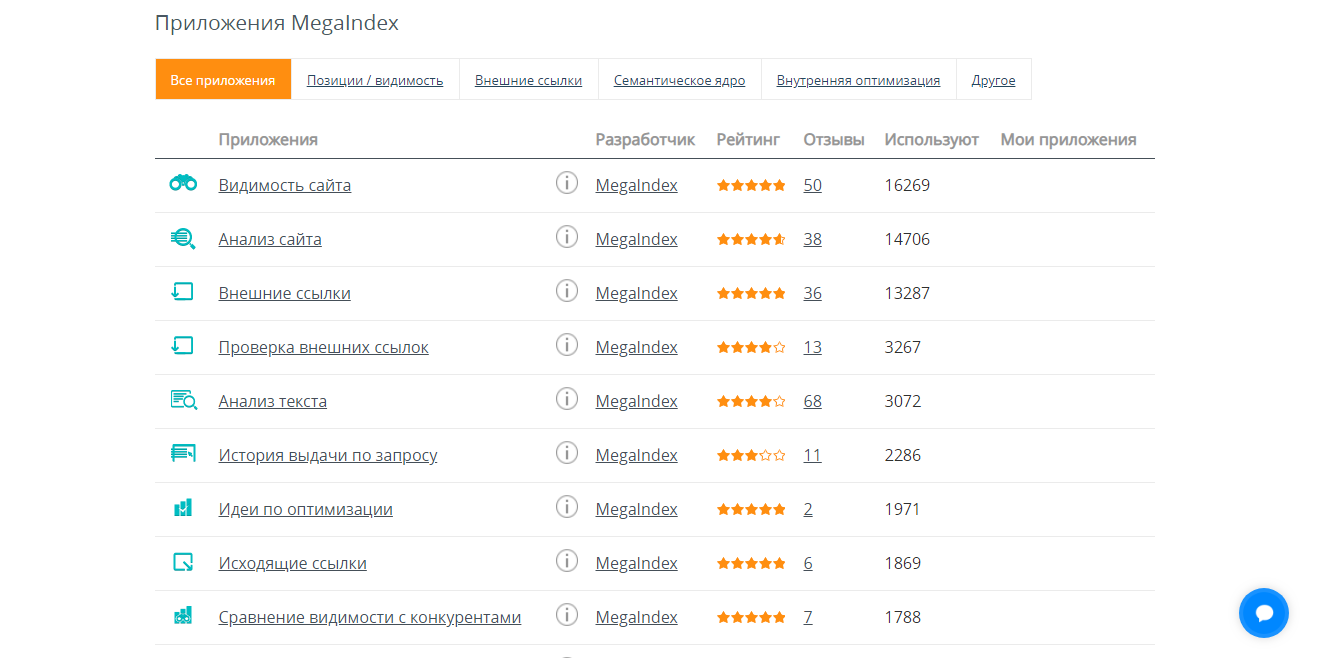

MegaIndex. На сайте сервиса пользователь найдет множество бесплатных инструментов, позволяющих получить различную информацию по сетевому трафику. Ими пользуются в процессе поисковой оптимизации, продвижения сайта, создания семантического ядра, определения CTR, релевантности веб-страниц по ключевому слову, вычисления других показателей, влияющих на ранжирование, посещаемость, поведенческие факторы.

Ими пользуются в процессе поисковой оптимизации, продвижения сайта, создания семантического ядра, определения CTR, релевантности веб-страниц по ключевому слову, вычисления других показателей, влияющих на ранжирование, посещаемость, поведенческие факторы.

vidimost-sajta2.jpg

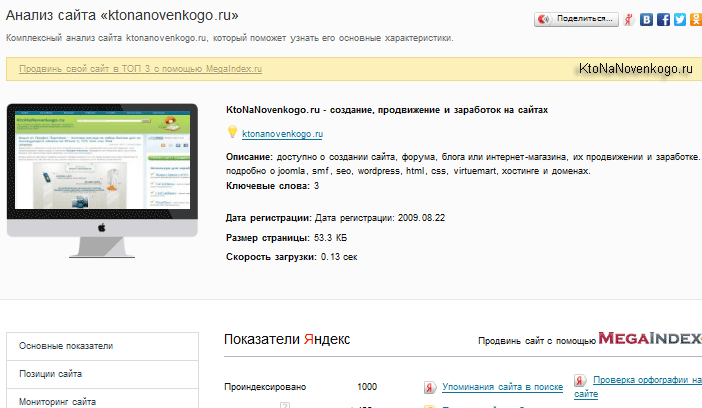

vidimost-sajta2.jpgЧтобы узнать видимость сайта, нужно посетить сайт MegaIndex, перейти на вкладку «SEO-сервисы», выбрать в меню «Видимость сайта». Далее в специальном поле указываем адрес любого сайта, по которому хотим рассчитать показатель видимости. После нажатия кнопки «Найти» сервис предоставит результаты автоматической обработки данных по указанному адресу. Значения будут отсортированы по нескольким параметрам.

Программа Site-Auditor. Для получения значения видимости сайта по ключевым запросам в программе есть функция их подбора. В специальное поле нужно ввести ключевое слово, после чего программа проверит поисковую выдачу и выдаст соответствующие результаты.

vidimost-sajta3.png

vidimost-sajta3.pngСервис PR-CY. Попав на страницу проведения анализа сетевого ресурса, пользователь может получить сводную информацию по продвигаемому сайту, включая его видимость сайта по основным ключевым запросам. Достаточно ввести домен и запустить проверку. Сервис работает автоматически, используя собственные настройки. То есть пользователь не может изменить параметры проводимого анализа, например указать запросы, по которым необходимо определить видимость сайта.

Видимость сайта в поисковых системах. Что это и как рассчитывается — Devaka SEO Блог

3107 просмотров

Изменение видимости сайта в поисковых системах является одной из важных метрик эффективности проведения SEO работ. Однако, что именно подразумевается под видимостью? И почему нельзя обойтись показателем поискового трафика сайта или количеством его показов на поиске?

Если дать общее определение: Видимость сайта в поисковых системах — это количественная мера присутствия сайта в зоне видимости целевой аудитории.

По всей видимости, термин «видимость сайта» ввел и популяризировал в Рунете Игорь Ашманов. Большинство существующих инструментов рассчитывают этот показатель на основе формулы, предложенной Игорем еще в 2005 году [1], а также она была заложена в первой программе для сеошников — Site Auditor. Поэтому, определение Ашманова будем называть классическим.

Упрощенный метод рассчета видимости сайтаУпрощенный метод основывается на понятии «доля рынка» [1], какую долю из всех показов по целевым запросам сайт забирает на рынке. И видимость сайта здесь оценивается как отношение доли показов в ТОП10 ко всем показам по целевым запросам. Считается, что если сайт попал в ТОП10 по какому-либо запросу, то будет осуществлен показ (т.е. сайт покажется пользователю, когда-то так и было).

Видимость = SUM(Частот запросов в ТОП10) / SUM(Частот) * 100%

Преимущества упрощенного метода: легко понять и объяснить клиенту.

Основные недостатки:

- Не все сайты в ТОП10 покажутся пользователю

- Всё, что за пределами ТОП10 находится в зоне невидимости

Как очень грубая оценка видимости, этот метод подходит, но год спустя Ашманов с командой модернизировали формулу.

Классический метод расчета видимостиЗа счет развития рекламы и изменения формата рекламных блоков часть результатов в ТОП10 стали спускаться ниже первого экрана, и гарантировать показ для сайтов в конце десятки выдачи стало сложно. Классическое определение видимости сайта использует вместо «показов» количество «эффективных показов». Пришлось вводить поправочные коэффициенты, учитывающие распределение внимания пользователей по позициям сайтов в органических результатах. Логика расчета видимости, при этом, не изменилась.

Видимость = (Эффективных показов) / (Всех показов) * 100%,

где

всех показов = SUM(Частот),

эффективных показов = SUM(Частотность запроса * Коэф.![]() видимости),

видимости),

а коэффициент видимости равен

- 1 для 1, 2 и 3 позиции

- 0.85 для 4

- 0.6 для 5

- 0.5 для 6 и 7

- 0.3 для 8 и 9

- 0.2 для 10 позиции

Термины «частота» и «частотность» в данной статье используются как синонимы.

Так как в классическом методе расчета видимости сайта эффективные показы считаются, по-прежнему, для ТОП10, то коэффициенты для позиций более 10 равны нулю. В этом плане, конечно, сложно сравнивать себя с кем-либо по видимости, кроме как с сайтами в ТОПе.

Этот метод широко используется в существующих инструментах оценки видимости, в частности, в SE Ranking [2], а также немного адаптированный для ТОП20 в Pixel Tools и Megaindex [3].

Зарубежные методы расчета видимости сайтаКлассическая видимость сайта зависит от выбранного пула запросов. Соответственно, мы не можем сравнивать два сайта по этому показателю, если они из разных ниш, или даже если из одной, но в ТОПе по совершенно разным запросам. В этом и нет смысла, так как есть другой показатель — оценка трафика. Но зарубежные специалисты так не считают.

В этом и нет смысла, так как есть другой показатель — оценка трафика. Но зарубежные специалисты так не считают.

Видимость сайта, практически, во всех зарубежных сервисах (Ahrefs, Searchmetrix, Sistrix) [4] и статьях считается, как отношение оценочного трафика сайта к общему трафику в поисковой системе. Общий трафик иногда, для упрощения, считается только для миллиона самых популярных фраз в базе. Аналогично считается видимость по Serpstat [5]. Сделано это для того, чтобы можно было сравнивать видимость для разных сайтов, в том числе для одного и того же, но с плавающей семантикой.

Например, так считается показатель видимости сайта в Serpstat:

Видимость = SUM(Частотность * CTR) / SUM(Частотность 1млн выбранных фраз) * 100% * 1000

Расчет ведется для ТОП20, в качестве CTR взяты коэффициенты показов от Ашманова, подкрученные для сглаживания кривой кликов.

Преимущества метода — можно сравнивать сайты между собой по показателю видимости без ввода собственных запросов.

Недостатки:

- Показатель коррелирует с оценкой трафика. Неясно, зачем две метрики.

- Попытка измерить в процентах, хотя метрика совершенно не процентная.

- Сезонность запросов очень сильно влияет на оценку видимости.

Расчет видимости сайта методом Serpstat/Ahrefs совершенно не связан с реальной видимостью сайта в поисковых системах.

ЗаключениеОценивать трафик или показы сайта полезно и нужно, но видимость учитывает ещё объем рынка. Повышение видимости сайта это борьба за долю рынка, которая оценивается по доле эффективных показов сайта по целевым запросам, в определенной поисковой системе, определенном регионе и на определенном устройстве.

В текущих реалиях сложно гарантировать показ сайта в поиске, даже если он находится на первой позиции. На количество эффективных показов будет влиять наличие и тип колдунщиков, а также дополнительных элементов интерфейса, смещающих органические результаты поиска.

Использование классического метода, по-прежнему, дает представление об эффективности SEO-работ (за исключением молодых сайтов). Однако, здесь есть место для улучшений. Динамические коэффициенты, учитывающие архитектуру результатов поиска, могут дать более точную оценку видимости сайта. Плюс, необходимо решить, учитывать ли показ в блоке ответов или в локал-паке. Интерфейсно они отделены от органики, но, по-прежнему, связаны с показателем видимости на поиске. Классическую видимость бесполезно измерять для молодых сайтов (она будет нулевой), даже если у них сильные подвижки по позициям из ТОП100 в ТОП30. Возможность менять коэффициенты вручную в существующих инструментах решило бы эту проблему.

Зарубежные сервисы при расчете видимости сайта оценивают долю трафика вместо доли эффективных показов. И по отношению к общему трафику поисковика вместо максимально возможного трафика сайта. Нет на них Ашманова!

Полезные ссылки:[1]Метод учета эффективности SEO (Ашманов и Партнеры)

Оценка видимости сайта в поисковых системах (Ашманов и Партнеры)

[2]Методология расчета видимости сайта в SE Ranking

[3]Оценка видимости в Пиксель Тулс

Анализ видимости сайта в Megaindex

[4]Что такое «Видимость» в Serpstat

[5]Как рассчитывается видимость в Ahrefs Rank Tracker

SISTRIX Visibility Index

Мегаиндекс — как бесплатно провести анализ видимости сайта в Яндексе и Гугле, подобрать запросы и проверить позиции

Обновлено 17 мая 2021- Проверка позиций сайта и другие возможности MegaIndex

- Видимость и бесплатный анализ сайта в МегаИндексе

- Возможности MegaIndex по платному продвижению сайтов

Здравствуйте, уважаемые читатели блога KtoNaNovenkogo. ru. Сегодня я хочу поговорить про набирающий последнее время популярность сервис Мегаиндекс. Он представляет из себя автоматизированную систему продвижения сайтов, где вы можете арендовать ссылки для продвижения своего проекта, но также вы можете провести там совершенно бесплатный анализ вашего ресурса на предмет его видимости в поисковых системах.

ru. Сегодня я хочу поговорить про набирающий последнее время популярность сервис Мегаиндекс. Он представляет из себя автоматизированную систему продвижения сайтов, где вы можете арендовать ссылки для продвижения своего проекта, но также вы можете провести там совершенно бесплатный анализ вашего ресурса на предмет его видимости в поисковых системах.

Ну, и еще у MegaIndex есть ряд бесплатных плюшек, способных привлечь к себе внимание вебмастеров. Будете ли вы продвигать сайт в этом сервисе или нет — решать, конечно же, вам, но вот воспользоваться набором бесплатных Seo инструментов высочайшего уровня и качества исполнения нужно обязательно, ибо это реальная халява.

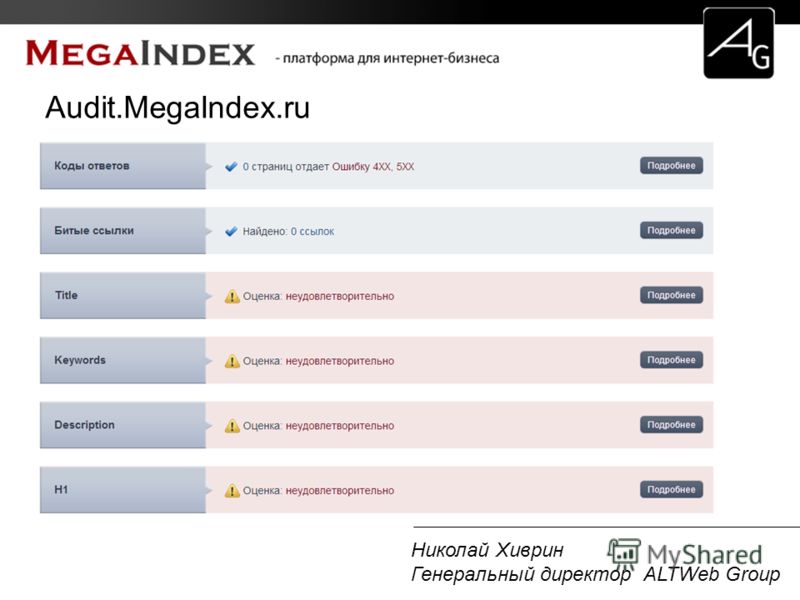

Сегодня мы поговорим про бесплатный анализ видимости вебсайта, но также я уже писал про полный аудит сайта в этой системе (опять же бесплатный, ибо платите вы в нем только за продвижение, а все остальное на халяву). Еще у них появился не так давно набор инструментов для вебмастеров и оптимизаторов и даже возможность получения Free хостинга.

Еще у них есть специальное расширение для всех популярных браузеров MegaIndex-Bar, которое поможет в анализе ресурсов доноров, например. Ну, а кроме традиционного ссылочного продвижения они еще предлагают и SMM продвижение через Socialtask, что тоже довольно интересно, особенно сегодня, когда многие старые методы уже не так эффективно работаю.

Проверка позиций сайта и другие возможности MegaIndex

При этом вам достаточно будет только зарегистрироваться в Мегаиндексе и можно сразу же посмотреть, по каким именно поисковым запросам ваш сайт имеет переходы из Яндекса и Гугла.

Причем, можно будет провести анализ не только своего ресурса, но и любого другого интернет проекта. Это может пригодиться, например, для проверки видимости сайтов конкурентов и коллег по цеху на предмет поиска и подбора ключевых слов, по которым им удалось уже продвинуться, а вы эти ключи почему-то упустили из внимания. Лично я это делал неоднократно — очень удобно и наглядно.

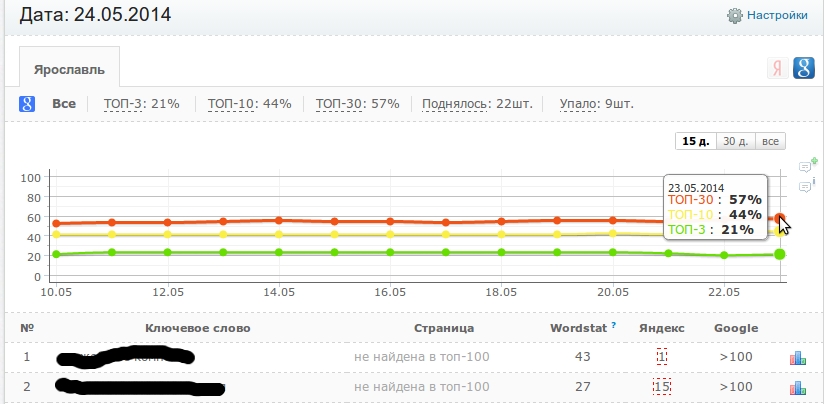

Кроме этого, MegaIndex можно использовать для бесплатного определения позиций вашего сайта (видимости в поисковиках) по практически неограниченному количеству ключевых слов. При этом у вас будет возможность отслеживать динамику изменения позиций в сравнении с тем промежутком времени, который вы зададите сами (будет отображаться снижение или повышение позиций рядом с каждым значением).

Естественно, что прежде, чем начать пользоваться всеми этими благами, вам нужно будет зарегистрироваться в Мегаиндекс. Далее, на странице «Мои сайты» добавить Урл своего или чужого проекта (подтверждать право владения здесь не потребуется):

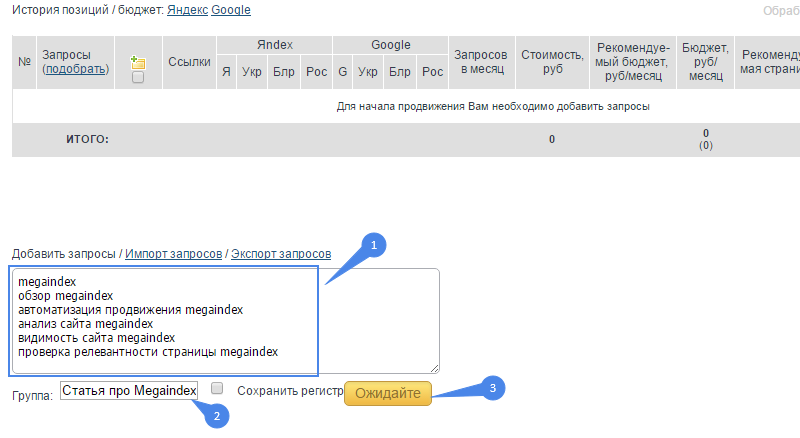

Следующим шагом будет добавление в MegaIndex списка поисковых запросов, по которым вы хотите продвигать свой проект (см. статью про Seo оптимизацию сайта). При желании вы, конечно же, можете начать закупку ссылок по этим запросам через этот агрегатор, но никто вас это делать принудительно заставлять не будет.

Мой проект, например, висит в Мегаиндексе уже несколько месяцев, и это нужно мне в первую очередь из-за очень удобного просмотра позиций в Яндексе и Google, а также для получения информации по видимости сайта в этих поисковых системах.

Итак, для добавления нужных вам поисковых запросов достаточно перейти по ссылке «Добавить», показанной на предыдущем скриншоте, и ввести список ключевых слов, по которым вы если даже не планируете продвигаться в этой системе, то хотя бы узнаете текущие позиции и правильность выбора вами целевых страниц (по одной фразе на каждой строчке):

После этого MegaIndex проведет первичное определение позиций вашего ресурса в Яндексе и Google по этим ключевикам (это гораздо удобнее и быстрее, чем проверять позиции через Site-Auditor), а также рассчитает еще массу параметров, которые мне, по большому счету, не важны (кроме частотности ключевых слов из Yandex WordStat), хотя, возможно, вам они что-нибудь скажут:

Понятно, что если данная статистика Мегаиндекса вам нужна не просто для информации и вы хотите начать ссылочное продвижение, то нужно будет, наверное, еще добавить для каждого запроса целевую страницу вашего вебсайта (в столбце «Страница для продвижения»), на которую будут вести закупаемые ссылки, а также поставить галочку в столбце «Активен» для начала процесса закупки.

Так, но нас сейчас интересует не ссылочное продвижение, а бесплатные методы анализа и аналитики успешности продвижения сайта. Посмотрим, что еще может нам предложить из своего арсенала этот агрегатор. Используем его, так сказать, по полной.

Видимость и бесплатный анализ сайта в МегаИндексе

Давайте будем считать, что проверку позиций по нужным нам ключевым словам мы в общих чертах разобрали. Теперь хочу сказать пару слов о других совершенно бесплатных возможностях Мегаиндекса, которые могут вам в той или иной степени пригодиться.

Начать, наверное, стоит с уже упомянутого чуть ранее сервиса просмотра видимости сайта. Там нам покажут первые 1000 поисковых запросов, по которым ваш web-проект занимает хоть сколько-нибудь значимые позиции в Яндексе и Google.

Для того, чтобы оценить видимость, вам нужно щелкнуть по вкладке из верхнего меню под названием «SEO сервисы» и выбрать из выпадающего списка вариант «Видимость сайта»:

В предложенную форму вводите Урл своего или чужого ресурса и жмете на кнопку «Найти». Найденные ключевые фразы будут отсортированы по такому параметру, как количество эффективных показов, который показывает их потенциал. Т.е. продвижение по более высоко расположенным в этом окне сервиса MegaIndex запросам будет более рентабельным в плане получения большего количества посетителей.

Найденные ключевые фразы будут отсортированы по такому параметру, как количество эффективных показов, который показывает их потенциал. Т.е. продвижение по более высоко расположенным в этом окне сервиса MegaIndex запросам будет более рентабельным в плане получения большего количества посетителей.

Что примечательно, вы можете выбрать из списка «сравнить с» нужную вам дату в прошлом и отследить динамику изменения позиций вашего web-проекта по ключевым словам (зеленые и красные степенные числа, отражающие рост или спад позиций).

В Мегаиндекс можно также посмотреть входящие ссылки на домен с указанием донора, текста ссылки и показателем Тиц:

Имеется и еще один бесплатный инструмент для быстрой проверки веб-сайта, который по своему функционалу очень похож на описанные мною когда-то онлайн сервисы для анализа сайтов, но в то же время он имеет и ряд своих особенностей.

Наверное, в этом агрегаторе есть еще что-нибудь бесплатное, интересное и полезное (кроме того, что было упомянуто в начале этой публикации), но я в этом пока еще не разбирался. Может вы мне что-то подскажите, уважаемые читатели.

Может вы мне что-то подскажите, уважаемые читатели.

Хотя, вот еще видео нашел по тому, как использовать рейтинг от Мегаиндекса, который позволит понять, стоит ли начинать бодаться в какой-либо тематике за место под солнцем или же ваших ресурсов заведомо на это не хватит:

Возможности MegaIndex по платному продвижению сайтов

Все, о чем я говорил выше, было доступно в MegaIndex совершенно бесплатно и направлено было, скорее всего, на то, чтобы пользователи захотели познакомиться с этой системой продвижения поподробнее, а возможно, что и захотели бы потратить в ней какие-то деньги на покупку ссылок. Вот.

Недавно я посмотрел видео по тому, как Мегаиндекс умеет подбирать именно к вашему сайту наиболее перспективные поисковые запросы, удовлетворяющие требованию «дешево и сердито» (по ним можно будет попасть в Топ за сравнительно маленькие деньги)

Попробовал все это посмотреть применительно к своему блогу и возникла еретическая мысль про небольшую закупку ссылок по некоторым из них. Т.е. в начале на вкладке «Мои сайты» я перешел по ссылке «Продвижение»:

Т.е. в начале на вкладке «Мои сайты» я перешел по ссылке «Продвижение»:

На открывшейся странице перешел по ссылке «Рекомендованные запросы«, которая расположена над основной таблицей:

Ну, а дальше уже вы увидите список из двадцати рекомендуемых ключевых фраз с указанием их частотности по статистике Яндекс Вордстат и рекомендуемой стоимости продвижения в месяц, которой по мнению MegaIndex будет достаточно для попадания в Топ.

Соотношение частотности запросов (пропорциональной ожидаемому количеству посетителей после попадания в Топ) и стоимости продвижения по некоторым из этих ключевых слов мне показались очень даже заманчивыми. Не знаю даже, смогу ли удержаться от того, чтобы не начать тратить деньги за закупку ссылок еще и в Мегаиндексе.

До этого я пробовал закупаться пока только в:

- Collaborator, описанный тут

- ГоГетЛинкс — здесь читайте о нюансах работы с ним

- ГетГудЛинкс — тут описание возможности по покупке ссылок в ГетГудЛинкс со страниц имеющих PR (большой статический вес)

- РотаПост — здесь полный обзор возможностей биржи

Ну, как бы, если вам лень смотреть, то отвечу, что разработчик сервиса MegaIndex считает покупку нескольких ссылок с одного и того же донора вполне уместным действием, и это вполне может принести такую же пользу, как и покупка с разных.

Во многом эта точка зрения обусловлена еще и тем, что по-настоящему хороших доноров, торгующих ссылками в рунете, вовсе не так уж и много. Другой вопрос: а как отыскать эти самые чудесные площадки? Возможно, что Мегаиндекс это знает.

Ну, и в заключении хочу сказать, что этот агрегатор вознамерился в последнее время полностью заменить собой Seo конторы, особенно в плане обслуживания клиентов со средними и маленькими бюджетами. К вашим услугам теперь заказ и настройка рекламы в Яндекс Директе и даже предоставление услуги персонального менеджера

Думаю, что найдется довольно много клиентов, которые не захотят платить очень большую маржу Сео компаниями и предпочтут воспользоваться услугами MegaIndex, ибо это будет сравнительно дешевле при практически таком же конечном результате. ИМХО.

Удачи вам! До скорых встреч на страницах блога KtoNaNovenkogo.ru

Crunchbase Профиль компании и финансирование

MegaIndex — Профиль компании Crunchbase и финансированиеMegaIndex — комплексная система автоматизации продвижения и аналитики.

- Industries

- Дата основания 1 мая 2015 г.

- Операционный статус Активен

- Последний тип финансирования не разглашается

- Номер телефона (415) 854-5671

MegaIndex — это комплексная система автоматизации для продвижения и аналитики.

У сервиса есть собственный индексатор, который собирает информацию о сайтах по всему Интернету и сохраняет ее в базе данных. В дальнейшем данные анализируются, обрабатываются и на выходе вы получаете готовый отчет, содержащий все ключевые данные по сайту. Сервис

позволяет просматривать подробный отчет по входящим / исходящим ссылкам, а также видимость сайтов в поисковых системах. Также в системе хранится история позиций сайта в поисковых системах по более чем 120 000 000 запросов. В совокупности это дает нашим пользователям возможность отслеживать динамику смены позиций и оценивать эффективность продвижения.

ПодробнееВыберите подходящее решение Crunchbase

Условия использования | Политика конфиденциальности | Карта сайта | © 2021 Crunchbase Inc. Все права защищены. (0.1.12194 568)

Расположение головного офиса

Количество сотрудников

Тип последнего финансирования

Статус IPO

Веб-сайт

Рейтинг CB (Компания)

Общая сумма, полученная за все раунды финансирования

Общее количество профилей сотрудников и Организация имеет в Crunchbase

Общее количество инвестиционных фирм и индивидуальных инвесторов

Описательное ключевое слово для организации (например,г. SaaS, Android, облачные вычисления, медицинское устройство)

Дата основания организации

Операционный статус организации, например, Активный, закрытый

Тип последнего раунда финансирования (например, посевной, серия A, частный капитал)

Независимо от того, является ли организация коммерческой или некоммерческой

Общий номер телефона организации

Маркетинговые инструменты для российского SEO / SEA, социальных сетей и Контент-маркетинг

Здесь мы хотели бы поделиться парочкой инструментов, которые необходимо иметь для вашей маркетинговой кампании в Рунете.Есть вопросы? Напишите нам по электронной почте.

JagaJam

URL: https://jagajam.com/en

JagaJam — это аналитическая платформа, которая помогает эффективно общаться между брендом и аудиторией социальных сетей. Он предоставляет брендам текущие данные о деятельности конкурентов в социальных сетях: их контент в социальных сетях и результаты, которых они достигают. Вы получите всю необходимую информацию, необходимую для оптимизации вашей контент-стратегии и повышения эффективности взаимодействия с целевой аудиторией социальных сетей.

LinkPad

URL: https://www.linkpad.ru

LinkPad — это российский сервис, который предоставляет информацию об обратных ссылках любого веб-сайта: доменах, URL-адресах, якорях, внешних ссылках,% ссылок nofollow / dofollow и другие полезные данные.

Megaindex

URL: https://megaindex.com

Megaindex предлагает десятки сервисов для SEO и PPC-аналитики, среди которых: видимость домена в органических результатах поиска, видимость в платных результатах Google и Яндекс, проверка обратных ссылок.В этой статье мы можем узнать о его алгоритме, который определяет, является ли обратная ссылка органической или платной.

SerpStat

URL: https://serpstat.com

С помощью SerpStat вы можете проверить, какие ключевые фразы используют ваши конкуренты в рекламной кампании в Google и Яндексе и по каким фразам получают органический трафик из поисковых систем. SerpStat имеет базу данных ключевых слов для Google в России, Украине, Беларуси, Казахстане, Болгарии, Литве, Латвии, США, Великобритании, Канаде, Австралии, Южной Африке.База данных Яндекса включает ключевые слова для Москвы, Санкт-Петербурга, Украины.

SimilarWeb

URL: https://www.similarweb.com

SimilarWeb — известный аналитический инструмент, который позволяет узнать статистику посещаемости веб-сайтов ваших конкурентов. Россия является одним из приоритетных рынков для SimilarWeb, поэтому русскоязычная база данных обновляется чаще и показывает довольно точную статистику.

Тельдери

URL: http://www.telderi.ru

Сервис по покупке и продаже российских сайтов и доменов.Аукционы обычно содержат данные об уровне и источниках трафика на сайт, текущих способах монетизации и ежемесячном заработке. Часто владелец продает свой веб-сайт «все-в-одном» вместе с его фан-страницами в социальных сетях и логином / паролем для услуг, на которых веб-сайт в настоящее время зарабатывает деньги (рекламные платформы, службы обмена ссылками и т. Д.).

TopVisor

URL: https://topvisor.com

Универсальная SEO-платформа. В нем есть несколько инструментов: проверка рейтинга для Яндекс, Google, Bing, Go.Mail.ru, Yahoo; Планировщик ключевых слов для Яндекс и Google; Ключевые слова Инструмент кластеризации; Обновления поисковых систем Яндекс, Google в Москве и Санкт-Петербурге.

Яндекс.Касса

URL: https://kassa.yandex.ru

Яндекс.Касса — универсальный платежный инструмент для интернет-магазинов, сервисов и благотворительных организаций. Вы можете использовать платежное решение для получения разовых или периодических платежей (с автоматическим списанием). Сегодня Яндекс.Касса — один из самых популярных провайдеров платежных услуг в России.Подробности о Яндекс.Кассе.

Яндекс.Метрика

URL: https://metrica.yandex.com

Аналитический сервис, очень похожий на Google Analytics, но специализирующийся в основном на поиске Яндекса и аналитике рекламных кампаний. Одно из преимуществ — вы можете просматривать запросы пользователей, которые пришли из результатов поиска Яндекса (в Google Analytics вы не можете увидеть эти данные). Кроме того, если вы проводите рекламную кампанию в Яндекс.Директе, рекомендуем следить за результатами в Яндекс.Метрике.Посмотрите наши видео на YouTube, чтобы узнать больше о Яндекс.Метрике.

Сайт, сканирующий веб-пауки, 23 апреля 2016 г.

Сайт, сканирующий веб-пауки, 23 апреля 2016 г. Когда я просматривал страницу на сайте сегодня утром, страница долго загрузить в моем браузере. Я проверил Доступ к Apache log, чтобы увидеть, что он показывает в отношении активности сайта, поскольку я заметил несколько паутины сканеры, также известные как веб-пауки, заходили на сайт вчера. Проверка доступа войти с помощью команды tail, Я видел следующие записи как последние несколько записей в журнале в то время, когда я проверил:180.76.15.32 - - [23 / апр / 2016: 09: 28: 55 -0400] "GET / downloads / windows / network / Em ail / simplecheck.php HTTP / 1.1 "200 7580" - "" Mozilla / 5.0 (совместимо; Baiduspider /2.0; + http: //www.baidu.com/search/spider.html) " 157.55.39.20 - - [23 / апр / 2016: 09: 28: 34 -0400] "GET / blog // blosxom / 2014/03/06 / HT TP / 1.1 "200 14776" - "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.co m / bingbot.htm) " 5.9.98.178 - - [23 / апр / 2016: 09: 28: 44 -0400] "GET / blog // blosxom / 2013/06/29 HTTP / 1.1 "200 16491" - "" Mozilla / 5.0 (совместимый; MegaIndex.ru / 2.0; + http: // мегаиндекс .com / сканер) " 157.55.39.57 - - [23 / апр / 2016: 09: 28: 58 -0400] "GET / blog / blosxom / 2010 / HTTP / 1.1" 200 263330 "-" "Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bing bot.htm) " 5.9.98.178 - - [23 / апр / 2016: 09: 29: 06 -0400] "GET / blog // blosxom / 2013/06/28 HTTP / 1.1 "200 15890" - "" Mozilla / 5.0 (совместимый; MegaIndex.ru/2.0; + http: // megaindex .com / сканер) " 157.55.39.20 - - [23 / апр / 2016: 09: 29: 18 -0400] «GET / info / tools / mt500w_work_light /697054-2T.jpg HTTP / 1.1 "200 6532" - "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + ht tp: //www.bing.com/bingbot.htm) " 5.9.98.178 - - [23 / апр / 2016: 09: 29: 20 -0400] "GET / blog // blosxom / 2013/06/23 HTTP / 1.1 "200 13266" - "" Mozilla / 5.0 (совместимый; MegaIndex.ru/2.0; + http: // megaindex .com / сканер) " 157.55.39.20 - - [23 / апр / 2016: 09: 29: 42 -0400] "GET / template / ads / commjunction / или eilly_200x200 HTTP / 1.1 "200 334" - "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + http : //www.bing.com/bingbot.htm) " 5.9.98.178 - - [23 / апр / 2016: 09: 29: 35 -0400] "GET / blog // blosxom / os / windows / softw являются / network / snmp HTTP / 1.1 "200 17988" - "" Mozilla / 5.0 (совместимый; MegaIndex.ru/ 2.0; + http: //megaindex.com/crawler) " 54.211.105.220 - - [23 / апр / 2016: 09: 29: 53 -0400] "GET / HTTP / 1.1" 200 2972 "-" "M ozilla / 5.0 (совместимый; linkdexbot / 2.0; + http: //www.linkdex.com/bots/) "

То есть, все записи были для поисковых роботов. Первый, Baiduspider, это управляет Baidu, китаец веб-сервисы и поисковая система. В настоящее время, Алекса Интерент, дочерняя компания Amazon.com, которая оценивает доменные имена по популярности в мире и стране, связанной с доменным именем, занимает байду.ком как четвертый по популярности веб-сайт в мире и номер один в Китае.

Следующий краулер, который я увидел, был bingbot, поисковый робот Microsoft. Поисковый робот — это экземпляр программный агент, который иногда называют «ботом», сокращенно от «программного робота», который Вот почему поисковые роботы часто включают в свое имя слово «бот».

Примечание: иногда какой-то паук, заходящий на ваш сайт, может не быть связан с объектом, с которым он якобы связан. Microsoft имеет статья, Как проверить, что Bingbot является Bingbot, о том, как вы можете использовать обратный DNS выполняет поиск, чтобы проверить, отображается ли в журналах IP-адрес, ассоциироваться с поисковым роботом Microsoft, Bingbot, на самом деле ассоциируется с этим ботом.

Linkdex — это поиск компания по оптимизации двигателя (SEO), основанная в 2009 г. с персоналом в Лондоне, Нью-Йорке и Лос-Анджелесе.

MegaIndex также занимается поисковой оптимизацией, примечаний на его сайте:

Это система автоматизации входящего маркетинга, обеспечивающая надежную работу в сети. данные аналитики. У сервиса есть собственный краулер, который собирает данные о сайты по всему Интернету. MegaIndex анализирует и обрабатывает данные и предлагает вам это в виде комплексного интернет-маркетинга и SEO. отчеты, содержащие ключевые онлайн-показатели эффективности любого веб-сайта включая профиль входящих ссылок, видимость SERP, просмотры по ключевым словам и более.MegaIndex содержит историю поисковой выдачи для более чем 120 000 000 ключевых слов.

Я заметил, что связанные с ним записи в журнале относятся к MegaIndex.ru. RU — код страны для России, но когда я выполнил обратный поиск DNS на IP адрес, я увидел код страны DE, который является кодом страны для Германии. RIPE, европейский региональный Интернет-реестр показывает IP-адрес, который я видел в журнале доступа к сайту был назначен Hetzner Online AG в Германии — см. Запрос к базе данных RIPE для 5.9.98.178.

Alexa в настоящее время сообщает о 33 379 мировом рейтинге для megaindex.com. и занимал в России 2 483 места. Сайт MegaIndex предоставляет возможность владелец веб-сайта или разработчик, чтобы увидеть обратные ссылки, т. е. Ссылки с других сайтов на его или ее сайт были обнаружены MegaIndex.

Некоторые подробности о веб-пауках, которые я видел при сканировании сайта, перечислены ниже:

Примечание. Мировой рейтинг сайта Alexa может меняться ежедневно. Меньшие числа лучше с точки зрения рейтинга популярности.Предупреждение что Alexa обычно оценивает рейтинг на основе собственных пользователей, т. е. рейтинг — это несколько выборочная мера — см. Как определяется рейтинг посещаемости Alexa? крупица соли требуется, но они могут дать вам приблизительное представление о популярности сайта по сравнению с популярностью других сайтов.

Tool Highlight Tuesday — MegaIndex

Привет, друзья SEO. Если вы похожи на меня, вы любите данные, и нет ничего лучше, чем бесполезные бесплатные данные.Особенно, когда это бесплатные данные по ссылкам. Сегодня я хочу познакомить вас с инструментом, который делает то же самое, что и некоторые другие, но прямо сейчас у вас есть бесплатные данные, которые вы можете уловить. MegaIndex.com создает собственный индекс данных о ссылках, используя собственный поисковый робот с 314 миллионами доменов и 138 миллиардами URL-адресов. Инструмент все еще довольно новый и нуждается в улучшении, но Free — это довольно привлекательная цена.

Если у вас есть более мелкие клиенты, вы только начинаете или просто хотите посмотреть, есть ли ссылки на них, которых вы не видите в Ahrefs, Majestic или Moz, — тогда MegaIndex может стать для вас инструментом.Что мне действительно понравилось, так это то, как инструмент отображает данные в виде диаграмм и графиков. Конечно, большинство аналогичных инструментов тоже это делают, но они просто кажутся очень четкими и хорошо выполненными, особенно инструмент Диаграмма Венна при сравнении одного веб-сайта с другими.

MegaIndex использует новую терминологию, по крайней мере, новую для меня:

- Донор — веб-сайт, который ведет на проверяемый вами сайт

- Acceptor — веб-сайт, связанный с

- Биграмма — ключевое слово / ключевая фраза для поиска, в которой используется ровно 2 слова

- Триграмма — ключевое слово / ключевая фраза для поиска, в которой используется ровно 3 слова

Действительно хорошо

Команда MegaIndex очень быстро реагировала на мои запросы и на несколько обнаруженных мною ошибок.Инструмент также загружается очень быстро даже на моем супер медленном AT&T U-Verse, за который я заплатил, чтобы они делали быстрее, и он почему-то стал медленнее. Мне нравятся диаграммы и графики, которые создает их инструмент, и он определенно нацелен на успех на рынке SEO Martech.

Мне очень понравился «Бенчмарк для доноров» и то, как он сравнивает сайт, который вы изучаете, с другими сайтами, которые вы указали.

Требуется улучшение

Функция удаленных ссылок

Эта функция предназначена для того, чтобы сообщить вам, какие ссылки были удалены поисковым роботом и в какой день.Это было бы действительно мощно и полезно, но, к сожалению, сейчас это работает неправильно. Я уверен, что команда MegaIndex придумает, как это исправить, но в моем собственном списке удаленных ссылок я увидел, что единственная ссылка, которую я когда-либо получал с Search Engine Land, была удалена. Оказывается, это неверно, так как переход на страницу в прямом эфире покажет.

Я надеюсь, что они скоро исправят эту функцию и надстроят дополнительные функции, такие как оповещения об удалении ссылок или двойную проверку для платных пользователей, которая повторяет проверку, чтобы убедиться, что ссылка действительно была удалена, прежде чем сообщать об этом.

Ссылки с течением времени

MegaIndex.com также включает функцию изменения количества ссылок, которая показывает, сколько ссылок вы приобрели и потеряли с течением времени. Независимо от того, на каком сайте я проверяю, эта функция, кажется, всегда запускается примерно 8 апреля 2015 года, и нет никакого способа вернуть ее назад или сократить временные рамки. Я предполагаю, что это связано с тем, что инструмент был запущен в этот день или немного раньше, и все в порядке, но почему я не могу сократить время до нескольких последних месяцев?

Также нет возможности увидеть совокупное представление, например, с помощью инструмента Majestic.Мне нравится часть удаленных ссылок на диаграмме, но она уже оказалась неисправной, как показано выше, поэтому я действительно хотел бы увидеть способ получить свою статистику без включения удаленных ссылок.

Наконец, я не совсем уверен, какой URL проверяет инструмент. Когда вы даете ему URL-адрес веб-сайта с www. или http: // впереди, он удаляет все это и использует только корневой домен. Однако любой другой субдомен, похоже, прижился, включая субдомены, такие как WWW2.example.com. Для меня это означает, что инструмент фактически сканирует как www, так и не www версии URL, но каталогизирует все только в корневом домене.Если это так, он никогда не сообщает вам об этом, когда вы запускаете запрос.

В целом мне нравится простота MegaIndex, некоторые его функции, быстрая загрузка (здесь, в Далласе) и тот факт, что я могу просматривать его бесплатно прямо сейчас. Чтобы убедить меня заплатить за это, хотя мне бы очень хотелось увидеть исправление еще нескольких ошибок в том, как инструмент вычисляет вещи, немного больший индекс или URL-адреса (Ahrefs содержит 2 триллиона URL-адресов, Mega Index 138 миллиардов) и некоторые функции, которые я не могу найти с другими индексами ссылок.Тем не менее, команда постоянно совершенствуется и может в конечном итоге получить очень уникальный и полезный индекс ссылок, который будет прибыльным, особенно для предприятий, пытающихся создать большие наборы данных о своих усилиях по построению ссылок / заработку.

Как запретить поисковым системам сканировать ваш веб-сайт

Для того, чтобы другие люди могли найти ваш веб-сайт, сканеры поисковой системы , также иногда называемые ботами или пауками, будут сканировать ваш веб-сайт в поисках обновленного текста и ссылок для обновления своих поисковых индексов.

Как управлять сканерами поисковых систем с помощью файла robots.txt

Владельцы веб-сайтов могут указать поисковым системам, как им сканировать веб-сайт, с помощью файла robots.txt .

Когда поисковая система просматривает веб-сайт, она сначала запрашивает файл robots.txt , а затем следует внутренним правилам.

Отредактируйте или создайте файл robots.txt

Файл robots.txt должен находиться в корне вашего сайта. Если ваш домен был например.com следует найти:

У вас на сайте :

https://example.com/robots.txt

На вашем сервере :

/home/userna5/public_html/robots.txt

Вы также можете создать новый файл и называть его robots.txt как обычный текстовый файл, если у вас его еще нет.

Поисковая машина Пользовательские агенты

Наиболее распространенное правило, которое вы использовали бы в файле robots.txt , основано на User-agent сканера поисковой системы.

Сканеры поисковой системыиспользуют пользовательский агент , чтобы идентифицировать себя при сканировании, вот несколько распространенных примеров:

Топ-3 поисковых систем США Пользовательские агенты :

Googlebot Yahoo! Бингбот Slurp

Обычная поисковая система Заблокированы пользовательские агенты :

AhrefsBot Байдуспайдер Ezooms MJ12bot ЯндексБот

Доступ сканера поисковой системы через файл robots.txt

Существует несколько вариантов управления сканированием вашего сайта роботами .txt файл.

Правило User-agent: определяет, к какому User-agent применяется правило, а * — это подстановочный знак, соответствующий любому User-agent.

Запрещено: устанавливает файлы или папки, для которых запрещен просмотр .

Установить задержку сканирования для всех поисковых систем :

Если бы на вашем веб-сайте было 1000 страниц, поисковая система потенциально могла бы проиндексировать весь ваш сайт за несколько минут.

Однако это может привести к высокому использованию системных ресурсов, поскольку все эти страницы загружаются за короткий период времени.

A Crawl-delay: из 30 секунд позволит сканерам проиндексировать весь ваш 1000-страничный веб-сайт всего за 8,3 часа

A Crawl-delay: из 500 секунд позволит сканерам проиндексировать весь ваш 1000-страничный веб-сайт за 5,8 дней

Вы можете установить Crawl-delay: для всех поисковых систем одновременно с:

Агент пользователя: * Задержка сканирования: 30

Разрешить всем поисковым системам сканировать веб-сайт :

По умолчанию поисковые системы должны иметь возможность сканировать ваш веб-сайт, но вы также можете указать, что им разрешено с помощью:

Агент пользователя: * Запрещено:

Запретить сканирование веб-сайта всем поисковым системам :

Вы можете запретить любой поисковой системе сканировать ваш веб-сайт с помощью следующих правил:

Агент пользователя: * Запрещено: /

Запретить сканирование веб-сайта одной конкретной поисковой системе :

Вы можете запретить только одной конкретной поисковой системе сканировать ваш веб-сайт с помощью следующих правил:

Агент пользователя: Baiduspider Запрещено: /

Запретить всем поисковым системам использование определенных папок :

Если бы у нас было несколько каталогов, например / cgi-bin / , / private / и / tmp / , мы не хотели бы, чтобы боты сканировали, мы могли бы использовать это:

Агент пользователя: * Запрещено: / cgi-bin / Запрещено: / частный / Запрещение: / tmp /

Запретить доступ всех поисковых систем к определенным файлам :

Если бы у нас были файлы типа contactus.htm , index.htm и store.htm мы не хотели, чтобы боты сканировали, мы могли бы использовать это:

Агент пользователя: * Запрещено: /contactus.htm Disallow: /index.htm Запрещено: /store.htm

Запретить все поисковые системы, кроме одной :

Если бы мы только хотели разрешить Googlebot доступ к нашему каталогу / private / и запретить всем другим ботам, мы могли бы использовать:

Агент пользователя: * Запрещено: / частный / Агент пользователя: Googlebot Запрещено:

Когда Googlebot считывает наши robots.txt , он увидит, что сканирование каталогов не запрещено.

Primo Library Discovery Service — поиск академических ресурсов

Оценка воздействия службы Primo Library Discovery

Эффективная служба поиска в масштабе сети может улучшить использование ваших библиотечных коллекций и усилить роль вашей библиотеки в исследовательском процессе. Фактически, исследования подтверждают это: библиотеки, которые оценили свои инструменты открытия, обнаружили, что они оказывают положительное влияние на учреждение.

Вот несколько ярких примеров недавних исследований, изучающих эффективность открытий в масштабе Интернета в исследовательских библиотеках:

- В Манчестерском университете в Англии личные и онлайн-опросы более 1000 пользователей библиотеки с 2013 по 2016 год показали, что посетители библиотеки полагались на инструмент поиска библиотеки, чтобы найти соответствующий контент чаще, чем Google, Google Scholar или даже списки чтения курса. В течение этого четырехлетнего периода посетители пользовались услугами библиотеки почти на 10% больше, чем четыре года назад.Между тем, использование Google и Google Scholar снизилось и осталось на прежнем уровне соответственно.

- В исследовании, проведенном по заказу Jisc в 80 исследовательских учреждениях Соединенного Королевства в 2016 году, респондентов спросили, как их пользователи находят информацию. Сервисы Discovery показали себя не хуже, чем Google Scholar, и намного опередили стратегии, такие как абстрактные базы данных и Википедия, по целому ряду действий, таких как обнаружение и доступ к известным объектам, выполнение начального предметного поиска и ведение расследования.73 из 80 опрошенных библиотек заявили, что решения для поиска полезны при поиске конкретной журнальной статьи, а 69 заявили, что они полезны при поиске информации без известного названия.

- Опрос, проведенный в 2016 г. компанией Ithaka S&R, показал, что три четверти библиотек колледжей и университетов в Соединенных Штатах считают «использование службы обнаружения на основе индексов для облегчения доступа к информационным ресурсам» очень важным приоритетом. В аналогичном опросе, проведенном в 2013 году, почти 80% респондентов заявили, что они могут помочь пользователям находить новые элементы, о которых они не знают, гораздо более эффективно с помощью своего инструмента обнаружения, и более половины заявили, что их решение для обнаружения сделало скорость и эффективность библиотечных поисков намного лучше.

Как показывают эти и другие исследования, как количественный, так и качественный анализ показывают, что решения для открытий имеют большое влияние на учреждения по всему миру. Эти выводы подтверждаются анализом анонимных данных об использовании всех библиотек с помощью службы обнаружения Ex Libris Primo. Обобщенная статистика использования Primo указывает на более чем 100% -ное увеличение общего количества просмотренных страниц и общего количества пользовательских сеансов на учреждение с января 2014 года по март 2017 года.

Чтобы узнать, как можно успешно оценить собственную службу обнаружения, загрузите этот бесплатный технический документ.

megaindex.com оценочный сайт стоимостью $ 27,072

Уникальных посетителей за день : Расчетное количество уникальных посетителей за день. Это значение пытаются оценить с помощью нескольких источников, таких как Alexa, Quantcast, Compete, Google Ad Planner и т.д.

Ежедневных просмотров страниц : Расчетное общее количество ежедневных просмотров страниц.

Сред. Время на сайте : Среднее время на сайте рассчитывается на основе значений alexa.

Ежедневный доход от рекламы : Расчет ежедневного дохода от рекламы основан на доходе от AdSense. Сегодня большинство веб-мастеров используют Google AdSense. Наша оценка пытается имитировать для лучшего использования AdSense, если этот веб-сайт использует 3 объявления AdSense на всех страницах.

Ежемесячный доход от рекламы : Ежемесячный расчет дохода от рекламы основан на ежедневном доходе от рекламы.

Годовой доход от рекламы : Годовой расчет дохода от рекламы основан на ежедневном доходе от рекламы.

Moz Links : Moz Link count. Это значение дает только обратные ссылки с других доменов, оно не включает счетчик внутренних (обратных ссылок с того же веб-сайта) обратных ссылок. Низкие, но качественные обратные ссылки лучше, чем высокие, но некачественные обратные ссылки. Таким образом, это значение имеет меньшее влияние на алгоритм расчета цены нашего сайта. Обратные ссылки очень связаны с рейтингом страниц Google, поэтому мы считаем, что ценность PR более важна, чем количество обратных ссылок.

Majestic ссылающиеся домены : общее уникальное количество доменов, указывающих на этот веб-сайт

Majestic ссылающиеся IP-адреса : Общее уникальное количество IP-адресов, указывающих на этот веб-сайт. С одного IP-адреса можно разместить более 1 веб-сайта. Это засчитывается как 1, только если существует более 1 веб-сайта.

Alexa Backlinks : Alexa Backlink Count. Alexa очень быстро индексирует и показывает обратные ссылки веб-сайта. Вы всегда должны проверять страницу обратных ссылок alexa ваших конкурентов.

SemRush Links : Общее количество обратных ссылок, указывающих на запрошенный домен согласно SemRush.

Majestic External B. : общее количество внешних обратных ссылок на корневой URL.

Moz DA (аутентификация домена) : Moz Domain Authority (DA) — это оценка рейтинга поисковой системы, разработанная Moz, которая предсказывает, насколько хорошо веб-сайт будет ранжироваться на страницах результатов поисковой системы. Оценка авторитета домена варьируется от 1 до 100, причем более высокие оценки соответствуют большей способности к ранжированию.Авторитет домена рассчитывается путем оценки нескольких факторов, включая связывание корневых доменов и общее количество ссылок, в единую оценку DA. Затем эту оценку можно использовать при сравнении веб-сайтов или отслеживании «рейтинга» веб-сайта с течением времени. Авторитет домена не является показателем, используемым Google при определении рейтинга в поиске, и не влияет на результаты выдачи.

Moz PA (Полномочия страницы) : Это значение показывает корневую страницу данного домена. Полномочия страницы / Полномочия страницы (PA) — это оценка, разработанная Moz, которая предсказывает, насколько хорошо конкретная страница будет ранжироваться на страницах результатов поисковой системы.Оценка авторитетности страницы варьируется от 1 до 100, причем более высокие оценки соответствуют большей способности к ранжированию.

Moz Rank : MozRank — это разработанный SEOmoz, аналогичный рейтингу страниц в Google и масштабируемый 10-балльный показатель авторитета ссылок на веб-сайты или популярности данной страницы в Интернете. MozRank — это, по сути, показатель популярности ссылок, который отражает важность веб-страницы в Интернете по сравнению с другими.

Majestic Trust Flow : Majestic Trust Flow — это показатель, показывающий, насколько заслуживает доверия сайт, путем измерения его качества и представляет собой оценку, основанную на качестве по шкале от 0 до 100.Это число в основном показывает качество сайтов, ссылающихся на сайт.

Majestic Citiation Flow : Majestic Citation Flow — это оценка от 0 до 100 для измерения мощности ссылок, которые несет веб-сайт или ссылка. Он отражает количество «ссылочного веса», которое сайт имеет и может передать на другой сайт через ссылки.

Рейтинг SemRush : Рейтинг SemRush — это своего рода рейтинг, рассчитываемый SemRush, аналогичный рейтингу страниц в Google.

Ключевые слова в топ-100 : Общее количество ключевых слов, по которым сайт в органическом поиске Google находится в топ-100 по данным SemRush.

Индексирование поисковыми системами : Индексирование — один из самых сложных факторов, если у вас большой веб-сайт, поэтому мы считаем, что видимость в поисковых системах очень важна для расчета стоимости веб-сайта. Счетчик индекса показывает также размер содержимого веб-сайта. А огромный контент увеличивает возможность подсчета посетителей и дохода от рекламы. Обычно больше контента и больше проиндексированных страниц всегда лучше.

Alexa Rank : Alexa Global Rank. Alexa — один из самых распространенных трекеров сайтов.Он измеряет посещаемость сайтов и сравнивает трафик всех остальных сайтов. К сожалению, он не всегда дает правильные значения из-за манипуляций. Но это по-прежнему самый надежный трекер. А без значений ранга alexa сложно оценить стоимость домена.

Скорость веб-сайта : Скорость загрузки веб-сайта в секунду. Это значение показывает время загрузки веб-сайта в среднем для веб-браузеров реальных пользователей. Это время не включает время загрузки всех изображений, таблиц стилей и т.д., но включает время загрузки DOM…

Лайков в Facebook : количество лайков, связанных с корневым URL-адресом в Facebook.

Акции в Facebook : Сколько раз к странице поделились в Facebook

Реакции Facebook : Количество реакций, связанных с URL-адресом на Facebook

Facebook Комментарии : Количество комментариев, относящихся к URL-адресу на Facebook

.

Рассчитывается согласно коэффициенту позиции, если позиция ТОП-1 значит показ = переход.

Рассчитывается согласно коэффициенту позиции, если позиция ТОП-1 значит показ = переход. Процентное соотношение количества трафика на страницу от полной посещаемости сайта за месяц.

Процентное соотношение количества трафика на страницу от полной посещаемости сайта за месяц.