Как забанить сайт конкурента в выдаче и защитить себя

Опубликовано: 13.03.2015 11:10Просмотров: 19634

Всем привет, сегодня я бы хотел поделиться с вами своими мыслями о том, как можно забанить сайт конкурента и не дать провести данное действие со своим сайтом.

Данную статью я пишу исключительно в ознакомительных целях и ни в коем случае не призываю никого делать что-то плохое для конкурентов. Конечно, многие сейчас не хотят вести белую конкуренцию, которую нам диктует рынок. Каждый хочет либо «уничтожить сайт конкурентов», либо «забанить ресурс конкурентов» или еще чего.

На мой взгляд самое лучшее, что можно противопоставить конкурентам — это эффективное SEO продвижение своего ресурса, наращивание белой ссылочной массы и интересный контент.

Забанить сайт вашего конкурента очень просто!

1. Наплодить кучу страниц с косячной обработкой страницы 404

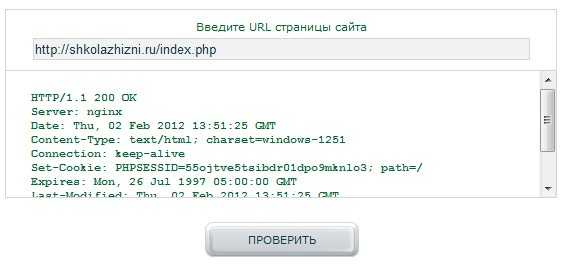

Это самый простой способ, которым воспользоваться может любой, кто мало-мальски знаком с seo. В самом начале нужно немного поковыряться во внутренностях сайта недруга. Благо, что хорошие сайты в сети Интернет можно пересчитать по пальцам. Поехали в техническую часть.

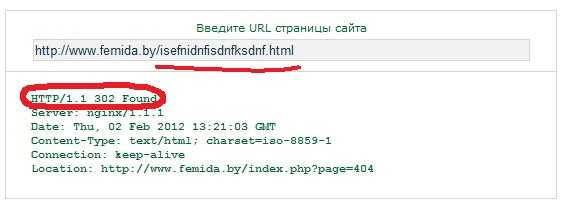

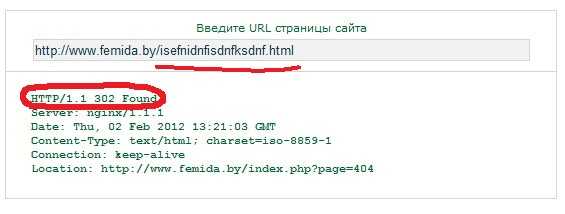

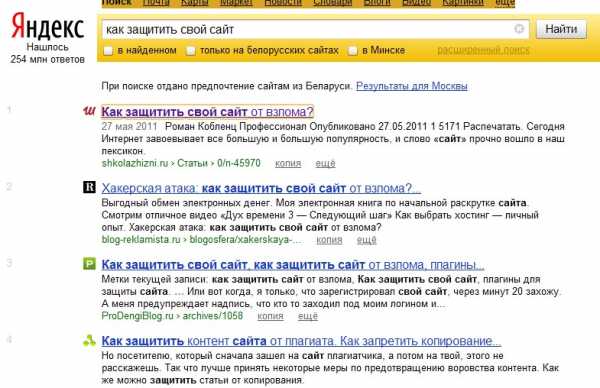

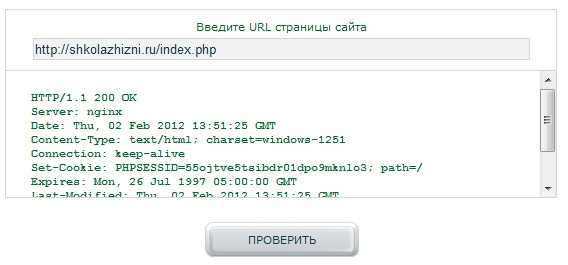

Страница 404 должна отображаться, если мы ввели адрес, которого нет на сайте. Допустим такой:

http://site.ru/bla-bla-bla

то должна показаться страница с ошибкой, а сервер должен отправить заголовок от страницы с кодом 404 (страница не найдена).

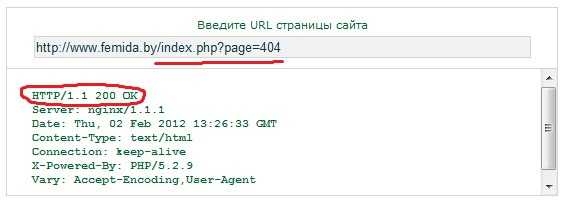

Для проверки ответа сервера достаточно перейти в панель отладки браузера (обычно это кнопка F12), а затем, с открытой вкладкой «сеть» зайти на заведомо несуществующую страницу. Пример ниже.

Так, ответ сервер нам посылает не 404, а 302, что обозначает «страница временно недоступна по такому адресу, перейдите на другую». Самым плохим при этом является то, что страница на которую перенаправляет редирект 302 отдает заголовок 200, то есть ОК, а не тот который нужен в данной ситуации (404).

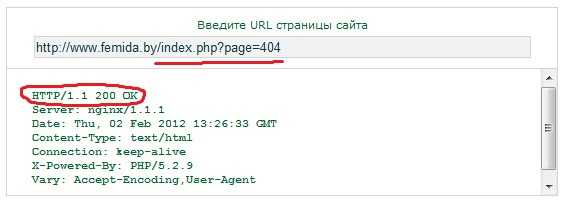

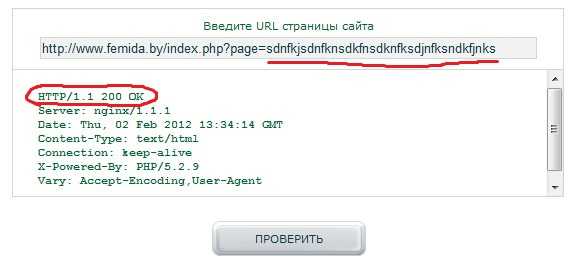

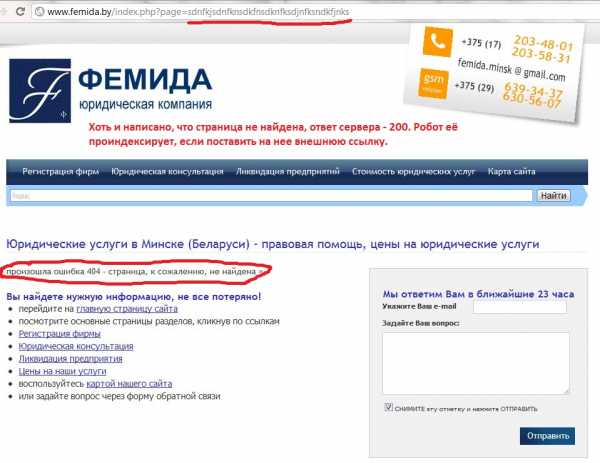

Теперь пришло время главного фэйла данного сайта (может они уже это поправили, но на момент публикации поста этот баг был).

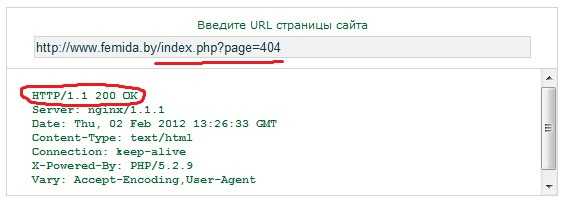

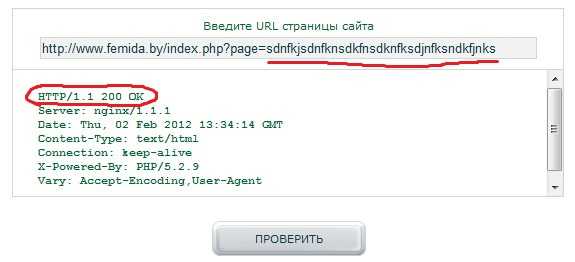

Подметив то, что сайт написан на CMS, мы увидели, что адреса страниц формируются по одному типу:

- femida.by›index.php?page=страница

Напишем билеберду в переменную page и нажмем на enter.

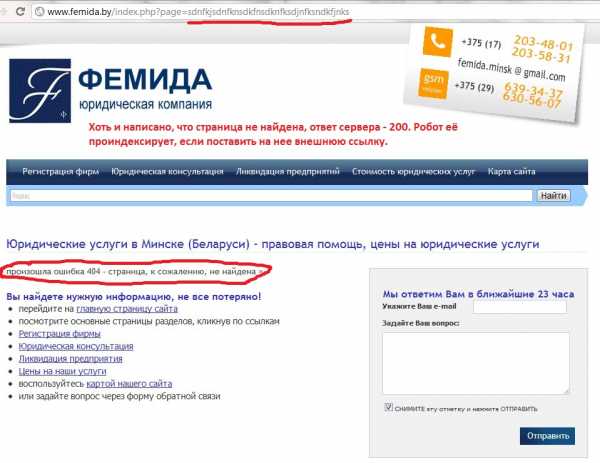

Опачки, код, который нам отдали — это 200, а не 404. Другими словами, сервер говорит мол «Заходите, индексируйте страницу, которой нет». Но при этом на странице написано, что такой страницы нет…делайте выводы.

Совет: внимательно изучайте ответы от сервера на всех типах страниц вашего сайта.

2. Дубли главной страницы сайта

Дубли всегда вредят сайту, а если на сайте есть дубль, а это еще и дубль главной, то ничего хорошего ждать не придется.

Например, часто главная страница доступна по адресам:

- site.ru

- site.ru/

- www.site.ru

- site.ru/index.php

- site.ru/index.html

- и другие вариации, которые можно получить применяя одновременно несколько способов перехода на главную

Почему плохо иметь несколько дублей главной страницы?

Дело в том, что главная страница на сайте, как правило, имеет наибольшый вес. Допустим, вы написали хорошую статью заточенную на высокочастотный запрос (Статья в тему Как составить семантическое ядро для сайта) и страничка попала в индекс. На страничку через некоторое время пойдет трафик, казалось бы все отлично, но вдруг поисковой робот прошёл по какой-нибудь ссылке, которая будет дублем вашей главной, например с www.

Как итог поисковой робот увидит, что на страницах www.site.ru и site.ru одинаковый неуникальный контент, который дублирует друг друга (а поисковики любят лишь уникальный текст). Ваш сайт будет пессимизирован в выдаче. А это печально, особенно если были потрачены деньги и время на развитие сайта.

Кстати, дубли внутренних страниц сайта не так страшны, но от них лучше тоже избавиться. Пусть все будет по Фэншую 🙂

Совет:

- Расставьте правильные редиректы на все возможные случаи. Как это сделано я рассказывал тут 301 редирект для Joomla на .htaccess.

- Как настроить правильный редирект на главном зеркале сайта я писал в статье по настройке Файла robots.txt.

3. Копипаста контента сайта конкурентов

Простой и в то же время действенный способ уничтожить страницы сайта вашего врага. Но не спешите радоваться, это не просто копирование сайта оппонента, это массовое копирование конкурента.

Делается это так. Покупаем, в худшем случае регистрируем, страницы в ЖЖ и Блогпост. Было бы идеальным завести сетку из 500 блогов и больше. После покупки этого богатства придется подождать, пока блоги не настоятся, хотя бы 3-4 месяца. А вот теперь можно и в бой!

Берем и массово копируем сайт конкурента в свои блоги. Конечно это процесс нудный и долгий, но вы можете нанять кого-то, конечно если позволяют финансы. В итоге у сайта конкурентов будет куча копий всех страниц, контент станет сомнительно уникальным, особенно метод хорош если сайт сам копировал информацию с других ресурсов. Быстробот Яндекса, который обитает на ЖЖ и Блогпосте схавает ваши блоги и … может быть вам повезет. и у конкурента забаняться некоторые странички.

Совет: однозначного совета я не дам. Главным оружием должна быть безукоризненная репутация вашего сайта до этого случая. Конечно, можно отключить нажатие правой кнопки или комбинации ctrl+c, но это легко обойти. Лучшим вариантом будет добавление всего вашего материала в Яндекс и Google, в специальные разделы для подтверждения вашего авторства.

4. Сайты-афилиаты

Суть данного метода заключается в том, что поисковые системы не любят сайты, которые имеют свои копии. Копия не обязательно должна быть точь-в-точь как главный сайт. Это может быть и сайт смежной тематики, но имеющий такие же контакты для связи, что и главный сайт. У Яндекса даже есть афилиат-фильтр, который накладывается на всю пачку сайтов с одинаковыми контактными данными.

Конечно для воплощения данного варианта в жизнь требуется время и силы, но результат может порадовать: ваш сайт может показываться выше сайта конкурента по ключевому запросу 🙂

Совет: просто проверяйте время от времени выдачу по вашим главным запросам и, переходя на сайты конкурентов, смотрите контакты. Если вы увидите свои контактные данные, то без промедления жалуйтесь на этот сайт в специальных формах Google и Яндекс.

5. Ссылочный взрыв

Этот метод может просто стереть с лица выдачи молодые сайты, а так же сайты, которые используют Черное SEO для вебмастеров.

Здесь суть простая. Вы берете и покупаете на сайт конкурентов очень много ссылок, но при этом нужно хорошо подойти к отбору самых УЖАСНЫХ и ЗАСПАМЛЕННЫХ сайтов. Набрав пачку хотя бы в 500 сайтов можно опубликовать ссылки на данных сайтах (например через сервис Sape). Главное, чтобы сайты были реально плохие, желательно даже сайты с содержанием для взрослых и с запрещенным контентом. В данном случаем можно использовать прогон по каталогам, благо баз для прогона в интернете тьма.

Если сайт конкурента молодой и не особо развитый, то с вероятностью в процентов 80 — сайт конкурента попадет под АГС фильтр.

Совет: постепенно покупать ссылки для вашего сайта, но без особого фанатизма. При этом необходимо постоянно отслеживать какие ссылки входят на ваш сайт. Если вы заподозрили, что-то неладное, то сразу принимайте меры: напишите в техподдержку поисковиков, свяжитесь с сайтами донорами.

6. DDOS-атака сайта конкурента

DDOS атака — это многократное обращение к серверу с целью его перегрузки. Для человека, конечно, тяжело сделать такую серию запросов к сайту. Но для специального скрипта, написанного программистом, это ничего сложного. Запускаем скрипт, желательно с нескольких компов, и смотрим как трещит и дымиться сервер конкурентов. При большой нагрузке на сервер сайт становится недоступным как для людей, так и для поисковых ботов, которые хотят зайти на сайт.

При длительной, например, недельной ДОС-атаке, странички у сайта конкурентов постепенно начинают выпадать из индекса, а посещаемость падает практически до нуля. Стоимость длительной ДДОС-атаки может выйти в копеечку, но если цель оправдывает средства, то вы можете попробовать…и да, конечно же это незаконно. Если вас вычислят — ждите проблем.

Совет: выбирайте только хорошие и устойчивые к атакам серверы и хостинги, это поможет уберечь ваш сайт хотя бы от недолгих атак.

7. Взлом сайта

Самый очевидный, но самый трудный способ насолить оппонентам. Заполучив контроль над сайтом вы можете сделать все, что угодно.

- Заражение сайта вирусом — сильно уменьшит приток посетителей, за счет снижения рейтинга сайта в поисковике.

- Изменение файла robots.txt — можно запретить индексацию всех страниц сайта. Это как бомба замедленного действия. Все страницы будут выпадать из индекса одна за другой.

- Помещение блока ссылок на черные сайты и скрытие их при помощи display:none — убавит позиции даже самого трастового ресурса.

- Удалите все страницы — топорный метод, который может помочь если у конкурентов не делается бэкап.

Здесь все ограниченно вашей фантазией, но перед тем как фантазировать — умудритесь прорваться через защиту сайта.

Совет: уделите особое внимание серверным файлам, внешним ссылкам, выбирайте защищенные хостинги и пользуйтесь последними версиями CMS.

Итоги

Все эти способы помогут вогнать в бан сайт конкурента и понизить его в поисковой выдаче. Я предлагаю пользоваться только проверенными методами «белой» конкуренции. Если же вдруг вы обнаружите, что на вас затеяли охоту ваши конкуренты, то советую обязательно несколько раз прочесть данную статью и найти брешь в своей обороне.

На этом закончу. Большое спасибо, что вы всегда с нами!

Если статья была для Вас полезной — Поделитесь ссылкой!

Советуем почитать

Закрепленные

Понравившиеся

seo-love.ru

Забанить сайт | Xrumer SEO прогон

Поисковики обладают системой фильтрации

Наказания, которые поисковые системы применяют к сайтам, можно объединить в группы и связать их с причинами их наложения. Вашему вниманию предлагаются самые распространенные из них.

Содержание текста и его микро разметка

— первое, что приводит к снижению степени соответствия текста относительно введенного запроса в «Яндексе» — «переспам Анкор-листа»;

— далее следует чрезмерное старание вебмастеров разместить в документе как можно больше ключевых слов для поднятия поисковых позиций. В итоге, это приводит к «переоптимизации» и потере мест в списках. Данный фильтр накладывается как автоматически, так и вручную аналитиками «Яндекса»;

— кроме того, ваш сайт может существенно обесцениться, либо вообще будет исключен из поисковой выдачи, если он попадет под множественные фильтры «текстового анти спама», которые применяются не только к новым документам, но и к уже проиндексированным;

— «Гугл» же прибегнет к своему ручному типу наказания, если документ будет пестрить спамом в своей микро разметке;

— наконец, последний фильтрующий алгоритм «Яндекса» в данной группе – «Баден-Баден». Его главной задачей является уменьшение количества переоптимизированных документов в поисковой выдаче, а делает он это, оценивая весь текстовый контент страницы.

Ссылочный фактор

— самым частым явлением в этой группе является «не естественный ссылочный взрыв», благодаря которому за небольшой промежуток времени появляется очень много обратных ссылок на ваш сайт. Из топа документ уйдет так же быстро, как и попадет в него, поскольку поисковые системы очень жестко следят за этим. При этом под штрафные санкции попадут и «доноры», которые участвовали в данном мероприятии;

— фильтр от «Гугл» «Пингвин» накладывается в тех случаях, когда алгоритм заподозрит накрутку ссылочной массы, и срабатывает он даже на низкочастотные запросы. Как видите, работа с биржами ссылок не приветствуется поисковиками;

— к «пессимизации» (искусственное понижение позиций сайта) может привести ситуация, когда вся «раскрутка» сайта строится лишь на манипуляциях со ссылками. Виды наказаний в таких случаях могут быть самыми разнообразными;

— «Непот-фильтр» применяется к сайтам, которые торгуют или обмениваются ссылками. Накладывается лишь на сами ссылки, теряющие после этого свой вес;

— алгоритм «Минусинск» находит сайты, использующие SEO-ссылки для своего продвижения, и штрафует их минимум на один месяц, что приводит к существенному понижению входящего трафика.

Факторы поведения

— поведенческие факторы набирают все большую значимость в работе поисковых систем, вот почему они научились отслеживать недобросовестных вебмастеров и штрафовать их за «накрутку ПФ»;

— также поисковики отфильтровывают сайты, за которыми скрываются охотники за персональными данными и другие подобные энтузиасты, использующие «Кликджекинг» для своих далеко не всегда благородных целей.

Группирование сайтов

— если сайты пересекаются между собой в нескольких точках (контактная информация, описание товаров, одинаковые тексты и т.п.) «Яндекс» может посчитать их «аффилированными» и принять соответствующие меры;

— фильтр накладывается на сайты и за «одинаковые сниппеты». Чаще всего под него попадают сайты с какими-либо товарами или услугами, поскольку описание зачастую берется из какого-то третьего источника и просто копируется. Поисковик отфильтровывает одинаковые сниппеты и в выдаче оставляет только один сайт, который он посчитает автором этого контента.

Рекламные фильтры

— попасть под эти санкции можно в случае, если на вашем сайте присутствует довольно много кликандеров, попандеров и им подобных. За навязанную рекламу поисковики могут не только лишить вас хорошего места в выдаче, но и вообще исключить из своего поиска;

— также под фильтры можно попасть, если на страничке есть обманный рекламный контент, либо его очень много и он мешает работать со всем остальным контентом. Понижение ранга станет самым безобидным наказанием для вебмастера в этом случае;

— агрессивная реклама на страничках для мобильных пользователей тоже подведет вас под фильтры поисковиков, поэтому не стоит увлекаться различными подписками, скачками и автоматическими перенаправлением, если на ваш ресурс зашел владелец мобильного устройства.

Контент для взрослых

— на сегодняшний день все поисковые системы обзавелись собственным «adult-фильтром», который исключает из выдачи по вполне себе безобидным запросам сайты с явным взрослым контентом. При чем, попасть под него могут и «пушистые» ресурсы из-за рекламы, партнерской программы, либо комментария на очередной пост со ссылкой на что-то взрослое.

Качество контента в целом

— алгоритм «Яндекса» «АГС», который продолжает совершенствоваться и по сей день, призван исключать из индексации сайты, на котором обнаружен хотя бы один способ «черной оптимизации»;

— у «Гугла» для этого есть свой собственный фильтр, который называется «Supplementary Results». Он отсеивает те страницы сайта, которые не несут никакой полезной информации в себе: дубликаты страниц, страницы со ссылками на несуществующие сайты, регистрационные формы и другой неуникальный контент;

— «Фильтр-Панда» занимается оценкой качества всего содержания страницы по своим параметрам и, исходя из результатов этой проверки, повышает или понижает позиции сайта в поисковой выдаче.

Ценность сайта

— прежде всего, сюда стоит отнести так называемые «партнёрки», которые не несут дополнительной пользы пользователям интернета, за что они и попадают под фильтры поисковых систем;

— их собратьями выступают «псевдосайты». Причин попадания под этот фильтр может быть несколько, поэтому вам сильно повезет, если поисковик посчитает ваше творение таковым и лишь понизит его позиции в выдаче. В большинстве же случаев сайты, которые признаются «псевдо», полностью исключаются из индекса.

Попытка обмана поисковика

— за любую попытку обмануть или обойти алгоритмы любой поисковой системы, при ее обнаружении, конечно, вы получите любимый всеми вебмастерами «БАН». Если вы не прибегаете к приемам «черного SEO» и другим сомнительным способам продвижения своего детища, «бан» вам не грозит, в большинстве случаев. Иногда вы можете получить его случайно, и после общения с техподдержкой поисковика, справедливость и позиции вашего сайта восстановятся;

— помимо автоматических блокировок и «банов» санкции могут быть применены к сайту и вручную, потому что аналитики поисковых систем всегда будут утверждать, что алгоритмы не могут учесть всех факторов и не видят ситуации в целом.

Закононарушение

— тут все очень просто. Если суд уличит ваш сайт в нарушении законодательства, по его решению из поисковых систем будут удалены любые ссылки на него или его копии, а вы, как владелец, получите уведомление об этом.

xrumer.xyz

Как убрать сайт конкурента из выдачи

Если у Вас есть собственный сайт, то у него обязательно есть конкуренты. Если Ваш сайт популярный, раскрученный и посещаемость немалая, то конкуренция очень высока. Становится обидно, когда Ваш сайт намного лучше, чем у конкурента, но в поисковой выдаче Ваш сайт ниже.

И тогда появляется желание избавиться от конкурента, убить его сайт. Но, как это сделать – знают единицы, да и те, которые знают, никогда Вам не расскажут. Многие думают, что таких методов вообще не существует, однако они ошибаются. Существует целая схема под названием «Как угробить сайт конкурента». Но прежде чем приступать к убийству сайта конкурента хорошенько подумайте, а не будет ли Вас мучить совесть? Если нет, то давайте рассмотрим схему подробнее.

1) Анализ сайта конкурента. Смотрим возраст домена, количество страниц в выдаче, показатели ТИЦ и PR, количество упоминаний в Яндексе, количество текста на главной странице и другие параметры. Всё это можно сделать с помощью сервиса анализа сайта, например cy-pr.com. Чем старше домен, тем сложнее будет убить сайт. Если ТИЦ и PR больше нуля, то ссылки закупались, значит можно сделать или купить несколько сотен или даже тысяч некачественных ссылок с ГС или сайтов adalt тематики на биржах купли-продажи ссылок. Такие ссылки стоят копейки, зато качество ссылок заметно ухудшится, позиции сайта в выдаче просядут и сайт конкурента уже не сможет бороться за посетителей с вашим сайтом.

2) Удаляем Базу Данных или файлов сайта. Это самый жестокий, но самый верный способ полного удаления сайта из сети. Для этого Вам нужен доступ к ftp серверу жертвы, также нужно знать параметры подключения БД. Если у Вас есть такие данные, то просто заходите на сайт через ftp и удаляйте всё, что видите. Но, как правило, у Вас такого доступа нет. В этом случаем придется взломать e-mail конкурента. Взломав почту, можно получит много контактной информации. Например, доступ к панели управления хостингом, в этом случае можно удалить все бекапы сайта, если таковые имеются, и поменять контактный e-mail. E-mail жертвы можно найти на сайте в разделе «Контакты» или «Связь с администрацией». Как ломать почту, рассказывать не буду, существует огромное количество сервисов, где можно создать ящик. И в сети можно без труда найти способы взлома почты на этих сервисах. Можно взломать сайт с помощью вирусов, готовых вирусов для взлома сайт немало в сети, только прежде чем использовать вирус, изучите отзывы о нем.

3) Ddos-атака. Distributed Denial of Service – это распределённая атака типа «отказ в обслуживании». Есть специализированные форумы, где хакеры предлагают свои услуги. Стоит такая услуга от 100$ за 24 час.

4) Киберсквоттинг. Киберсквоттинг – это захват или перехват домена. Воспользуйтесь ресурсом cybersquatting.ru.

5) Xrumer, Allsubmitter и аналогичные программы. Xrumer прогоняет сайт по форумам и гостевым доскам. Программа стоит немало, но можно найти крякнутые версии. Вам нужна чёрная база форумов, сайты должный быть забанены или на них должен быть размещен вредоносный код. Такие базы есть в сети.

6) Дорвеи. Находим основные топовые запросы сайта конкурента. Генерируем или создаем руками дорвеи, т.е. страницы, оптимизированные под какой-то конкретный запрос, в нашем случае – под топовые запросы конкурента. Потом ставим ссылку с дорвеев на сайт конкурента. Для ускорения процесса можно пожаловаться в службу поддержки Яндекса, мол, вот, нехороший человек таким способом мой сайт обгоняет по позициям в выдаче, только свой сайт не упоминайте. Бан сайта конкурента за такое дело в 9 случаях из 10.

7) Заражение сайта вирусом через предварительно найденую уязвимость.

Вот основные методы убийства сайта конкурента. Лучше этим никогда не заниматься, и бороться с конкурентами честно, но если с Вами поступили подло и несправедливо, то обязательно накажите обидчика.

Post Views: 981

rz-style.ru

TOP 10 способов убить сайт конкурента в выдаче и защитить свой.

Добрый день, уважаемые посетители! Из названия вы, конечно, догадались, о чем пойдет речь в сегодняшней статье. Сегодня мы поговорим о том, как убить сайт вашего конкурента или опустить его в выдаче поисковых систем с первых строчек до «куда-нибудь подальше».

Сразу скажу, что «убивать» я никого не собираюсь. 🙂

По моему мнению – намного более эффективным будет продвижение своего ресурса, чем порча сайтов своих соседей. Но, как говорится, каждому своё и многие ищут способы, чтобы насолить своим недругам по тем или иным причинам.

Мир становится более гуманным, и вместо прежних: «настучать по голове, чтобы он понял, что был не прав», теперь используют: «завали его сайт, чтобы весь его бизнес прогорел».

Основной причиной, по которой я пишу эту статью, является то, чтобы вы смогли пересмотреть свои сайты на предмет нахождения этих распространенных ошибок, и защититься от недругов и нежелательных действий своих кункурентов.

От действий тех, кому вы не понравились.

Итак, что можно сделать с сайтом вашего недруга? (Или, возможно, с вашим?)

1. Наплодить на сайте пару тысяч страниц из-за неправильной обработки 404 ошибки.

Это один из самых простых способов, которым вы можете с лёгкостью воспользоваться. Для начала, нужно хорошенько изучить техническое состояние сайта вашего недруга.

Большинство сайтов в интернете (около 80%) написаны настолько криво и неправильно, что найти проблему технического характера на таком сайте не составит большого труда.

Очень часто у сайтов некорректно обрабатывается 404 ошибка, или вообще не обрабатывается. 404 ошибка – это такая страница, которая говорит вам, что вы пришли по адресу, которого на сайте нет.

Т.е. или страница была, и её уже удалили, или её никогда не существовало в природе.

При этом роботу, который пришел на страницу, должен отдаваться ответ 404 — страница не найдена.

К примеру, вы набрали какой-нибудь адрес http://название_сайта/любой_набор_букв. И вам показывается какой-нибудь белый лист.

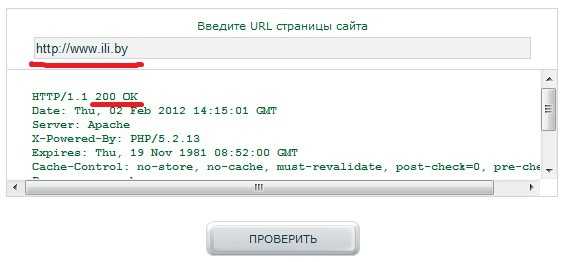

Воспользовавшись сервисом проверки ответа сервера http://mainspy.ru/otvet_servera вы можете увидеть, какой ответ сервера отдается.

Возьмем какой-нибудь сайт для примера, допустим вот этот: http://www.femida.by/ и проверим, как у него обрабатывается 404 ошибка.

Ага, ответ сервера не 404, а 302. Это значит, что стоит временный редирект со страниц, которые не существуют на страницу, которая показывает 404 ошибку. При том, что сама страница 404, на которую стоит редирект – отдает 200 ответ… Хотя, должна отдавать 404 ответ.

Единственное, что они сделали по уму – так это то, что закрыли эту страницу в robots.txt от индексации.

Нам этот вариант с дублями не подходит.

Копаем дальше.

Смотрим на структуру урлов страниц:

- femida.by›index.php?page=contract

- femida.by›index.php?page=torgovlia

- femida.by›index.php?page=lic

- femida.by›index.php?page=hoz_interes

Все урлы имеют схожую структуру. Не знаю, что это за CMS, но мы кое-что проверим.

Вместо слова, которое идет после ?page= вписываем что-нибудь страшное и проверяем ответ сервера.

Ой, посмотрите:

Ответ сервера – 200. Страница разрешена к индексации.

Но при этом сама страница выглядит вот так (кликабельно):

Остается только сгенерировать 3000 таких урлов и закупиться порно-ссылками в Sape. Если на сайте всего 100 полезных страниц, то появится еще 3000 бесполезных, на которые ведут ссылки с плохими словами.

Яндекс это оценит, возможно даже АГСом. 🙂

Защита: Чтобы защитить свой сайт – проверьте, чтобы ответ сервера на несуществующих страницах был 404. Если у вас отдается 200 заголовок – вы лёгкая мишень для подобной несложной манипуляции.

Обратитесь к программистам, которые исправят эту ошибку.

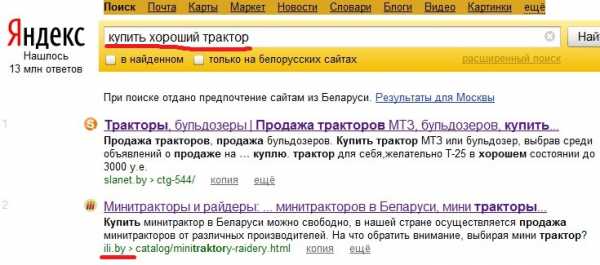

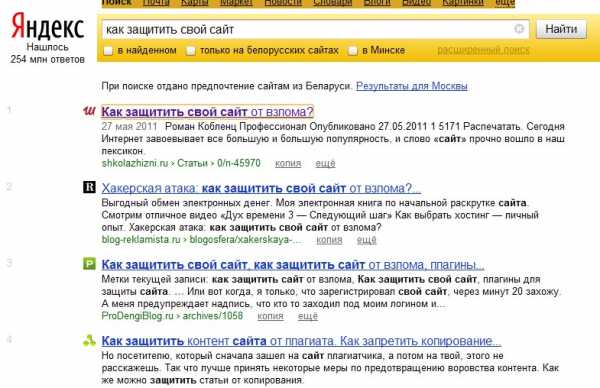

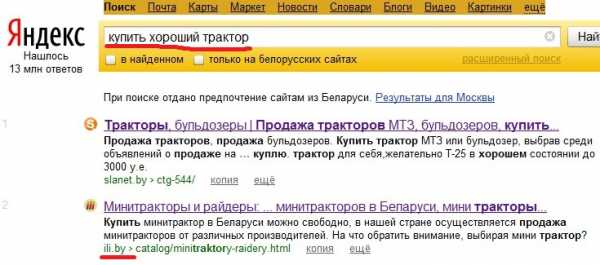

2. Дубль главной страницы.

Почти у каждого движка есть дубли главной страницы сайта.

К примеру, главная страница доступна по обычному адресу и с добавлением на конце /index.php, /index.html или слеша.

Открываю Яндекс и пишу примерно вот такую фразу (кликабельно):

Открываю первый же сайт и проверяю на дубли главной страницы.

Опачки!

/index.html выдает 404, а /index.php – вполне отлично себя чувствует:

Смотрим ответ сервера:

И тут всё хорошо. Страница отдает 200 заголовок, страница не закрыта в robots.txt.

Для чего всё это, возможно спросите вы? И что с того?

Большинство сайтов продвигают главные страницы. И обычно, это ВЧ запросы. Представьте себе, что путем простейшей покупки 5-10 ссылок на страницу с /index.php, вы создаете дубль главной страницы сайта и он попадает в поиск. Т.е. контент на странице становится неуникальным в пределах домена и страница опускается в выдаче, так как их уже 2. 🙂

Защита: Поставьте 301 редирект в файле .htaccess, со страницы с /index.php (той, которая у вас являет дублем) на главную страницу сайта. Таким образом, куда бы не ссылались ваши конкуренты, все ссылки будут вести на главную через 301 редирект.

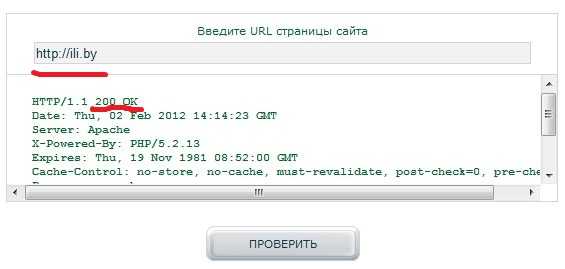

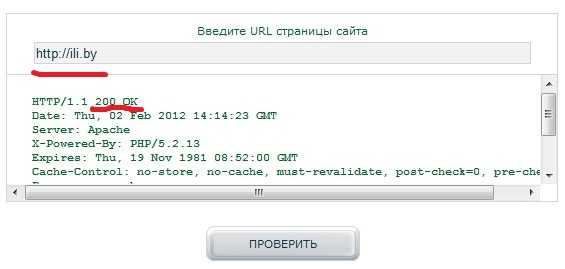

3. Неправильно настроенные зеркала «с www» и «без www».

С этой проблемой поисковики стараются справляться самостоятельно, пытаясь определить, какой-же адрес является на сайте основным – с www или без www.

Но они это делают не всегда правильно, поэтому многие сайты доступны в выдаче по двум адресам – с www и без www. Таким образом, каждая страница сайта имеет один и тот же контент, но существует по двум разным адресам.

В выдаче присутствует полный дубль вашего сайта.

Давайте поищем такие сайты? 🙂

Далеко идти не пришлось.

Первый введенный запрос – второй сайт в выдаче – вуаля! (кликабельно):

Сайт называется ili.by.

Доступен по двум адресам:

http://ili.by (без www) – ответ сервера – 200:

http://www.ili.by (с www) – ответ сервера – 200:

У сайта не настроено главное зеркало. Т.е. сайт доступен для поисковых роботов, как с www, так и без www.

Хоть у сайта и прописана в robots.txt директива Host (которую понимает только Яндекс), можно легко сделать дубль всего сайта, поставив на каждый урл по 1 ссылке на адрес без www.

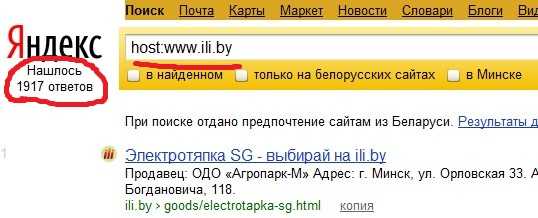

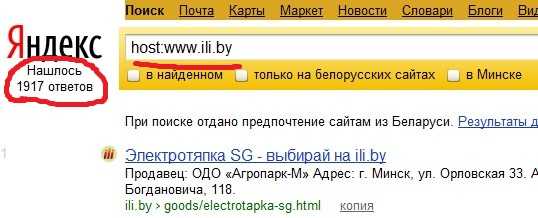

Всего таких ссылок понадобится 1917 штук:

Получится копия всего сайта в выдаче и сайт упадет в позициях.

Защита: Следует настроить в .htaccess 301 редирект с адресов с «без www», на адреса «с www». Прописать в robots.txt директиву Host: www.ili.by для Яндекса. В панели Вебмастеров Google указать главное зеркало – «с www» и в Панели Вебмастеров Яндекса также указать главное зеркало – «с www».

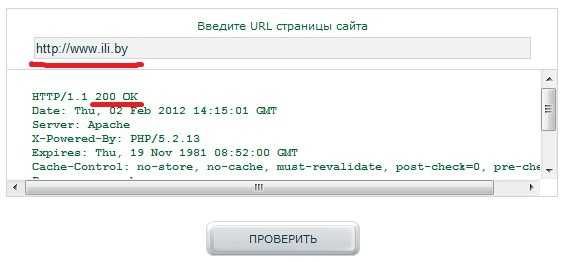

4. Дубли страниц со слешем и без на конце.

Вы думали что это всё? Нет, есть еще масса способов, к примеру – дубль страниц со слешем и без на конце адреса.

Далеко не пойдем и возьмем тот же самый сайт – www.ili.by.

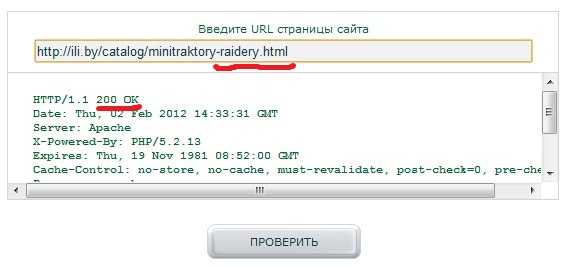

Берем любой урл – к примеру, этот:

http://ili.by/catalog/minitraktory-raidery.html

И добавляем к адресу на конце слеш.

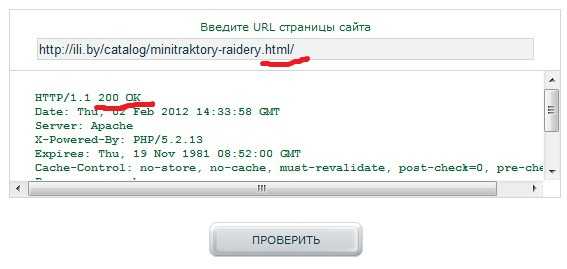

http://ili.by/catalog/minitraktory-raidery.html/

Если страница открывается, значит вот вам еще один вид дублей.

Для достоверности проверим ответы сервера.

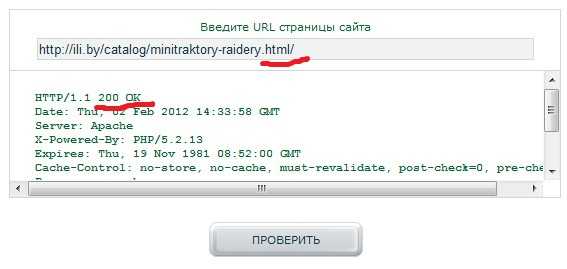

Опа:

И Опа:

Видим, что везде отдается тот же 200 заголовок, который говорит поисковым роботам: «Индексируй меня».

Т.е. схема та же – еще 1917 ссылок на каждый дубль со слешем и у нас еще одна копия сайта в выдаче. Итого, если сложить с предыдущим действием – уже 4 сайта в поиске вместо одного.

Защита: Настроить в .htaccess 301 редирект с «страниц со слешем» на «страницы без слеша» (читать как настроить — тут). Или наоборот, как вам больше нравится. Главное – чтобы на сайте был только 1 вид страниц. Кроме того, прописать тег rel=”canonical”, который виден только в HTML коде страницы и указывает на основной URL.

В принципе, одного этого тега может хватить, чтобы избавиться от дублей со слешем и без на конце (особенно для Google), но не всегда. Всегда лучше 2 раза перестраховаться.

5. Скопировать контент сайта.

Это, наверное, самый простой и самый понятный многим способ. Но простого копирования здесь, скорее всего не хватит.

Раз мы говорим о том, как «опустить» вашего недруга, будем действовать в промышленных масштабах. А именно – по-русски. Копировать, так с размахом. Русская душа всегда отличалась широтой мысли. 🙂

Итак, идем на форум и покупаем пачку ЖЖшечек, и Блогспотов. Как вариант, если вы занимаетесь выносом конкурента профессионально – завести свою сеточку из 500-800 блогов.

После того, как вы купили отстоявшиеся блоги (хотя бы возрастом от 4-5 месяцев), совершаем следующее – копируем весь сайт вашего недруга в эти ЖЖшечки и Блогспотики. Раз так 5-6 копируем. По сути – чем больше у вас подобных блогов во владении, тем лучше.

Почему ЖЖшечки и Блогспотики? Потому что быстробот Яшки там живет. Ваши статьи, не зависимо от того, копипаст это, или нет – обязательно попадут в поиск. А значит – у конкурента он станет неуникальным.

Если у него сайт большой – можно воспользоваться специальным софтом, который отпарсит весь сайт и на автомате загонит его в ЖЖшечки.

Если сайт маленький – можно и руками потрудиться. Или нанять кого-нибудь, кто сделает это за вас.

За счет не уникальности – позиции могут опуститься, и, порой, довольно значительно. На моей памяти, такое случалось не один раз, когда кто-то «с благими намерениями» копировал продвигаемую страницу, и приходилось переписывать текст заново, так как с 4 места страница опускалась до 50-70.

Защита: 100% защиты в этом случае просто нет. Можно поставить на ваш сайт какой-нибудь плагин, который отключит сочетания клавиш Ctrl+A, Ctrl+C, правую кнопку мыши и выделение текста (Для WordPress, это плагин http://wordpress.org/extend/plugins/wp-copyprotect/). Но это всё «защита от блондинок».

Это не спасет сайт от парсинга через специально написанный для этого софт, так как он обращается напрямую к коду страницы, а не через сочетания клавиш.

Есть еще вариант – программным способом скрывать сам html код сайта. Но, я до конца не уверен, что его нельзя слить программными методами. Насколько я понимаю, код закрыт только при просмотре в браузере. (Видел такое несколько раз, но, к сожалению, так и не вспомнил те сайты, чтобы показать, как пример.)

6. Создание сайта-афилиата.

Данный способ наиболее трудоемкий, но он также наиболее действенный. Суть метода такова: Вы создаете один или несколько сайтов, которые ко контенту схожи с сайтом вашего конкурента, при этом присваиваете сайту тот же регион и те же контактные данные, что и у конкурента.

Яндекс не любит, когда в выдаче присутствует несколько сайтов одной и той же фирмы, поэтому и придумали афилиат-фильтр.

Если поисковик повесит этот фильтр и, что еще лучше – определит, что ваш сайт стоит показывать в выдаче, конкурент без видимых на то причин по некоторой совокупности запросов просто не будет показываться в ТОПе. Будет показываться только ваш сайт.

Защита: В принципе, защиты от такого рода атаки просто нет. Единственное, что поможет вам избежать этого – если фильтр еще не повесили, вы обнаружили «плохой сайт» и отписали Платону, объяснив всю ситуацию. Возможно (но далеко не факт), вам помогут и отправят тот сайт в бан.

7. Ссылочный взрыв.

Данный метод очень хорошо работает на молодых сайтах, а также на сайтах, которые любят копировать контент.

Суть метода – вы закупаете на сайт конкурента огромное количество ссылок. Желательно и почти обязательно – чтобы ссылки были ярко выраженными продажными с небольшим или большим оттенком адалта.

Проще всего – отпарсить статистику ключевых слов какого-нибудь адалт-сайта. Все ключевые слова, по которым приходили на тот сайт и будут анкорами ваших ссылок.

Далее загружаете это всё в сапу и на каждый URL конкурента закупаете по штук 20-50 ссылок. Причем – единовременно. Именно таким образом происходит так называемый «ссылочный взрыв». Если сайт до этого не продвигался и на него стоит хотя бы даже 100 ссылок, то ваши 4000 адалт ссылок легко укажут Яндексу, что сайт не стоит того, чтобы быть в выдаче.

Как я уже говорил – этот метод просто идеален для молодых сайтов (1-4 месяца жизни). А если эти сайты, как и большинство других сайтов в интернете, копируют контент и он у них неуникален – появляется 99,9% гарантия того, что придет АГС.

Защита: Для начала – постоянно «кормить» свою малютку качественными ссылками (не прогонами, а постовыми с тематических сайлов, чтобы знать в лицо каждую ссылку) и писать ТОЛЬКО уникальный контент. Короче – развивать сайт по полной.

При этом – постоянно мониторить все внешние ссылки на ваш сайт через панель Я.В. Как только увидите, что откуда-то резко появились ссылки, которые вы не ставили и их появилось очень много, и все они – с адалт анкорами – сразу же пишите письмо Платону.

Техподдержка просто не будет учитывать внешние ссылки, которые появятся на ваш сайт в течение некоторого времени. Так вы защитите свой сайт от АГСа, а конкурент просто зря потратит деньги на ссылки.

8. Переспам анкор листа продвигаемых страниц.

Так как продвигается обычно не весь сайт, а отдельные его страницы – вы можете «помочь» вашему конкуренту продвинуться, переспамив его анкор-лист прямыми вхождениями запроса.

Это не очень-то и хороший метод, но он имеет место жить. Почему он не очень-то хороший? Потому, что вы, по сути, помогаете вашему недругу продвинуться. В Яндексе вы его опускаете, а в Гугле – продвигаете, ибо Гугл любит прямые вхождения. А вот Яндекс – не очень то любит. Поэтому в нем позиции за переспам улетят за предел первой двадцатки.

Я бы не советовал использовать этот метод. Есть другие, куда более действенные.

Защита: Если вы обнаружили, что ваши страницы свалились в выдаче и у вас в панельке Я.В. появились ссылки с продвигаемыми ключами, которых вы не ставили, знайте – кто-то решил «помочь» вам продвинуться.

Чтобы вернуть позиции на место – закупите на проспамленные страницы побольше ссылок для разбавления анкор-листа. Если, к примеру, вам проспамили по запросу «купить квартиру», закупите ссылок вида: «Кстати, я вот долго думал и пришел в выводу, что лучшие квартиры тут.» или «На этом сайте вы сможете подобрать для себя любую квартиру, как в кредит, так и за наличные.»

Суть в том, чтобы на проспамленную страницу появились очень длинные анкоры, содержащие в себе часть запроса, которым вас проспамили. Так вы вернете нужный процент прямых вхождений и разнообразите ваш анкор-лист. И ссылки вашего конкурента пойдут вам только на пользу. 🙂

9. Взлом сайта, инъекция вируса, закрытие сайта от индексации, внешние ссылки.

Есть и такой метод, да. Суть его в том, что сайт вашего конкурента просто взламывается, и на нем делается всё, что вам захочется.

Можно, к примеру, заразить сайт вирусом, что резко уменьшит траффик на сайте вашего недруга, так как поисковики будут выводить в выдаче напротив сайта надпись, наподобие «Этот сайт может угрожать безопасности вашего компьютера».

Но, это цветочки.

Ягодки – это когда сайт полностью удаляется, или ломается. Причем ломается так, что на его восстановление может уйти несколько дней. А за несколько дней часть страниц может вылететь из индекса поисковика.

Еще один из вариантов – взломать сайт и изменить на нем файл robots.txt. Ваш недруг может даже не заметить того, как его сайт постепенно вылетит из индекса. А когда опомнится – будет уже поздновато.

Или вот еще один вариант из той-же серии. Взламывается сайт и на нем размещается скрытый блок, состоящий из внешних ссылок на плохие ресурсы. Скрыть блок можно через элементарное display:none, или вынести блок далеко за экран. В каждом блоке, к примеру, по 20 внешних ссылок на плохие адалт сайты.

Увидев это, Яндекс подумает, что сайт продает ссылки, при чем очень жестко продает, и отправит его под АГС.

Защита: Внимательно следите за любыми изменениями, которые происходят с индексацией сайта и вашими внешними ссылками. Кроме того, выбирайте защищенные и хорошие хостинги, та как безопасность – прежде всего.

И периодически делайте бэкап всего вашего сайта. С хотсерами тоже может многое случиться.

10. ДДос атака.

Суть ДДос атаки – перегрузка сервера, на котором стоит сайт конкурента с помощью огромнейшего числа запросов. В результате сервер не успевает отвечать на них и виснет. Сайт становится недоступным.

Но он становится недоступным не только для людей, но и для роботов. Поэтому, придя на сайт, роботы разворачиваются и уходят.

Если ДДос атака длится непрерывно в течение нескольких дней, страницы сайта конкурента начинают выпадать из индекса. Таким образом, большой организованной ДДос атакой можно вывести из строя любой сайт, и он пропадет из выдачи.

Стоимость длительной ДДос атаки будет весьма большой, но если вы упрямый и у вас много денег – можно вывести из строя даже сервера ЖЖ, что случалось не один раз. А они там будут помощнее, чем на любом хостинге за 5 баксов в месяц.

Защита: Держите свои сайты на хороших хостингах, у которых профессиональная техподдержка и админы с мозгом. Они хотя-бы смогут защитить ваш сайт от мелких ДДосеров. Но, как я уже говорил выше, если очень хочется, то можно и ЖЖшечку положить. От хорошо отлаженной атаки вас ничто не спасет.

В заключение.

Уф, большой получился пост. Вы увидели, какие же все-таки хрупкие наши с вами сайты, и как о них нужно заботиться.

Так как статья будет участвовать в конкурсе «TOP 10» от Сергея Шелвина, остановимся на десяти способах. Остальное останется «секретом фирмы».

Но, в окончании, я бы еще хотел уточнить несколько моментов.

Обычно, если использовать только один из методов, нужного эффекта можно и не добиться. Методы воздействия нужно комбинировать. Только нужная комбинация поможет вам добиться 99,9% результата и, все-таки, пояснить вашему недругу, что «он был не прав». Какая комбинация и каких методов может помочь? Всё сугубо по ситуации и зависит от множества факторов.

Я же хотел бы вам посоветовать не использовать эти методы. Но знать их настоятельно рекомендую, так как если знаешь врага в лицо, знаешь чего ждать и как защититься.

Желаю вам исправить все ошибки на ваших сайтах, чтобы ни один злостный хулиган не мешал вам вести бизнес в интернете.

Если же вы хотите по максимуму защититься от возможных негативных действий ваших конкурентов, закажите SEO аудит вашего сайта. По стоимости обойдется раз в 5 дешевле, чем потом разгребать последствия их «наездов» на ваш сайт. Сон будет крепче, а сайт будет приносить больше клиентов.

Также рекомендую подписаться на бесплатный курс по исправлению ошибок на сайте: ссылка. Там я подробно, в видео формате, рассказываю о самых популярных и, можно сказать, «детских» ошибках, которые есть на каждом 2-ом сайте в рунете. С помощью даже этих «детских ошибок», можно неплохо подпортить вам жизнь. И именно они часто являются причиной того, что сайт висит не на 1-5 по запросу, а на 20-30.

Успехов вам! И всего наилучшего!

Твит дня: «Э — это волшебная буква, которая включает свет в туалете.»

Подписаться на обновления блога:

Оставить комментарий

*** Правила комментирования блога ***sickboy.ru

Большой ссылочный взрыв | Тариф «Ссылочный взрыв» | Прогон Хрумером | Как забанить сайт конкурента | Забанить сайт | XRumer прогон

В настоящее время сайт, или ресурс имеется у большинства компаний или фирм, которые так или иначе продвигают свои услуги или товары в интернете. Этот популярный ресурс стал одним из главных инструментов получения денег и внимания со стороны клиентской базы. Однако зачастую возникают различные вопросы, когда необходимо не только продвинуть собственный продукт, но и поднять позицию клиента. Например, этим тарифом, можно навредить своему сайту или даже забанить.

Причинами такого поступка могут быть различные действия. Однако в данном случае речь идет об услугах тех компаний, которые их предоставляют. Итак, компания XRumer выполняет услуги по наращиванию сылочной массы для вашего сайта. Каким образом происходит процесс? Опишем его детально:

Выполнение прогона и символической атаки выполняется с четырех серверов одновременно. Такого количества более чем достаточно для того, чтобы нарастить много ссылок.

Кроме этого, производится взрывная масса беклинков. Этот процесс позволяет очень быстро и мощно воздействавать на позиции сайта среди поисковых систем. То есть, фактически такой прием может обрушить не только моральный авторитет сайта компании, но и фактически технически изменить его позицию в поисковой выдаче. Соответственно, этот ресурс будет видеть значительно более или меньшее количество потенциальных пользователей.

Подключение сайта к «черному списку». Поисковые системы имеют в своей базе данных список ресурсов, с которыми не стоит так или иначе сотрудничать. В данном случае включение сайта в этот список позволит им игнорировать не только ресурсы упомянутых компаний, но и непосредственно их самих.

Гарантированная анонимность. При заказе подобных услуг компания предоставляет возможность полной анонимности.

Быстрое выполнение заказа. Работа выполняется в течение 3 – 7 суток. Подробную информацию вы узнаете на ресурсе непосредственног

Низкая стоимость. Цены на услуги подобного рода варьируются в зависимости от их качества. В данном случае вы можете быть уверены в денежной экономии. За небольшие средства вы решите свои вопросы.

Подробную информацию о сотрудничестве вы узнаете на сайте компании. Всегда вам рады!

xrumer.pro

TOP 10 способов убить сайт конкурента в выдаче и защитить свой.

Добрый день, уважаемые посетители! Из названия вы, конечно, догадались, о чем пойдет речь в сегодняшней статье. Сегодня мы поговорим о том, как убить сайт вашего конкурента или опустить его в выдаче поисковых систем с первых строчек до «куда-нибудь подальше».

Сразу скажу, что «убивать» я никого не собираюсь. 🙂

По моему мнению – намного более эффективным будет продвижение своего ресурса, чем порча сайтов своих соседей. Но, как говорится, каждому своё и многие ищут способы, чтобы насолить своим недругам по тем или иным причинам.

Мир становится более гуманным, и вместо прежних: «настучать по голове, чтобы он понял, что был не прав», теперь используют: «завали его сайт, чтобы весь его бизнес прогорел».

Основной причиной, по которой я пишу эту статью, является то, чтобы вы смогли пересмотреть свои сайты на предмет нахождения этих распространенных ошибок, и защититься от недругов и нежелательных действий своих кункурентов.

От действий тех, кому вы не понравились.

Итак, что можно сделать с сайтом вашего недруга? (Или, возможно, с вашим?)

1. Наплодить на сайте пару тысяч страниц из-за неправильной обработки 404 ошибки.

Это один из самых простых способов, которым вы можете с лёгкостью воспользоваться. Для начала, нужно хорошенько изучить техническое состояние сайта вашего недруга.

Большинство сайтов в интернете (около 80%) написаны настолько криво и неправильно, что найти проблему технического характера на таком сайте не составит большого труда.

Очень часто у сайтов некорректно обрабатывается 404 ошибка, или вообще не обрабатывается. 404 ошибка – это такая страница, которая говорит вам, что вы пришли по адресу, которого на сайте нет.

Т.е. или страница была, и её уже удалили, или её никогда не существовало в природе.

При этом роботу, который пришел на страницу, должен отдаваться ответ 404 — страница не найдена.

К примеру, вы набрали какой-нибудь адрес http://название_сайта/любой_набор_букв. И вам показывается какой-нибудь белый лист.

Воспользовавшись сервисом проверки ответа сервера http://mainspy.ru/otvet_servera вы можете увидеть, какой ответ сервера отдается.

Возьмем какой-нибудь сайт для примера, допустим вот этот: http://www.femida.by/ и проверим, как у него обрабатывается 404 ошибка.

Ага, ответ сервера не 404, а 302. Это значит, что стоит временный редирект со страниц, которые не существуют на страницу, которая показывает 404 ошибку. При том, что сама страница 404, на которую стоит редирект – отдает 200 ответ… Хотя, должна отдавать 404 ответ.

Единственное, что они сделали по уму – так это то, что закрыли эту страницу в robots.txt от индексации.

Нам этот вариант с дублями не подходит.

Копаем дальше.

Смотрим на структуру урлов страниц:

- femida.by›index.php?page=contract

- femida.by›index.php?page=torgovlia

- femida.by›index.php?page=lic

- femida.by›index.php?page=hoz_interes

Все урлы имеют схожую структуру. Не знаю, что это за CMS, но мы кое-что проверим.

Вместо слова, которое идет после ?page= вписываем что-нибудь страшное и проверяем ответ сервера.

Ой, посмотрите:

Ответ сервера – 200. Страница разрешена к индексации.

Но при этом сама страница выглядит вот так (кликабельно):

Остается только сгенерировать 3000 таких урлов и закупиться порно-ссылками в Sape. Если на сайте всего 100 полезных страниц, то появится еще 3000 бесполезных, на которые ведут ссылки с плохими словами.

Яндекс это оценит, возможно даже АГСом. 🙂

Защита: Чтобы защитить свой сайт – проверьте, чтобы ответ сервера на несуществующих страницах был 404. Если у вас отдается 200 заголовок – вы лёгкая мишень для подобной несложной манипуляции.

Обратитесь к программистам, которые исправят эту ошибку.

2. Дубль главной страницы.

Почти у каждого движка есть дубли главной страницы сайта.

К примеру, главная страница доступна по обычному адресу и с добавлением на конце /index.php, /index.html или слеша.

Открываю Яндекс и пишу примерно вот такую фразу (кликабельно):

Открываю первый же сайт и проверяю на дубли главной страницы.

Опачки!

/index.html выдает 404, а /index.php – вполне отлично себя чувствует:

Смотрим ответ сервера:

И тут всё хорошо. Страница отдает 200 заголовок, страница не закрыта в robots.txt.

Для чего всё это, возможно спросите вы? И что с того?

Большинство сайтов продвигают главные страницы. И обычно, это ВЧ запросы. Представьте себе, что путем простейшей покупки 5-10 ссылок на страницу с /index.php, вы создаете дубль главной страницы сайта и он попадает в поиск. Т.е. контент на странице становится неуникальным в пределах домена и страница опускается в выдаче, так как их уже 2. 🙂

Защита: Поставьте 301 редирект в файле .htaccess, со страницы с /index.php (той, которая у вас являет дублем) на главную страницу сайта. Таким образом, куда бы не ссылались ваши конкуренты, все ссылки будут вести на главную через 301 редирект.

3. Неправильно настроенные зеркала «с www» и «без www».

С этой проблемой поисковики стараются справляться самостоятельно, пытаясь определить, какой-же адрес является на сайте основным – с www или без www.

Но они это делают не всегда правильно, поэтому многие сайты доступны в выдаче по двум адресам – с www и без www. Таким образом, каждая страница сайта имеет один и тот же контент, но существует по двум разным адресам.

В выдаче присутствует полный дубль вашего сайта.

Давайте поищем такие сайты? 🙂

Далеко идти не пришлось.

Первый введенный запрос – второй сайт в выдаче – вуаля! (кликабельно):

Сайт называется ili.by.

Доступен по двум адресам:

http://ili.by (без www) – ответ сервера – 200:

http://www.ili.by (с www) – ответ сервера – 200:

У сайта не настроено главное зеркало. Т.е. сайт доступен для поисковых роботов, как с www, так и без www.

Хоть у сайта и прописана в robots.txt директива Host (которую понимает только Яндекс), можно легко сделать дубль всего сайта, поставив на каждый урл по 1 ссылке на адрес без www.

Всего таких ссылок понадобится 1917 штук:

Получится копия всего сайта в выдаче и сайт упадет в позициях.

Защита: Следует настроить в .htaccess 301 редирект с адресов с «без www», на адреса «с www». Прописать в robots.txt директиву Host: www.ili.by для Яндекса. В панели Вебмастеров Google указать главное зеркало – «с www» и в Панели Вебмастеров Яндекса также указать главное зеркало – «с www».

4. Дубли страниц со слешем и без на конце.

Вы думали что это всё? Нет, есть еще масса способов, к примеру – дубль страниц со слешем и без на конце адреса.

Далеко не пойдем и возьмем тот же самый сайт – www.ili.by.

Берем любой урл – к примеру, этот:

http://ili.by/catalog/minitraktory-raidery.html

И добавляем к адресу на конце слеш.

http://ili.by/catalog/minitraktory-raidery.html/

Если страница открывается, значит вот вам еще один вид дублей.

Для достоверности проверим ответы сервера.

Опа:

И Опа:

Видим, что везде отдается тот же 200 заголовок, который говорит поисковым роботам: «Индексируй меня».

Т.е. схема та же – еще 1917 ссылок на каждый дубль со слешем и у нас еще одна копия сайта в выдаче. Итого, если сложить с предыдущим действием – уже 4 сайта в поиске вместо одного.

Защита: Настроить в .htaccess 301 редирект с «страниц со слешем» на «страницы без слеша» (читать как настроить — тут). Или наоборот, как вам больше нравится. Главное – чтобы на сайте был только 1 вид страниц. Кроме того, прописать тег rel=”canonical”, который виден только в HTML коде страницы и указывает на основной URL.

В принципе, одного этого тега может хватить, чтобы избавиться от дублей со слешем и без на конце (особенно для Google), но не всегда. Всегда лучше 2 раза перестраховаться.

5. Скопировать контент сайта.

Это, наверное, самый простой и самый понятный многим способ. Но простого копирования здесь, скорее всего не хватит.

Раз мы говорим о том, как «опустить» вашего недруга, будем действовать в промышленных масштабах. А именно – по-русски. Копировать, так с размахом. Русская душа всегда отличалась широтой мысли. 🙂

Итак, идем на форум и покупаем пачку ЖЖшечек, и Блогспотов. Как вариант, если вы занимаетесь выносом конкурента профессионально – завести свою сеточку из 500-800 блогов.

После того, как вы купили отстоявшиеся блоги (хотя бы возрастом от 4-5 месяцев), совершаем следующее – копируем весь сайт вашего недруга в эти ЖЖшечки и Блогспотики. Раз так 5-6 копируем. По сути – чем больше у вас подобных блогов во владении, тем лучше.

Почему ЖЖшечки и Блогспотики? Потому что быстробот Яшки там живет. Ваши статьи, не зависимо от того, копипаст это, или нет – обязательно попадут в поиск. А значит – у конкурента он станет неуникальным.

Если у него сайт большой – можно воспользоваться специальным софтом, который отпарсит весь сайт и на автомате загонит его в ЖЖшечки.

Если сайт маленький – можно и руками потрудиться. Или нанять кого-нибудь, кто сделает это за вас.

За счет не уникальности – позиции могут опуститься, и, порой, довольно значительно. На моей памяти, такое случалось не один раз, когда кто-то «с благими намерениями» копировал продвигаемую страницу, и приходилось переписывать текст заново, так как с 4 места страница опускалась до 50-70.

Защита: 100% защиты в этом случае просто нет. Можно поставить на ваш сайт какой-нибудь плагин, который отключит сочетания клавиш Ctrl+A, Ctrl+C, правую кнопку мыши и выделение текста (Для WordPress, это плагин http://wordpress.org/extend/plugins/wp-copyprotect/). Но это всё «защита от блондинок».

Это не спасет сайт от парсинга через специально написанный для этого софт, так как он обращается напрямую к коду страницы, а не через сочетания клавиш.

Есть еще вариант – программным способом скрывать сам html код сайта. Но, я до конца не уверен, что его нельзя слить программными методами. Насколько я понимаю, код закрыт только при просмотре в браузере. (Видел такое несколько раз, но, к сожалению, так и не вспомнил те сайты, чтобы показать, как пример.)

6. Создание сайта-афилиата.

Данный способ наиболее трудоемкий, но он также наиболее действенный. Суть метода такова: Вы создаете один или несколько сайтов, которые ко контенту схожи с сайтом вашего конкурента, при этом присваиваете сайту тот же регион и те же контактные данные, что и у конкурента.

Яндекс не любит, когда в выдаче присутствует несколько сайтов одной и той же фирмы, поэтому и придумали афилиат-фильтр.

Если поисковик повесит этот фильтр и, что еще лучше – определит, что ваш сайт стоит показывать в выдаче, конкурент без видимых на то причин по некоторой совокупности запросов просто не будет показываться в ТОПе. Будет показываться только ваш сайт.

Защита: В принципе, защиты от такого рода атаки просто нет. Единственное, что поможет вам избежать этого – если фильтр еще не повесили, вы обнаружили «плохой сайт» и отписали Платону, объяснив всю ситуацию. Возможно (но далеко не факт), вам помогут и отправят тот сайт в бан.

7. Ссылочный взрыв.

Данный метод очень хорошо работает на молодых сайтах, а также на сайтах, которые любят копировать контент.

Суть метода – вы закупаете на сайт конкурента огромное количество ссылок. Желательно и почти обязательно – чтобы ссылки были ярко выраженными продажными с небольшим или большим оттенком адалта.

Проще всего – отпарсить статистику ключевых слов какого-нибудь адалт-сайта. Все ключевые слова, по которым приходили на тот сайт и будут анкорами ваших ссылок.

Далее загружаете это всё в сапу и на каждый URL конкурента закупаете по штук 20-50 ссылок. Причем – единовременно. Именно таким образом происходит так называемый «ссылочный взрыв». Если сайт до этого не продвигался и на него стоит хотя бы даже 100 ссылок, то ваши 4000 адалт ссылок легко укажут Яндексу, что сайт не стоит того, чтобы быть в выдаче.

Как я уже говорил – этот метод просто идеален для молодых сайтов (1-4 месяца жизни). А если эти сайты, как и большинство других сайтов в интернете, копируют контент и он у них неуникален – появляется 99,9% гарантия того, что придет АГС.

Защита: Для начала – постоянно «кормить» свою малютку качественными ссылками (не прогонами, а постовыми с тематических сайлов, чтобы знать в лицо каждую ссылку) и писать ТОЛЬКО уникальный контент. Короче – развивать сайт по полной.

При этом – постоянно мониторить все внешние ссылки на ваш сайт через панель Я.В. Как только увидите, что откуда-то резко появились ссылки, которые вы не ставили и их появилось очень много, и все они – с адалт анкорами – сразу же пишите письмо Платону.

Техподдержка просто не будет учитывать внешние ссылки, которые появятся на ваш сайт в течение некоторого времени. Так вы защитите свой сайт от АГСа, а конкурент просто зря потратит деньги на ссылки.

8. Переспам анкор листа продвигаемых страниц.

Так как продвигается обычно не весь сайт, а отдельные его страницы – вы можете «помочь» вашему конкуренту продвинуться, переспамив его анкор-лист прямыми вхождениями запроса.

Это не очень-то и хороший метод, но он имеет место жить. Почему он не очень-то хороший? Потому, что вы, по сути, помогаете вашему недругу продвинуться. В Яндексе вы его опускаете, а в Гугле – продвигаете, ибо Гугл любит прямые вхождения. А вот Яндекс – не очень то любит. Поэтому в нем позиции за переспам улетят за предел первой двадцатки.

Я бы не советовал использовать этот метод. Есть другие, куда более действенные.

Защита: Если вы обнаружили, что ваши страницы свалились в выдаче и у вас в панельке Я.В. появились ссылки с продвигаемыми ключами, которых вы не ставили, знайте – кто-то решил «помочь» вам продвинуться.

Чтобы вернуть позиции на место – закупите на проспамленные страницы побольше ссылок для разбавления анкор-листа. Если, к примеру, вам проспамили по запросу «купить квартиру», закупите ссылок вида: «Кстати, я вот долго думал и пришел в выводу, что лучшие квартиры тут.» или «На этом сайте вы сможете подобрать для себя любую квартиру, как в кредит, так и за наличные.»

Суть в том, чтобы на проспамленную страницу появились очень длинные анкоры, содержащие в себе часть запроса, которым вас проспамили. Так вы вернете нужный процент прямых вхождений и разнообразите ваш анкор-лист. И ссылки вашего конкурента пойдут вам только на пользу. 🙂

9. Взлом сайта, инъекция вируса, закрытие сайта от индексации, внешние ссылки.

Есть и такой метод, да. Суть его в том, что сайт вашего конкурента просто взламывается, и на нем делается всё, что вам захочется.

Можно, к примеру, заразить сайт вирусом, что резко уменьшит траффик на сайте вашего недруга, так как поисковики будут выводить в выдаче напротив сайта надпись, наподобие «Этот сайт может угрожать безопасности вашего компьютера».

Но, это цветочки.

Ягодки – это когда сайт полностью удаляется, или ломается. Причем ломается так, что на его восстановление может уйти несколько дней. А за несколько дней часть страниц может вылететь из индекса поисковика.

Еще один из вариантов – взломать сайт и изменить на нем файл robots.txt. Ваш недруг может даже не заметить того, как его сайт постепенно вылетит из индекса. А когда опомнится – будет уже поздновато.

Или вот еще один вариант из той-же серии. Взламывается сайт и на нем размещается скрытый блок, состоящий из внешних ссылок на плохие ресурсы. Скрыть блок можно через элементарное display:none, или вынести блок далеко за экран. В каждом блоке, к примеру, по 20 внешних ссылок на плохие адалт сайты.

Увидев это, Яндекс подумает, что сайт продает ссылки, при чем очень жестко продает, и отправит его под АГС.

Защита: Внимательно следите за любыми изменениями, которые происходят с индексацией сайта и вашими внешними ссылками. Кроме того, выбирайте защищенные и хорошие хостинги, та как безопасность – прежде всего.

И периодически делайте бэкап всего вашего сайта. С хотсерами тоже может многое случиться.

10. ДДос атака.

Суть ДДос атаки – перегрузка сервера, на котором стоит сайт конкурента с помощью огромнейшего числа запросов. В результате сервер не успевает отвечать на них и виснет. Сайт становится недоступным.

Но он становится недоступным не только для людей, но и для роботов. Поэтому, придя на сайт, роботы разворачиваются и уходят.

Если ДДос атака длится непрерывно в течение нескольких дней, страницы сайта конкурента начинают выпадать из индекса. Таким образом, большой организованной ДДос атакой можно вывести из строя любой сайт, и он пропадет из выдачи.

Стоимость длительной ДДос атаки будет весьма большой, но если вы упрямый и у вас много денег – можно вывести из строя даже сервера ЖЖ, что случалось не один раз. А они там будут помощнее, чем на любом хостинге за 5 баксов в месяц.

Защита: Держите свои сайты на хороших хостингах, у которых профессиональная техподдержка и админы с мозгом. Они хотя-бы смогут защитить ваш сайт от мелких ДДосеров. Но, как я уже говорил выше, если очень хочется, то можно и ЖЖшечку положить. От хорошо отлаженной атаки вас ничто не спасет.

В заключение.

Уф, большой получился пост. Вы увидели, какие же все-таки хрупкие наши с вами сайты, и как о них нужно заботиться.

Так как статья будет участвовать в конкурсе «TOP 10» от Сергея Шелвина, остановимся на десяти способах. Остальное останется «секретом фирмы».

Но, в окончании, я бы еще хотел уточнить несколько моментов.

Обычно, если использовать только один из методов, нужного эффекта можно и не добиться. Методы воздействия нужно комбинировать. Только нужная комбинация поможет вам добиться 99,9% результата и, все-таки, пояснить вашему недругу, что «он был не прав». Какая комбинация и каких методов может помочь? Всё сугубо по ситуации и зависит от множества факторов.

Я же хотел бы вам посоветовать не использовать эти методы. Но знать их настоятельно рекомендую, так как если знаешь врага в лицо, знаешь чего ждать и как защититься.

Желаю вам исправить все ошибки на ваших сайтах, чтобы ни один злостный хулиган не мешал вам вести бизнес в интернете. Если вы сами плохо понимаете данную тему, можете заказать SEO аудит вашего сайта, где я найду все ошибки и помогу вам от них избавиться.

Успехов вам!

http://sickboy.ru/konkursy/top-10-sposobov-ubit-sajjt-konkurenta-v-vydache-i-zashhitit-svojj.html

yankolin.livejournal.com

Как убрать конкурента из выдачи?

Жалоба на неуникальный контент

Не так давно мы продвигали сайт, заметили, что сайт частично выпал из индекса Google, стали разбираться, в чем причина и обнаружили вот такое сообщение прямо на странице выдачи:

Оказалось, конкурент написал жалобу в LumenDatabase.org, что у него украли фотографии товара. Сайт с неуникальными фотографиями без разбирательств, кто прав, кто виноват, частично исключили из индекса Google. В Яндекс такое не проходит, но в Google запросто.

Как защититься: не используйте на сайте фотографии, видео, описание товара из Интернета, особенно с сайтов конкурентов. Берегите свои сайты и нервы.

Создание дублей

Еще одна хитрость – создать дубли. Тут тоже есть несколько способов.

2.1. Кручу, верчу, запутать хочу

Практически на каждом сайте можно найти технические несовершенства.

Многие знают, что с www на без www необходимо настроить 301-редирект (если этого не делать, то поисковики главным зеркалом могут определить любой по своему усмотрению, и это может стать проблемой), но не многие знают, что Главная еще может быть доступна по адресу Site.ru\index.html или Site.ru\index.php

Возьмем любой сайт, например, it-teamnet.ru. Во-первых, у сайта не настроен редирект с www на без www и наоборот. Как это определить?

В браузере сайт открывается по обоим адресам, при этом адрес не меняется:

и без www:

Во-вторых, по адресу it-teamnet.ru/index.html выдает 404, и это правильно:

А вот по it-teamnet.ru/index.php , сайт открывается, проверяем с помощью сервиса mainspy.ru/analiz_ssylok_sajta и видим код 200, и это не есть хорошо:

Страница не закрыта в robots.txt и отдает ответ 200.

Яндекс определил Главным зеркалом сайт без www:

Проверить можно по ссылке: webmaster.yandex.ru/addurl.xml

И что с того, спросите вы? Как конкуренты этим могут воспользоваться?

А вот так. Получается, что у сайта it-teamnet.ru есть дубли: с www и /index.php. Осталось сделать так, чтобы Яндекс и Google узнали о них.

Проще всего для этого купить пару тысяч дешевых ссылок на эти адреса: на сайт с www (неглавное зеркало) и на адрес it-teamnet.ru/index.php, тогда поисковик может понизить основной сайт в выдаче, т.к. увидит три сайта с одинаковым контентом.

Способ 100% не гарантирует, что сайт в выдаче опустится, но однозначно создаст неприятности человеку, отвечающему за продвижение сайта.

Как защититься: чтобы с вами такого не случилось, настройте в .htaccess 301-редирект с адреса без www, на адрес с www (или наоборот, смотря что вы хотите сделать главным зеркалом сайта), а также со страницы с /index.php и /index.html на главную страницу сайта.

В robots.txt обязательно пропишите директиву Host, она нужна для Яндекса. В панели вебмастеров Google и в панели вебмастеров Яндекса также укажите главное зеркало сайта.

Мы это обязательно делаем в рамках комплексного продвижения сайта.

2.2. Копировать контент полностью

Наверное, все знают, что блоги очень хорошо индексируются. Поэтому, если скопировать сайт конкурента раз 5-15 целиком в блоги (жж, блогспот и другие блогохостинги, которые мониторятся Яндекс.Блогами и т.п.), они наверняка проиндексируются поисковиками, и, возможно, это помешает продвижению конкурента. Ибо неуникальный контент – это бич всего и вся.

Стоит заметить, что этот способ может не сработать, а может сработать не сразу. Но на перспективу, конечно, на благо конкуренту не пойдет.

Как защититься: 100% гарантированной защиты тут нет. Как вариант можно зайти в Яндекс.Вебмастер → «Содержимое сайта» → «Оригинальные тексты», указать там написанный вами текст до его индексации роботами. Для Google такой защиты сейчас нет.

Периодически можно проверять свой сайт на уникальность с помощью сервиса text.ru или advego. Если текст на вашем сайте неуникальный, лучше его переписать.

1ps.ru